En un pasado no muy lejano, las conversaciones sobre IA se limitaban principalmente al ámbito de la ciencia ficción y los artículos académicos.

En la actualidad, la IA está profundamente integrada en el tejido de la vida cotidiana, desde el funcionamiento de los hogares inteligentes hasta el diagnóstico de enfermedades.

Pero mientras la tecnología de la IA avanza a toda velocidad, los marcos reguladores se ponen al día y a menudo se quedan rezagados con respecto a la curva de la innovación.

Esto plantea a la humanidad un rompecabezas polifacético: ¿cómo elaborar leyes y normativas lo bastante ágiles para adaptarse a los rápidos cambios tecnológicos y lo bastante sólidas para proteger los intereses de la sociedad?

En todo el mundo, los esfuerzos reguladores distan mucho de ser uniformes. La Unión Europea (UE) está sentando las bases con su exhaustiva Ley de IA, cuyo objetivo es clasificar y controlar las aplicaciones de IA en función de su nivel de riesgo.

Mientras tanto, Estados Unidos ha favorecido los compromisos voluntarios frente a la legislación inmediata.

China, por su parte, ejerce un férreo control sobre la IA, alineando la regulación con objetivos más amplios de gobernanza política y social.

Y no olvidemos otras jurisdicciones: la IA es un fenómeno global que requerirá una legislación casi universal. cobertura.

Así pues, ¿dónde está ahora la normativa y cómo se espera que progrese?

El enfoque de la UE

La UE ha adoptado un marco estricto con su innovadora Ley de Inteligencia Artificial, que se espera esté totalmente aprobada a finales de año.

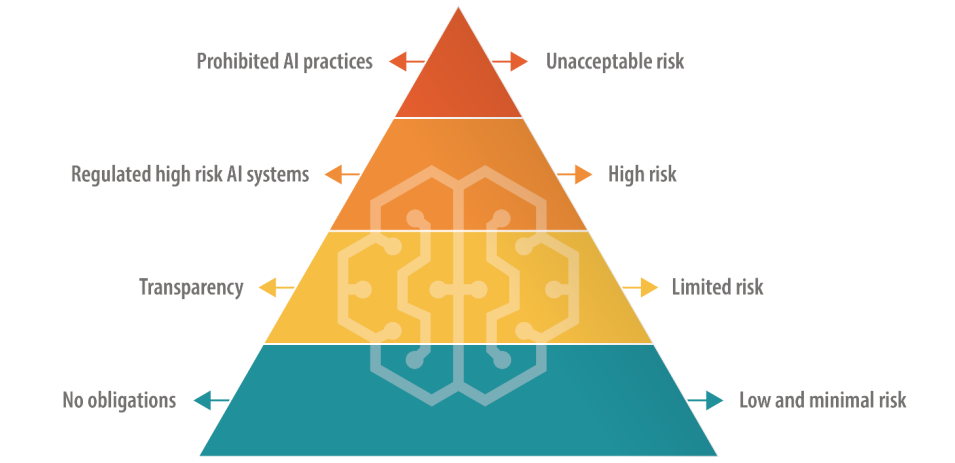

La Ley de IA especifica cuatro niveles: "IA de riesgo inaceptable", "IA de alto riesgo", "IA de riesgo limitado" y "IA de bajo riesgo", cada uno con un conjunto específico de directrices y prohibiciones.

Las IA de riesgo inaceptable plantean peligros inmediatos o considerables, como causar daños físicos o mentales o vulnerar los derechos humanos, y serán prohibidas rotundamente.

Las IA de alto riesgo están permitidas, pero sujetas a estrictas normas que van desde la gestión de riesgos a la documentación técnica y la ciberseguridad.

Las IA limitadas y de bajo riesgo, por su parte, siguen siendo predominantemente no reguladas, pero están obligadas a mantener la transparencia con los usuarios.

Hay un respiro a corto plazo, ya que la legislación incluye un periodo de gracia de unos dos años para que las empresas se adapten a la nueva normativa.

La UE propone que los creadores originales de los modelos de IA sean responsables del uso que se haga de su tecnología, incluso cuando otra empresa o desarrollador la incorpore a un sistema diferente. También se han añadido nuevas normas para los "modelos fundacionales", que incluyen los modelos generativos de IA.

La acogida de la Ley de Inteligencia Artificial varía: algunos critican sus torpes definiciones y su potencial para frenar la innovación. Por ejemplo, existe una gran incertidumbre sobre la clasificación de los distintos modelos de IA en categorías de riesgo.

Además, las empresas de IA más pequeñas temen carecer de recursos para dedicarlos al cumplimiento de la normativa.

Sam Altman, Director General de OpenAI breve amenaza de retirar los productos de su empresa del mercado de la UE si la Ley de IA especificaba requisitos que no pueden cumplirse de forma realista.

En junio, 150 grandes empresas destacó el enfoque de mano dura de la LeyLa actual normativa amenaza con destruir la competitividad europea.

Divergencia con EE.UU.

A Análisis de Stanford de la Ley de IA debatió las diferencias fundamentales entre los planteamientos de la UE y EE.UU. sobre la regulación de la IA.

Alex Engler, investigador de Estudios de Gobernanza en The Brookings Institution, dijo: "Hay una creciente disparidad entre el enfoque de Estados Unidos y el de la UE [para regular la IA]".

Destaca que la UE ha impulsado leyes de privacidad y transparencia de datos, que siguen faltando en su mayor parte en Estados Unidos. La disparidad confunde el cumplimiento de la normativa por parte de las empresas de IA, y los costes asociados al cumplimiento transjurisdiccional podrían ser excesivos.

"Los intereses empresariales lucharán con uñas y dientes si existen dos normas radicalmente distintas para las plataformas en línea", dijo Engler.

En general, a la hora de la verdad, es difícil imaginar que las empresas tecnológicas no encuentren la manera de sortear la Ley de IA, como han hecho con el GDPR y tendrán que hacer con la reciente Ley de Servicios Digitales.

Dirigiéndose al revista NatureDaniel Leufer, analista político de Access Now, tacha las objeciones de la industria de la IA a la Ley de "fanfarronadas".

El enfoque británico

Tras el Brexit, el Reino Unido pretende capitalizar su independencia de la UE para formular un régimen normativo más flexible y específico para cada sector.

A diferencia de la Ley de IA, el gobierno británico pretende regular las aplicaciones de la IA en lugar del propio software subyacente.

A favor de la innovación

El Gobierno británico ha publicado un libro blanco en marzo en el que se esboza un marco "proinnovación" y se invita a las partes interesadas a compartir sus puntos de vista. Sin embargo, el Gobierno aún no ha publicado directrices para aplicar este marco.

En un comunicado se afirma que "el Gobierno ayudará al Reino Unido a aprovechar las oportunidades y beneficios que presentan las tecnologías de IA", un enfoque criticado por no prestar la debida atención a los daños relacionados con la IA.

El Gobierno había previsto incluso ofrecer a las empresas de IA una "exención de derechos de autor" muy controvertida, pero Cambio de planes en agosto.

Últimamente, Gran Bretaña ha tenido dificultades para atraer la innovación tecnológica, sobre todo con la pérdida del fabricante de chips de Cambridge Arm, que optó por cotizar en bolsa en Estados Unidos en lugar de hacerlo en el país. Tal vez esto alimente la ansiedad del Reino Unido por reactivar su menguante sector tecnológico.

Para ayudar a posicionar al Reino Unido como un país con visión de futuro en el ámbito de la IA, el Primer Ministro Rishi Sunak ha anunciado una conferencia de dos días de duración sobre la IA. Cumbre sobre seguridad de la IA que tendrá lugar en noviembre.

China ha sido invitada al acto, aunque se especula con la posibilidad de que quede excluida. temores de espionaje.

El enfoque estadounidense

En Estados Unidos, la atención se centra en permitir que el sector se autorregule, al menos por ahora.

El Congreso de EE.UU. está dando señales de "esperar y ver", embarcándose en una revisión de las reuniones a puerta cerrada de AI y Chuck Schumer Foros AI Insight para determinar dónde precisamente la IA requiere una nueva regulación.

Los acuerdos bipartidistas pueden girar en torno a una legislación específica sobre privacidad, transparencia de las plataformas o seguridad. protección de la infancia en internet.

Además, algunos han destacado que las leyes y normativas vigentes siguen siendo pertinentes para la IA.

En junio, Khan dijo...] "No hay ninguna exención para la IA de las leyes que prohíben la discriminación... A medida que estas cosas se van incrustando en la forma en que se toman las decisiones cotidianas, creo que invitan y merecen mucho escrutinio... Creo que los encargados de hacerlas cumplir, ya sea a nivel estatal o nacional, van a actuar".

Marcos voluntarios y "stop-gaps

Destacadas empresas tecnológicas como Microsoft, OpenAI, Google, Amazon y Meta firma de compromisos voluntarios para el desarrollo seguro de la IAEntre ellas, la realización de pruebas internas y externas del modelo de IA antes de su publicación.

Muchos líderes de la industria tecnológica se han comprometido, pero en En ausencia de una sólida supervisión legislativa, la sinceridad de estas promesas aún está por comprobar.

Con todo, los críticos afirman que el planteamiento de EE.UU. es esencialmente simbólico y carece de la profundidad y el compromiso de la Ley de IA de la UE. La primera Foro AI Insight fue un acto a puerta cerrada que algunos criticaron por restringir el debate abierto.

El senador Josh Hawley dijo que el acto era un "cóctel gigante".

Como resumió acertadamente Ryan Calo, profesor de la Facultad de Derecho de la Universidad de Washington: "Hay apariencia de actividad, pero nada sustantivo y vinculante".

El enfoque chino

China, en proporción a su apetito por el control estatal, está imponiendo algunas de las normativas más estrictas sobre IA.

Se hace hincapié en el control de la difusión de información por parte de la IA, lo que refleja los marcos más amplios de gobernanza política y social de China.

Por ejemplo, los proveedores de IA generativa cuyos productos puedan "influir en la opinión pública" están obligados a someterse a revisiones de seguridad.

La primera oleada de chatbots aprobados, entre ellos ERNIE Bot de Baidu, fue recientemente hecho público y se encontró que censuraba las preguntas de temática política.

El auge de las "falsificaciones profundas" y los contenidos generados por IA plantea problemas en todo el mundo, y China no es una excepción. La Administración del Ciberespacio de China (CAC, por sus siglas en inglés), que reconoció los peligros potenciales de la IA a principios de año, exige que los generadores de contenidos basados en IA se sometan a procesos de verificación de la identidad de los usuarios.

Además, se han introducido disposiciones sobre marcas de agua para distinguir los contenidos generados por IA de los creados por humanos, normas que las potencias occidentales también pretenden aplicar.

Divergencia entre EE.UU. y China

La IA ha acelerado las fricciones entre Estados Unidos y China, desencadenando lo que muchos han denominado una "Guerra Fría Digital", o quizá más apropiadamente, una "Guerra Fría de la IA".

Las restricciones estadounidenses a la colaboración y el comercio con China no son nada nuevo, pero la desvinculación de ambos países dio un paso adelante cuando Xi Jinping anunció su nueva y reformada Plan Made in China 2025.

Con ello se pretende que China 70% sea autosuficiente en sectores tecnológicos cruciales para 2025, incluida la tecnología de IA de gama alta.

En la actualidad, EE.UU. cortar la financiación y la investigación lazos con China al tiempo que subyuga su adquisición de chips de IA a empresas como Nvidia.

Aunque Estados Unidos lleva una clara ventaja en la carrera por el dominio de la IA, China tiene algunos trucos en la manga, como un enfoque centralizado de la regulación y datos personales casi ilimitados.

En mayo, Edith Yeung, socia de la empresa de inversión Race Capital, a la BBCChina tiene muchas menos normas sobre privacidad y muchos más datos [en comparación con Estados Unidos]. Hay reconocimiento facial por CCTV en todas partes, por ejemplo".

La estrecha relación entre el gobierno y la industria tecnológica china también ofrece ventajas, ya que el intercambio de datos entre el gobierno y las empresas tecnológicas nacionales es prácticamente perfecto.

Estados Unidos y otras jurisdicciones occidentales no comparten el mismo acceso a los datos empresariales y personales, que son la savia de los modelos de aprendizaje automático. De hecho, ya existe la preocupación de que las fuentes de datos se están "agotando".'

Además, el uso liberal por parte de las empresas occidentales de IA de datos de entrenamiento potencialmente protegidos por derechos de autor ha provocado un amplio revuelo y demandas.

Es probable que las empresas chinas de IA no sufran ese problema.

Equilibrio entre accesibilidad y riesgo

Antes, la IA estaba confinada al mundo académico y a las grandes empresas. En aproximadamente un año, entre una cuarta parte y la mitad de los adultos del Reino Unido, Estados Unidos y la UE han utilizado IA generativa.

La accesibilidad tiene muchas ventajas, como estimular la innovación y reducir las barreras de entrada para las nuevas empresas y los desarrolladores individuales. Sin embargo, también suscita preocupación el posible uso indebido que conlleva el acceso no regulado.

El reciente incidente en el que el modelo lingüístico Llama-1 de Meta se filtró en Internet ejemplifica los retos que plantea la contención de la tecnología de IA. Ya se han utilizado modelos de IA de código abierto con fines fraudulentos y para generar imágenes de abusos a menores.

Las empresas de IA lo sabeny los modelos de código abierto amenazan su ventaja competitiva. Meta ha surgido como una especie de antagonista de la industria, lanzando una serie de modelos de forma gratuita mientras otros, como Microsoft, OpenAI y Google, luchan por monetizar sus productos de IA.

Otros modelos de código abierto, como el Falcon 180B LLMson excepcionalmente potentes aunque carecen de guardarraíles.

Algunos especulan con que las grandes empresas de IA están presionando para que se regule, ya que esto obliga a los actores más pequeños y a la comunidad de código abierto a salir del ruedo, lo que les permite mantener el dominio de la industria.

El enigma del doble uso de la IA

Otro factor complejo son las aplicaciones duales o múltiples de la IA.

Los mismos algoritmos que pueden mejorar nuestra calidad de vida también pueden convertirse en armas o aplicarse en entornos militares. Este podría ser el talón de Aquiles del marco heurístico de la Ley de IA de la UE: ¿cómo se interpretan las IA útiles que pueden modificarse para hacer daño?

La regulación de la tecnología de doble uso es notoriamente compleja. Implantar controles estrictos podría ahogar la innovación y el crecimiento económico cuando solo una ínfima minoría hace un uso indebido de una tecnología de IA.

Las empresas de IA pueden eludir la culpa creando políticas contra el uso indebido, pero eso no impide que la gente utilice 'jailbreakspara engañar a los modelos para que produzcan material ilícito.

Equilibrar los beneficios económicos de la IA y las preocupaciones éticas

Los beneficios de la IA son económicamente convincentes, especialmente en sectores como la sanidad, la energía y la fabricación.

Informes por McKinsey y PwC prevén que la IA aportará billones anuales a la economía mundial, independientemente del impacto de las sustituciones de puestos de trabajo y los despidos.

La IA puede considerarse una vía de creación de empleo y crecimiento para los países con problemas económicos.

En una escala filosófica más amplia, la IA se presenta a veces como la salvadora de la humanidad en medio de problemas macroeconómicos como la pobreza, el cambio climático y el envejecimiento de la población.

Los gobiernos occidentales, sobre todo los de Estados Unidos y el Reino Unido, parecen inclinados a impulsar el crecimiento mediante incentivos fiscales, financiación de la investigación en IA y un enfoque normativo de laissez-faire.

Esta es una apuesta que Estados Unidos hizo en el pasado al permitir que la industria tecnológica se autorregulara, pero ¿puede seguir resultando rentable?

W¿Las predicciones catastrofistas que comparan la inteligencia artificial con la "guerra nuclear" y las "pandemias mundiales" acaban con la visión romántica del potencial de esta tecnología para sacar a la humanidad de los problemas mundiales cada vez más acuciantes?

La IA presenta una cierta dualidad que evoca tanto visiones eutópicas como distópicas del futuro, según a quién se escuche.

Regular una entidad de este tipo es un reto sin precedentes.

En cualquier caso, es probable que a finales de 2024 vivamos en un mundo en el que la IA esté casi universalmente regulada, pero lo que nadie puede responder es hasta qué punto la industria - y la propia tecnología - habrá evolucionado para entonces.