El Instituto de Innovación Tecnológica (TII) de los Emiratos Árabes Unidos presentó la semana pasada su Falcon 180B LLM en Hugging Face, que ha ofrecido un rendimiento impresionante en las primeras pruebas.

El modelo, de libre acceso para investigadores y usuarios comerciales, es producto de una floreciente industria de IA en Oriente Medio.

El Falcon 180B es 2,5 veces mayor que el Meta Llama 2 y fue entrenado con 4 veces más computación. El TII entrenó el modelo con 3,5 billones de fichas. El impresionante rendimiento de este modelo se debe en gran medida a su enfoque único del conjunto de datos.

Para entrenar un modelo no sólo se necesitan muchos datos, sino muchos datos de buena calidad. Su producción cuesta mucho dinero y no hay muchos conjuntos de datos curados de gran tamaño a disposición del público. TII decidió probar un enfoque novedoso para evitar la necesidad de curar.

En junio, los investigadores utilizaron filtrado y deduplicación cuidadosos de datos CommonCrawl de acceso público para crear el conjunto de datos RefinedWeb. Este conjunto de datos no sólo fue más fácil de producir, sino que ofrece un mejor rendimiento que el simple uso de corpus curados o datos web.

Falcon 180B se entrenó con la enorme cantidad de 3,5 billones de tokens del conjunto de datos RefinedWeb, una cifra significativamente superior a los 2 billones de tokens del conjunto de datos de preentrenamiento de Llama 2.

Rendimiento del Falcon 180B

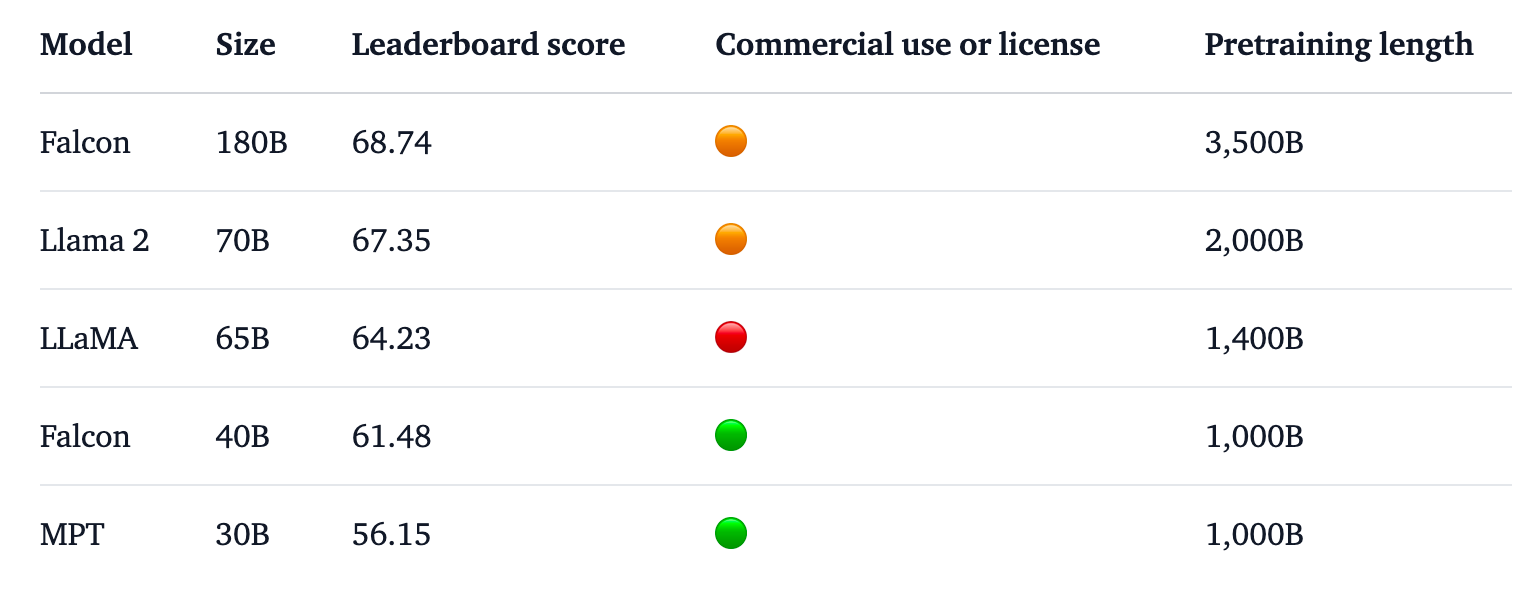

Falcon 180B encabeza la clasificación de Hugging Face para los LLM de acceso abierto. El modelo supera a Llama 2, el anterior líder, en una serie de pruebas comparativas como las de razonamiento, codificación, competencia y conocimientos.

Falcon 180B incluso obtiene buenas puntuaciones cuando se compara con modelos propietarios de código cerrado. Se sitúa justo por detrás de GPT-4 y a la par de PaLM 2 Large de Google, que duplica en tamaño a Falcon 180B.

Fuente: Cara de abrazo

El TII afirma que, a pesar del ya impresionante rendimiento con su modelo preentrenado, tiene la intención de "proporcionar versiones cada vez más capaces de Falcon en el futuro, basadas en conjuntos de datos mejorados y en RLHF/RLAIF".

Puede probar una versión de chat del modelo con esto Falcon 180B demo en Cara de Abrazo.

La versión de chat se ha ajustado y depurado, pero el modelo básico aún no dispone de barreras de alineación. El TII dijo que, como aún no había pasado por un proceso de ajuste o alineación, podía dar respuestas "problemáticas".

Llevará algún tiempo alinearlo hasta el punto en que pueda desplegarse comercialmente con confianza.

Aun así, el impresionante rendimiento de este modelo pone de manifiesto las oportunidades de mejora que existen más allá de la simple ampliación de los recursos informáticos.

Falcon 180B muestra que los modelos más pequeños entrenados en conjuntos de datos de buena calidad pueden ser una dirección más rentable y eficiente para el desarrollo de la IA.

El lanzamiento de este impresionante modelo subraya el meteórico crecimiento de Desarrollo de la IA en Oriente Próximoa pesar de la reciente restricciones a la exportación de GPU a la región.

Mientras empresas como TII y Meta siguen publicando sus potentes modelos bajo licencias de acceso abierto, será interesante ver qué hacen Google y OpenAI para impulsar la adopción de sus modelos cerrados.

La diferencia de rendimiento entre los modelos de acceso abierto y los patentados parece estar reduciéndose.