Nvidia ha presentado una versión actualizada de su superchip Grace Hopper (GH200) que anunció hace 2 meses. El GH200 se diseñó para alimentar centros de datos de procesamiento de IA a gran escala.

La GH200 aún no se ha empezado a fabricar en serie, pero ya ha tenido un actualización importante en su memoria. La salsa secreta de estos nuevos chips es la memoria mejorada de gran ancho de banda denominada HBM3e, capaz de acceder a los datos a 5 TB/s.

Esto representa una mejora de 50% respecto a la memoria HBM3 del chip que se anunció a finales de mayo.

Nvidia conectó esta memoria de alta velocidad a potentes CPU y GPU en el mismo dispositivo. El aumento resultante en la velocidad de procesamiento mejorará drásticamente la capacidad de procesamiento de IA que tienen los centros de datos actuales.

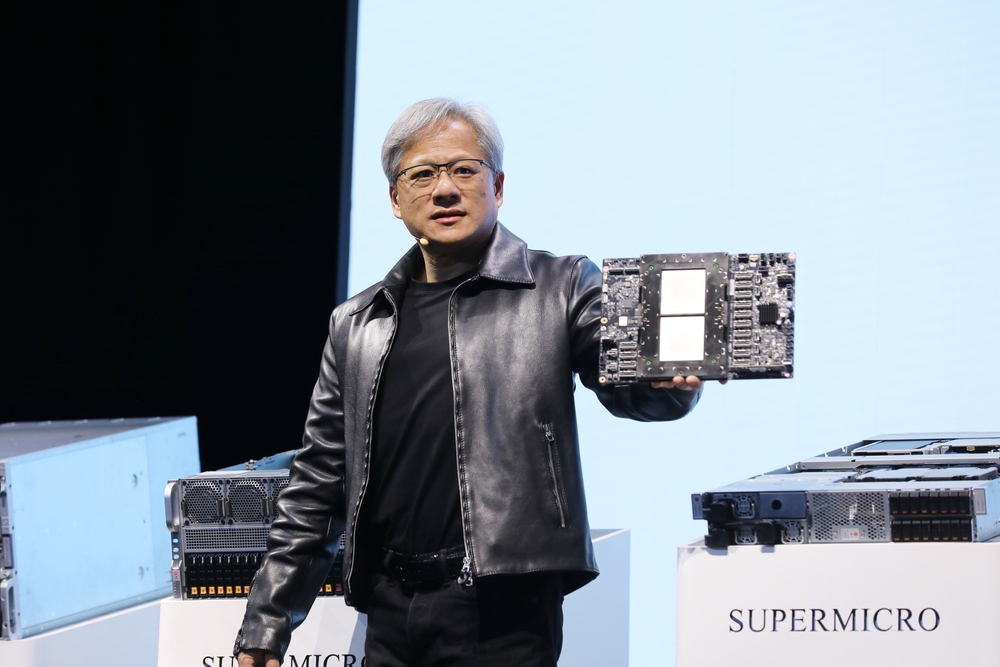

Además del chip actualizado, Nvidia también ha anunciado la plataforma GH200 Grace Hopper, que permite conectar 2 de los chips GH200 en una única placa.

La plataforma ofrece ocho petaflops de procesamiento de IA y 282 GB de memoria HBM3e con un ancho de banda de 10 TB/s.

¿Cómo cambiará el chip de Nvidia los centros de datos?

Las cifras pueden ser un poco difíciles de entender. Entonces, ¿qué importancia tienen este nuevo chip y esta nueva plataforma?

En su presentación, Jensen Huang, CEO de Nvidia, utilizó el ejemplo de un centro de datos típico con 8800 procesadores x86 que realizan diversas funciones informáticas (presupuesto ISO).

Un centro de datos como este que ejecute Llama 2 para inferencia, con una base de datos vectorial que se consulte y SDXL que genere los resultados le costaría alrededor de $100m y utilizaría 5MW de energía.

Un centro de datos de $100m que utilizara 2.500 plataformas GH200 podría ejecutar los mismos modelos 12 veces más rápido y sólo consumiría 3 MW de energía.

Si un centro de datos se centrara en un conjunto muy específico de tareas (carga de trabajo ISO), la comparación sería aún más asombrosa.

Bastaría con gastar $8m para que 210 dispositivos GH200 consumieran 20 veces menos energía para igualar el rendimiento de un centro de datos de $100m.

Huelga decir que los centros de datos de computación en nube de IA que estaban en fase de planificación antes de este lanzamiento volverán a la mesa de dibujo.

Los chips GH200 se lanzarán en el segundo trimestre de 2024 y se espera que se coman buena parte del negocio de los procesadores x86. El nuevo chip MI300 de AMD es el rival más cercano de Nvidia, pero su mayor ventaja en memoria parece verse mermada por la actualización del nuevo GH200.

El avance en la tecnología de procesadores que estamos viendo está superando Ley de Moore y no parece que vaya a ralentizarse. Las aplicaciones de IA generativa ya ofrecen un rendimiento impresionante, pero parece que están a punto de ser mucho más rápidas.