Investigadores de las universidades británicas Durham University, Surrey University y Royal Holloway University of London han desarrollado una innovadora técnica basada en inteligencia artificial para extraer las pulsaciones de las grabaciones acústicas.

En estudiar ha desarrollado una técnica para leer con éxito las pulsaciones de los teclados mediante grabaciones de audio.

Esta técnica podría permitir a los hackers analizar las pulsaciones de teclas apoderándose del micrófono de un dispositivo y recopilando información personal como contraseñas, conversaciones privadas, mensajes y otros datos sensibles.

Las pulsaciones se graban a través de un micrófono y son procesadas y analizadas por un modelo de aprendizaje automático (ML) que determina su espaciado y posición en el teclado.

El modelo puede identificar pulsaciones individuales con un sorprendente índice de precisión de 95% cuando las pulsaciones se graban a través del micrófono de un teléfono cercano. La precisión de la predicción disminuyó a 93% cuando se utilizaron grabaciones realizadas a través de Zoom para entrenar el algoritmo de clasificación de sonidos.

Los ataques de piratería acústica se han vuelto cada vez más sofisticados debido a la disponibilidad generalizada de dispositivos equipados con micrófonos que pueden capturar audio de alta calidad.

¿Cómo funciona el modelo?

El ataque comienza registrando las pulsaciones del teclado del objetivo. Estos datos son cruciales para entrenar el algoritmo predictivo.

Esta grabación puede realizarse utilizando un micrófono cercano o el teléfono infectado con malware del objetivo con acceso a su micrófono.

Alternativamente, un participante deshonesto en una llamada Zoom podría correlacionar los mensajes tecleados por el objetivo con su grabación de sonido. También puede haber formas de piratear el micrófono del ordenador utilizando malware o vulnerabilidades de software.

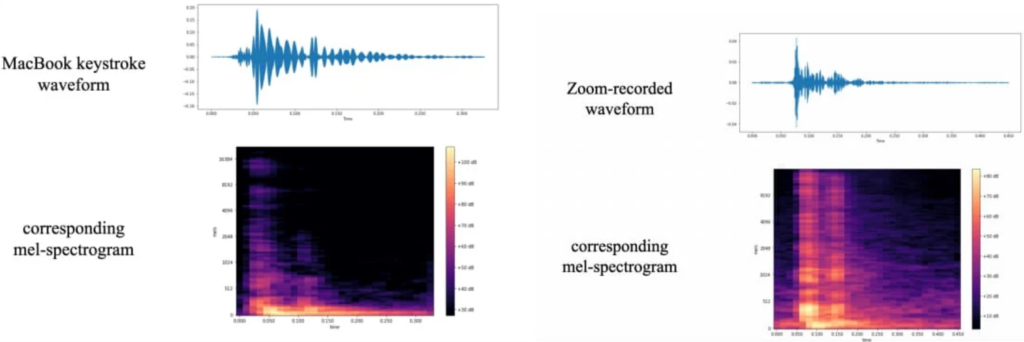

Los investigadores recopilaron datos de entrenamiento pulsando 25 veces cada una de las 36 teclas de un MacBook Pro moderno y registrando el sonido que generaba cada pulsación. A partir de estas grabaciones se produjeron formas de onda y espectrogramas que permitían visualizar las variaciones identificables de cada tecla.

Se realizó un tratamiento adicional de los datos para mejorar las señales utilizadas para identificar las pulsaciones de teclas.

Estas imágenes de espectrogramas se utilizaron para entrenar 'CoAtNet', un clasificador de imágenes que atribuye diferentes espectrogramas de audio a distintas pulsaciones de teclas.

En sus pruebas, los investigadores utilizaron un ordenador portátil con un teclado similar al de los nuevos portátiles de Apple. Los micrófonos y métodos de grabación incluían un iPhone 13 Mini colocado a 17 cm del objetivo, Zoom y Skype.

El clasificador CoANet demostró una precisión de 95% a partir de grabaciones de teléfonos inteligentes y de 93% a partir de las capturadas mediante Zoom. También probaron las pulsaciones de teclas grabadas a través de Skype, que arrojaron una precisión de 91,7%.

El documento de investigación sugiere modificar los estilos de escritura o utilizar contraseñas aleatorias para evitar estos ataques, pero eso dista mucho de ser práctico.

Otras posibles medidas defensivas incluyen el empleo de software para reproducir los sonidos de las pulsaciones de teclas, ruido blanco o filtros de audio de pulsaciones de teclas basados en software. Sin embargo, el estudio descubrió que incluso un teclado silencioso podía analizarse con éxito en busca de pulsaciones.

Este es otro ejemplo novedoso de cómo el aprendizaje automático puede permitir sofisticadas técnicas de fraude. A estudio reciente descubrió que las voces de audio falsas y profundas podían engañar hasta 25% de personas.

Los ataques de audio podrían dirigirse a personas de alto perfil, como políticos y directores ejecutivos, para robar información sensible o lanzar ataques de ransomware basados en conversaciones robadas.