Un estudio realizado por psicólogos de la UCLA ha demostrado que el GPT-3 es tan bueno como los estudiantes universitarios en la resolución de problemas de razonamiento.

Sabemos que los LLM como GPT-3 son buenos generando respuestas basadas en los datos con los que han sido entrenados, pero su capacidad de razonamiento es cuestionable. El razonamiento analógico es la capacidad que tenemos los humanos de tomar lo que aprendemos de una experiencia no relacionada y aplicarlo a un problema al que no nos hemos enfrentado antes.

Esa capacidad es en la que te apoyas cuando tienes que responder a una pregunta que nunca has visto antes. Puedes razonarla basándote en problemas anteriores que has resuelto. Y según la investigación, parece que la GPT-3 también ha desarrollado esa capacidad.

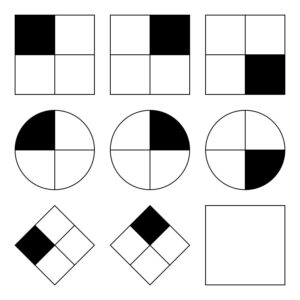

En Investigadores de la UCLA poner a GPT-3 a trabajar en una serie de problemas similares a Matrices progresivas de Raven que consiste en predecir la siguiente imagen de una serie de imágenes. Aquí tienes uno fácil para que lo intentes.

GPT-3 fue capaz de mantenerse a la altura de los 40 estudiantes universitarios de la UCLA a los que se pidió que realizaran la misma prueba. La IA acertó 80% de las respuestas, mientras que los 40 estudiantes obtuvieron una media de 60%. Los mejores estudiantes obtuvieron aproximadamente la misma puntuación que GPT-3.

El profesor de psicología de la UCLA Hongjing Lu, autor principal del estudio, afirmó: "Sorprendentemente, la GPT-3 no sólo lo hizo tan bien como los humanos, sino que también cometió errores similares".

Los investigadores también pidieron al GPT-3 que resolviera algunos problemas de asociación de palabras. Por ejemplo, "'Coche' es a 'Carretera' lo que 'Barco' es a ¿qué palabra?". La respuesta es, obviamente, "agua", pero este tipo de preguntas pueden resultar complicadas para una IA.

Bueno, al menos los investigadores pensaron que podría ser complicado. Resulta que los GPT-3 obtuvieron mejores resultados que la media de los solicitantes universitarios en sus pruebas SAT.

GPT-3 lucha con problemas que son fáciles para los humanos

Lo que les cuesta a los modelos de IA son los problemas que requieren una comprensión visual del espacio físico. Si le presentas a GPT-3 una lista de herramientas como un martillo, un clavo y un cuadro, no es capaz de encontrar la solución obvia para colgar el cuadro en la pared.

Este tipo de problema es fácil de resolver para los humanos porque podemos ver, sostener y sentir objetos físicos en un espacio que ocupamos. Esas experiencias facilitan que nuestros cerebros aprendan y resuelvan problemas de una forma que los modelos de IA no pueden. Dicho esto, GPT-4 está mejorando en este tipo de razonamiento ahora.

Aunque los investigadores pudieron medir el rendimiento de la GPT-3, no tienen ni idea del proceso de "pensamiento" que sigue para obtener las respuestas. ¿Sigue un proceso de pensamiento similar al de los humanos o hace algo completamente distinto? Como GPT-3 es un modelo cerrado, no es posible mirar bajo el capó para ver qué ocurre.

El sorprendente resultado de esta investigación es que la GPT-3 parece ser capaz de resolver problemas nuevos sin ningún entrenamiento directo. Esto coincide con la forma en que los humanos resuelven problemas nuevos. Se espera que GPT-4 rinda aún mejor en estos problemas y quién sabe qué otra capacidad "pensante" podría surgir con más pruebas.

Aunque el razonamiento espacial es un reto para los LLM, estos desafíos podrían resolverse mediante modelos visuales como RT-2 de Google anunciado recientemente. Una vez que los modelos de IA puedan empezar a "ver" e interactuar físicamente con su entorno, su capacidad para resolver problemas mejorará exponencialmente.