A medida que la IA sigue incorporándose a los procesos de contratación, está claro que la promesa de eficiencia de la tecnología conlleva sus propios riesgos.

Según Datos de 2022En la actualidad, alrededor del 55% de las empresas ya utilizan herramientas de IA para la contratación.

Aunque la IA ha acelerado las prácticas tradicionales de contratación, eliminando pilas de CV y currículos en el proceso, también ha planteado cuestiones críticas sobre la equidad, la parcialidad y la propia naturaleza de la toma de decisiones humana.

Al fin y al cabo, las IA se entrenan con datos humanos, por lo que son susceptibles de heredar todos los sesgos y prejuicios que prometen erradicar.

¿Es algo que podamos cambiar? ¿Qué hemos aprendido hasta ahora de la IA de contratación?

Grupos de derechos humanos acusan a Meta de prácticas publicitarias discriminatorias

Los datos muestran que algunos 79% de solicitantes de empleo utilizan las redes sociales para buscar empleo, y está demostrado que es ahí donde empieza la discriminación.

Meta es actualmente se enfrenta a múltiples acusaciones de organizaciones europeas de derechos humanos que afirman que el algoritmo de segmentación de anuncios de empleo de Facebook es sesgado.

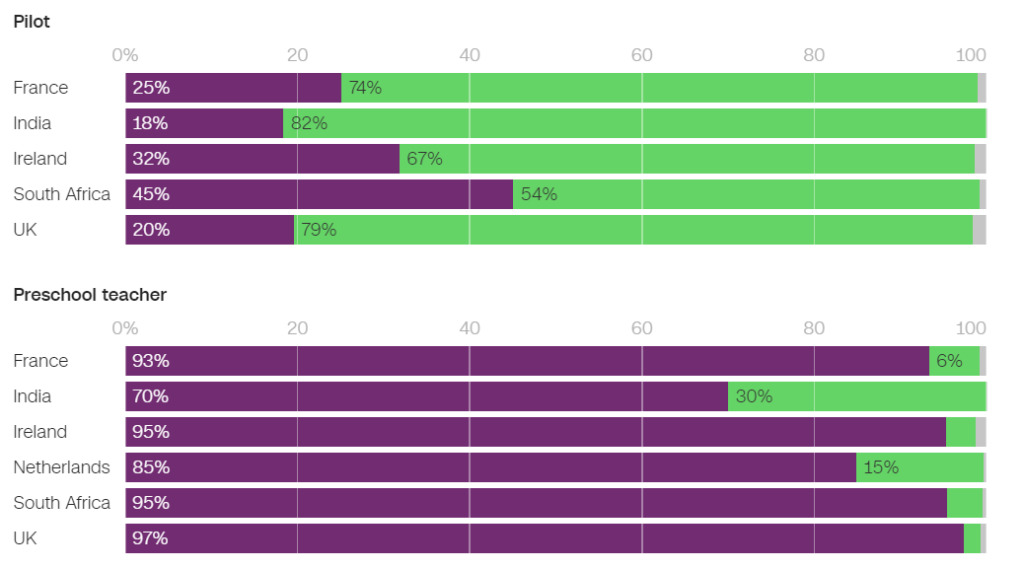

En junio, la ONG Testigo Mundial investigó varios anuncios de empleo autodirigidos en Facebook y descubrió que muchos perpetuaban prejuicios sexistas.

Por ejemplo, los hombres tenían muchas más probabilidades de que se les mostraran anuncios relacionados con la ingeniería, mientras que las mujeres tenían muchas más probabilidades de que se les mostraran anuncios relacionados con la enseñanza.

De los anuncios mostrados en Francia, 93% de los usuarios que vieron un anuncio de trabajo de profesor de preescolar y 86% de los que vieron un anuncio de trabajo de psicólogo eran mujeres. Por el contrario, sólo 25% de las mujeres vieron un anuncio de trabajo de piloto y apenas 6% vieron un anuncio de trabajo de mecánico.

En los Países Bajos, 85% de los usuarios a los que se mostró un anuncio de trabajo de profesor y 96% de los que se mostró un anuncio de trabajo de recepcionista eran mujeres. Se observaron resultados similares en muchos otros países, como Reino Unido, India y Sudáfrica.

En un entrevista con CNNEn palabras de Naomi Hirst, de Global Witness: "Nuestra preocupación es que Facebook está exacerbando los prejuicios que vivimos en la sociedad y, de hecho, estropeando las oportunidades de progreso y equidad en el lugar de trabajo".

Junto con Bureau Clara Wichmann y la Fondation des Femmes, Global Witness ha presentado denuncias contra Meta ante las autoridades de derechos humanos y protección de datos de Francia y los Países Bajos.

Los grupos piden que se investigue si las prácticas de Meta vulneran los derechos humanos o la legislación sobre protección de datos. Si las acusaciones se confirman, Meta podría enfrentarse a multas y sanciones.

En respuesta, un portavoz de Meta declaró: "El sistema tiene en cuenta distintos tipos de información para intentar ofrecer a la gente anuncios que le interesen más."

No es la primera vez que Meta rechaza este tipo de críticas. múltiples demandas en 2019 y se comprometió a cambiar su sistema de difusión de anuncios para evitar los prejuicios basados en características protegidas como el sexo y la raza.

Pat de Brún, de Amnistía Internacional, fue mordaz con las conclusiones de Global Witness. "La investigación muestra sistemáticamente cómo los algoritmos de Facebook producen resultados profundamente desiguales y a menudo refuerzan la marginación y la discriminación", dijo a CNN.

Amazon desecha una herramienta secreta de reclutamiento por IA que mostraba prejuicios contra las mujeres

Amazon desarrolló una herramienta de contratación de IA entre 2014 y 2017 antes de darse cuenta de que la herramienta estaba sesgada al seleccionar trabajos de desarrollador de software y otros puestos técnicos. En 2018, Amazon abandonó la herramienta por completo.

El sistema de IA penalizaba los currículos que contenían la palabra "mujer" y "femenino" y rebajaba las cualificaciones de las licenciadas.

El sistema falló incluso después de que Amazon intentara editar los algoritmos para que no tuvieran en cuenta el género.

Más tarde se supo que Amazon había entrenado la herramienta a partir de currículos enviados a la empresa durante un periodo de 10 años, la mayoría de los cuales procedían de hombres.

Como muchos sistemas de IA, la herramienta de Amazon se vio influida por los datos con los que se entrenó, lo que provocó un sesgo involuntario. Este sesgo favorecía a los candidatos masculinos y prefería los currículos que utilizaban un lenguaje más habitual en los currículos de los ingenieros hombres.

Además, debido a problemas con los datos subyacentes, el sistema recomendaba a menudo candidatos no cualificados para diversos puestos.

En Foro Económico Mundial dice sobre el sistema de contratación de Amazon: "Por ejemplo, como en el caso de Amazon, los fuertes desequilibrios de género podrían correlacionarse con el tipo de estudio realizado. Estos sesgos de los datos de formación también podrían surgir debido a la mala calidad de los datos o a conjuntos de datos muy pequeños y no diversos, lo que puede ser el caso de las empresas que no operan a nivel mundial y buscan candidatos de nicho."

Amazon consiguió reutilizar una "versión diluida" del motor de contratación para tareas rudimentarias, como eliminar perfiles de candidatos duplicados de las bases de datos.

Crearon un nuevo equipo para hacer otro intento de selección automatizada de personal, esta vez centrado en promover la diversidad.

Google lucha contra sus propios problemas de discriminación y parcialidad

En diciembre de 2020, el Dr. Timnit Gebru, destacado especialista en ética de la IA en Google, anunció que la empresa la había despedido.

El cese se produjo después de que el Dr. Gebru expresara su preocupación por el enfoque de Google respecto a la contratación de minorías y el sesgo inherente a los sistemas de IA.

Antes de abandonar la empresa, el Dr. Gebru iba a publicar un artículo en el que ponía de manifiesto la parcialidad de los modelos de IA de Google.

Tras presentar este artículo en una conferencia académica, la Dra. Gebru reveló que un directivo de Google le pidió que se retractara del artículo o que retirara su nombre y el de los demás investigadores de Google. Al negarse, Google aceptó una propuesta de dimisión condicional, con lo que la Dra. Gebru quedó cesada de inmediato.

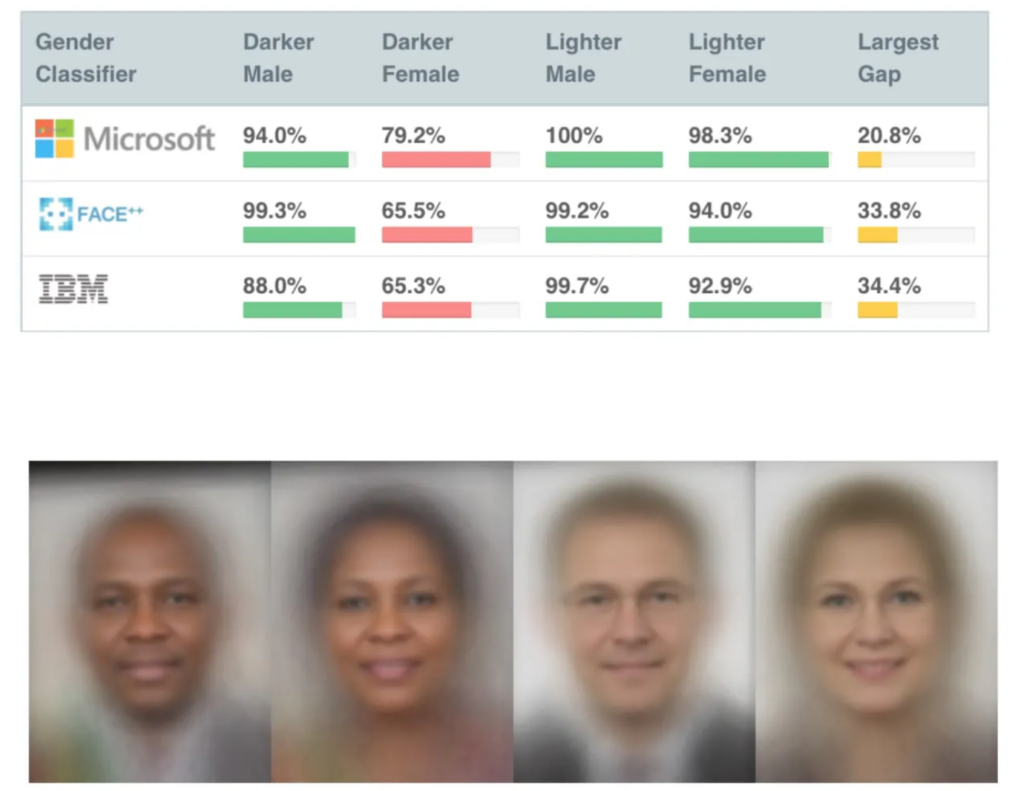

Esto no ocurrió mucho después de que se publicaran varios estudios muy influyentes sobre el sesgo de la IA, entre ellos Estudio del MIT sobre los matices de géneroque se ha convertido en uno de los artículos sobre IA más citados de todos los tiempos.

El estudio Gender Shades descubrió un sesgo en las IA de reconocimiento facial, que identificaban erróneamente los rostros negros aproximadamente entre 30% y 35% de las veces, frente a alrededor de 5% en el caso de los rostros blancos.

Unas coincidencias incorrectas de reconocimiento facial condujeron a la detención y encarcelamiento injustos de varios hombres en EE.UU..

El despido de Gebru provocó una tormenta mediática en torno a las prácticas discriminatorias en Silicon Valley.

Mutale Nkonde, del Laboratorio de Sociedad Civil Digital de Stanford, declaró: "Su despido sólo indica que los científicos, activistas y académicos que quieren trabajar en este campo -y son mujeres negras- no son bienvenidos en Silicon Valley."

El despido del Dr. Gebru inspiró otro estudio, Desenmascarar los prejuicios codificadosen el que se constató que las personas de raza negra tenían muchas más probabilidades de ser infravaloradas por la IA de contratación que cualquier otra persona.

"Este informe encontró amplias pruebas que sugieren que los estudiantes y profesionales negros están preocupados por enfrentarse a prejuicios contra los negros durante el proceso de contratación. Algo más de la mitad de los encuestados afirman haber observado prejuicios en el proceso de contratación o reclutamiento en sitios web de contratación o reclutamiento. Los profesionales negros son ligeramente más propensos a haber observado tal sesgo, con un cincuenta y cinco por ciento de los encuestados indicando haber observado sesgos en el proceso de contratación". Desenmascarar los prejuicios codificados, Penn Law Policy Lab.

El documento afirma: "La conversación pública espoleada por la Dra. Gebru y sus colegas sobre el sesgo algorítmico permitió a nuestro laboratorio participar en este diálogo nacional y ampliar una comprensión más matizada del sesgo algorítmico en las plataformas de contratación."

La exposición del problema ha sido un catalizador para el cambio, pero la IA tiene un largo camino por delante para conciliar su papel en la toma de decisiones humanas sensibles.

El papel de la IA en la contratación: rescatar algunos aspectos positivos

A pesar de las numerosas controversias, ha sido difícil para las empresas resistirse al inmenso potencial de la IA para acelerar la contratación.

El papel de la IA en la contratación tiene cierto sentido lógico: podría ser más fácil librar a la IA de prejuicios que a los humanos. Al fin y al cabo, la IA es *solo* matemáticas y código, seguramente más maleable que los prejuicios inconscientes profundamente arraigados.

Y aunque los datos de formación estaban muy sesgados a principios y mediados de la década de 2010, principalmente debido a la falta de conjuntos de datos diversos, se puede decir que esto ha mejorado desde entonces.

Una destacada herramienta de contratación con IA es SapiaSapia, apodado "entrevistador inteligente". Según la fundadora de Sapia, Barb Hyman, la IA permite un proceso de entrevista "a ciegas" que no se basa en currículos, redes sociales o datos demográficos, sino únicamente en las respuestas del candidato, eliminando así los sesgos que prevalecen en la contratación dirigida por humanos.

Estos sistemas pueden proporcionar una oportunidad justa para todos entrevistando a todos los solicitantes. Hyman sugiereTienes el doble de probabilidades de contratar y mantener a mujeres en el proceso de contratación si utilizas IA".

Pero incluso el propio proceso de entrevistar a alguien con IA plantea dudas.

Los modelos de procesamiento del lenguaje natural (PLN) suelen entrenarse principalmente con textos nativos en inglés, lo que significa que están mal manejo del inglés no nativo.

Estos sistemas podrían penalizar inadvertidamente a los hablantes no nativos de inglés o a los que tienen rasgos culturales diferentes. Además, los críticos sostienen que las discapacidades podrían no tenerse debidamente en cuenta en un chat o una entrevista de vídeo con IA, lo que podría dar lugar a una mayor discriminación.

Esto se agrava por el hecho de que los solicitantes a menudo no saben si una IA les está evaluando, lo que hace imposible solicitar los ajustes necesarios en el proceso de entrevista.

Los conjuntos de datos son fundamentales

Los conjuntos de datos son fundamentales. Si entrenas a una IA con datos de hace una década, aprenderá valores de hace una década.

El mercado laboral se ha diversificado considerablemente desde el cambio de milenio.

Por ejemplo, en algunos países las mujeres superan a los hombres en varias disciplinas médicas clave, como psicología, genética, pediatría e inmunología.

En el Reino Unido, un informe 2023 descubrió que 27% de las mujeres empleadas trabajaban en "ocupaciones profesionales" (como médicos, ingenieros, enfermeros, contables, profesores y abogados), frente a 26% de los hombres, una tendencia que ha aumentado de forma constante durante 5 a 10 años.

Estas transiciones se han acelerado en los últimos 2 a 5 años: muchos conjuntos de datos son antiguos y sencillamente no reflejan datos recientes. La raza y la discapacidad plantean problemas similares a los del género.

Los conjuntos de datos deben reflejar nuestros lugares de trabajo, cada vez más diversos, para servir a todos con equidad.

Aunque aún queda mucho por hacer para garantizar la diversidad en el lugar de trabajo, la IA debe heredar valores del presente y no del pasado. Eso debería ser lo mínimo para producir IA de contratación justas y transparentes.

Es probable que los desarrolladores de IA de contratación se enfrenten a una estricta regulación, ya que EE.UU., Reino Unido, China, los Estados miembros de la UE y muchos otros países están a punto de hacerlo. reforzar los controles de la IA en los próximos años.

Se sigue investigando, pero sigue siendo poco probable que la mayoría de las IA de contratación apliquen los principios justos e imparciales que esperamos de las demás.