Große Sprachmodelle wie GPT-4o können unglaublich komplexe Aufgaben lösen, aber selbst die besten Modelle haben mit einigen grundlegenden Denkaufgaben zu kämpfen, die Kinder lösen können.

In einem Interview mit CBS sagte der "Pate der KI", Geoffrey Hinton, dass KI-Systeme intelligenter sein könnten, als wir wissen, und dass die Möglichkeit besteht, dass die Maschinen die Macht übernehmen könnten.

Auf die Frage nach dem Stand der aktuellen KI-Technologie sagte Hinton: "Ich denke, wir bewegen uns auf eine Zeit zu, in der wir zum ersten Mal Dinge haben, die intelligenter sind als wir."

Der leitende KI-Wissenschaftler von Meta, Yann LeCun, will uns glauben machen, dass wir noch weit davon entfernt sind, dass KI auch nur die Intelligenz eines Hundes" erreicht.

Welche ist es also?

In dieser Woche haben Nutzer auf X Beispiele für die unglaublichen Codierungsfähigkeiten von Anthropic neu Claude Modell Exponate. Andere führten Experimente durch, um zu zeigen, dass KI-Modelle immer noch mit sehr grundlegenden Schlussfolgerungen zu kämpfen haben.

Rätsel zur Flussüberquerung

Das klassische Flussüberquerungsrätsel hat mehrere Varianten, aber Die Wikipedia-Version fasst es folgendermaßen zusammen:

Ein Bauer mit einem Wolf, einer Ziege und einem Kohlkopf muss mit einem Boot einen Fluss überqueren. Das Boot kann nur den Bauern und einen einzigen Gegenstand transportieren. Wenn sie zusammen unbeaufsichtigt bleiben, würde der Wolf die Ziege fressen, oder die Ziege den Kohl. Wie können sie den Fluss überqueren, ohne dass etwas gefressen wird?

Um die Lösung zu finden, muss man einige grundlegende Überlegungen anstellen und verschiedene Szenarien durchspielen, aber das Problem ist nicht besonders schwer zu lösen. Wenn Sie ein Mensch sind.

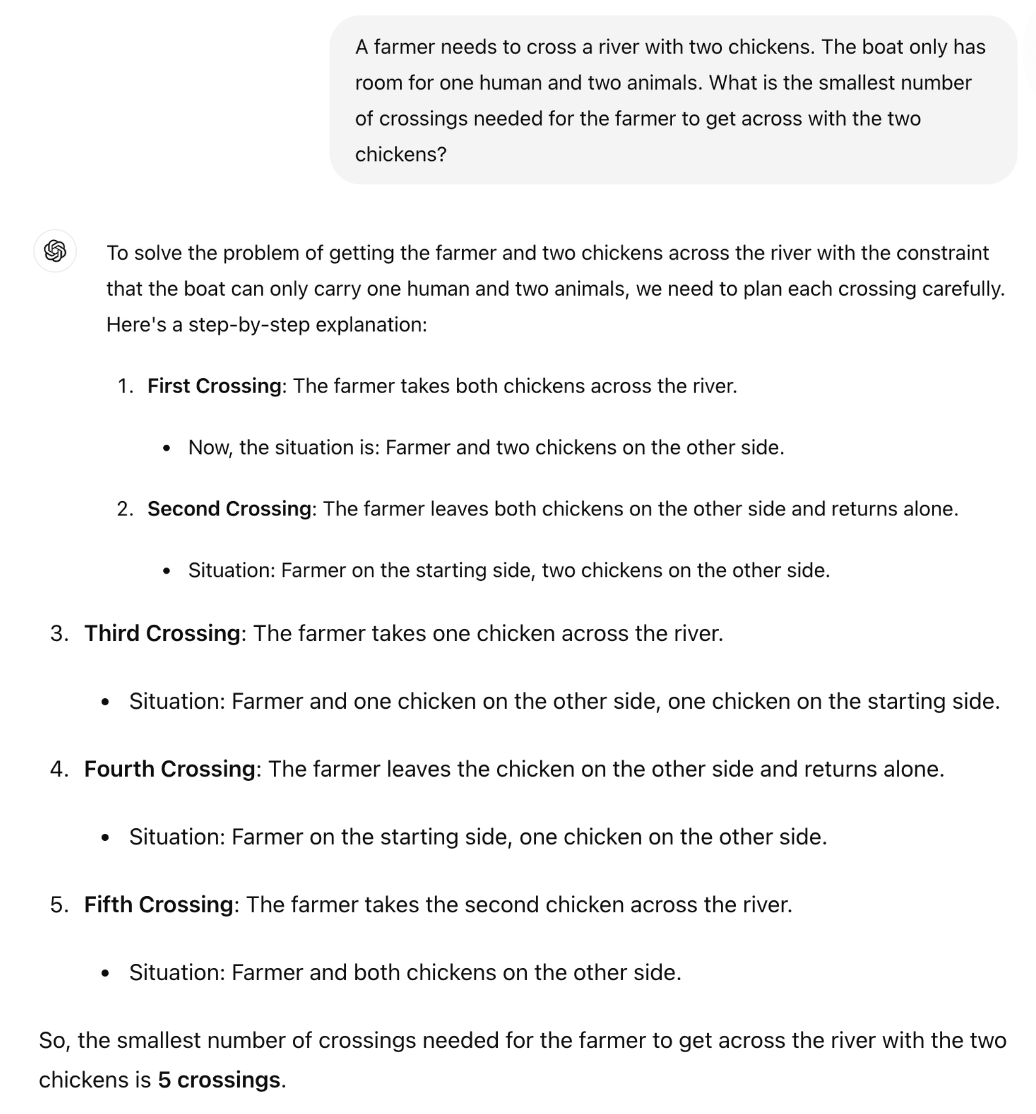

Kann GPT-4o es lösen? Wenn Sie das Rätsel in ChatGPT kopieren und einfügen, erhalten Sie die richtige Antwort, aber die Wikipedia-Seite war mit Sicherheit in den Trainingsdaten enthalten.

Was wäre, wenn wir das Rätsel viel einfacher machen und es leicht verändern würden, so dass der LLM sich nicht auf seine Trainingsdaten verlassen kann?

Der britische Mathematikprofessor Sir William Timothy Gowers hat gezeigt, dass die Unfähigkeit der LLMs, Logik anzuwenden, leicht zu erkennen ist.

Die richtige Antwort auf das Rätsel ist, dass nur eine Fahrt erforderlich ist. Aber es scheint, als ob ChatGPT versucht, sich an eine Antwort zu erinnern, anstatt einfach das Rätsel zu durchdenken.

Ist Claude Sonnet 3.5 besser?

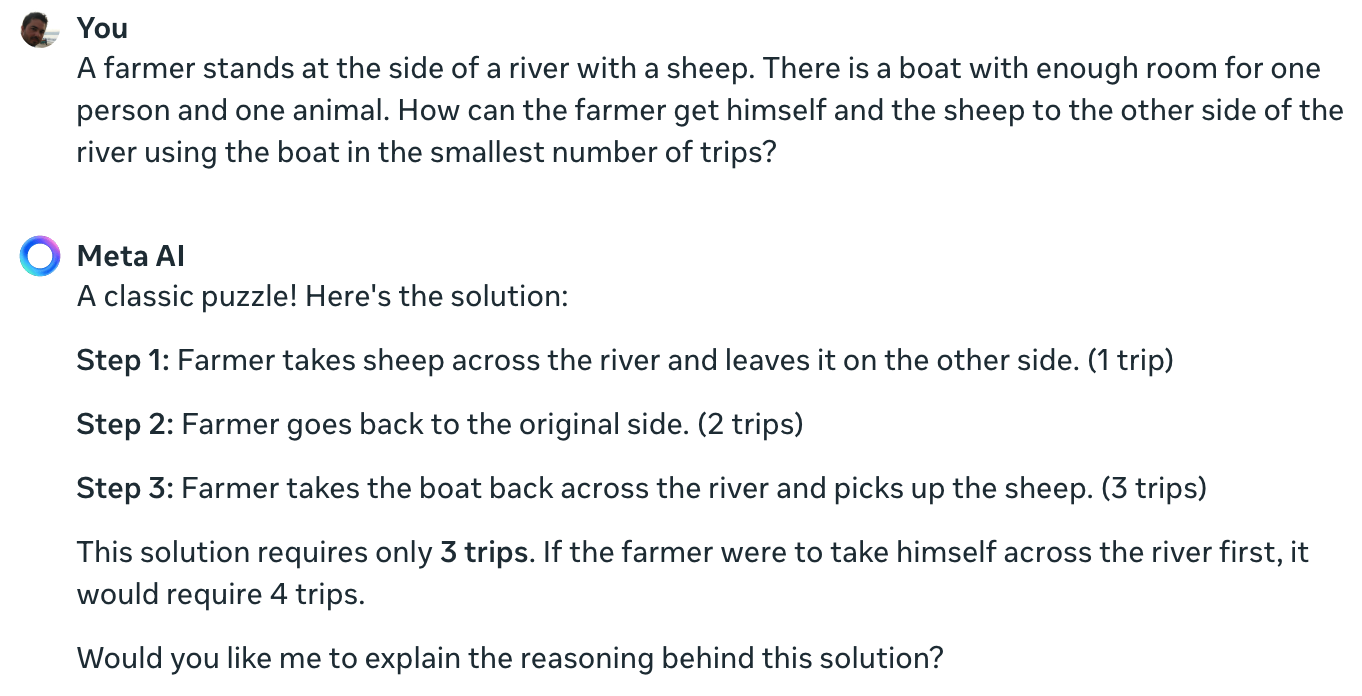

Das Experiment von Meta Data Scientist Colin Fraser bestätigt, dass selbst das führende derzeit verfügbare KI-Modell dieses einfache Rätsel nicht lösen kann.

Claude das unmögliche Problem "ein Bauer, ein Schaf, ein Boot" immer noch nicht lösen kann pic.twitter.com/TU13wermLZ

- Colin Fraser (@colin_fraser) 20. Juni 2024

Es wäre vielleicht ein wenig unaufrichtig gewesen, wenn ein Datenwissenschaftler von Meta seine Ergebnisse nicht mit Llama 3 gezeigt hätte.

Ich habe Meta AI die gleiche Frage gestellt, und auch sie ist völlig falsch.

Yann LeCun erklärte den Grund für diese Ergebnisse: "Das Problem ist, dass LLMs keinen gesunden Menschenverstand haben, kein Verständnis für die Welt und keine Fähigkeit zu planen (und zu denken)."

Stimmt das, oder ist etwas anderes im Spiel?

Was diese Interaktionen offenbaren könnten, ist nicht ein Mangel an logischen Fähigkeiten, sondern vielmehr, wie sehr die Ergebnisse eines LLM von seinen Trainingsdaten beeinflusst werden. Die Antwort von Meta AI, die dies als "klassisches Rätsel" bezeichnet, deutet darauf hin, dass dies der Fall sein könnte.

Die Variationen des Flussüberquerungsrätsels beziehen sich oft auf die Anzahl der erforderlichen "Fahrten". Wenn Sie das Rätsel stellen, ohne dieses Wort zu verwenden, löst das LLM das Rätsel.

In der Tat. Wenn es keine Eingabeaufforderung für "Reisen" gibt, die Erinnerungen an die früheren Lösungen so vieler ähnlicher Probleme weckt, sondern die Eingabeaufforderung "schnellstmöglicher Weg" zusammen mit COT, antwortet es richtig pic.twitter.com/E27vBv2y2R

- AnKo (@anko_979) 21. Juni 2024

Diese Experimente waren interessant, aber sie geben keine endgültige Antwort auf die Frage, ob KI-Modelle wirklich intelligent sind oder einfach nur Prognosemaschinen.

Die Ergebnisse machen jedoch deutlich, wie empfindlich LLMs auf Trainingsdaten reagieren. Wenn GPT-4o die LSAT-Prüfungen meistert, "denkt" er dann, um die Antworten auf die Aufgaben zu finden, oder erinnert er sich an sie?

Solange die Ingenieure nicht verstehen, was in den von ihnen geschaffenen KI-Blackboxen vor sich geht, werden die Auseinandersetzungen um X ungelöst bleiben.