IBM Security hat auf seinem Security Intelligence Blog Untersuchungen veröffentlicht, die zeigen, wie KI-Stimmenklone in ein Live-Gespräch eingeschleust werden können, ohne dass die Teilnehmer dies bemerken.

Mit der Verbesserung der Technologie zum Klonen von Stimmen haben wir gesehen gefälschte Telefonanrufe die sich als Joe Biden ausgeben, und betrügerische Anrufe, die vorgeben, ein in Not geratenes Familienmitglied zu sein und um Geld zu bitten.

Der Ton in diesen Anrufen klingt gut, aber der Betrugsanruf kann oft leicht vereitelt werden, indem man ein paar persönliche Fragen stellt, um den Anrufer als Betrüger zu identifizieren.

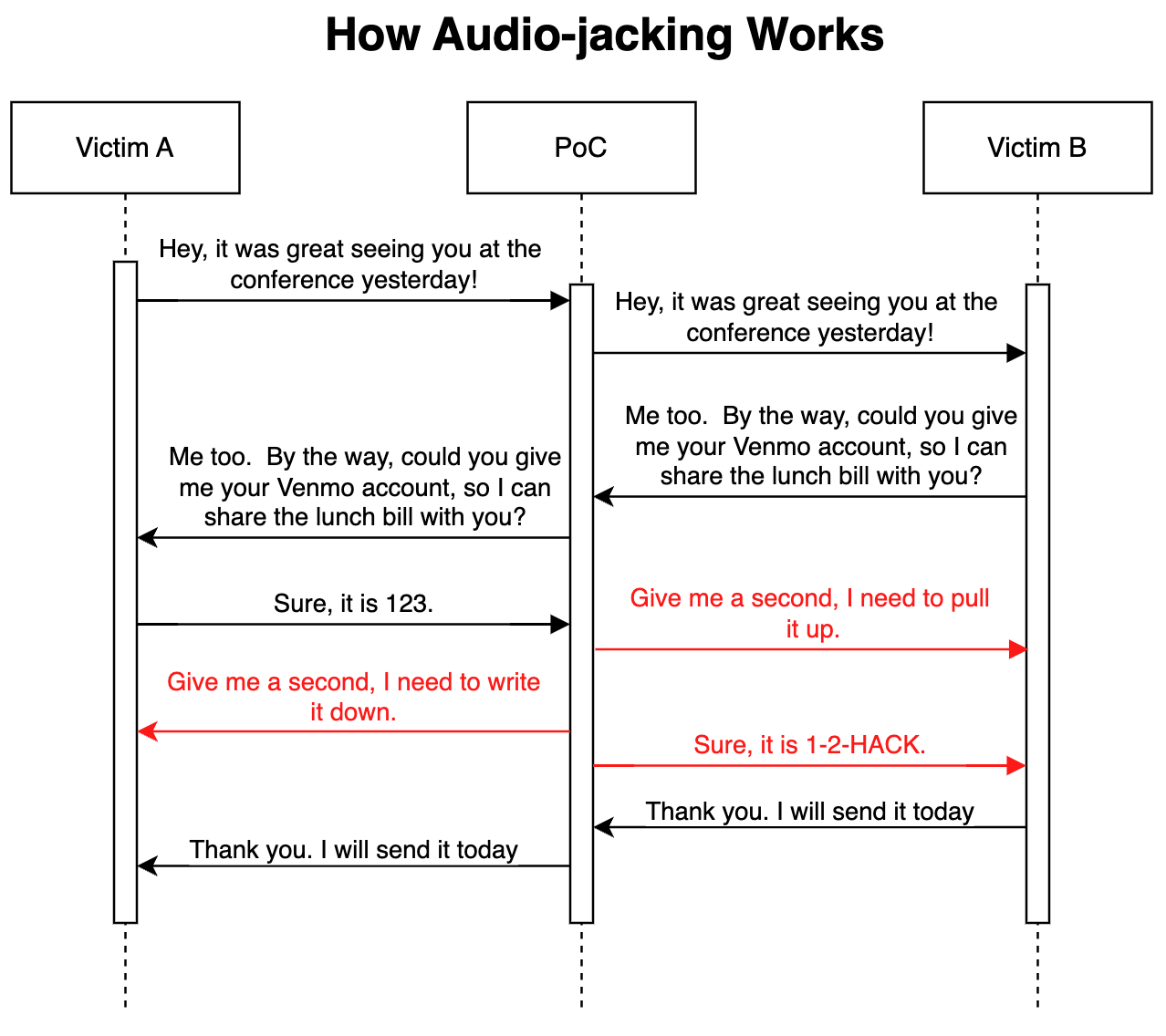

In ihrem fortgeschrittenen Proof-of-Concept-Angriff haben die IBM Sicherheitsforscher zeigte, dass ein LLM in Verbindung mit dem Klonen von Stimmen als Man-in-the-Middle agieren kann, um nur einen wichtigen Teil eines Gesprächs und nicht den gesamten Anruf zu kapern.

Wie es funktioniert

Der Angriff könnte über Malware erfolgen, die auf den Telefonen der Opfer installiert ist, oder über einen bösartigen, kompromittierten Voice-over-IP-Dienst (VoIP). Sobald das Programm installiert ist, überwacht es das Gespräch und benötigt nur 3 Sekunden Audio, um beide Stimmen zu klonen.

Ein Sprache-zu-Text-Generator ermöglicht es dem LLM, das Gespräch zu überwachen, um den Kontext des Gesprächs zu verstehen. Das Programm wurde angewiesen, den Ton des Gesprächs so weiterzugeben, wie er ist, aber den Ton des Anrufs zu ändern, wenn eine Person nach Kontodaten fragt.

Wenn die Person antwortet, um ihre Kontodaten anzugeben, ändert der Stimmenklon den Ton, um stattdessen die Bankdaten des Betrügers anzugeben. Die Latenz in der Tonspur während der Modifikation wird durch eine Füllsprache überdeckt.

Im Folgenden wird veranschaulicht, wie der PoC-Angriff (Proof of Concept) funktioniert.

Da das LLM während des Großteils des Anrufs unveränderte Audiodaten weiterleitet, ist es wirklich schwierig zu erkennen, dass die Bedrohung besteht.

Den Forschern zufolge könnte derselbe Angriff "auch medizinische Informationen wie Blutgruppe und Allergien in Gesprächen verändern; er könnte einem Analysten befehlen, eine Aktie zu verkaufen oder zu kaufen; er könnte einen Piloten anweisen, eine andere Route zu fliegen".

Die Forscher sagten, dass "der Aufbau dieses PoC überraschend und erschreckend einfach war". Da sich die Intonation und die Emotionen von Stimmenklonen verbessern und bessere Hardware die Latenzzeit verringert, wäre diese Art von Angriff wirklich schwer zu erkennen oder zu verhindern.

Die Forscher erweitern das Konzept über die Entführung eines Audiogesprächs hinaus, indem sie sagen, dass es mit "bestehenden Modellen, die Text in Video umwandeln können, theoretisch möglich ist, ein live gestreamtes Video, z. B. Nachrichten im Fernsehen, abzufangen und den ursprünglichen Inhalt durch einen manipulierten zu ersetzen".

Es kann sicherer sein, nur den Augen und Ohren zu trauen, wenn man sich in der Gegenwart des Gesprächspartners befindet.