Alibaba hat mehr als 100 quelloffene KI-Modelle veröffentlicht, darunter Qwen 2.5 72B, das andere quelloffene Modelle in Mathematik- und Codierungsbenchmarks übertrifft.

Ein Großteil der Aufmerksamkeit der KI-Branche für Open-Source-Modelle galt den Bemühungen von Meta mit Llama 3, aber Qwen 2.5 von Alibaba hat die Lücke deutlich geschlossen. Die gerade veröffentlichte Qwen 2.5-Modellfamilie umfasst Modelle mit 0,5 bis 72 Milliarden Parametern, die sowohl verallgemeinerte Basismodelle als auch Modelle für sehr spezifische Aufgaben umfassen.

Laut Alibaba verfügen diese Modelle über "erweiterte Kenntnisse und stärkere Fähigkeiten in den Bereichen Mathematik und Kodierung" mit spezialisierten Modellen, die sich auf Kodierung, Mathematik und mehrere Modalitäten wie Sprache, Audio und Sehen konzentrieren.

Alibaba Cloud kündigte auch ein Upgrade seines proprietären Flaggschiffmodells Qwen-Max an, das es nicht als Open-Source veröffentlicht hat. Die Qwen-2.5-Max-Benchmarks sehen gut aus, aber es ist das Qwen-2.5-72B-Modell, das für die meiste Aufregung unter den Open-Source-Fans gesorgt hat.

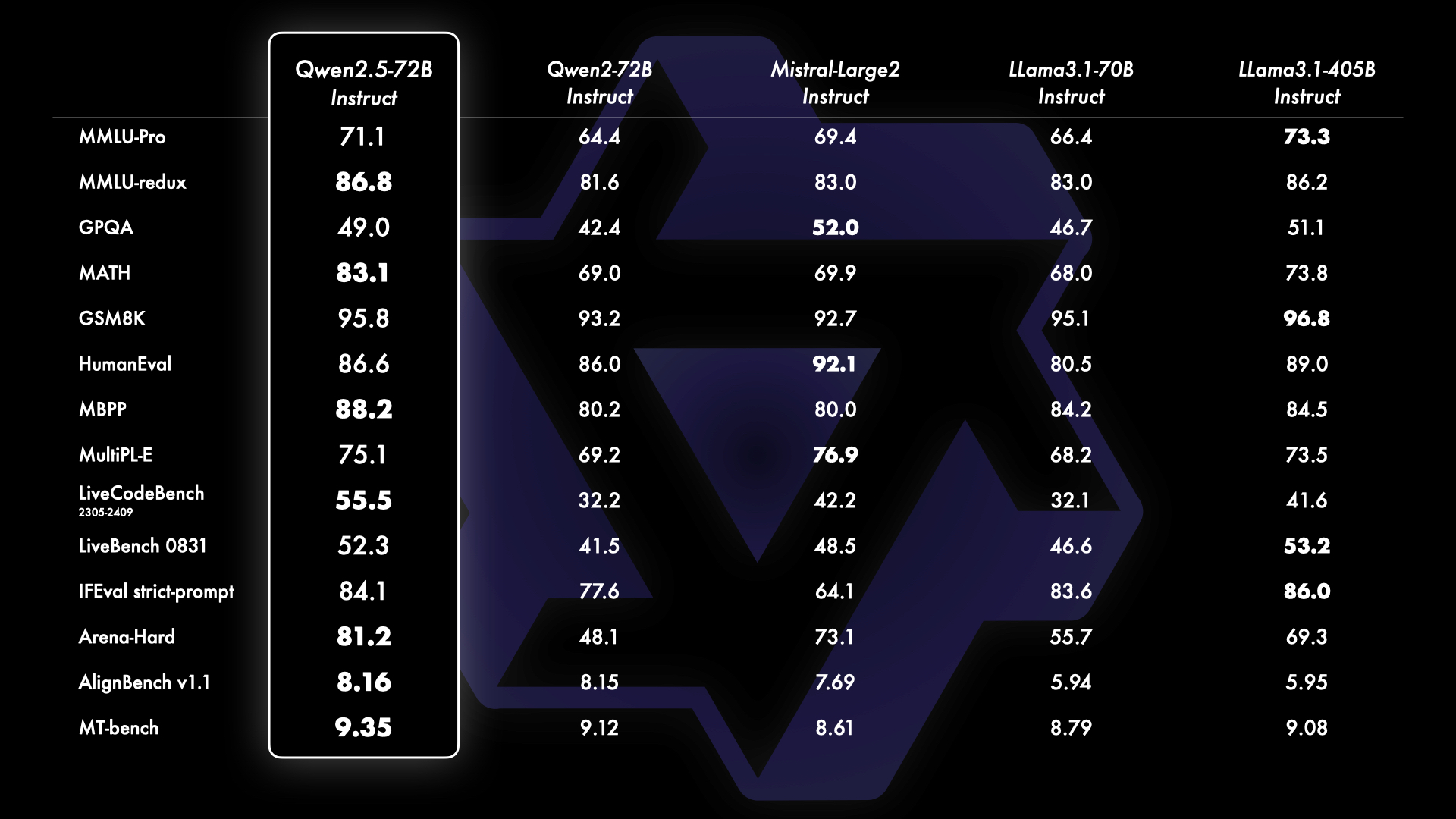

Die Benchmarks zeigen, dass Qwen 2.5 72B das viel größere Flaggschiff von Meta schlägt Llama 3.1 405B Modell an mehreren Fronten, vor allem in den Bereichen Mathematik und Codierung. Die Kluft zwischen Open-Source-Modellen und proprietären Modellen wie denen von OpenAI und Google schließt sich ebenfalls schnell.

Erste Nutzer von Qwen 2.5 72B zeigen, dass das Modell nur knapp hinter Sonnet 3.5 zurückbleibt und es sogar übertrifft OpenAIdie o1-Modelle bei der Kodierung.

Open Source Qwen 2.5 schlägt o1-Modelle bei der Kodierung 🤯🤯

Qwen 2.5 schneidet bei der Kodierung auf Livebench AI besser ab als die o1-Modelle

Qwen liegt knapp unter Sonnet 3.5, und für einen Open-Source-Modus ist das fantastisch!!!

o1 ist gut in einigen harten Kodierungen, aber schrecklich bei Code-Vervollständigungsproblemen und... pic.twitter.com/iazam61eP9

- Bindu Reddy (@bindureddy) 20. September 2024

Laut Alibaba wurden diese neuen Modelle auf einem umfangreichen Datensatz trainiert, der bis zu 18 Billionen Token umfasst. Die Qwen-2.5-Modelle verfügen über ein Kontextfenster von bis zu 128k und können Ausgaben von bis zu 8k Token generieren.

Der Wechsel zu kleineren, leistungsfähigeren und kostenlosen Open-Source-Modellen wird wahrscheinlich für viele Nutzer größere Auswirkungen haben als fortschrittlichere Modelle wie o1. Die Rand- und On-Device-Fähigkeiten dieser Modelle bedeuten, dass man mit einem kostenlosen Modell, das auf dem Laptop läuft, sehr viel anfangen kann.

Das kleinere Qwen 2.5-Modell bietet GPT-4-Codierung für einen Bruchteil der Kosten oder sogar kostenlos, wenn Sie einen anständigen Laptop haben, um es lokal auszuführen.

Wir haben GPT-4 zur Codierung zu Hause! Ich habe nachgeschaut OpenAI?ref_src=twsrc%5Etfw”>@OpenAI GPT-4 0613 Ergebnisse für verschiedene Benchmarks und verglich sie mit @Alibaba_Qwen 2.5 7B-Codierer. 👀

> 15 Monate nach der Veröffentlichung von GPT-0613 haben wir ein offenes LLM unter Apache 2.0, das genauso gut funktioniert. 🤯

> GPT-4 Preise... pic.twitter.com/2szw5kwTe5

- Philipp Schmid (@_philschmid) 22. September 2024

Zusätzlich zu den LLMs hat Alibaba mit der Einführung von Qwen2-VL ein bedeutendes Update seines Vision-Sprachmodells veröffentlicht. Qwen2-VL kann Videos mit einer Dauer von über 20 Minuten verstehen und unterstützt videobasierte Fragebeantwortung.

Es ist für die Integration in Mobiltelefone, Automobile und Roboter konzipiert, um die Automatisierung von Vorgängen zu ermöglichen, die ein visuelles Verständnis erfordern.

Alibaba hat außerdem ein neues Text-to-Video-Modell als Teil seines Bildgenerators, der großen Tongyi Wanxiang-Modellfamilie, vorgestellt. Tongyi Wanxiang AI Video kann Videoinhalte in Kinoqualität und 3D-Animationen mit verschiedenen künstlerischen Stilen auf der Grundlage von Textanweisungen produzieren.

Die Demos sehen beeindruckend aus, und die Nutzung des Tools ist kostenlos, obwohl Sie eine chinesische Handynummer benötigen, um melden Sie sich hier an. Sora wird ernsthafte Konkurrenz bekommen, wenn oder falls OpenAI es schließlich veröffentlicht.