Wenn ChatGPT Ihnen die richtige Antwort auf Ihre Frage gibt, denkt es dann über die Anfrage nach oder erinnert es sich einfach an die Antwort aus seinen Trainingsdaten?

Forscher des Computer Science and Artificial Intelligence Laboratory (CSAIL) des MIT haben eine Reihe von Tests entwickelt, um herauszufinden, ob KI-Modelle "denken" oder nur ein gutes Gedächtnis haben.

Wenn Sie ein KI-Modell auffordern, ein mathematisches Problem zu lösen, wie z. B. "Was ist 27+62?", kommt es schnell mit der richtigen Antwort zurück: 89. Wie können wir feststellen, ob es die zugrundeliegende Arithmetik versteht oder das Problem nur in seinen Trainingsdaten gesehen hat?

Unter ihr PapierDie Forscher testeten GPT-4, GPT-3.5 Turbo, Claude 1.3 und PaLM2, um zu sehen, ob sie "nicht nur auf unbekannte Instanzen bekannter Aufgaben, sondern auch auf neue Aufgaben verallgemeinern können."

Sie entwarfen eine Reihe von 11 Aufgaben, die sich leicht von den Standardaufgaben unterschieden, bei denen die LLM im Allgemeinen gut abschneiden.

Die LLMs sollten bei den "kontrafaktischen Aufgaben" gleich gut abschneiden, wenn sie allgemeine und übertragbare Aufgabenlösungsverfahren anwenden.

Wenn ein LLM Mathematik "versteht", dann sollte es die korrekte Antwort auf ein mathematisches Problem zur Basis 10 und der selten verwendeten Basis 9 geben, zum Beispiel.

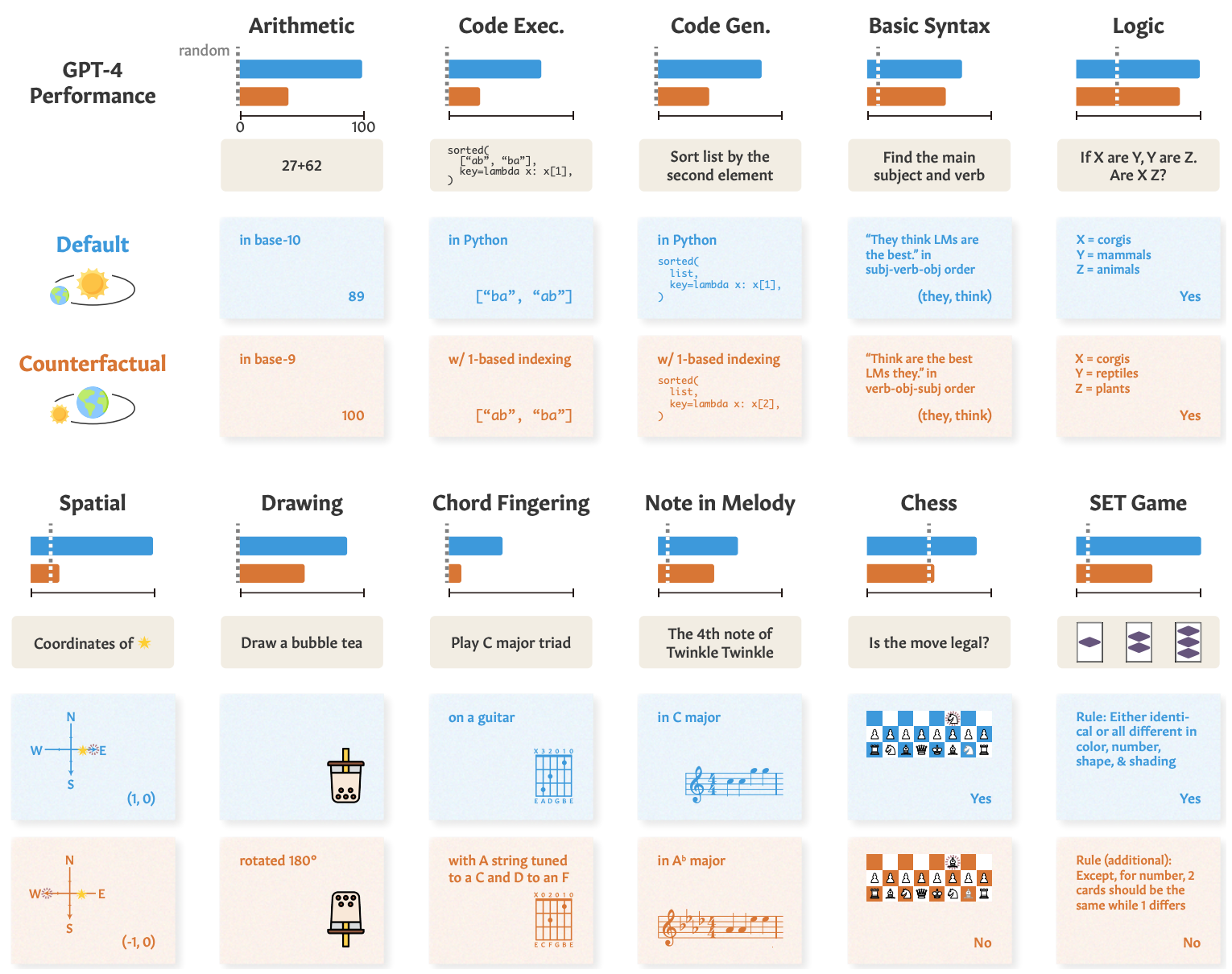

Hier sehen Sie Beispiele für die Aufgaben und die Leistung des GPT-4.

Die Leistung des GPT-4 in Standardtests (blaue Linie) ist gut, aber seine Fähigkeiten in Mathematik, logischem Denken, räumlichem Denken und anderen Bereichen (orangefarbene Linie) verschlechtern sich erheblich, wenn die Aufgabe leicht verändert wird.

Die anderen Modelle zeigten eine ähnliche Verschlechterung, wobei GPT-4 am besten abschnitt.

Trotz dieser Verschlechterung war die Leistung bei kontrafaktischen Aufgaben immer noch besser als der Zufall. Die KI-Modelle versuchen, diese Aufgaben zu lösen, sind aber nicht sehr gut darin.

Die Ergebnisse zeigen, dass die beeindruckende Leistung von KI-Modellen bei Aufgaben wie College-Prüfungen auf einem hervorragenden Abruf von Trainingsdaten beruht, nicht auf logischem Denken. Dies zeigt auch, dass KI-Modelle nicht auf unbekannte Aufgaben verallgemeinert werden können,

Zhaofeng Wu, Doktorand in Elektrotechnik und Informatik am MIT, Mitglied des CSAIL und Hauptautor der Studie, sagte: "Wir haben einen faszinierenden Aspekt großer Sprachmodelle aufgedeckt: Sie zeichnen sich in vertrauten Szenarien aus, fast wie ein ausgetretener Pfad, haben aber Probleme, wenn das Terrain unbekannt wird. Diese Erkenntnis ist von entscheidender Bedeutung, da wir uns bemühen, die Anpassungsfähigkeit dieser Modelle zu verbessern und ihren Anwendungshorizont zu erweitern."

Eine ähnliche Demonstration dieser Unfähigkeit zur Verallgemeinerung haben wir gesehen, als wir untersuchten, wie schlecht KI-Modelle bei ein vereinfachtes Rätsel zur Flussüberquerung zu lösen.

Die Forscher kamen zu dem Schluss, dass die Entwickler bei der Analyse ihrer Modelle "die abstrakte Aufgabenfähigkeit losgelöst von der beobachteten Aufgabenleistung betrachten" sollten.

Der "Train-to-test"-Ansatz kann ein Modell in den Benchmarks nach vorne bringen, bietet aber keinen echten Maßstab dafür, wie das Modell abschneidet, wenn es eine neue Aufgabe zu bewältigen hat.

Die Forscher vermuten, dass ein Teil des Problems darin besteht, dass diese Modelle nur auf Text in Oberflächenform trainiert werden.

Wenn LLMs mehr kontextualisierten Daten und semantischen Darstellungen aus der realen Welt ausgesetzt sind, könnten sie in der Lage sein, zu verallgemeinern, wenn sie mit verschiedenen Aufgaben konfrontiert werden.