Der Wettlauf um leistungsstärkere und effizientere KI-Hardware hat sich in dieser Woche beschleunigt: Intel und Google kündigten neue Chips an, die sie unabhängiger von der NVIDIA-Technologie machen sollen.

Es scheint, dass jede Woche neue KI-Modelle veröffentlicht werden. Hinter jeder Veröffentlichung stehen wochenlange Trainings in Cloud-Computing-Rechenzentren, von denen die meisten von NVIDIA-GPUs angetrieben werden.

Sowohl Intel als auch Google haben neue hauseigene KI-Chips angekündigt, die große KI-Modelle schneller trainieren und einsetzen können und dabei weniger Strom verbrauchen.

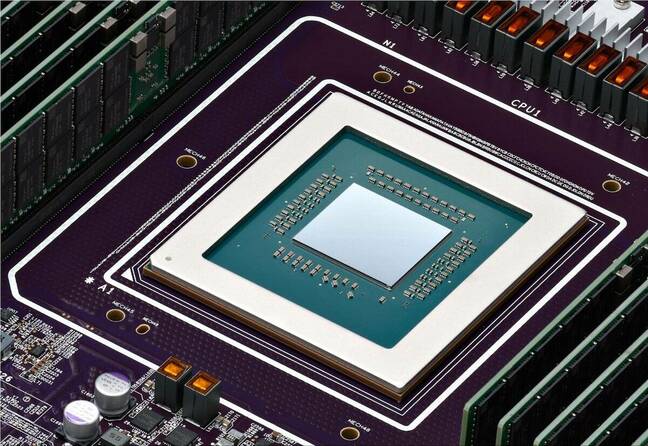

Intels KI-Beschleuniger-Chip Gaudi 3

Intel ist wahrscheinlich besser bekannt für die Chips, die Ihren PC antreiben, aber am Dienstag hat das Unternehmen angekündigt seinen neuen KI-Chip namens Gaudi 3.

NVIDIAs H100 GPUs haben den Großteil der KI-Rechenzentren gebildet, aber Intel sagt, dass Gaudi 3 "im Durchschnitt 50% bessere Inferenz und 40% bessere Energieeffizienz als Nvidia H100 liefert - zu einem Bruchteil der Kosten."

Ein wichtiger Faktor für die Energieeffizienz von Gaudi 3 ist, dass Intel für die Herstellung der Chips das 5nm-Verfahren von Taiwan Semiconductor Manufacturing Co verwendet.

Intel machte keine Preisangaben, aber auf die Frage, wie es im Vergleich zu NVIDIAs Produkten abschneidet, sagte Das Kamhout, VP of Xeon Software bei Intel: "Wir erwarten, dass es sehr wettbewerbsfähig sein wird."

Dell Technologies, Hewlett Packard Enterprise, Lenovo und Supermicro werden die ersten sein, die Gaudi 3 in ihren KI-Rechenzentren einsetzen.

Intel-CEO Pat Gelsinger fasste die KI-Ambitionen des Unternehmens mit den Worten zusammen: "Intel bringt KI überall in das Unternehmen, vom PC über das Rechenzentrum bis hin zum Edge."

Die #IntelGaudi 3 #AI Beschleuniger bietet eine äußerst wettbewerbsfähige Alternative zu NVIDIAs H100 mit höherer Leistung, besserer Skalierbarkeit und PyTorch-Integration. Erfahren Sie mehr über die wichtigsten Produktvorteile. https://t.co/sXdQKjYFw0 pic.twitter.com/iJSndBQkvT

- Intel AI (@IntelAI) 9. April 2024

Googles Arm und TPU-Upgrades

Am Dienstag kündigte Google seine erste benutzerdefinierte Arm-basierte CPUs den es für den Betrieb seiner Rechenzentren einsetzen will. Der neue Chip mit dem Namen Axion ist ein direkter Konkurrent zu den CPUs von Intel und AMD.

Google behauptet, Axion liefere "30% mehr Leistung als die schnellsten Arm-basierten Instanzen, die heute in der Cloud verfügbar sind, bis zu 50% mehr Leistung und bis zu 60% mehr Energieeffizienz als vergleichbare x86-basierte Instanzen der aktuellen Generation."

Google hat mehrere seiner Dienste wie YouTube und Google Earth auf seine Arm-basierten Server der aktuellen Generation verlagert, die bald mit den Axion-Chips aufgerüstet werden sollen.

Eine leistungsstarke Arm-basierte Option erleichtert es Kunden, ihre CPU-basierten KI-Trainings-, Inferencing- und andere Anwendungen auf die Cloud-Plattform von Google zu migrieren, ohne sie neu entwickeln zu müssen.

Für das Training von Modellen in großem Maßstab hat sich Google weitgehend auf seine TPU-Chips als Alternative zu NVIDIAs Hardware verlassen. Diese werden ebenfalls mit einem einzigen neuen TPU v5p aufgerüstet, der nun mehr als doppelt so viele Chips enthält wie der aktuelle TPU v4-Pod.

TPU v5p, unsere leistungsstärkste und skalierbarste TPU, ist jetzt allgemein verfügbar! #GoogleCloudNext pic.twitter.com/mmfWlzHeqs

- Google Cloud Tech (@GoogleCloudTech) 9. April 2024

Google will weder seine neuen Arm-Chips noch seine TPUs verkaufen. Das Unternehmen will eher seine Cloud-Computing-Dienste vorantreiben, als ein direkter Hardware-Konkurrent von NVIDIA zu werden.

Die aufgerüsteten TPUs werden Google einen Schub für die KI-Hypercomputer die das Training von KI-Modellen in großem Maßstab ermöglicht. Der KI-Hypercomputer verwendet auch NVIDIA H100-Grafikprozessoren, die laut Google bald durch NVIDIAs neue Blackwell-GPUs.

Die Nachfrage nach KI-Chips wird sich in absehbarer Zeit nicht verlangsamen, und es sieht nicht mehr so sehr nach einem Ein-Pferd-Rennen für NVIDIA aus wie früher.