Google-Forscher haben eine Technik namens Infini-Attention entwickelt, die es LLMs ermöglicht, unendlich lange Texte zu verarbeiten, ohne dass der Rechen- und Speicherbedarf steigt.

Die Transformer-Architektur eines LLM ermöglicht es ihm, alle Token in einer Eingabeaufforderung zu berücksichtigen. Die komplexen Punktprodukt- und Matrixmultiplikationen, die er durchführt, sind quadratisch in der Komplexität.

Das bedeutet, dass die Verdoppelung der Token in Ihrer Eingabeaufforderung zu einer Vervierfachung des Arbeitsspeichers und der Verarbeitungsleistung führt. Aus diesem Grund ist es so schwierig, LLMs mit große Kontextfenster ohne dass die Anforderungen an Speicher und Rechenleistung in die Höhe schießen.

In einem "normalen" LLM gehen die Informationen am Anfang des Prompt-Inhalts verloren, sobald der Prompt größer als das Kontextfenster wird. Googles Forschungsarbeit erklärt, wie Infini-attention Daten über das Kontextfenster hinaus aufbewahren kann.

Google präsentiert Leave No Context Behind: Effiziente unendliche Kontexttransformatoren mit Infini-attention

1B-Modell, das auf bis zu 5K Passkey-Instanzen mit Sequenzlänge abgestimmt wurde, löst das Problem mit 1M Längehttps://t.co/zyHMt3inhi pic.twitter.com/ySYEMET9Ef

- Aran Komatsuzaki (@arankomatsuzaki) 11. April 2024

Wie funktioniert Infini-attention?

Infini-Attention kombiniert komprimierende Gedächtnistechniken mit modifizierten Aufmerksamkeitsmechanismen, so dass relevante ältere Informationen nicht verloren gehen.

Sobald die Eingabeaufforderung die Kontextlänge des Modells überschreitet, speichert der komprimierte Speicher die Informationen in einem komprimierten Format, anstatt sie zu verwerfen.

Auf diese Weise können ältere, weniger unmittelbar relevante Informationen gespeichert werden, ohne dass die Speicher- und Rechenanforderungen ins Unendliche wachsen, wenn die Eingaben zunehmen.

Anstatt zu versuchen, alle älteren Eingabedaten zu speichern, wägt das komprimierende Gedächtnis von Infini-Attention Informationen ab und fasst sie zusammen, die als relevant und behaltenswert erachtet werden.

Infini-Attention basiert auf einem "normalen" Aufmerksamkeitsmechanismus, verwendet aber die Schlüsselwertzustände (KV) aus jedem nachfolgenden Segment des Modells wieder, anstatt sie zu verwerfen.

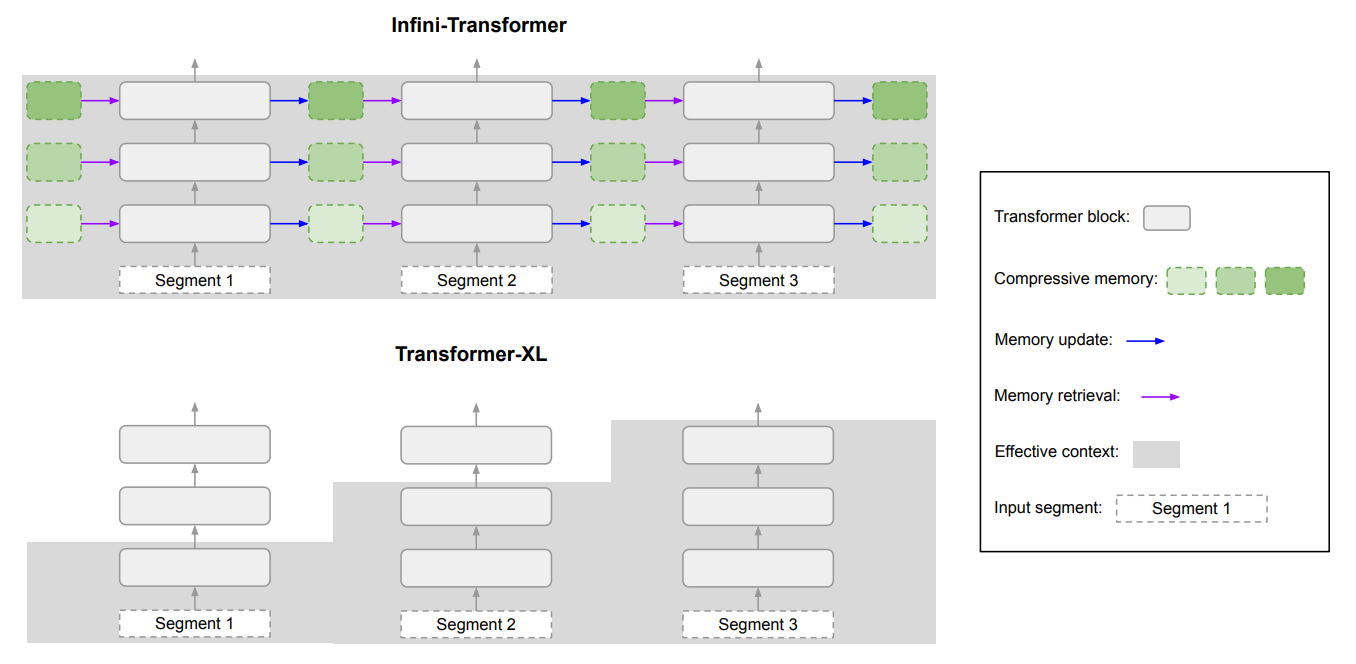

Das folgende Diagramm zeigt den Unterschied zwischen Infini-attention und einem anderen erweiterten Kontextmodell Transformer XL.

Das Ergebnis ist ein LLM, das den jüngsten Eingabedaten lokale Aufmerksamkeit schenkt, aber auch kontinuierlich destillierte, komprimierte historische Daten mit sich führt, auf die es langfristige Aufmerksamkeit anwenden kann.

In dem Papier heißt es: "Diese subtile, aber entscheidende Änderung der Aufmerksamkeitsschicht ermöglicht es LLMs, unendlich lange Kontexte mit begrenzten Speicher- und Rechenressourcen zu verarbeiten."

Wie gut ist es?

Google führte Benchmarking-Tests mit kleineren Infini-Aufmerksamkeitsmodellen mit 1B und 8B Parametern durch. Diese wurden mit anderen erweiterten Kontextmodellen wie Transformer-XL und Memorizing Transformers verglichen.

Der Infini-Transformer erreichte bei der Verarbeitung von Inhalten mit langem Kontext deutlich niedrigere Perplexitätswerte als die anderen Modelle. Ein niedrigerer Perplexitätswert bedeutet, dass das Modell mit größerer Sicherheit seine Ergebnisse vorhersagen kann.

In den Tests zum Abrufen von Schlüsseln fanden die Infini-Attention-Modelle durchweg die Zufallszahl, die in einem Text mit bis zu 1 Mio. Token versteckt war.

Andere Modelle schaffen es oft, den Hauptschlüssel gegen Ende der Eingabe abzurufen, haben aber Schwierigkeiten, ihn in der Mitte oder am Anfang eines langen Inhalts zu finden. Infini-attention hatte bei diesem Test keine Probleme.

Die Benchmarking-Tests sind sehr technisch, aber die Kurzfassung ist, dass Infini-attention die Basismodelle bei der Zusammenfassung und Handhabung langer Sequenzen übertrifft und dabei den Kontext über längere Zeiträume beibehält.

Bezeichnenderweise wurde diese überragende Speicherfähigkeit beibehalten, während gleichzeitig 114 Mal weniger Speicherplatz benötigt wurde.

Die Benchmark-Ergebnisse überzeugen die Forscher davon, dass Infini-attention so skaliert werden kann, dass extrem lange Eingabesequenzen verarbeitet werden können, ohne dass die Speicher- und Rechenressourcen eingeschränkt werden.

Die Plug-and-Play-Natur von Infini-attention bedeutet, dass es für das kontinuierliche Vortraining und die Feinabstimmung bestehender Transformer-Modelle verwendet werden kann. Dadurch könnten ihre Kontextfenster effektiv erweitert werden, ohne dass das Modell komplett neu trainiert werden muss.

Kontextfenster werden weiter wachsen, aber dieser Ansatz zeigt, dass ein effizienter Speicher eine bessere Lösung sein kann als eine große Bibliothek.