Forscher veröffentlichten eine Studie, in der sie die Genauigkeit und Qualität von Zusammenfassungen verglichen, die LLMs erstellen. Claude 3 Opus schnitt besonders gut ab, aber der Mensch hat immer noch die Nase vorn.

KI-Modelle sind äußerst nützlich, um lange Dokumente zusammenzufassen, wenn man keine Zeit oder Lust hat, sie zu lesen.

Der Luxus wachsender Kontextfenster bedeutet, dass wir die Modelle mit längeren Dokumenten konfrontieren können, was ihre Fähigkeit, die Fakten in der Zusammenfassung immer richtig zu erfassen, in Frage stellt.

Die Forscher von der University of Massachusetts Amherst, Adobe, dem Allen Institute for AI und der Princeton University, veröffentlichte eine Studie die herausfinden sollte, wie gut KI-Modelle bei der Zusammenfassung von Inhalten in Buchlänge (>100k Token) sind.

FABLES

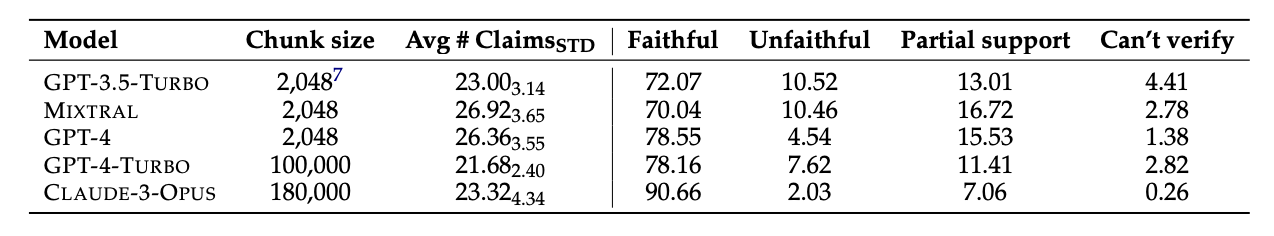

Sie wählten 26 Bücher aus, die in den Jahren 2023 und 2024 veröffentlicht wurden, und ließen verschiedene LLMs die Texte zusammenfassen. Die jüngsten Veröffentlichungsdaten wurden gewählt, um eine mögliche Datenkontamination in den ursprünglichen Trainingsdaten der Modelle zu vermeiden.

Nachdem die Modelle die Zusammenfassungen erstellt hatten, verwendeten sie GPT-4, um daraus dekontextualisierte Aussagen zu extrahieren. Die Forscher stellten dann menschliche Kommentatoren ein, die die Bücher gelesen hatten, und baten sie, die Behauptungen zu überprüfen.

Die daraus resultierenden Daten wurden in einem Datensatz namens "Faithfulness Annotations for Book-Length Summarization" (FABLES) zusammengefasst. FABLES enthält 3.158 Annotationen zur Treue in 26 Erzähltexten.

Die Testergebnisse zeigten, dass Claude 3 Opus "mit deutlichem Abstand die getreueste Zusammenfassung in Buchlänge" war, wobei über 90% der Angaben als getreu oder genau verifiziert wurden.

GPT-4 liegt mit Abstand an zweiter Stelle, denn nur 78% seiner Angaben wurden von den menschlichen Kommentatoren als wahrheitsgetreu bestätigt.

Der schwierige Teil

Die getesteten Modelle schienen alle mit denselben Dingen zu kämpfen. Die meisten Fakten, die die Modelle falsch wiedergaben, bezogen sich auf Ereignisse oder Zustände von Personen und Beziehungen.

Das Papier stellt fest, dass "die meisten dieser Behauptungen nur durch Multi-Hop-Argumentation über die Beweise entkräftet werden können, was die Komplexität der Aufgabe und ihren Unterschied zu bestehenden Faktenüberprüfungssituationen hervorhebt".

Die LLMs ließen in ihren Zusammenfassungen auch häufig kritische Informationen aus. Außerdem betonen sie den Inhalt gegen Ende des Buches übermäßig und vernachlässigen wichtige Inhalte am Anfang.

Wird KI menschliche Kommentatoren ersetzen?

Menschliche Kommentatoren oder Faktenchecker sind teuer. Die Forscher gaben $5.200 aus, um die Behauptungen in den KI-Zusammenfassungen durch menschliche Kommentatoren überprüfen zu lassen.

Hätte ein KI-Modell die Aufgabe für weniger Geld erledigen können? Einfach Faktenrecherche ist etwas, was Claude 3 gut kann, aber seine Leistung bei der Überprüfung von Aussagen, die ein tieferes Verständnis des Inhalts erfordern, ist weniger konsistent.

Wenn man ihnen die extrahierten Behauptungen vorlegte und sie aufforderte, diese zu überprüfen, blieben alle KI-Modelle hinter den menschlichen Kommentatoren zurück. Besonders schlecht schnitten sie bei der Erkennung unlauterer Angaben ab.

Obwohl Claude 3 Opus mit einigem Abstand der beste Antragsprüfer war, kamen die Forscher zu dem Schluss, dass er "letztendlich zu schlecht abschneidet, um ein zuverlässiger automatischer Prüfer zu sein".

Wenn es darum geht, die Nuancen, die komplexen menschlichen Beziehungen, die Handlungspunkte und die Motivationen der Figuren in einer langen Erzählung zu verstehen, scheinen die Menschen im Moment noch im Vorteil zu sein.