Forscher von Meta und der University of California San Diego (UCSD) haben ToolVerifier entwickelt, eine Methode, die den Aufruf und die Interaktion von LLMs mit Softwaretools verbessert.

Für LLMs, die als allgemeine Assistenten oder AgentenSie müssen lernen, wie man verschiedene Werkzeuge oder APIs benutzt. Die Feinabstimmung eines LLM für die Verwendung eines bestimmten Tools funktioniert, aber die wirkliche Herausforderung besteht darin, dass ein LLM mit neuen Tools interagieren kann, ohne dass eine Feinabstimmung oder eine Demonstration in wenigen Schritten erforderlich ist.

Wenn zwei Werkzeuge sehr ähnlich sind, kann es für den LLM eine besondere Herausforderung sein, das richtige Werkzeug zu wählen, um sein Ziel zu erreichen. Die derzeitige Methode, mehrere Beispiele mit wenigen Bildern für jedes Werkzeug zu liefern, kann einen großen Teil des Kontextfensters verbrauchen, das einem LLM zur Verfügung steht.

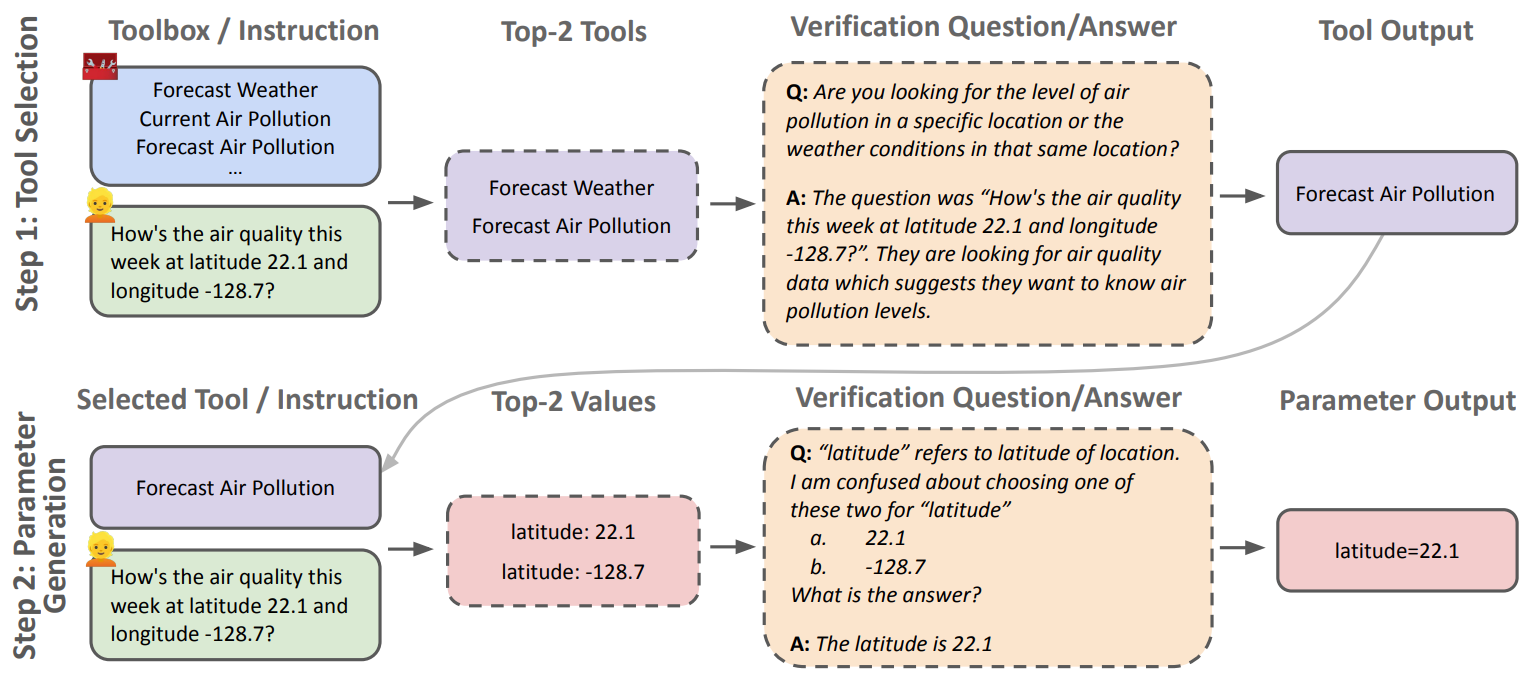

ToolVerifier ist eine Selbstüberprüfungsmethode, die es dem LLM ermöglicht, sich selbst Fragen zu stellen, um herauszufinden, welches Werkzeug zu verwenden ist und welche Parameter an das Werkzeug zu übergeben sind.

Um den LLM zu unterstützen, wählt ToolVerifier zunächst das am besten geeignete Tool aus einer Bibliothek von Optionen aus und generiert dann die entsprechenden Parameter. Bei jedem dieser Schritte werden Fragen generiert, die bei der Bewertung der Auswahl helfen und die Unterscheidung zwischen ähnlichen Kandidaten erleichtern.

Hier ist ein Beispiel aus dem Forschungspapier, das den Prozess der Werkzeugauswahl und der Klärung der Parameter zeigt.

ToolVerifier wurde anhand von Daten trainiert, die aus einer Liste synthetischer Tools bestehen, darunter Reise-, Bank- und Kalendertools und die dazugehörigen Beschreibungen. Es wurde so trainiert, dass es allein aufgrund des Titels und der Beschreibung das passende Tool auswählt.

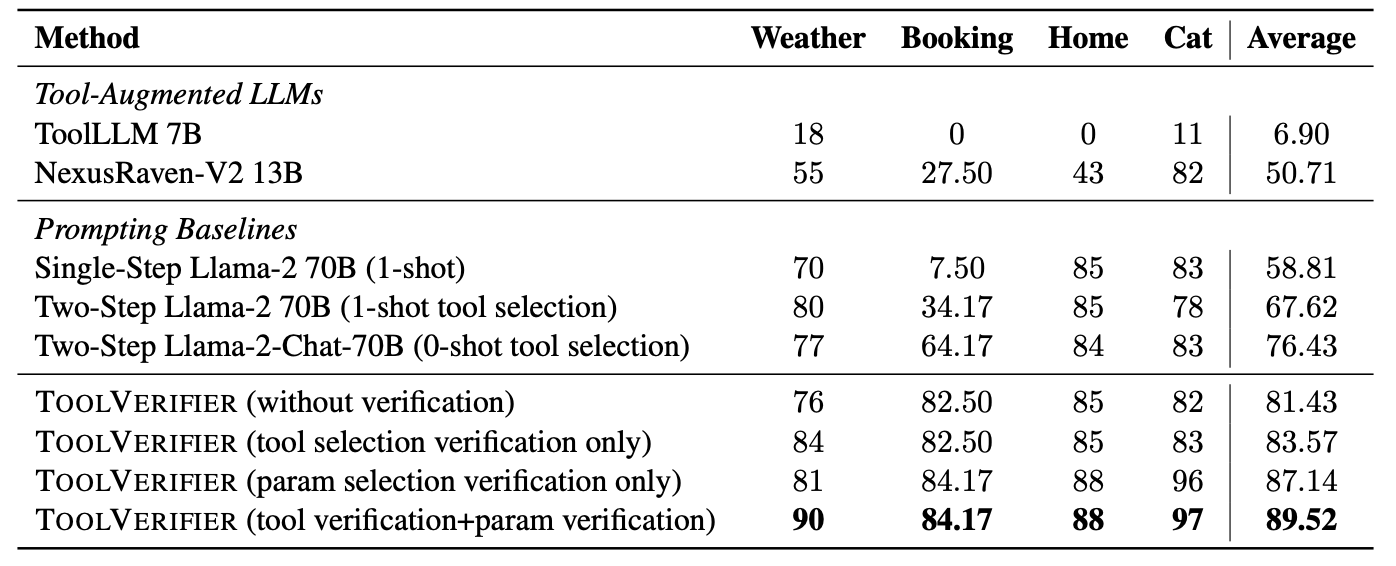

Nach dem Training zur Werkzeugauswahl und Parameterüberprüfung testeten die Forscher ToolVerifier mit 4 Aufgaben aus dem ToolBench-Benchmark, bei denen Llama 2-70B mit 17 bisher unbekannten Werkzeugen interagieren musste.

Die Ergebnisse veröffentlicht in der Zeitung sagen, dass die Verwendung der ToolVerifier-Methode zu "einer durchschnittlichen Verbesserung von 22% gegenüber den "few-shot baselines" führte, selbst in Szenarien, in denen die Unterscheidungen zwischen den Kandidaten fein nuanciert sind".

Die Ergebnisse zeigen, dass ToolVerifier die Werkzeugauswahl und die genaue Parametergenerierung eines LLMs erheblich verbessert. Die Methode wurde zwar nur für Einzelwerkzeug- und nicht für Multiwerkzeug-Interaktionen trainiert und getestet, aber sie ist dennoch vielversprechend.

Mit Werkzeugen ausgestattete LLMs sind eine aufregende Entwicklung bei der Verwendung von KI als verallgemeinerter Agent. Sobald LLMs lernen, mehrere Werkzeuge zu nutzen, um ein Ziel zu erreichen, werden sie für uns noch nützlicher sein, als sie es bereits sind.

Die Zukunft, in der ein KI-Assistent einen Flug bucht, ein Meeting koordiniert oder Ihren Lebensmitteleinkauf für Sie erledigt, scheint nicht mehr weit entfernt zu sein.