Für das Training von KI-Modellen wie GPT-4 wurden bisher meist Datensätze verwendet, die aus Text und Bildern bestanden. Metas multimodaler Wahrnehmungsdatensatz Ego-Exo4D bietet Datenwissenschaftlern ein reichhaltiges neues Set an Trainingsdaten.

Man kann eine neue Fähigkeit erlernen, indem man ein Buch liest, aber es ist so viel einfacher, wenn jemand einem zeigt, wie man etwas tut, während er es einem erklärt. Das ist das Ziel, das das FAIR-Team (Fundamental Artificial Intelligence Research) von Meta mit Ego-Exo4D verfolgt.

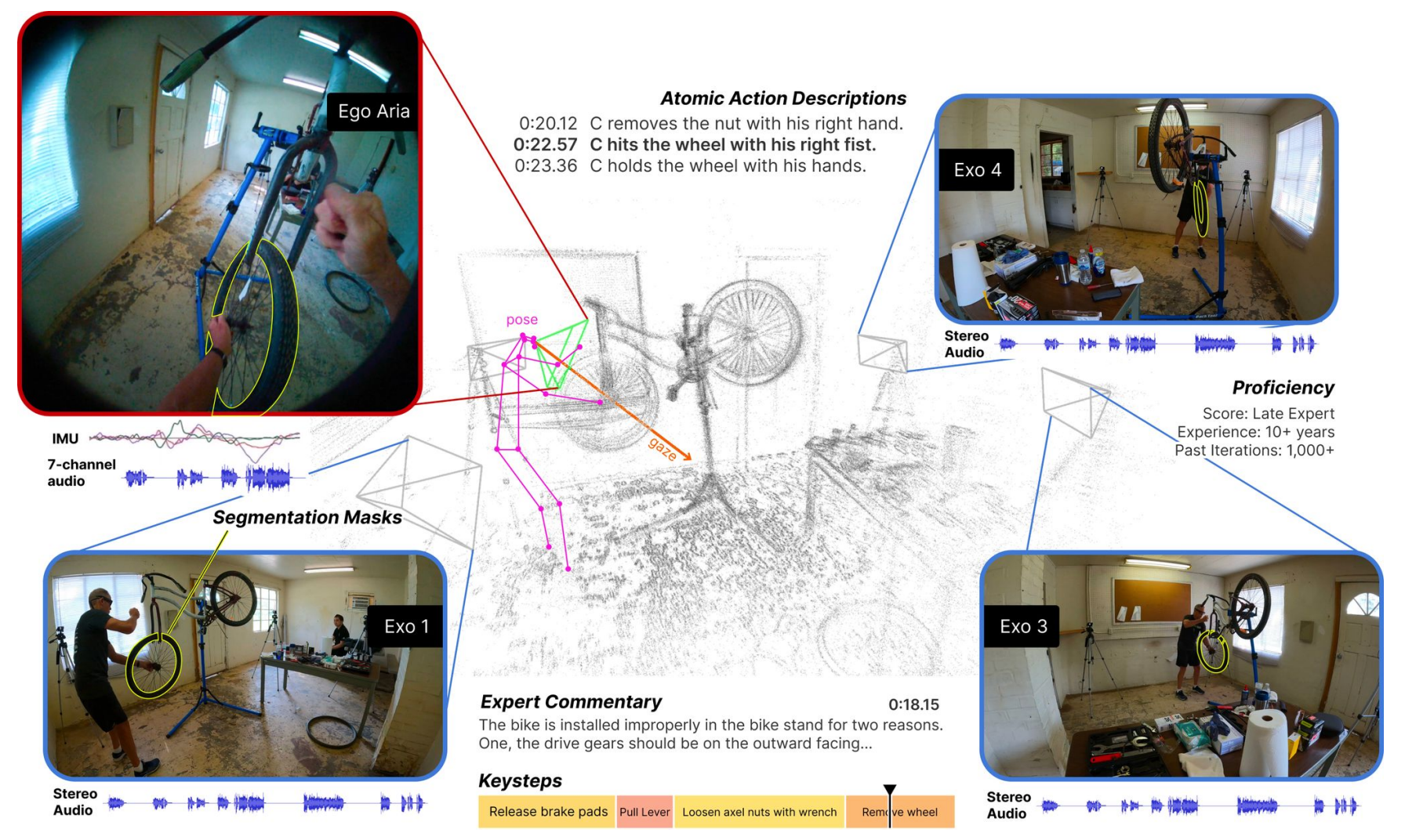

Der Datensatz besteht aus Videos aus der Ich-Perspektive (Ego) und der Dritten-Perspektive (Exo), in denen Menschen bei der Ausübung verschiedener qualifizierter menschlicher Tätigkeiten zu sehen sind. Das kann alles sein, vom Kochen über Tanzen und Musizieren bis hin zum Reparieren eines Fahrrads. Die Daten wurden in 13 Städten weltweit von 839 Kameraträgern gesammelt, die 1422 Stunden Video aufzeichneten.

Die gleichzeitig aufgenommenen Videos werden dann mit Hilfe der Project Aria-Brille von Meta mit zusätzlichen Daten angereichert.

Die Project Aria-Brille ist ein tragbarer Computer in Brillenform. Sie erfassen die Video- und Audiodaten des Trägers sowie seine Augenbewegungen und Standortinformationen. Die Brille erfasst auch Kopfhaltungen und 3D-Punktwolken der Umgebung.

Das Ergebnis ist ein Datensatz mit gleichzeitigen Videos von der Ausführung einer Aufgabe, mit Ich-Erzählungen der Kameraträger, die ihre Handlungen beschreiben, und mit Kopf- und Augenverfolgung der Person, die die Aufgabe ausführt.

Wir stellen vor: Ego-Exo4D - ein grundlegender Datensatz und eine Benchmark-Suite, die sich auf qualifizierte menschliche Aktivitäten konzentriert, um die Forschung im Bereich Video-Lernen und multimodale Wahrnehmung zu unterstützen. Es ist der größte jemals öffentlich zugängliche Datensatz seiner Art.

Weitere Informationen ➡️ https://t.co/82OR4msehv pic.twitter.com/NTI1kdj1RN

- AI bei Meta (@AIatMeta) 4. Dezember 2023

Meta fügte dann Play-by-Play-Beschreibungen aus der dritten Person zu den Aktionen jedes Kameraträgers hinzu. Meta beauftragte auch Experten aus verschiedenen Bereichen, die in der dritten Person gesprochene Expertenkommentare hinzufügten, in denen die Art und Weise, wie die Person im Video die Aufgabe ausführte, kritisiert wurde.

Da der Ego-Exo4D-Datensatz sowohl egozentrische als auch exozentrische Ansichten erfasst, kann er Forschern zeigen, wie Aktivitäten aus verschiedenen Perspektiven aussehen. Dies könnte ihnen helfen, Computer-Vision-Algorithmen zu entwickeln, die erkennen können, was eine Person aus jeder Perspektive tut.

Ego-Exo4D eröffnet neue Lernmöglichkeiten

Eines der Haupthindernisse auf dem Weg zu einer intelligenten Intelligenz oder einer effizienteren Ausbildung von Robotern ist die fehlende Sinneswahrnehmung von Computern. Wir Menschen haben so viele Sinneseindrücke aus unserer Umgebung, die wir oft als selbstverständlich ansehen, wenn wir neue Fähigkeiten erlernen.

Ego-Exo4D wird eine äußerst nützliche Ressource sein, um diese Lücke zu schließen.

Dr. Gedas Bertasius, Assistenzprofessor im Fachbereich Informatik an der University of North Carolina, sagte: "Bei Ego-Exo4D geht es nicht nur um das Sammeln von Daten, sondern darum, die Art und Weise zu verändern, wie KI versteht, wahrnimmt und lernt. Mit menschlichem Lernen und menschlicher Perspektive kann KI in unserem täglichen Leben hilfreicher werden und uns auf eine Weise unterstützen, die wir uns nur vorstellen können."

Meta hofft, dass Ego-Exo4D "die Roboter der Zukunft befähigen wird, Einblicke in komplexe, geschickte Manipulationen zu gewinnen, indem sie erfahrene menschliche Experten in Aktion beobachten".

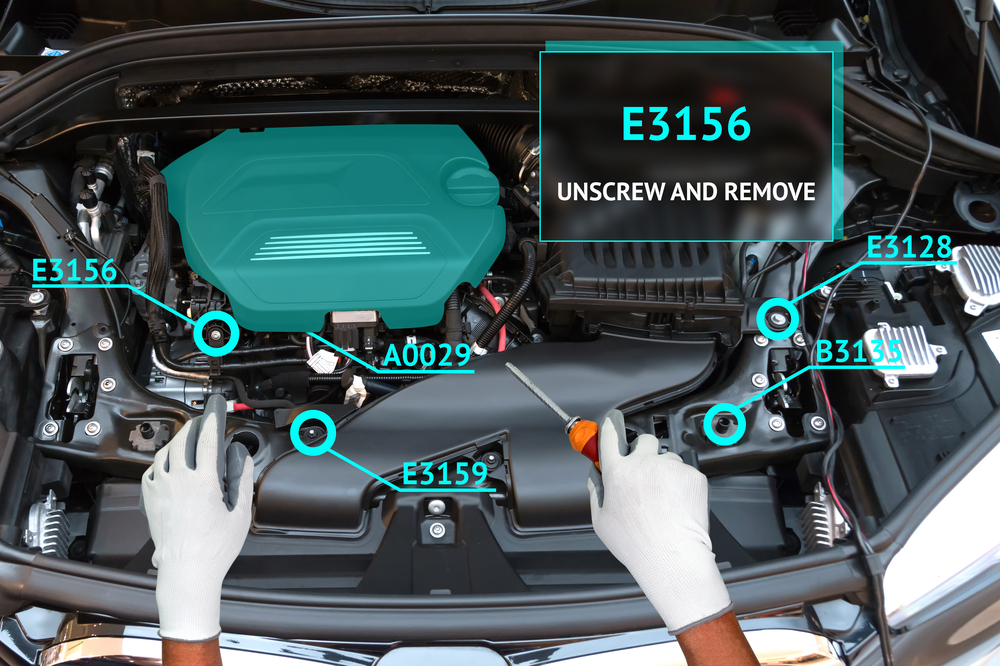

Dieser Datensatz wird in Verbindung mit der Project Aria-Brille bald auch eine wirklich immersive Lernerfahrung für Menschen ermöglichen. Stellen Sie sich vor, Sie führen eine Aufgabe aus, während Ihre Brille mithilfe von Augmented Reality (AR) ein Lernvideo einblendet oder Sie durch Ihre Aufgabe führt.

Sie könnten Klavierspielen lernen und eine visuelle Einblendung erhalten, die Ihnen zeigt, wo Sie Ihre Hände hinbewegen sollten, mit Audioempfehlungen in Echtzeit, während Sie es tun. Oder Sie öffnen die Motorhaube Ihres Autos und werden bei der Fehlersuche und Reparatur eines Motorproblems unterstützt.

Es wird interessant sein zu sehen, ob Meta's Ego How-To Lernkonzept wird die Akzeptanz der Project Aria-Brille besser sein als die des gescheiterten Google Glass-Produkts. Es ist noch nicht bekannt, wann die Brille zu kaufen sein wird.

Meta wird den Ego-Exo4D-Datensatz erstellen zum Herunterladen verfügbar vor Ende Dezember.