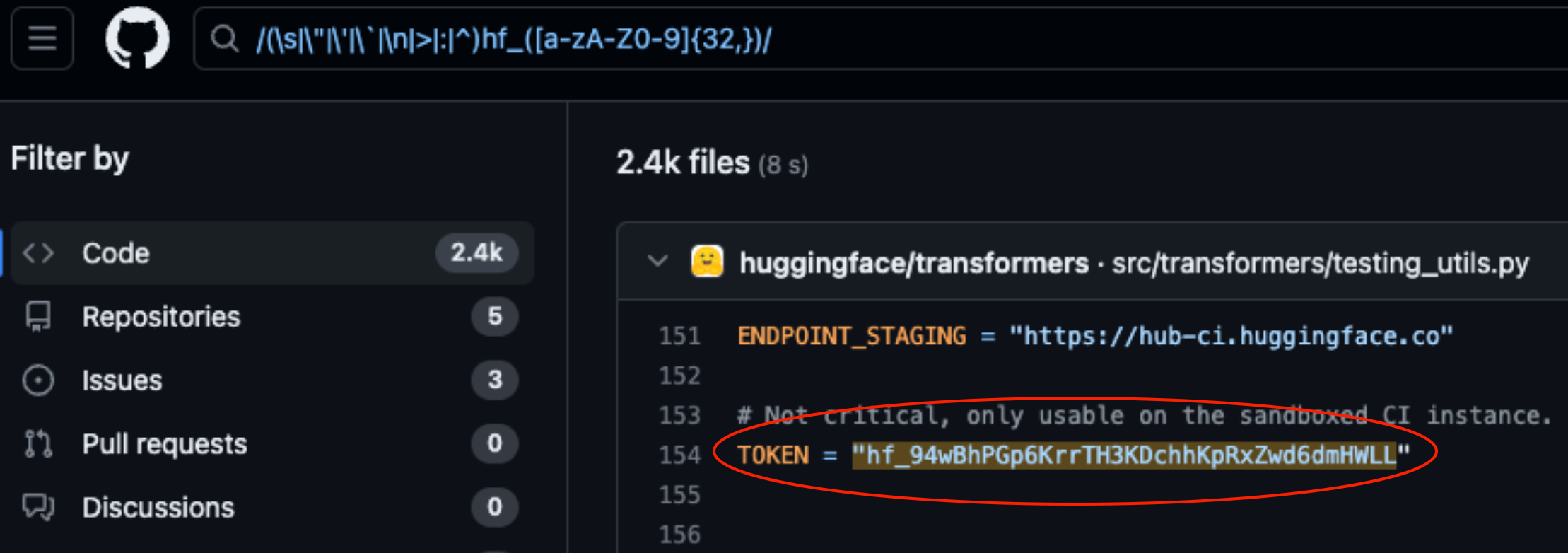

Lasso Security hat Sicherheitslücken auf HuggingFace und GitHub aufgedeckt, nachdem 1681 exponierte API-Tokens gefunden wurden, die in den auf den Plattformen gespeicherten Code einkodiert waren.

HuggingFace und GitHub sind zwei der beliebtesten Repositories, auf denen Entwickler Zugang zu ihren KI-Modellen und ihrem Code erhalten. Stellen Sie sich diese als Ordner in der Cloud vor, die von den Unternehmen verwaltet werden, die sie besitzen.

HuggingFace und GitHub machen es Nutzern leicht, über APIs mit Hunderttausenden von KI-Modellen und -Datensätzen zu interagieren. Außerdem können Organisationen, die Eigentümer der Modelle und Datensätze sind, den API-Zugang zum Lesen, Erstellen, Ändern und Löschen von Repositories oder Dateien nutzen.

Die mit Ihrem API-Token verbundenen Berechtigungen bestimmen die Zugriffsebene, die Sie haben. Lasso gefunden dass sie mit etwas Nachforschung eine Menge Token in Code finden konnten, der in Repositories auf den Plattformen gespeichert ist.

Von den 1681 gefundenen gültigen Token hatten 655 Benutzertoken Schreibrechte, 77 davon mit vollen Kontoberechtigungen.

Warum ist das eine große Sache?

Stellen Sie sich ein API-Token wie einen Schlüssel zu Ihrer Haustür vor. Es mag bequem sein, den Schlüssel unter der Fußmatte liegen zu lassen, aber wenn ihn jemand findet, hat er Zugang zu Ihrem Haus.

Wenn Entwickler einen Code schreiben, der mit ihrem KI-Modell oder Datensatz interagieren muss, werden sie manchmal ein wenig faul. Sie können die Token fest in ihren Code codieren, anstatt sie auf sicherere Weise zu verwalten.

Einige der von Lasso gefundenen Token gaben ihnen volle Lese- und Schreibrechte auf Metas Lama 2, BigScience Workshop, und EleutherAI. Diese Organisationen verfügen alle über KI-Modelle, die bereits millionenfach heruntergeladen wurden.

Wenn Lasso die Bösewichte wären, könnten sie die Modelle oder Datensätze in den offengelegten Repositories verändert haben. Stellen Sie sich vor, jemand hätte heimtückischen Code in das Repository von Meta eingefügt und dann Millionen von Menschen zum Herunterladen gebracht.

Als Meta, Google, Microsoft und andere von den offengelegten API-Tokens erfuhren, widerriefen sie diese schnell.

Modelldiebstahl, Vergiftung von Trainingsdaten und die Kombination von Drittanbieter-Datensätzen und vortrainierten Modellen sind große Risiken für KI-Unternehmen. Wenn Entwickler API-Token in ihrem Code offenlegen, wird es für böswillige Akteure nur noch einfacher, diese auszunutzen.

Man muss sich fragen, ob die Lasso-Ingenieure die ersten waren, die diese Schwachstellen entdeckt haben.

Wenn Cyber-Kriminelle Wenn sie diese Zeichen gefunden hätten, wären sie sicherlich sehr leise gewesen, als sie die Eingangstür öffneten.