Nvidia hat seinen KI-Supercomputer Eos skaliert und optimiert, um neue MLPerf-Benchmark-Rekorde beim KI-Training aufzustellen.

Als Nvidia im Mai seinen KI-Supercomputer Eos einschaltete, wurden 10.752 NVIDIA H100 Tensor Core GPUs zum Leben erweckt, die gerade einige Praxistests durchlaufen haben.

Diese beispiellose Verarbeitungsleistung zusammen mit neuen Software-Optimierungen hat es Eos ermöglicht, den MLPerf Benchmark auf Rekordniveau.

Der quelloffene MLPerf-Benchmark ist eine Reihe von Trainings- und Inferenztests, mit denen die Leistung von maschinellen Lernprozessen auf realen Datensätzen gemessen werden kann.

Eines der herausragenden Ergebnisse war, dass Eos ein GPT-3-Modell mit 175 Milliarden Parametern auf einer Milliarde Token in nur 3,9 Minuten trainieren konnte.

Als Nvidia vor weniger als 6 Monaten den Rekord bei diesem Benchmark aufstellte, dauerte es mit 10,9 Minuten fast dreimal so lange.

Nvidia konnte bei den Tests außerdem eine Effizienzrate von 93% erreichen, was bedeutet, dass fast die gesamte theoretisch in Eos verfügbare Rechenleistung genutzt wurde.

Microsoft Azure, das in seiner virtuellen Maschine ND H100 v5 ein ähnliches H100-Setup wie Eos verwendet, kam in seinen MLPerf-Tests bis auf 2% an die Testergebnisse von Nvidia heran.

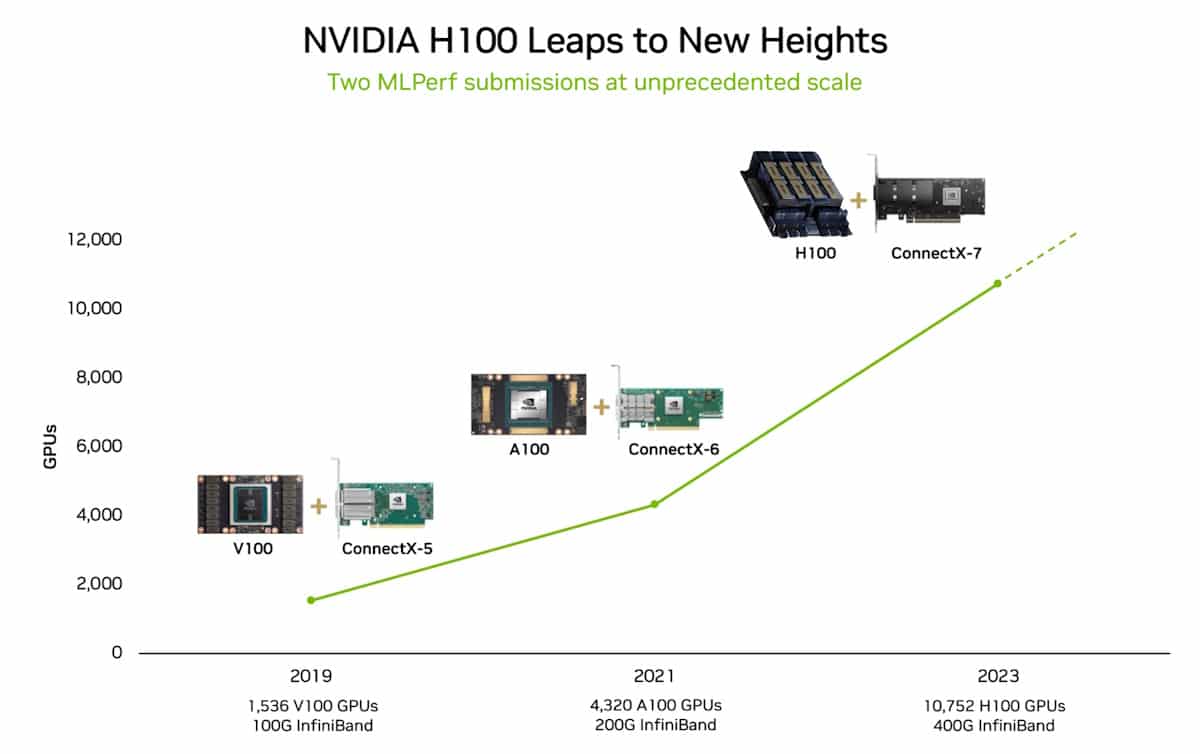

Im Jahr 2018 sagte Jensen Huang, der CEO von Nvidia, dass sich die Leistung von Grafikprozessoren alle zwei Jahre mehr als verdoppeln wird. Diese Behauptung wurde als Haung's Law bezeichnet und hat sich bewahrheitet, denn sie lässt Moore's Law verschwindet in den Rückspiegeln der Computer.

Na und?

Der MLPerf-Benchmark-Trainingstest, den Nvidia erfolgreich absolviert hat, verwendet nur einen Teil des vollständigen Datensatzes, auf dem GPT-3 trainiert wurde. Nimmt man die Zeit, die Eos im MLPerf-Test angesetzt hat, und extrapoliert sie für den gesamten GPT-3-Datensatz, dann könnte das gesamte Modell in nur 8 Tagen trainiert werden.

Würde man dies mit dem bisherigen, hochmodernen System aus 512 A100-GPUs versuchen, würde es rund 170 Tage dauern.

Wenn Sie ein neues KI-Modell trainieren, können Sie sich den Unterschied in der Markteinführungszeit und den Kosten vorstellen, den 8 Tage gegenüber 170 Tagen ausmachen?

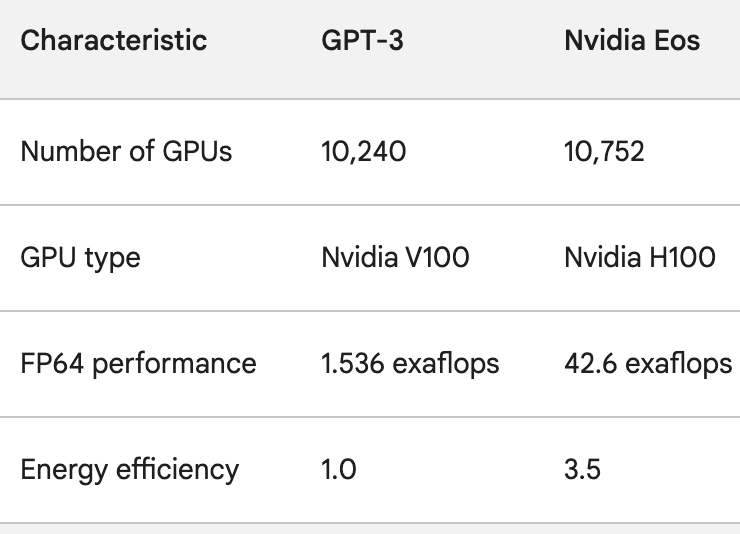

Die H100-GPUs sind nicht nur viel leistungsfähiger als die A100-GPUs, sondern auch bis zu 3,5 Mal energieeffizienter. Energienutzung und Der Kohlenstoff-Fußabdruck von AI sind echte Probleme, die angegangen werden müssen.

Um eine Vorstellung davon zu bekommen, wie schnell sich die KI-Verarbeitung verbessert, denken Sie an ChatGPT, das vor knapp einem Jahr in Betrieb ging. Das zugrunde liegende Modell, GPT-3, wurde auf 10.240 Nvidia V100 GPUs trainiert.

Weniger als ein Jahr später verfügt der Eos über die 28-fache Rechenleistung bei einer 3,5-fachen Verbesserung der Effizienz.

Als Sam Altman von OpenAI den letzten DevDay beendete, sagte er, dass die Projekte, an denen OpenAI arbeitet, die letzten Versionen alt aussehen lassen würden.

In Anbetracht der sprunghaften Zunahme der Rechenleistung, die Unternehmen wie Nvidia erzielen, dürfte Altmans Aussage die Zukunft der KI-Branche insgesamt widerspiegeln.