Multimodale Large Language Models (MLLM) wie GPT-4V sind wirklich gut bei der Analyse und Beschreibung von Bildern, aber manchmal halluzinieren sie und machen Dinge falsch. Ein neuer Ansatz namens Woodpecker könnte das ändern.

Wenn man ein MLLM bittet, ein Foto zu beschreiben, kann es normalerweise die Objekte herausgreifen und die Szene genau beschreiben. Aber wie bei der Beantwortung von Textaufforderungen trifft das Modell manchmal Annahmen auf der Grundlage von Objekten oder Konzepten, die häufig zusammen auftreten.

So könnte ein MLLM ein Foto einer Schaufensterszene beschreiben und sagen, dass Menschen in der Szene zu sehen sind, obwohl es in Wirklichkeit keine gibt.

Die Behebung von Halluzinationen in textbasierten LLMs ist ein fortlaufender Prozess, der jedoch wesentlich einfacher wird, wenn das Modell mit dem Internet verbunden ist. Das LLM kann eine Textantwort auf eine Eingabeaufforderung generieren, sie auf der Grundlage relevanter Internetdaten auf ihre Richtigkeit überprüfen und gegebenenfalls selbst korrigieren.

Wissenschaftler des YouTu Lab von Tencent und der University of Science and Technology of China haben diesen Ansatz aufgegriffen und in eine visuelle Lösung namens Woodpecker umgesetzt.

Vereinfacht ausgedrückt, baut Woodpecker einen Wissensbestand aus dem Bild auf, den ein LLM dann als Referenz verwenden kann, um die vom MLLM generierte Ausgangsbeschreibung zu korrigieren.

Hier ist eine kurze Beschreibung, wie es funktioniert:

- Ein LLM wie GPT-3.5 Turbo analysiert die vom MLLM erzeugte Beschreibung und extrahiert Schlüsselkonzepte wie Objekte, Mengen und Attribute. Zum Beispiel werden in dem Satz "Der Mann trägt einen schwarzen Hut" die Objekte "Mann" und "Hut" extrahiert.

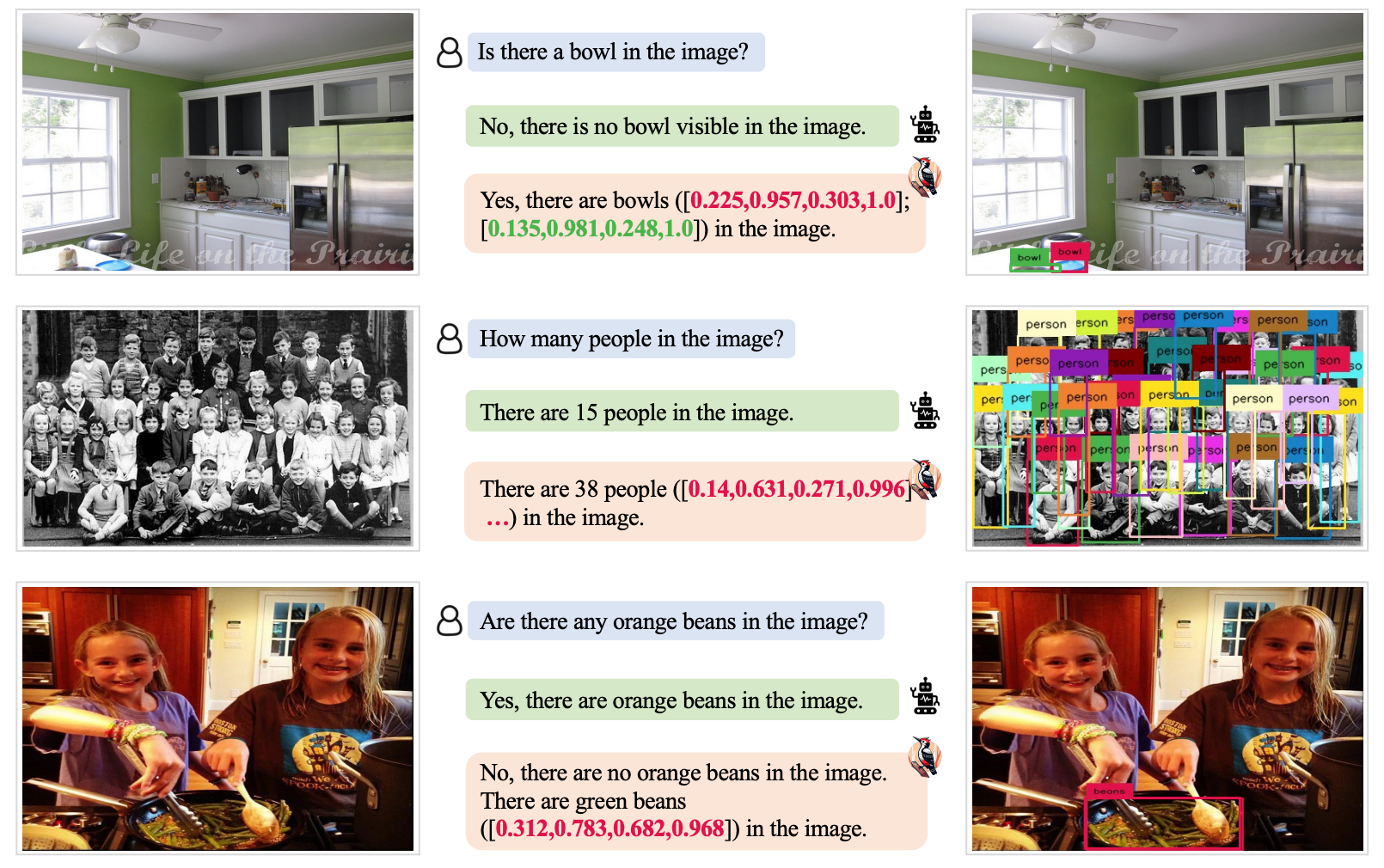

- Ein LLM wird dann aufgefordert, Fragen zu diesen Konzepten zu stellen, wie "Ist ein Mann auf dem Bild?" oder "Was trägt der Mann?".

- Diese Fragen werden als Eingabeaufforderungen an ein Visual Question Answering (VQA) Modell weitergeleitet. Grounding DINO führt die Objekterkennung und -zählung durch, während BLIP-2-FlanT5 VQA nach der Analyse des Bildes attributbezogene Fragen beantwortet.

- Ein LLM kombiniert die Antworten auf die Fragen zu einer visuellen Wissensbasis für das Bild.

- Ein LLM nutzt dieses Referenzwissen, um etwaige Halluzinationen in der ursprünglichen Beschreibung des MLLM zu korrigieren und übersehene Details zu ergänzen.

Die Forscher nannten ihren Ansatz "Woodpecker" (Specht) in Anlehnung an die Art und Weise, wie der Vogel Käfer aus den Bäumen pickt.

Die Testergebnisse zeigten, dass Woodpecker eine Genauigkeitsverbesserung von 30,66% für MiniGPT4 und 24,33% für die mPLUG-Owl-Modelle erzielte.

Der generische Charakter der für diesen Ansatz erforderlichen Modelle bedeutet, dass der Woodpecker-Ansatz leicht in verschiedene MLLMs integriert werden kann.

Wenn OpenAI Woodpecker in ChatGPT integriert, könnten wir eine deutliche Verbesserung der bereits beeindruckenden visuellen Leistung sehen. Eine Verringerung der MLLM-Halluzinationen könnte auch die automatische Entscheidungsfindung von Systemen verbessern, die visuelle Beschreibungen als Eingaben verwenden.