Forscher der Universität Chicago haben ein neues Tool entwickelt, mit dem KI-Modelle "vergiftet" werden können, wenn KI-Unternehmen Bilder ohne Zustimmung in ihre Datensätze aufnehmen.

Unternehmen wie OpenAI und Meta wurden kritisiert und verklagt, weil sie zum Trainieren ihrer Modelle Online-Inhalte in großem Stil auswerten. Damit Text-zu-Bild-Generatoren wie DALL-E oder Midjourney effektiv arbeiten können, müssen sie auf großen Mengen visueller Daten trainiert werden.

Eine Reihe von Künstler haben sich darüber beschwert, dass diese Bildgeneratoren nun in der Lage sind, Bilder in ihrem Stil zu erstellen, nachdem sie ihre Kunstwerke ohne Zustimmung kopiert haben.

Die Forscher schufen Nightshade, ein Tool, das unsichtbare Pixel in ein Bild einbettet, die das Bild anschließend für KI-Modelle "giftig" machen.

Generative KI beruht auf richtig beschrifteten Daten. Wenn ein KI-Modell mit Tausenden von Katzenbildern trainiert wurde und die Bilder alle mit "Katze" beschriftet sind, weiß es, wie eine Katze aussehen sollte, wenn man es bittet, ein Bild von ihr zu erzeugen.

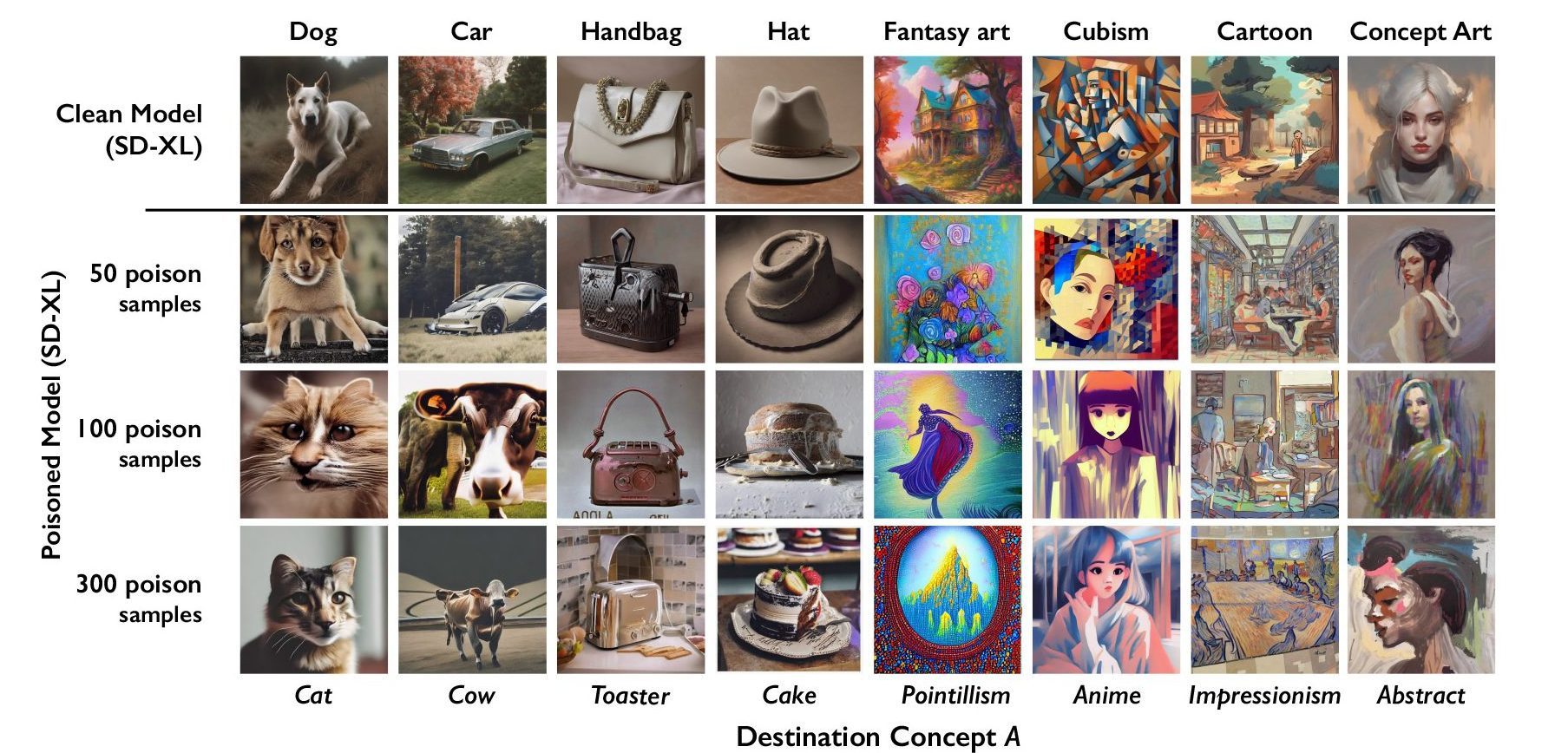

Nightshade bettet Daten in das Bild ein, die die Klassifizierung des Bildes verfälschen. So würde das Bild eines von Nightshade vergifteten Schlosses beispielsweise als alter Lastwagen klassifiziert werden. Die Forscher fanden heraus, dass bereits 100 Bilder, die auf eine einzige Eingabeaufforderung abzielen, ein Modell verfälschen können.

Nightshade ist eine schlechte Nachricht für KI-Bildgeneratoren

Ein Modell, das von vergifteten Daten betroffen ist, könnte denken, dass Bilder von Kuchen Hüte oder Toaster Handtaschen sind. Neben der Verfälschung des spezifischen Wortes, auf das Nightshade abzielt, infiziert die Verfälschung auch umfassendere Konzepte. So würde die Beschädigung der Bezeichnung "Hund" auch auf Begriffe wie "Welpe" übergreifen.

Wenn genügend Künstler Nightshade verwenden, könnten die Unternehmen sehr viel vorsichtiger sein, wenn es darum geht, die Zustimmung einzuholen, bevor sie sich Bilder aneignen.

Das Forschungsteam wird Nightshade in das ebenfalls von ihm entwickelte Glaze-Tool einbeziehen. Glaze kennzeichnet den Stil eines Bildes falsch. Ein Künstler, der den Stil seines Werks schützen möchte, kann es beispielsweise mit Glaze als "impressionistisch" bezeichnen, obwohl es sich eigentlich um "Pop Art" handelt.

Die Tatsache, dass Tools wie Nightshade so effektiv funktionieren, unterstreicht eine Schwachstelle in Text-zu-Bild-Generatoren, die von böswilligen Akteuren ausgenutzt werden könnten.

Unternehmen wie OpenAI und Stability AI erklären, dass sie die Opt-outs für "Nicht scrapen die Websites zu ihren robots.txt-Dateien hinzufügen können. Wenn die von Nightshade vergifteten Bilder nicht ausgelesen werden, bleiben die Modelle unberührt.

Böswillige Akteure könnten jedoch eine große Menge von Bildern vergiften und sie zum Scraping bereitstellen, um KI-Modelle zu schädigen. Die einzige Möglichkeit, dies zu umgehen, sind bessere Kennzeichnungsdetektoren oder menschliche Überprüfung.

Nightshade wird Künstlern ein wenig mehr Sicherheit geben, wenn es darum geht, ihre Inhalte online zu stellen, könnte aber ernsthafte Probleme für KI-Bildgeneratoren verursachen.