Tesla wird am Montag den Schalter seines neuen Supercomputers $300M umlegen und damit sein Programm für vollständiges autonomes Fahren (FSD) vorantreiben.

Der Ansatz, den Tesla mit seiner selbstfahrenden Technologie verfolgt, wird eine Menge Rechenleistung erfordern.

Elon Musk hat vor ein paar Tagen eine Live-Demo von Teslas FSD V12 vorgeführt, und obwohl es wirklich gut funktionierte, gab es ein paar Pannen. Das System befindet sich noch in der Beta-Phase und ist ein ehrgeiziger Ansatz für selbstfahrende Fahrzeuge, da es sich ausschließlich auf Kameras ohne Unterstützung durch Radar- oder Lidarsensoren stützt.

In einem Tweet sagte Musk: "Was ebenfalls verblüffend ist, ist die Tatsache, dass die für 8 Kameras, die mit 36 FPS laufen, benötigte Rechenleistung auf dem von Tesla entworfenen KI-Computer nur etwa 100 W beträgt. Diese winzige Menge an Energie reicht aus, um übermenschliches Fahren zu erreichen!

Das mag für die im Fahrzeug benötigte Rechenleistung zutreffen, ist aber nur möglich, wenn die KI richtig trainiert wurde.

Musk erläuterte die Notwendigkeit der Investitionen von Tesla in die Datenverarbeitung mit den Worten: "Um übermenschliches Fahren mit KI zu erreichen, sind Milliarden von Dollar pro Jahr für Trainingscomputer und Datenspeicherung sowie eine große Anzahl von gefahrenen Kilometern erforderlich."

Und hier kommt der neue Supercomputer von Tesla ins Spiel. Der Computer besteht aus 10.000 Nvidia H100 Compute GPUs. Das macht ihn zu einem der leistungsstärksten Supercomputer der Welt.

Tesla hat derzeit 4 Millionen Autos auf der Straße, die den Trainingsdatensatz erweitern können, und erwartet in einigen Jahren 10 Millionen. Das sind eine Menge Videos, die man sich ansehen muss.

Tim Zaman, einer der KI-Engineering-Manager bei Tesla, sagte: "Dank des Videotrainings in der realen Welt verfügen wir möglicherweise über die größten Trainingsdatensätze der Welt und eine Hot-Tier-Cache-Kapazität von über 200 PB - um Größenordnungen mehr als LLMs."

Der neue Tesla-Rechner wird 340 FP64 PFLOPS für technische Berechnungen und 39,58 INT8 ExaFLOPS für KI-Anwendungen liefern.

Auch wenn Ihnen diese Zahlen nicht viel sagen, so sind sie doch besser als der Leonardo, der auf der Liste der besten Supercomputer der Welt an vierter Stelle steht.

Nvidia kann nicht mithalten

Die H100-GPUs von Nvidia führen das KI-Training bis zu neunmal schneller durch als die A100-Prozessoren, die Tesla bisher verwendet hat. Und das ist immer noch nicht ausreichend für Teslas Bedürfnisse.

Warum kaufen sie dann nicht einfach mehr GPUs? Weil Nvidia nicht die Kapazität hat, sie schnell genug zu liefern.

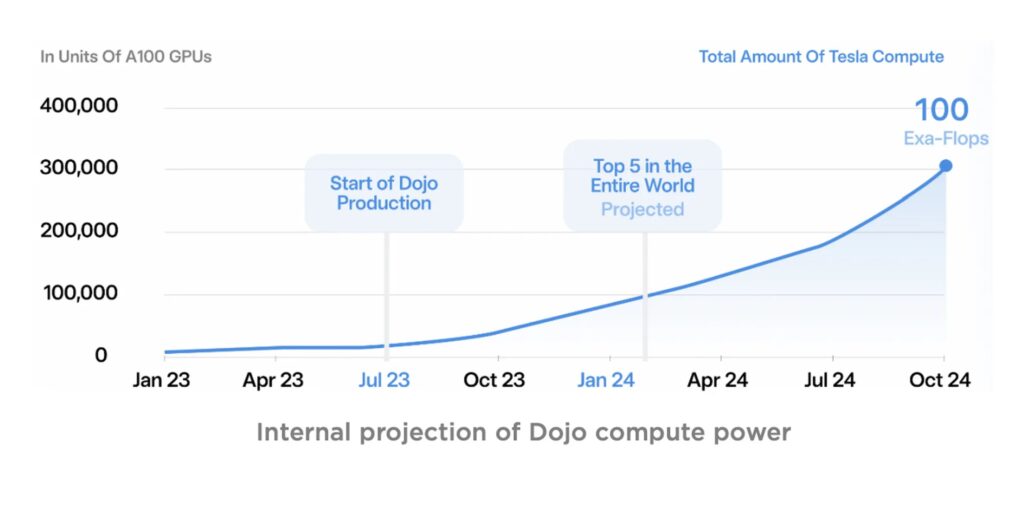

Aber Tesla wartet nicht darauf, dass Nvidia seine Produktion erhöht. In den letzten Jahren hat das Unternehmen seinen eigenen Supercomputer Dojo gebaut, der auf Chips basiert, die Tesla selbst entwickelt hat.

Dojo soll gegen Ende 2024 online gehen und wird noch leistungsfähiger sein als der Nvidia-Cluster von Tesla.

Quelle: Tesla

Produktionsleiter bei Nvidia zu sein, muss angesichts der unstillbaren Nachfrage nach Nvidias GPUs ein harter Job sein.

Interessanterweise wurde Musk mit den Worten zitiert: "Ehrlich gesagt... wenn sie (NVIDIA) uns genügend GPUs liefern könnten, bräuchten wir Dojo vielleicht nicht."

Wir denken bei Tesla eher an ein Unternehmen für Elektroautos, aber es scheint, dass es sich in Wirklichkeit um ein Unternehmen für Supercomputer-KI handelt.

Es wird interessant sein zu sehen, wie der exponentielle Anstieg der Rechenleistung Musks Ambitionen sowohl bei Tesla als auch bei seinem xAI-Projekt vorantreibt.