Nvidia hat eine aktualisierte Version seines Grace Hopper Superchips (GH200) vorgestellt, den es vor 2 Monaten angekündigt hatte. Der GH200 wurde entwickelt, um Rechenzentren für groß angelegte KI-Verarbeitung zu betreiben.

Der GH200 ist noch nicht in die Serienproduktion gegangen, aber er hat bereits eine wichtiges Upgrade in seinem Speicher. Das Geheimnis dieser neuen Chips ist der verbesserte Hochbreitenspeicher HBM3e, der mit 5 TB/s auf Daten zugreifen kann.

Dies stellt eine Verbesserung von 50% gegenüber dem HBM3-Speicher des Chips dar, der Ende Mai angekündigt wurde.

Nvidia hat diesen Hochgeschwindigkeitsspeicher mit leistungsstarken CPUs und GPUs auf demselben Gerät verbunden. Die sich daraus ergebende höhere Verarbeitungsgeschwindigkeit wird die KI-Verarbeitungsfähigkeit der aktuellen Rechenzentren drastisch verbessern.

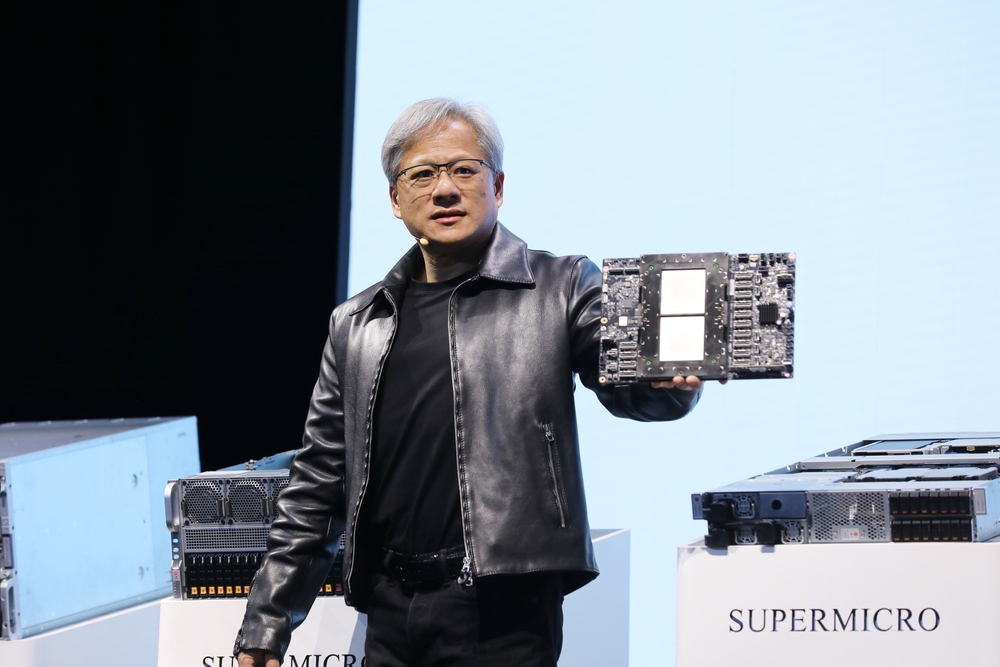

Neben dem aktualisierten Chip kündigte Nvidia auch die GH200 Grace Hopper-Plattform an, die es ermöglicht, zwei GH200-Chips auf einem einzigen Board zu verbinden.

Die Plattform bietet acht Petaflops an KI-Verarbeitung und 282 GB HBM3e-Speicher mit einer Bandbreite von 10 TB/s.

Wie wird der Nvidia-Chip die Rechenzentren verändern?

Die Zahlen sind manchmal etwas schwer zu verstehen. Wie groß ist also die Bedeutung dieses neuen Chips und der neuen Plattform?

In seiner Präsentation verwendete Nvidia-CEO Jensen Huang das Beispiel eines typischen Rechenzentrums mit 8800 x86-Prozessoren, die eine Vielzahl von Rechenfunktionen ausführen (ISO-Budget).

Ein solches Rechenzentrum, in dem Llama 2 zur Inferenz eingesetzt wird, wobei eine Vektordatenbank abgefragt wird und SDXL die Ausgaben generiert, würde etwa $100m kosten und 5MW Strom verbrauchen.

Ein $100m-Rechenzentrum mit 2500 GH200-Plattformen könnte dieselben Modelle 12 Mal schneller betreiben und würde nur 3 MW Strom verbrauchen.

Wenn sich ein Rechenzentrum auf eine ganz bestimmte Gruppe von Aufgaben konzentriert (ISO-Workload), wird der Vergleich noch erschütternder.

Sie müssten nur $8m für 210 GH200-Geräte ausgeben, die 20 Mal weniger Energie verbrauchen, um die Leistung eines $100m-Rechenzentrums zu erreichen.

Es versteht sich von selbst, dass alle KI-Cloud-Computing-Rechenzentren, die sich vor dieser Veröffentlichung in der Planungsphase befanden, wieder auf das Reißbrett zurückkehren werden.

Die GH200-Chips werden im zweiten Quartal 2024 auf den Markt kommen und dürften einen großen Teil des Geschäfts mit x86-Prozessoren ausmachen. AMDs neuer MI300-Chip ist Nvidias nächster Konkurrent, aber sein größerer Speichervorteil scheint durch das Upgrade des neuen GH200 aufgezehrt zu werden.

Der Fortschritt in der Prozessortechnologie, den wir erleben, übersteigt Mooresches Gesetz und es gibt keine Anzeichen für eine Verlangsamung. Generative KI-Anwendungen liefern bereits eine beeindruckende Leistung, aber es sieht so aus, als würden sie noch viel schneller werden.