AI-åldern innebär ett komplext samspel mellan teknik och samhälleliga attityder.

Den ökade sofistikeringen av AI-system suddar ut gränserna mellan människor och maskiner - är AI-tekniken skild från oss själva? I vilken utsträckning ärver AI mänskliga brister och tillkortakommanden vid sidan av färdigheter och kunskaper?

Det är kanske frestande att föreställa sig AI som en empirisk teknik, understruken av objektiviteten i matematik, kod och beräkningar.

Vi har dock insett att de beslut som fattas av AI-system är mycket subjektiva och baseras på de data som de exponeras för - och det är människor som bestämmer hur dessa data ska väljas ut och sammanställas.

Däri ligger en utmaning, eftersom AI-träningsdata ofta förkroppsligar de fördomar och den diskriminering som mänskligheten kämpar mot.

Även till synes subtila former av omedvetna fördomar kan förstoras av modellträningsprocessen och så småningom visa sig i form av bland annat felaktiga ansiktsmatchningar i brottsbekämpande sammanhang, nekad kredit, feldiagnostisering av sjukdomar och försämrade säkerhetsmekanismer för självkörande fordon.

Mänsklighetens försök att förhindra diskriminering i samhället är fortfarande ett pågående arbete, men AI driver på kritiskt beslutsfattande just nu.

Kan vi arbeta tillräckligt snabbt för att synkronisera AI med moderna värderingar och förhindra partiska livsförändrande beslut och beteenden?

Avslöja partiskhet i AI

Under det senaste decenniet har AI-system visat sig kunna spegla samhällets fördomar.

Dessa system är inte partiska i sig själva - i stället absorberar de de fördomar som deras skapare har och de data som de tränas på.

AI-system, precis som människor, lär sig genom exponering. Den mänskliga hjärnan är ett till synes oändligt index av information - ett bibliotek med nästan obegränsat antal hyllor där vi lagrar erfarenheter, kunskap och minnen.

Neurovetenskaplig studier visar att hjärnan egentligen inte har någon "maxkapacitet" utan fortsätter att sortera och lagra information långt upp i åldrarna.

Även om hjärnans progressiva, iterativa inlärningsprocess är långt ifrån perfekt hjälper den oss att anpassa oss till nya kulturella och samhälleliga värderingar, från att låta kvinnor rösta och acceptera olika identiteter till att avskaffa slaveriet och andra former av medvetna fördomar.

Wi lever nu i en tid där AI-verktyg används för kritiskt beslutsfattande i stället för mänskliga bedömningar.

Många modeller för maskininlärning (ML) lär sig från träningsdata som ligger till grund för deras beslutsfattande och kan inte ta in ny information lika effektivt som den mänskliga hjärnan. Därför misslyckas de ofta med att producera de uppdaterade, minutaktuella beslut som vi har kommit att vara beroende av dem för.

AI-modeller används t.ex. för att identifiera ansiktsmatchningar i brottsbekämpande syfte, analysera CV:n för jobbansökningaroch fatta hälsokritiska beslut i kliniska miljöer.

När samhället fortsätter att integrera AI i våra vardagsliv måste vi se till att det är lika och korrekt för alla.

För närvarande är detta inte fallet.

Fallstudier av AI-bias

Det finns många exempel på AI-relaterade fördomar och diskriminering i verkligheten.

I vissa fall är effekterna av AI-bias livsförändrande, medan de i andra fall dröjer sig kvar i bakgrunden och påverkar beslut på ett subtilt sätt.

1. MIT:s fördomar om dataset

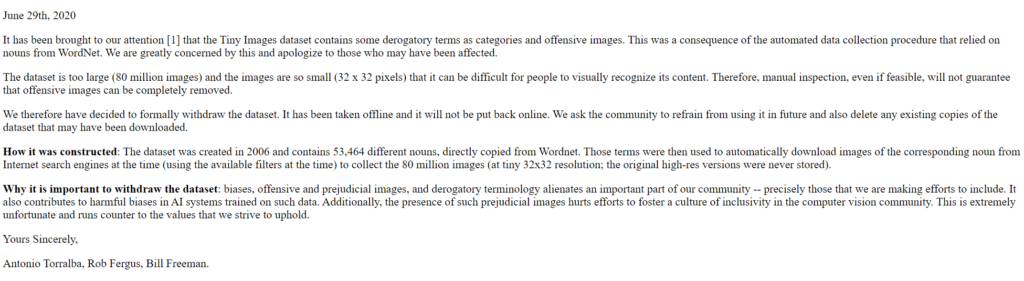

Ett träningsdataset från MIT som byggdes 2008 och kallas Små bilder innehöll cirka 80.000.000.000 bilder i cirka 75.000 kategorier.

Det var ursprungligen tänkt att lära AI-system att känna igen människor och objekt i bilder och blev ett populärt benchmarkingdataset för olika applikationer inom datorseende (CV).

A 2020 analys av The Register konstaterade att många Tiny Images innehöll obscena, rasistiska och sexistiska etiketter.

Antonio Torralba från MIT sa att laboratoriet inte var medvetet om dessa stötande etiketter och sa till The Register: "Det är uppenbart att vi borde ha manuellt screenat dem." MIT släppte senare ett uttalande för att säga att de hade tagit bort datasetet från tjänsten.

Detta är inte den enda gången en tidigare referensdatauppsättning har visat sig vara full av problem. LFW (Labeled Faces in the Wild), ett dataset med kändisansikten som används flitigt i ansiktsigenkänningsuppgifter, består av 77,5% män och 83,5% vithyade individer.

Många av dessa gamla dataset har hittat sin väg in i moderna AI-modeller men härstammar från en era av AI-utveckling där fokus låg på att bygga system som bara arbeta snarare än sådana som är lämpliga för användning i verkliga scenarier.

När ett AI-system väl har tränats på ett sådant dataset har det inte nödvändigtvis samma privilegium som den mänskliga hjärnan när det gäller att kalibrera om till samtida värderingar.

Även om modeller kan uppdateras iterativt är det en långsam och ofullkomlig process som inte kan matcha tempot i den mänskliga utvecklingen.

2: Bildigenkänning: fördomar mot mörkhyade personer

Under 2019 kommer Amerikanska regeringen hittade att de bästa ansiktsigenkänningssystemen felidentifierar svarta människor 5-10 gånger mer än vita människor.

Detta är inte bara en statistisk anomali - det har allvarliga konsekvenser i verkligheten, allt från att Google Foto identifierar svarta människor som gorillor till att självkörande bilar inte känner igen mörkhyade personer och kör på dem.

Dessutom förekom det en mängd felaktiga arresteringar och fängelsestraff med falska ansiktsmatchningar, kanske mest produktiva Nijeer Parks som felaktigt anklagades för snatteri och trafikbrott, trots att han befann sig 30 mil från händelsen. Parks tillbringade därefter 10 dagar i fängelse och fick betala tusentals kronor i advokatkostnader.

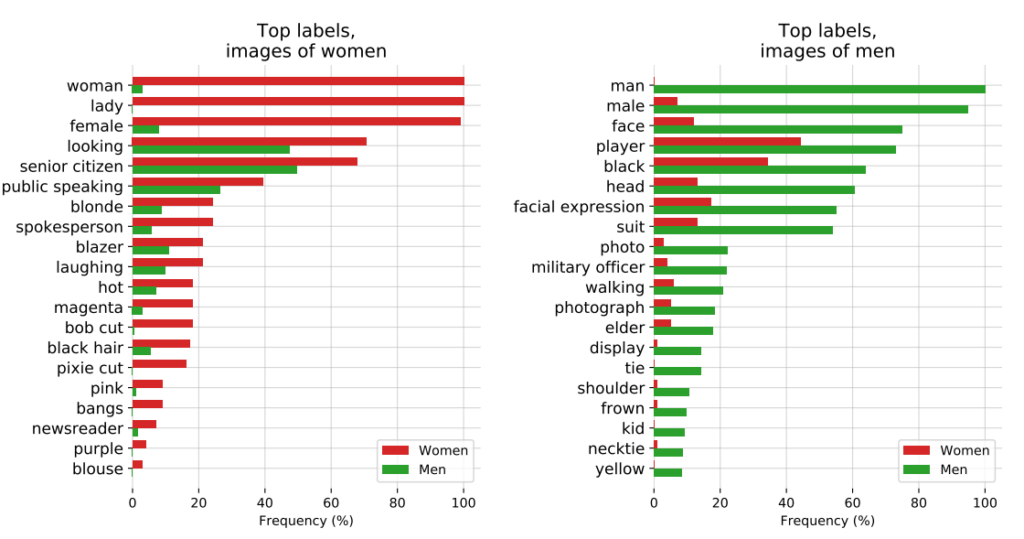

Den inflytelserika studien från 2018, Genusnyanser, undersökte ytterligare algoritmisk partiskhet. Studien analyserade algoritmer som byggts av IBM och Microsoft och fann dålig noggrannhet när de utsattes för mörkhyade kvinnor, med felfrekvenser upp till 34% högre än för ljushyade män.

Detta mönster visade sig vara konsekvent för 189 olika algoritmer.

Videon nedan från studiens huvudforskare Joy Buolamwini ger en utmärkt guide till hur ansiktsigenkänning varierar mellan olika hudfärger.

3: OpenAI:s CLIP-projekt

OpenAI:s CLIP-projektetsom släpptes 2021, utformad för att matcha bilder med beskrivande text, illustrerade också pågående problem med partiskhet.

I ett revisionsdokument lyfte CLIP:s skapare fram sina farhågor och sa: "CLIP bifogade vissa etiketter som beskrev högstatusyrken oproportionerligt ofta för män, till exempel 'verkställande' och 'läkare'. Detta liknar de fördomar som finns i Google Cloud Vision (GCV) och pekar på historiska könsskillnader."

4: Brottsbekämpning: PredPol-kontroversen

Ett annat exempel på algoritmisk partiskhet med höga insatser är PredPol, en algoritm för prediktivt polisarbete som används av olika polismyndigheter i USA.

PredPol tränades på historiska brottsdata för att förutsäga framtida hotspots för brottslighet.

Men eftersom dessa data i sig återspeglar fördomsfulla polismetoder har algoritmen kritiserats för att upprätthålla rasprofilering och oproportionerligt rikta in sig på minoritetsområden.

5: Partiskhet inom dermatologi AI

Inom hälso- och sjukvården är de potentiella riskerna med AI-bias ännu tydligare.

Ta exemplet med AI-system som är utformade för att upptäcka hudcancer. Många av dessa system tränas på datamängder som till överväldigande del består av ljushyade individer.

A 2021 studie av University of Oxford undersökte 21 dataset med öppen tillgång för bilder av hudcancer. De upptäckte att av de 14 dataset som avslöjade sitt geografiska ursprung bestod 11 enbart av bilder från Europa, Nordamerika och Oceanien.

Endast 2.436 av 106.950 bilder i de 21 databaserna hade information om hudtyp registrerad. Forskarna noterade att "endast 10 bilder var från personer som registrerats ha brun hud och en var från en individ som registrerats ha mörkbrun eller svart hud".

När det gäller uppgifter om etnicitet var det endast 1.585 bilder som innehöll denna information. Forskarna konstaterade att "inga bilder var från personer med afrikansk, afrikansk-karibisk eller sydasiatisk bakgrund".

De drog slutsatsen att "i kombination med datasetens geografiska ursprung fanns det en massiv underrepresentation av bilder på hudskador från mörkhyade befolkningar".

Om sådana AI-system används i kliniska miljöer innebär förvrängda dataset en mycket reell risk för feldiagnostisering.

Dissekering av partiskhet i AI-träningsdataset: en produkt av deras skapare?

Träningsdata - oftast text, tal, bilder och video - ger en övervakad maskininlärningsmodell (ML) en grund för att lära sig begrepp.

AI-system är inget annat än tomma dukar från början. De lär sig och skapar associationer baserat på våra data och målar i princip upp en bild av världen som den ser ut i deras träningsdataset.

Genom att lära sig från träningsdata är förhoppningen att modellen ska kunna tillämpa de inlärda begreppen på nya, osedda data.

När de väl har tagits i drift kan vissa avancerade modeller lära sig av nya data, men deras träningsdata styr fortfarande deras grundläggande prestanda.

Den första frågan som måste besvaras är varifrån uppgifterna kommer. Data som samlas in från icke-representativa, ofta homogena och historiskt orättvisa källor är problematiska.

Detta gäller sannolikt en betydande mängd online-data, inklusive text- och bilddata som skrapats från "öppna" eller "offentliga" källor.

Internet, som skapades för bara några decennier sedan, är inte ett universalmedel för mänsklig kunskap och är långt ifrån rättvist. Halva världen använder inte internet, än mindre bidrar till det, vilket innebär att det i grund och botten inte är representativt för det globala samhället och den globala kulturen.

Även om AI-utvecklare ständigt arbetar för att säkerställa att teknikens fördelar inte begränsas till den engelsktalande världen, produceras majoriteten av träningsdata (text och tal) på engelska - vilket innebär att engelsktalande bidragsgivare styr modellens resultat.

Forskare från Anthropic nyligen publicerade ett dokument om just detta ämne och drog slutsatsen: "Om en språkmodell oproportionerligt representerar vissa åsikter riskerar den att medföra potentiellt oönskade effekter, såsom att främja hegemoniska världsbilder och homogenisera människors perspektiv och övertygelser."

Även om AI-system bygger på "objektiva" principer för matematik och programmering, existerar de ändå i och formas av ett djupt subjektivt mänskligt och socialt sammanhang.

Möjliga lösningar på algoritmisk partiskhet

Om data är det grundläggande problemet kan lösningen på hur man bygger rättvisa modeller verka enkel: man gör bara dataset mer balanserade, eller hur?

Inte riktigt. A 2019 års studie visade att det inte räcker med att balansera dataset, eftersom algoritmer fortfarande har en oproportionerligt stor inverkan på skyddade egenskaper som kön och ras.

Författarna skriver: "Överraskande nog visar vi att även när dataset är balanserade så att varje etikett förekommer lika mycket med varje kön, förstärker inlärda modeller sambandet mellan etiketter och kön, lika mycket som om data inte hade balanserats."

De föreslår en teknik där sådana etiketter tas bort helt och hållet från datasetet. Andra tekniker är att lägga till slumpmässiga störningar och förvrängningar, vilket minskar en algoritms uppmärksamhet på specifika skyddade egenskaper.

Även om modifiering av utbildningsmetoder och optimering av maskininlärning är en förutsättning för att producera opartiska resultat, är avancerade modeller känsliga för förändringar eller "drift", vilket innebär att deras prestanda inte nödvändigtvis förblir konsekventa på lång sikt.

En modell kan vara helt opartisk när den tas i bruk, men senare bli partisk när den utsätts för mer och mer nya data.

Den algoritmiska transparensrörelsen

I sin provocerande bok Artificiell ointelligens: Hur datorer missförstår världenMeredith Broussard argumenterar för ökad "algoritmisk transparens" för att utsätta AI-system för flera nivåer av löpande granskning.

Detta innebär att man måste tillhandahålla tydlig information om hur systemet fungerar, hur det har utbildats och vilka data det har utbildats på.

Medan öppenhetsinitiativ lätt absorberas i AI-landskapet med öppen källkod är proprietära modeller som GPT, Bard och Anthropics Claude "svarta lådor", och endast deras utvecklare vet exakt hur de fungerar - och även det är en fråga om debatt.

Problemet med den "svarta lådan" inom AI innebär att externa observatörer bara ser vad som går in i modellen (input) och vad som kommer ut (output). Den inre mekaniken är helt okänd förutom för dess skapare - ungefär som den magiska cirkeln skyddar magikernas hemligheter. AI drar bara upp kaninen ur hatten.

Frågan om den svarta lådan har nyligen utkristalliserats kring rapporter om GPT-4:s potentiella försämring av prestanda. GPT-4-användare hävdar att modellens förmågor har minskat snabbt, och även om OpenAI erkände att detta är sant, har de inte varit helt tydliga med varför det händer. Det ställer frågan, vet de ens?

AI-forskaren Dr. Sasha Luccioni säger att OpenAI:s brist på transparens är ett problem som även gäller andra proprietära eller slutna AI-modellutvecklare. "Alla resultat från modeller med sluten källkod är inte reproducerbara eller verifierbara, och ur ett vetenskapligt perspektiv jämför vi därför tvättbjörnar och ekorrar."

“Det är inte forskarnas uppgift att kontinuerligt övervaka utplacerade LLM:er. Det är modellskaparna som ska ge tillgång till de underliggande modellerna, åtminstone för revisionsändamål", säger hon.

Luccioni betonade att utvecklare av AI-modeller bör tillhandahålla råa resultat från standardbenchmarks som SuperGLUE och WikiText och biasbenchmarks som BOLD och HONEST.

Kampen mot AI-driven partiskhet och fördomar kommer sannolikt att vara konstant och kräva kontinuerlig uppmärksamhet och forskning för att hålla modellresultaten i schack när AI och samhället utvecklas tillsammans.

Även om reglering kommer att kräva former av övervakning och rapportering finns det få hårda och snabba lösningar på frågan om algoritmisk partiskhet, och det här är inte det sista vi kommer att höra om det.