Forskare publicerade en studie som jämförde noggrannheten och kvaliteten på de sammanfattningar som LLM:er producerar. Claude 3 Opus presterade särskilt bra, men människor har fortfarande övertaget.

AI-modeller är extremt användbara för att sammanfatta långa dokument när du inte har tid eller lust att läsa dem.

Lyxen med växande kontextfönster innebär att vi får uppmana modeller med längre dokument, vilket utmanar deras förmåga att alltid få fram fakta i sammanfattningen.

Forskarna kommer från University of Massachusetts Amherst, Adobe, Allen Institute for AI och Princeton University, publicerade en studie som syftade till att ta reda på hur bra AI-modeller är på att sammanfatta boklångt innehåll (>100k tokens).

FABLER

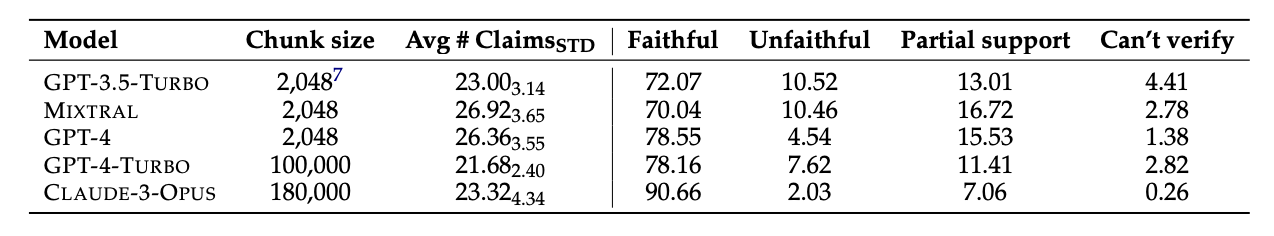

De valde 26 böcker som publicerades 2023 och 2024 och lät olika LLM:er sammanfatta texterna. De senaste publiceringsdatumen valdes för att undvika potentiell datakontaminering i modellernas ursprungliga träningsdata.

När modellerna producerade sammanfattningarna använde de GPT-4 för att extrahera dekontextualiserade påståenden från dem. Forskarna anställde sedan mänskliga annotatorer som hade läst böckerna och bad dem att faktakontrollera påståendena.

De resulterande uppgifterna sammanställdes i ett dataset som kallas "Faithfulness Annotations for Book-Length Summarization" (FABLES). FABLES innehåller 3.158 anteckningar om trofasthet på påståendenivå i 26 berättande texter.

Testresultaten visade att Claude 3 Opus var "den mest trogna sammanfattningen av en boklängd med en betydande marginal", med över 90% av dess påståenden verifierade som trogna eller korrekta.

GPT-4 kom på en avlägsen andraplats med endast 78% av sina påståenden verifierade som trogna av de mänskliga annotatörerna.

Den svåra delen

De modeller som testades verkade alla kämpa med samma saker. Majoriteten av de fakta som modellerna fick fel relaterade till händelser eller tillstånd hos karaktärer och relationer.

I rapporten konstateras att "de flesta av dessa påståenden endast kan ogiltigförklaras genom att man resonerar kring bevisen i flera steg, vilket visar hur komplex uppgiften är och hur den skiljer sig från befintliga inställningar för faktaverifiering".

LLM:erna utelämnade också ofta kritisk information i sina sammanfattningar. De lägger också för stor vikt vid innehåll i slutet av böckerna och missar viktigt innehåll i början.

Kommer AI att ersätta mänskliga kommentatorer?

Mänskliga kommentatorer eller faktakontrollanter är dyra. Forskarna spenderade $5.200 för att få de mänskliga kommentatorerna att verifiera påståendena i AI-sammanfattningarna.

Hade en AI-modell kunnat göra jobbet billigare? Enkelt faktainhämtning är något som Claude 3 är bra på, men dess prestanda när det gäller att verifiera påståenden som kräver en djupare förståelse av innehållet är mindre konsekvent.

När AI-modellerna presenterades med de extraherade påståendena och uppmanades att verifiera dem, klarade de sig sämre än de mänskliga kommentatorerna. De presterade särskilt dåligt när det gällde att identifiera falska påståenden.

Även om Claude 3 Opus var den bästa verifieraren av anspråk med god marginal, drog forskarna slutsatsen att den "i slutändan presterar för dåligt för att vara en tillförlitlig automatisk bedömare".

När det gäller att förstå nyanserna, de komplexa mänskliga relationerna, intrigerna och karaktärernas motiv i en lång berättelse verkar det som om människorna fortfarande har ett försprång.