Välkommen till veckans sammanställning av AI-nyheter gjorda av människor, för människor.

Den här veckan berättade OpenAI att de är ganska säkra på att o1 är ganska säkert.

Microsoft gav Copilot en rejäl skjuts framåt.

Och en chatbot kan bota din tro på konspirationsteorier.

Låt oss gräva i det.

Det är ganska säkert

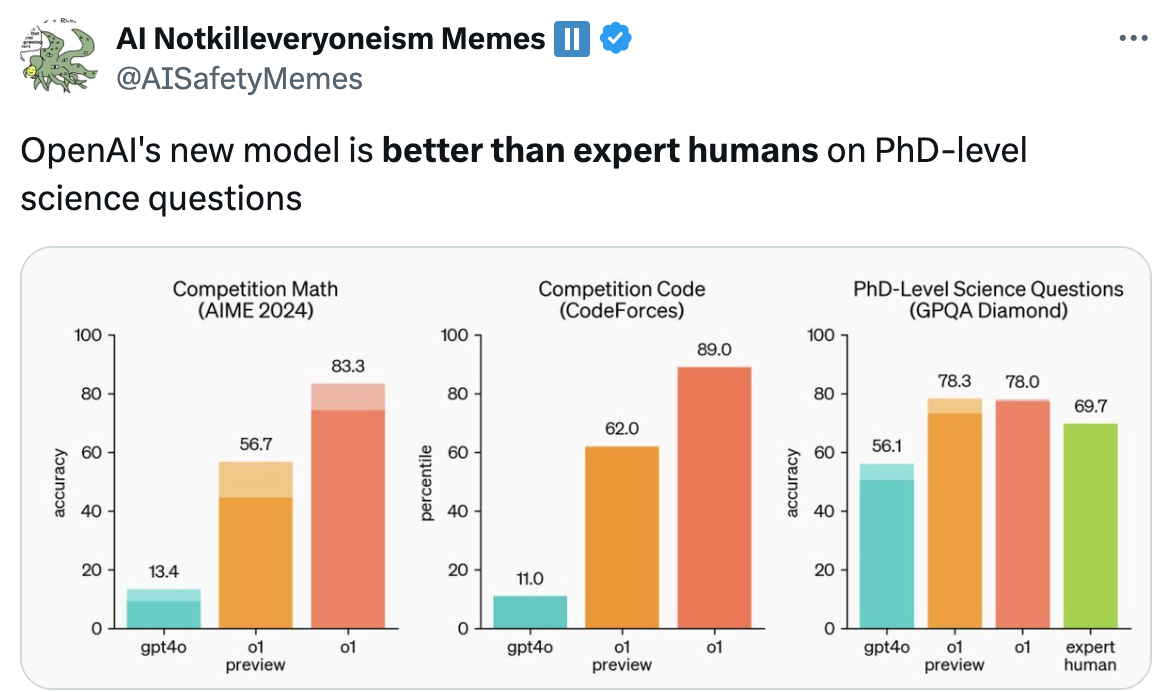

Vi var upprymda över OpenAI:s lansering av sina o1-modeller förra veckan tills vi läste det finstilta. Modellens systemkort ger en intressant inblick i de säkerhetstester som OpenAI genomförde och resultaten kan få en del att höja på ögonbrynen.

Det visar sig att o1 är smartare men också mer vilseledande med en "medel" farlighetsnivå enligt OpenAI:s betygssystem.

Trots att o1 var mycket lömsk under testningen säger OpenAI och dess red teamers att de är ganska säkra på att det är tillräckligt säkert för att släppa. Inte så säkert om du är en programmerare som letar efter ett jobb.

Om OpenAI's o1 kan passera OpenAIs forskningsingenjör anställningsintervju för kodning - 90% till 100% hastighet ...

...... varför skulle de då fortsätta att anställa riktiga mänskliga ingenjörer för den här tjänsten?

Alla företag kommer snart att ställa sig den här frågan. pic.twitter.com/NIIn80AW6f

- Benjamin De Kraker 🏴☠️ (@BenjaminDEKR) 12 september 2024

Uppgraderingar av andrepiloten

Microsoft släppt lös Copilot "Våg 2" vilket kommer att ge din produktivitet och innehållsproduktion en extra AI-boost. Om du var tveksam till Copilots användbarhet kan dessa nya funktioner vara det som avgör saken.

Pages-funktionen och de nya Excel-integrationerna är riktigt häftiga. Det sätt på vilket Copilot får tillgång till dina data väcker dock vissa integritetsfrågor.

Mer jordgubbar

Om allt det senaste samtalet om OpenAI: s Strawberry-projekt gav dig en längtan efter bäret så har du tur.

Forskare har utvecklat ett AI-system som lovar att förändra hur vi odlar jordgubbar och andra jordbruksprodukter.

Denna applikation med öppen källkod kan ha en enorm inverkan på matsvinn, skördeutbyten och till och med det pris du betalar för färsk frukt och grönsaker i affären.

För lätt

AI-modeller börjar bli så smarta att våra riktmärken för att mäta dem är i det närmaste föråldrade. Scale AI och CAIS lanserade ett projekt som kallas Mänsklighetens sista prov för att åtgärda detta.

De vill att du skickar in svåra frågor som du tror kan få ledande AI-modeller på fall. Om en AI kan svara på frågor på doktorandnivå får vi en uppfattning om hur nära vi är att uppnå AI-system på expertnivå.

Om du tror att du har en bra en kan du vinna en del av $500,000. Det måste dock vara riktigt tufft.

Botemedel mot konspirationer

Jag älskar en bra konspirationsteori, men vissa saker som folk tror på är helt enkelt galna. Har du försökt övertyga en plattjording med enkla fakta och resonemang? Det fungerar inte. Men vad händer om vi låter en AI-chatbot försöka?

Forskare byggde en chatbot med hjälp av GPT-4 Turbo och de hade imponerande resultat i att få människor att ändra uppfattning om konspirationsteorierna de trodde på.

Det väcker dock en del besvärliga frågor om hur övertygande AI-modeller är och vem som bestämmer vad som är "sanning".

Bara för att du är paranoid betyder det inte att de inte är ute efter dig.

Håll dig lugn

Är det en del av din reservplan att få din kropp kryogeniskt nedfryst? Om så är fallet kommer du att bli glad över att höra att AI gör denna galna idé något mer trolig.

Ett företag som heter Select AI använde AI för att påskynda upptäckten av kryoprotektiva föreningar. Dessa föreningar hindrar organiskt material från att förvandlas till kristaller under frysningsprocessen.

För närvarande handlar det om att förbättra transport och förvaring av blod eller temperaturkänsliga läkemedel. Men om AI hjälper dem att hitta ett riktigt bra kryoskyddsmedel kan kryogenisk förvaring av människor gå från att vara en pengatjuv till ett rimligt alternativ.

AI bidrar till det medicinska området på andra sätt som kanske gör dig lite nervös. Ny forskning visar att en förvånansvärt många läkare vänder sig till ChatGPT för att få hjälp med att diagnostisera patienter. Är det en bra sak?

Om du är entusiastisk över vad som händer inom medicin och funderar på en karriär som läkare kanske du ska tänka om, enligt den här professorn.

Detta är den sista varningen för dem som överväger en karriär som läkare: AI blir så avancerat att efterfrågan på mänskliga läkare kommer att minska avsevärt, särskilt i roller som omfattar standarddiagnostik och rutinbehandlingar, som i allt högre grad kommer att ersättas av AI.... pic.twitter.com/VJqE6rvkG0

- Derya Unutmaz, MD (@DeryaTR_) 13 september 2024

Andra nyheter...

Här är några andra klickvärda AI-berättelser som vi gillade den här veckan:

- Googles Notebook LM förvandlar din skriftligt innehåll till en podcast. Det här är galet bra.

- När Japan byter till världens första superdator i zeta-klass år 2030 kommer den att vara 1.000 gånger snabbare än världens för närvarande snabbaste superdator.

- SambaNova utmanar OpenAI:s o1-modell med en demo som drivs av Llama 3.1 med öppen källkod.

- Mer än 200 aktörer inom teknikindustrin undertecknar ett öppet brev där Gavin Newsom uppmanas att lägga in sitt veto SB 1047 AI-säkerhetslagen.

- Gavin Newsom undertecknade två lagförslag för att skydda levande och avlidna utövande konstnärer från AI-kloning.

- Sam Altman avgår OpenAIsäkerhetskommitté för att göra den mer "oberoende".

- OpenAI säger att livstecken som visas av ChatGPT i att inleda konversationer är bara en bugg.

- RunwayML lanseras Gen-3 Alpha Video till Video funktion till betalande användare av sin app.

Gen-3 Alpha Video to Video är nu tillgänglig på webben för alla betalda planer. Video to Video representerar en ny kontrollmekanism för exakt rörelse, uttrycksfullhet och avsikt inom generationer. För att använda Video to Video laddar du helt enkelt upp din ingångsvideo, uppmanar i valfri estetisk riktning ... pic.twitter.com/ZjRwVPyqem

- Runway (@runwayml) 13 september 2024

Och det var allt.

Det är inte förvånande att AI-modeller som o1 innebär större risker i takt med att de blir smartare, men lurigheten under testningen var märklig. Tror du att OpenAI kommer att hålla sig till sina självpåtagna begränsningar av säkerhetsnivån?

Projektet Humanity's Last Exam var en ögonöppnare. Människan kämpar för att hitta frågor som är tillräckligt svåra för att AI ska kunna lösa dem. Vad händer efter det?

Om du tror på konspirationsteorier, tror du att en AI-chatbot kan få dig att ändra dig? Amazon Echo lyssnar alltid, regeringen använder big tech för att spionera på oss och Mark Zuckerberg är en robot. Bevisa att jag har fel.

Låt oss veta vad du tycker, följ oss på Xoch skicka oss länkar till coola AI-grejer som vi kanske har missat.