Meta har släppt sina uppgraderade Llama 3.1-modeller i 8B-, 70B- och 405B-versioner och åtagit sig Mark Zuckerbergs vision om öppen källkod för framtiden för AI.

De nya tillskotten till Metas Llama-familj av modeller kommer med en utökad kontextlängd på 128k och stöd för åtta språk.

Meta säger att den efterlängtade 405B-modellen visar "oöverträffad flexibilitet, kontroll och toppmoderna funktioner som konkurrerar med de bästa modellerna med sluten källkod". Man hävdar också att Llama 3.1 405B är "världens största och mest kapabla öppet tillgängliga grundmodell".

Med iögonfallande datorkostnader som spenderas för att träna allt större modeller fanns det mycket spekulationer om att Metas flaggskeppsmodell 405B kunde vara den första betalda modellen.

Llama 3.1 405B tränades på över 15 biljoner tokens med hjälp av 16.000 NVIDIA H100, vilket sannolikt kostade hundratals miljoner dollar.

I en BlogginläggMetas VD Mark Zuckerberg bekräftade företagets uppfattning att AI med öppen källkod är vägen framåt och att lanseringen av Llama 3.1 är nästa steg "mot att AI med öppen källkod blir branschstandard".

Llama 3.1-modellerna är gratis att ladda ner och modifiera eller finjustera med en uppsättning tjänster från Amazon, Databricks och NVIDIA.

Modellerna finns också tillgängliga hos molntjänstleverantörer som AWS, Azure, Google och Oracle.

Från och med idag är det öppen källkod som visar vägen. Vi introducerar Llama 3.1: Våra mest kapabla modeller hittills.

Idag släpper vi en samling nya Llama 3.1-modeller, inklusive vår efterlängtade 405B. Dessa modeller levererar förbättrade resonemangsfunktioner, en större 128K tokenkontext ... pic.twitter.com/1iKpBJuReD

- AI på Meta (@AIatMeta) 23 juli 2024

Prestanda

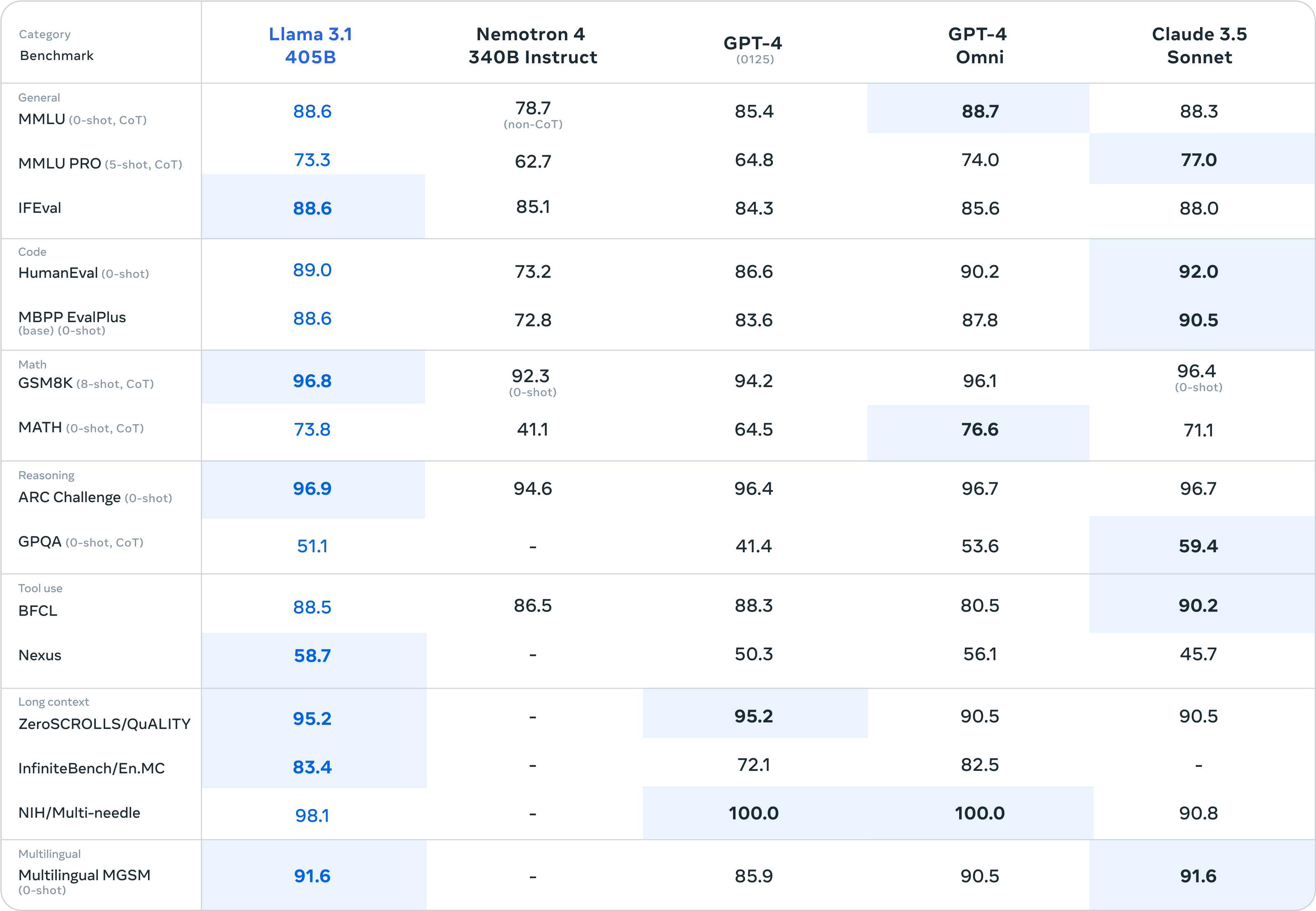

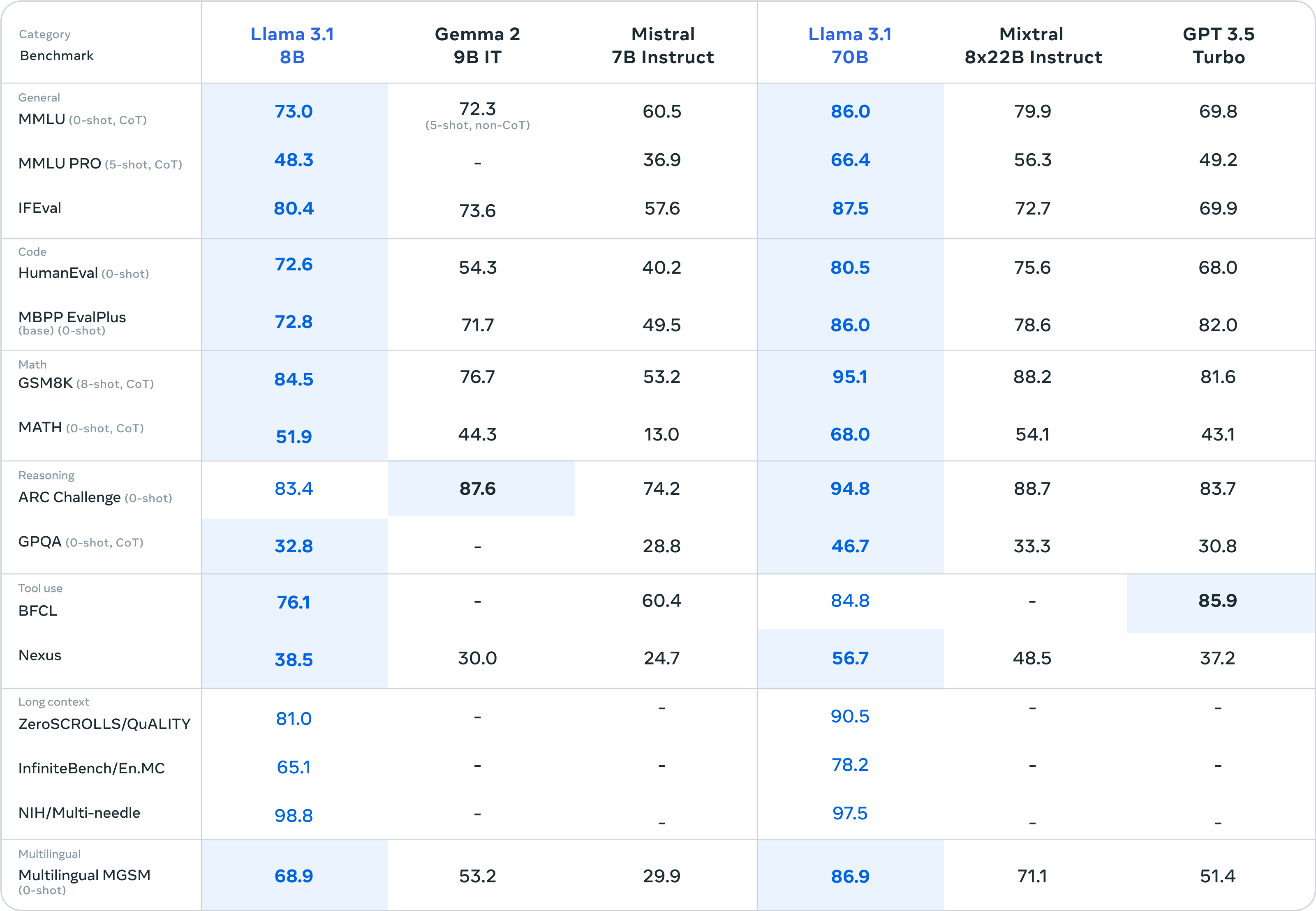

Meta säger att de testade sina modeller på över 150 referensdataset och släppte resultat för de vanligaste riktmärkena för att visa hur de nya modellerna står sig mot andra ledande modeller.

Det är inte mycket som skiljer Llama 3.1 405B från GPT-4o och Claude 3.5 Sonnet. Här är siffrorna för 405B-modellen och sedan de mindre 8B- och 70B-versionerna.

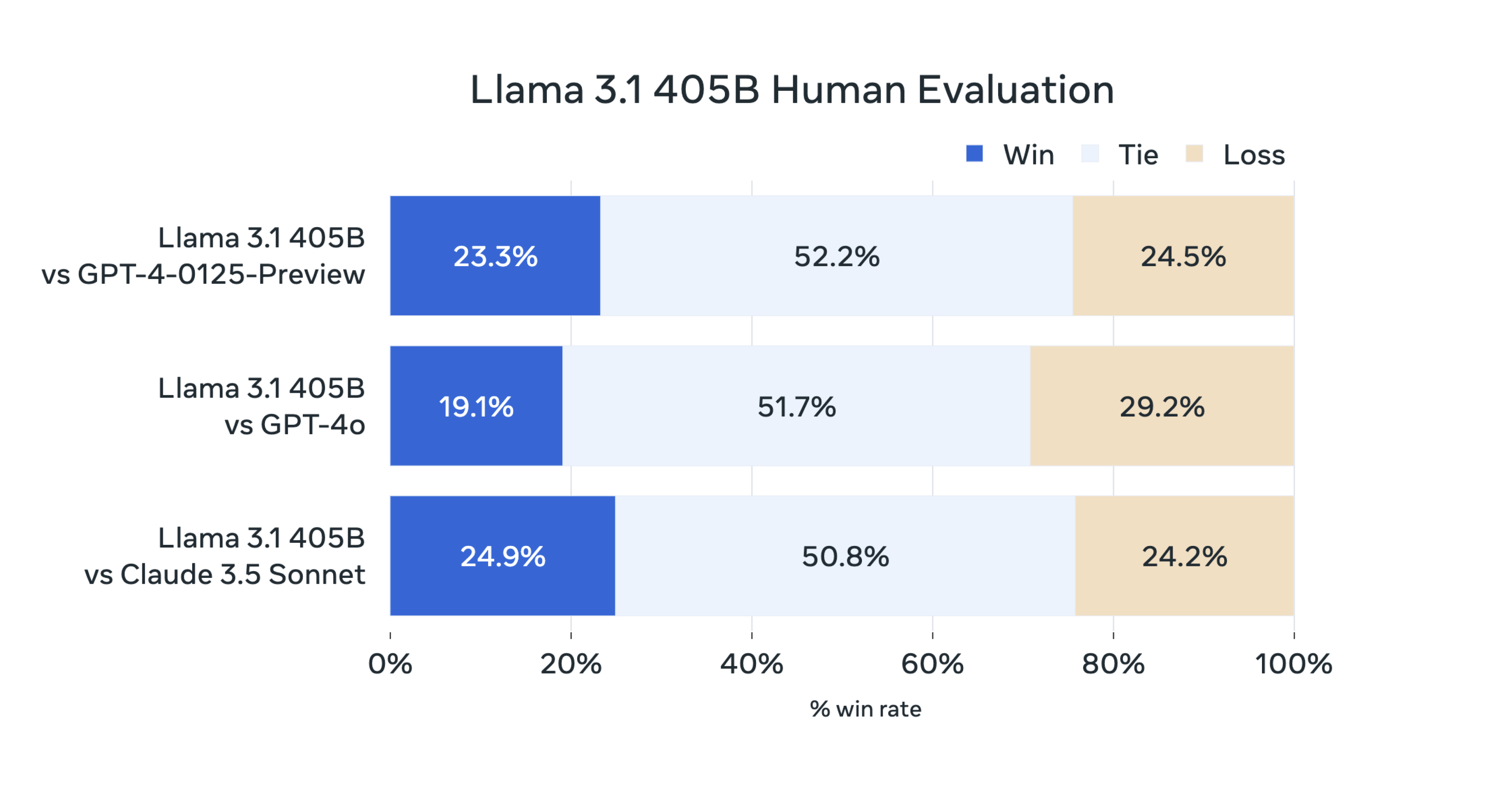

Meta utförde också "omfattande mänskliga utvärderingar som jämför Llama 3.1 med konkurrerande modeller i verkliga scenarier."

Dessa siffror bygger på att användarna avgör om de föredrar att få svar från den ena eller andra modellen.

Den mänskliga utvärderingen av Llama 3.1 405B återspeglar liknande paritet som jämförelsesiffrorna avslöjar.

Meta säger att dess modell är verkligt öppen eftersom Llama 3.1-modellvikter också är tillgängliga för nedladdning, även om träningsdata inte har delats. Företaget ändrade också sin licens för att tillåta att Llama-modeller används för att förbättra andra AI-modeller.

Friheten att finjustera, modifiera och använda Llama-modeller utan begränsningar kommer att ha kritiker av öppen källkod AI får varningsklockorna att ringa.

Zuckerberg menar att en öppen källkod är det bästa sättet att undvika oavsiktlig skada. Om en AI-modell är öppen för granskning är det mindre sannolikt att den utvecklar ett farligt emergent beteende som vi annars skulle missa i slutna modeller, säger han.

När det gäller risken för avsiktlig skada säger Zuckerberg: "Så länge som alla har tillgång till liknande generationer av modeller - vilket öppen källkod främjar - kommer regeringar och institutioner med mer beräkningsresurser att kunna kontrollera dåliga aktörer med mindre beräkningsresurser."

Att ta itu med risken för att statliga motståndare som Kina får tillgång till Metas modeller Zuckerberg säger att ansträngningar för att hålla dessa ur kinesiska händer inte kommer att fungera.

"Våra motståndare är duktiga på spionage, det är relativt enkelt att stjäla modeller som ryms på ett USB-minne och de flesta teknikföretag är långt ifrån att arbeta på ett sätt som skulle göra detta svårare", förklarade han.

Upphetsningen över att en AI-modell med öppen källkod som Llama 3.1 405B tar upp kampen med de stora slutna modellerna är berättigad.

Men med rykten om GPT-5 och Claude 3.5 Opus som väntar i kulisserna kanske dessa benchmarkresultat inte åldras särskilt väl.