När ChatGPT ger dig rätt svar på din fråga, resonerar den genom förfrågan eller kommer den helt enkelt ihåg svaret från sina träningsdata?

Forskare vid MIT:s Computer Science and Artificial Intelligence Laboratory (CSAIL) har utformat en serie tester för att se om AI-modeller "tänker" eller bara har bra minne.

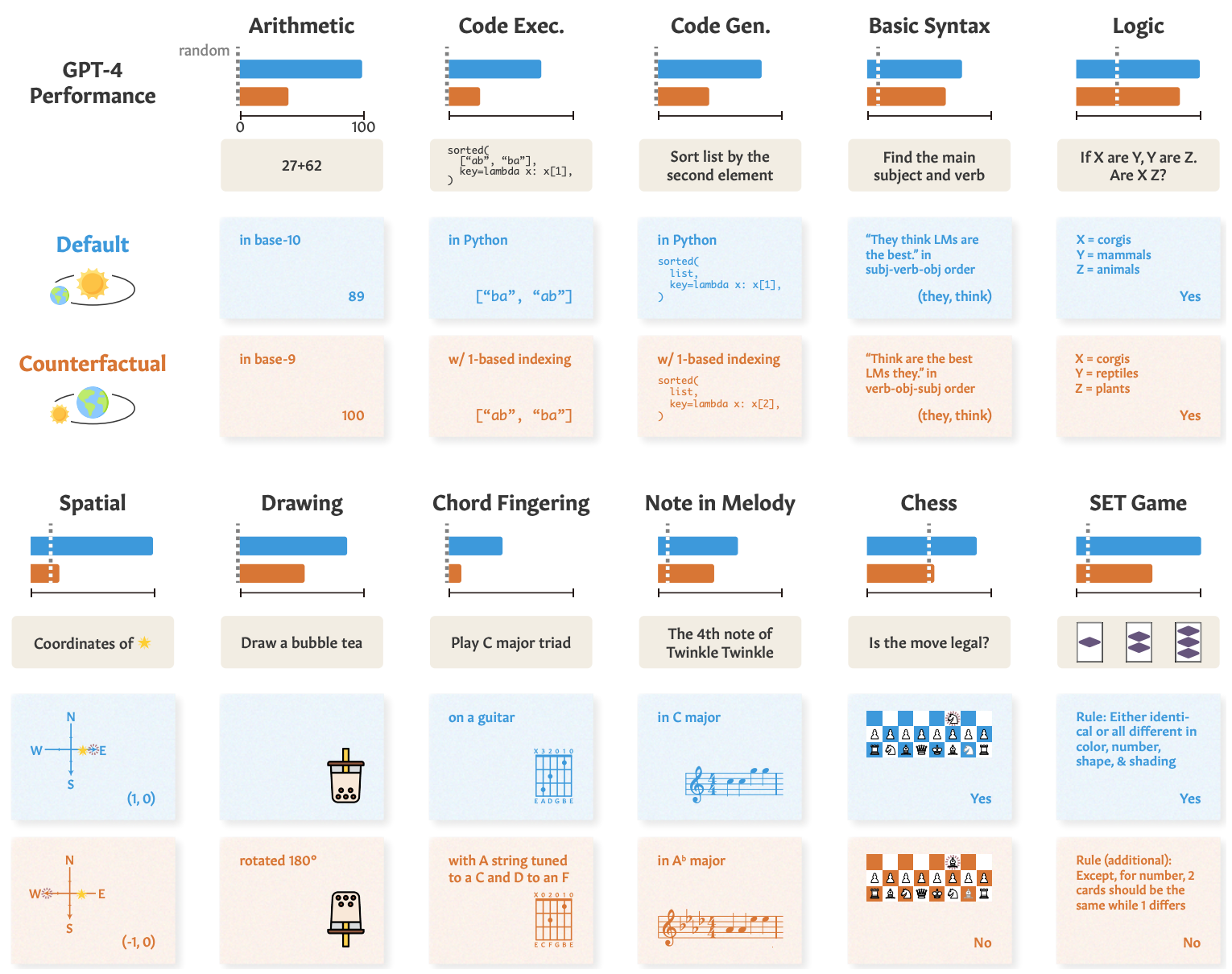

När du ber en AI-modell att lösa ett matematiskt problem som "Vad är 27+62?" kommer den snabbt tillbaka med rätt svar: 89. Hur kan vi säga om den förstår den underliggande aritmetiken eller helt enkelt såg problemet i sina träningsdata?

I deras pappertestade forskarna GPT-4, GPT-3.5 Turbo, Claude 1.3 och PaLM2 för att se om de kunde "generalisera inte bara till osedda instanser av kända uppgifter utan även till nya uppgifter".

De utformade en serie med 11 uppgifter som skilde sig något från de standarduppgifter som LLM-personer i allmänhet presterar bra i.

LLM:erna bör prestera lika bra med de "kontrafaktiska uppgifterna" om de använder generella och överförbara procedurer för uppgiftslösning.

Om en LLM "förstår" matematik bör den till exempel ge rätt svar på ett matematiskt problem i bas-10 och den sällan använda bas-9.

Här följer några exempel på uppgifter och GPT-4:s prestanda.

GPT-4:s prestanda i standardtester (blå linje) är bra, men dess förmåga till matematik, logiska resonemang, spatiala resonemang och andra förmågor (orange linje) försämras avsevärt när uppgiften ändras något.

De andra modellerna uppvisade liknande nedbrytning med GPT-4 i topp.

Trots försämringen var resultatet för de kontrafaktiska uppgifterna fortfarande bättre än slumpen. AI-modellerna försöker resonera sig fram genom dessa uppgifter men är inte särskilt bra på det.

Resultaten visar att AI-modellernas imponerande prestanda i uppgifter som högskoleprov beror på utmärkt återkallande av träningsdata, inte på resonemang. Detta belyser ytterligare att AI-modeller inte kan generaliseras till osynliga uppgifter,

Zhaofeng Wu, MIT-doktorand i elektroteknik och datavetenskap, CSAIL-ansluten och huvudförfattare till artikeln, säger: "Vi har upptäckt en fascinerande aspekt av stora språkmodeller: de utmärker sig i bekanta scenarier, nästan som en väl upptrampad stig, men kämpar när terrängen blir obekant. Denna insikt är avgörande när vi strävar efter att förbättra dessa modellers anpassningsförmåga och bredda deras applikationshorisonter."

Vi såg en liknande demonstration av denna oförmåga att generalisera när vi undersökte hur dåliga AI-modeller är på att lösa ett förenklat flodövergångspussel.

Forskarna drog slutsatsen att när utvecklare analyserar sina modeller bör de "betrakta abstrakt uppgiftsförmåga som fristående från observerad uppgiftsprestation".

"Träna-för-att-testa"-metoden kan flytta en modell uppåt i riktmärkena, men ger inget verkligt mått på hur modellen kommer att klara sig när den ställs inför en ny uppgift att resonera igenom.

Forskarna menar att en del av problemet är att dessa modeller endast tränas på ytformad text.

Om LLM:er exponeras för mer kontextualiserade data och semantiska representationer från den verkliga världen kan de kanske generalisera när de ställs inför variationer i uppgifterna.