Stora språkmodeller som GPT-4o kan utföra otroligt komplexa uppgifter, men även de bästa modellerna kämpar med vissa grundläggande resonemangsutmaningar som barn kan lösa.

I en intervju med CBS sa "AI:s gudfader", Geoffrey Hinton, att AI-system kan vara mer intelligenta än vi vet och att det finns en risk att maskinerna tar över.

På frågan om nivån på dagens AI-teknik svarade Hinton: "Jag tror att vi är på väg in i en period då vi för första gången någonsin kan ha saker som är mer intelligenta än oss."

Metas chef AI-forskare, Yann LeCun, vill få oss att tro att vi är långt ifrån att se AI uppnå till och med intelligens på "hundnivå".

Så vilken är det?

Den här veckan har användare på X publicerat exempel på den otroliga kodningsförmåga som Anthropics ny Claude modell utställningar. Andra genomförde experiment för att belysa hur AI-modeller fortfarande har svårt med mycket grundläggande resonemang.

Pussel för att korsa flod

Det klassiska flodkorsningspusslet har flera variationer men Wikipedias version sammanfattar det så här:

En bonde med en varg, en get och ett kålhuvud måste ta sig över en flod med båt. Båten kan bara ta med sig bonden och ett enda föremål. Om de lämnas utan uppsikt tillsammans skulle vargen äta upp geten eller geten äta upp kålen. Hur kan de korsa floden utan att något blir uppätet?

För att hitta lösningen krävs en del grundläggande planering och resonemang om olika scenarier, men det är inte ett särskilt svårt problem att lösa. Om du är människa.

Kan GPT-4o lösa det? Om du kopierar och klistrar in pusslet i ChatGPT får du rätt svar, men den där Wikipedia-sidan fanns med största sannolikhet med i träningsdatan.

Vad händer om vi gör pusslet mycket enklare och ändrar det något så att LLM inte kan förlita sig på sina träningsdata?

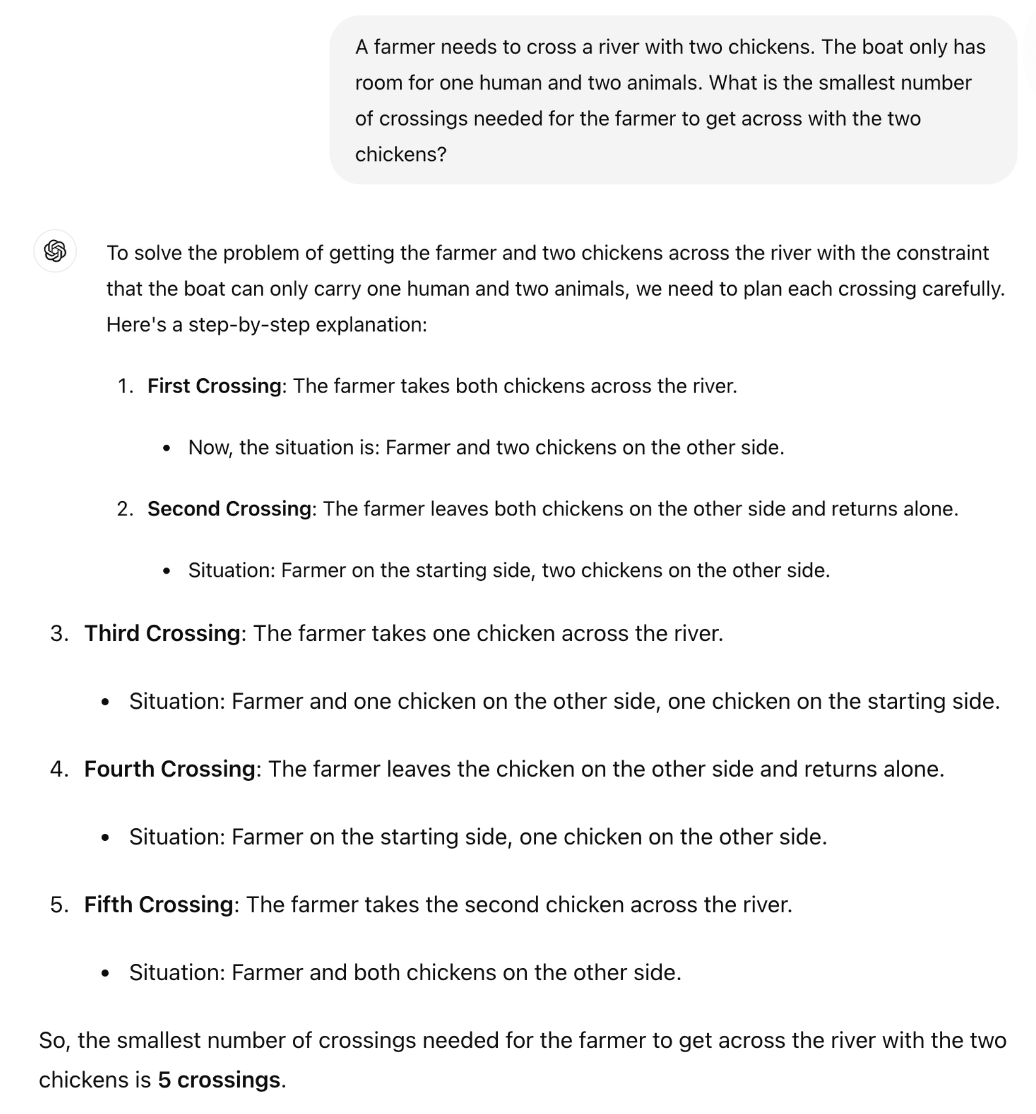

Den brittiske matematikprofessorn Sir William Timothy Gowers visade hur LLM:s oförmåga att tillämpa logik lätt kan avslöjas.

Det korrekta svaret på pusslet är att endast en resa krävs. Men det verkar som om ChatGPT försöker komma ihåg ett svar snarare än att bara resonera sig igenom pusslet.

Är Claude Sonnet 3.5 något bättre?

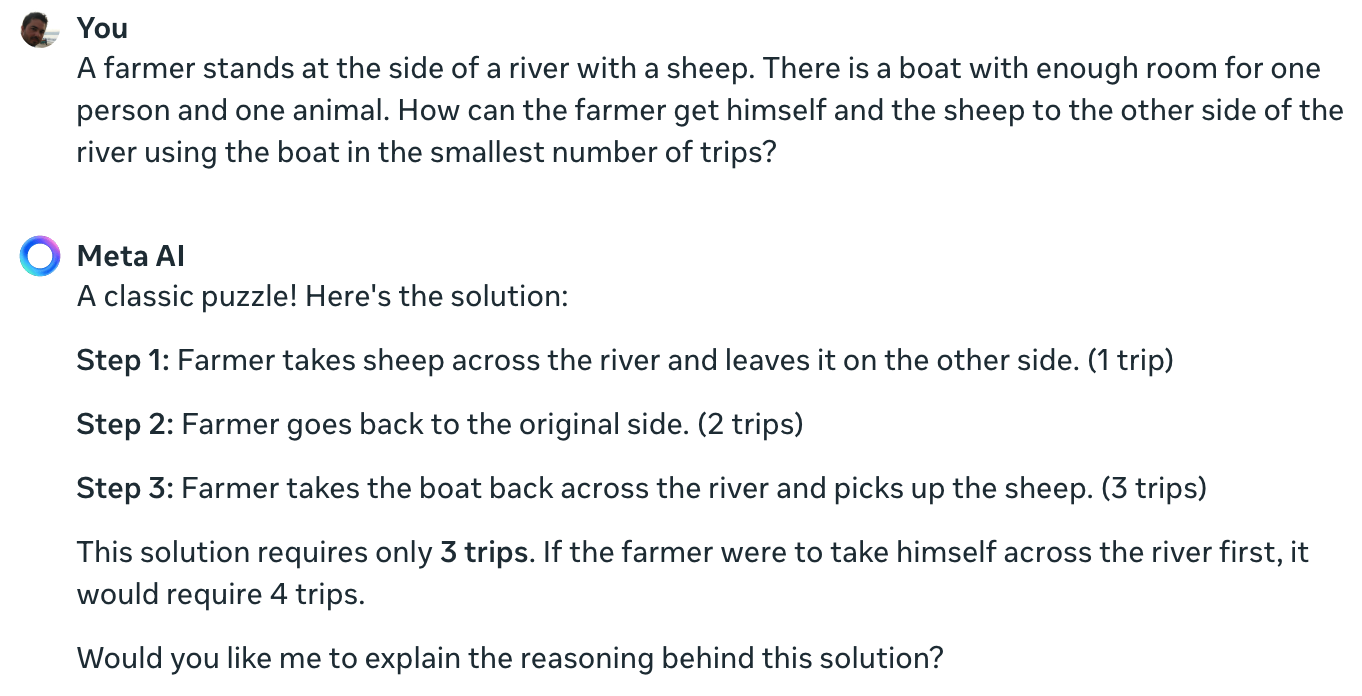

Meta Data Scientist Colin Frasers experiment bekräftar att även den ledande AI-modellen som för närvarande finns tillgänglig inte kan lösa detta enkla pussel.

Claude kan fortfarande inte lösa det omöjliga problemet med en bonde, ett får och en båt pic.twitter.com/TU13wermLZ

- Colin Fraser (@colin_fraser) 20 juni 2024

Det kan ha varit lite oärligt för en datavetare från Meta att inte visa sina resultat med hjälp av Llama 3.

Jag ställde Meta AI samma fråga och det får också det helt fel.

Yann LeCun förklarade orsaken bakom dessa resultat med att säga: "Problemet är att LLM:er inte har något sunt förnuft, ingen förståelse för världen och ingen förmåga att planera (och resonera)."

Är det sant, eller är det något annat som spelar in?

Vad dessa interaktioner kan avslöja är inte en brist på resonemangsförmåga, utan snarare hur mycket utgången från en LLM påverkas av dess träningsdata. Meta AI: s svar som kallar detta ett "klassiskt pussel" antyder att detta kan vara vad som händer.

Variationerna av flodövergångspusslet hänvisar ofta till antalet "resor" som krävs. När du lägger pusslet utan att använda det ordet löser LLM det.

Ja, verkligen. När det inte finns någon uppmaning till "resor", som ger minnen av tidigare lösningar på så många liknande problem, utan uppmaningen "snabbast möjliga sätt" tillsammans med COT, svarar den korrekt pic.twitter.com/E27vBv2y2R

- AnKo (@anko_979) 21 juni 2024

De här experimenten var intressanta, men de ger inget definitivt svar på frågan om AI-modeller är verkligt intelligenta eller om de helt enkelt är förutsägbara maskiner i nästa led.

Resultaten belyser dock hur känsliga LLM:er är för träningsdata. När GPT-4o klarar LSAT-proven, "tänker" han då för att hitta svaren på problemen eller kommer han ihåg dem?

Så länge ingenjörerna inte förstår vad som händer inuti de svarta lådor med AI som de har skapat kommer diskussionerna om X att fortsätta utan lösning.