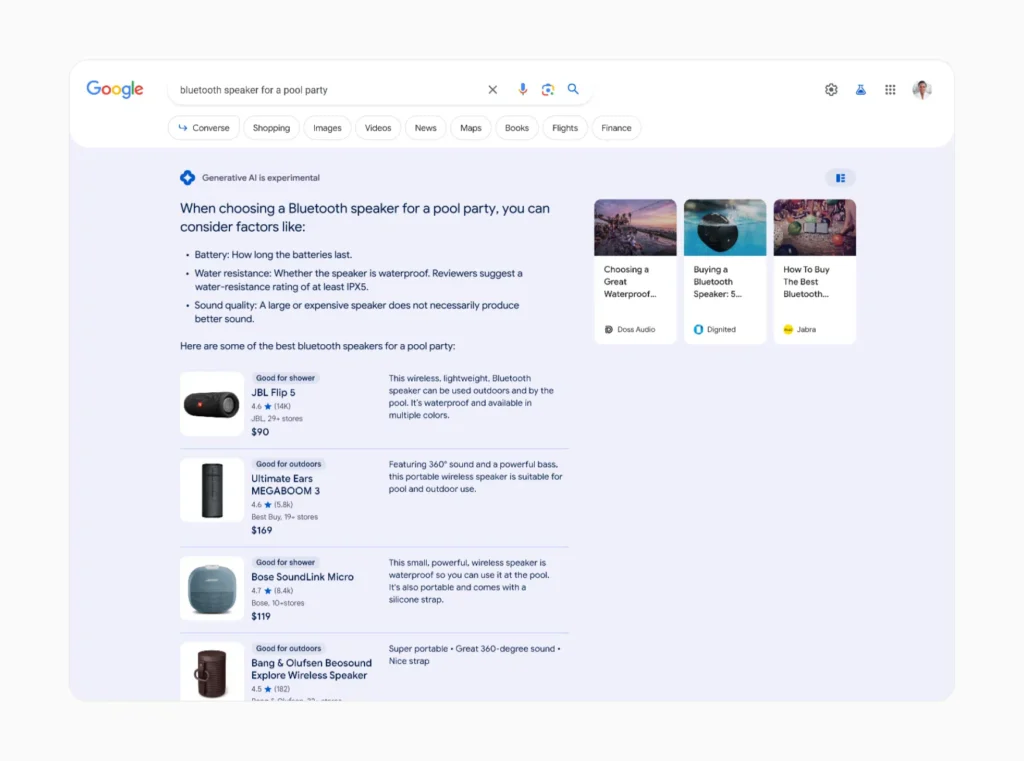

På Googles senaste flaggskeppskonferens I/O presenterade företaget sin Search Generative Experience (SGE) - som kommer att integrera generativ AI i Google Search.

SGE, som har som mål att ge AI-genererade svar till över en miljard användare i slutet av 2024, förlitar sig på Gemini, Googles familj av stora språkmodeller (LLM), för att generera människoliknande svar på sökfrågor.

Istället för en traditionell Google-sökning, som främst visar länkar, kommer du att få en AI-genererad sammanfattning tillsammans med andra resultat.

Denna "AI-översikt" har kritiserats för att tillhandahålla nonsensinformationoch Google arbetar snabbt på lösningar innan man börjar med massutrullningen.

Men bortsett från att rekommendera att man lägger lim på pizza och att pytonormar är däggdjur, finns det ett annat problem med Googles nya AI-drivna sökstrategi: dess miljöavtryck.

Varför SGE är resurskrävande

Medan traditionella sökmotorer bara hämtar befintlig information från internet, måste generativa AI-system som SGE skapa helt nytt innehåll för varje fråga.

Denna process kräver betydligt mer datorkraft och energi än konventionella sökmetoder.

Det uppskattas att mellan 3 och 10 miljarder sökningar görs på Google varje dag. Effekterna av att tillämpa AI på ens en liten andel av dessa sökningar skulle kunna vara otroliga.

Sasha Luccioni, forskare på AI-bolaget Hugging Face som studerar miljöpåverkan av dessa tekniker, diskuterade nyligen den kraftiga ökningen av energiförbrukningen som SGE kan leda till.

Luccioni och hennes team uppskattar att generering av sökinformation med AI kan kräva 30 gånger så mycket energi som en konventionell sökning.

"Det är ju bara logiskt, eller hur? Medan en vanlig sökfråga hittar befintlig data från internet, måste applikationer som AI Overviews skapa helt ny information", säger han. berättade hon för Scientific American.

År 2023 fann Luccioni och hennes kollegor att utbildningen av LLM BLOOM släppte ut växthusgaser motsvarande 19 kg CO2 per användningsdag, eller den mängd som genereras genom att köra 49 mil i en genomsnittlig bensindriven bil. De fann också att generering av bara två bilder med hjälp av AI kan förbruka lika mycket energi som en full laddning av en genomsnittlig smartphone.

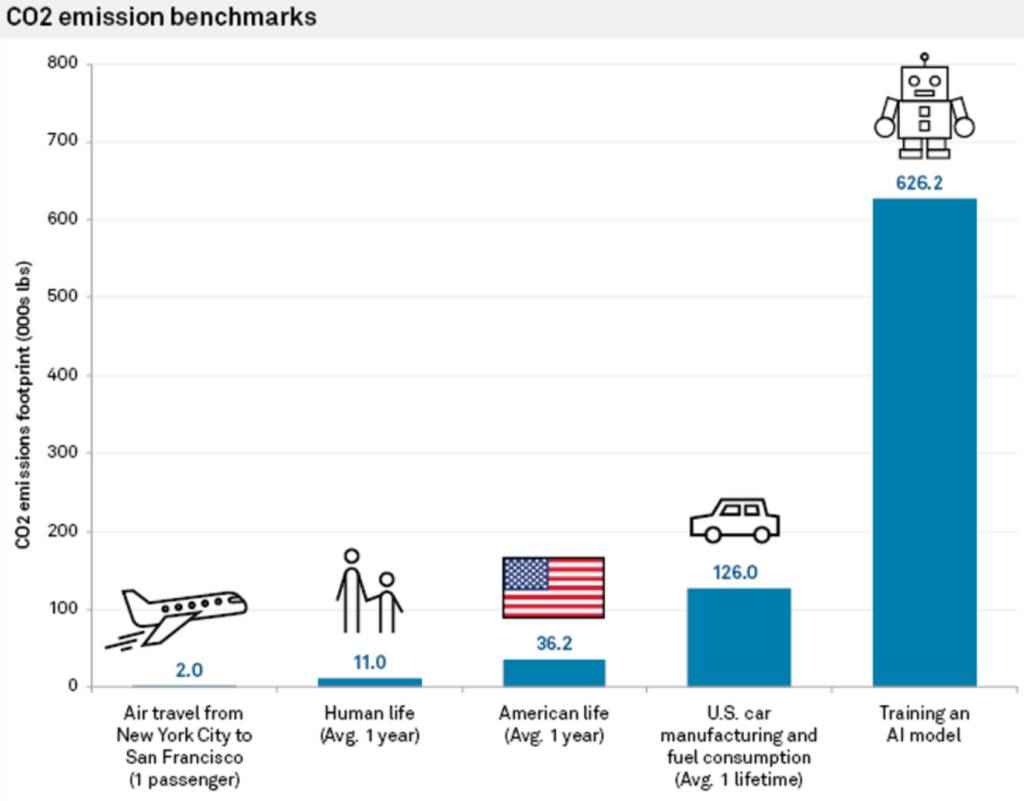

Tidigare studier har uppskattat att koldioxidutsläppen i samband med träning av en AI-modell kan överstiga utsläppen från hundratals kommersiella flygningar eller en genomsnittlig bil under dess livstid.

I en intervju med Reuters förra åretJohn Hennessy, ordförande för Googles moderbolag Alphabet, medgav själv de ökade kostnader som är förknippade med AI-driven sökning.

"En börs med en stor språkmodell kan kosta tio gånger mer än en traditionell sökning", sade han, även om han förutspådde att kostnaderna skulle minska i takt med att modellerna finjusteras.

AI-sökningens påfrestning på infrastruktur och resurser

Datacenter med AI-servrar beräknas fördubbla sin energiförbrukning fram till 2026 och potentiellt använda så mycket makt som ett litet land.

Med chiptillverkare som NVIDIA som rullar ut större och kraftfullare chip kan det snart ta motsvarar flera kärnkraftverk för att köra storskaliga AI-arbetsbelastningar.

När AI-företagen svarar på frågor om hur detta kan upprätthållas brukar de hänvisa till förnybara energikällors ökade effektivitet och kapacitet samt AI-hårdvarans förbättrade energieffektivitet.

Övergången till förnybara energikällor för datacenter har dock visat sig vara långsam och komplicerad.

Som Shaolei Ren, dataingenjör vid University of California, Riverside, som studerar hållbar AI, förklarade: "Det finns en obalans mellan utbud och efterfrågan på förnybar energi. Den intermittenta karaktären hos förnybar energiproduktion matchar ofta inte den konstanta, stabila kraft som krävs av datacenter."

På grund av denna obalans hålls anläggningar som drivs med fossila bränslen igång längre än planerat i områden med hög koncentration av teknisk infrastruktur.

En annan lösning på energiproblemen ligger i energieffektiv AI-hårdvara. NVIDIA:s nytt Blackwell-chip är många gånger mer energieffektiva än sina föregångare, och andra företag som Delta arbetar med effektiv hårdvara för datacenter.

Rama Ramakrishnan, professor vid MIT Sloan School of Management, förklarade att även om antalet sökningar som går via LLM:er sannolikt kommer att öka, verkar kostnaden per sökning minska i takt med att företagen arbetar för att göra hård- och mjukvara mer effektiv.

Men kommer det att räcka för att kompensera för det ökande energibehovet? "Det är svårt att förutspå", säger Ramakrishnan. "Min gissning är att det förmodligen kommer att gå upp, men det kommer förmodligen inte att gå upp dramatiskt."

I takt med att AI-racet intensifieras har det blivit nödvändigt att minska miljöpåverkan. Nöden är uppfinningarnas moder, och teknikföretagen är pressade att skapa lösningar för att hålla AI:s momentum rullande.

Energieffektiva hårdvaror, förnybara energikällor och även fusionskraft kan bana väg för en mer hållbar framtid för AI, men resan är kantad av osäkerhet.

SGE kan också belasta vattenförsörjningen

Vi kan också spekulera i de vattenbehov som SGE skapar, vilket skulle kunna spegla de stora ökningarna av vattenförbrukningen i datacenter som tillskrivs den generativa AI-industrin.

Enligt Microsofts senaste miljörapporter har vattenförbrukningen ökade med upp till 50% i vissa regioner, med en fördubbling av vattenförbrukningen i Las Vegas datacenter sedan 2022. Googles rapporter registrerade också en ökning med 20% av vattenutgifterna för datacenter 2023 jämfört med 2022.

Ren tillskriver AI den största delen av tillväxten och säger: "Det är rimligt att säga att den största delen av tillväxten beror på AI, inklusive Microsofts stora investeringar i generativ AI och partnerskap med OpenAI."

Ren uppskattade att varje interaktion med ChatGPT, som består av 5 till 50 uppmaningar, förbrukar häpnadsväckande 500 ml vatten.

I en papper som publicerades 2023, skrev Rens team: "Den globala AI-efterfrågan kan vara ansvarig för 4,2 - 6,6 miljarder kubikmeter vattenuttag 2027, vilket är mer än det totala årliga vattenuttaget i 4-6 Danmark eller hälften av Storbritannien."

Med hjälp av Rens forskning kan vi skapa några servettberäkningar för hur Googles SGE kan spela in i dessa förutsägelser.

Låt oss säga att Google bearbetar i genomsnitt 8,5 miljarder sökningar per dag över hela världen. Om vi antar att även en bråkdel av dessa sökningar, säg 10%, använder SGE och genererar AI-drivna svar med i genomsnitt 50 ord per svar, kan vattenförbrukningen bli fenomenal.

Med hjälp av Rens uppskattning på 500 milliliter vatten per 5 till 50 frågor (säg, en enda session på Google SGE) kan vi grovt beräkna att 850 miljoner SGE-drivna sökningar (10% av Googles dagliga sökningar) skulle förbruka cirka 425 miljoner liter vatten dagligen.

Detta är likvärdigt med dagligen vattenförbrukning i en stad med en befolkning på över 2,5 miljoner människor.

I verkligheten kan den faktiska vattenförbrukningen variera beroende på faktorer som effektiviteten i Googles datacenter och den specifika implementeringen och omfattningen av SGE.

Ändå är det mycket rimligt att spekulera i att SGE och andra former av AI-sökning kommer att öka AI:s resursanvändning ytterligare.

Kommer globala AI-upplevelser som SGE att vara hållbara i stor skala? Många faktorer spelar in, men det kommer inte att bli någon dans på rosor.