Anthropic forskare framgångsrikt identifierat miljontals begrepp inom Claude Sonnet, en av deras avancerade LLM:er.

AI-modeller betraktas ofta som svarta lådor, vilket innebär att man inte kan "se" in i dem för att förstå exakt hur de fungerar.

När du ger en LLM en inmatning genererar den ett svar, men resonemanget bakom dess val är inte tydligt.

Din input går in och output kommer ut - och inte ens AI-utvecklarna själva förstår riktigt vad som händer inuti den där "lådan".

Neurala nätverk skapar sina egna interna representationer av information när de mappar inmatningar till utmatningar under dataträningen. Byggstenarna i denna process, som kallas "neuronaktiveringar", representeras av numeriska värden.

Varje begrepp är fördelat på flera neuroner, och varje neuron bidrar till att representera flera begrepp, vilket gör det svårt att mappa begrepp direkt till enskilda neuroner.

Detta är i stort sett analogt med våra mänskliga hjärnor. Precis som våra hjärnor bearbetar sinnesintryck och genererar tankar, beteenden och minnen, är de miljarder, till och med biljoner, processer som ligger bakom dessa funktioner i huvudsak okända för vetenskapen.

Anthropicstudie försöker se in i AI:s svarta låda med en teknik som kallas "dictionary learning".

Detta innebär att komplexa mönster i en AI-modell bryts ned till linjära byggstenar eller "atomer" som är intuitivt begripliga för människor.

Mappning av LLM:er med Dictionary Learning

I oktober 2023, Anthropic tillämpade denna metod på en liten "leksaksspråkmodell" och fann sammanhängande funktioner som motsvarade begrepp som versaler, DNA-sekvenser, efternamn i citat, matematiska substantiv eller funktionsargument i Python-kod.

Den senaste studien skalar upp tekniken så att den fungerar för dagens större AI-språkmodeller, i det här fallet, Anthropic's Claude 3 Sonett.

Här följer en steg-för-stegbeskrivning av hur studien gick till:

Identifiera mönster med hjälp av ordboksinlärning

Anthropic använde ordboksinlärning för att analysera neuronaktiveringar i olika sammanhang och identifiera gemensamma mönster.

Ordboksinlärning grupperar dessa aktiveringar till en mindre uppsättning meningsfulla "funktioner", som representerar begrepp på högre nivå som modellen lärt sig.

Genom att identifiera dessa egenskaper kan forskarna bättre förstå hur modellen bearbetar och representerar information.

Extrahering av funktioner från mellanlagret

Forskarna fokuserade på det mellersta lagret av Claude 3.0 Sonnet, som fungerar som en kritisk punkt i modellens bearbetningspipeline.

Genom att tillämpa ordboksinlärning på detta lager extraheras miljontals funktioner som fångar modellens interna representationer och inlärda begrepp i detta skede.

Genom att extrahera funktioner från det mellersta lagret kan forskare undersöka modellens förståelse av information efter den har bearbetat inmatningen före generera den slutliga produktionen.

Upptäcka olika och abstrakta begrepp

De extraherade funktionerna avslöjade ett expansivt utbud av begrepp som lärts in av Claudefrån konkreta enheter som städer och människor till abstrakta begrepp relaterade till vetenskapliga områden och programmeringssyntax.

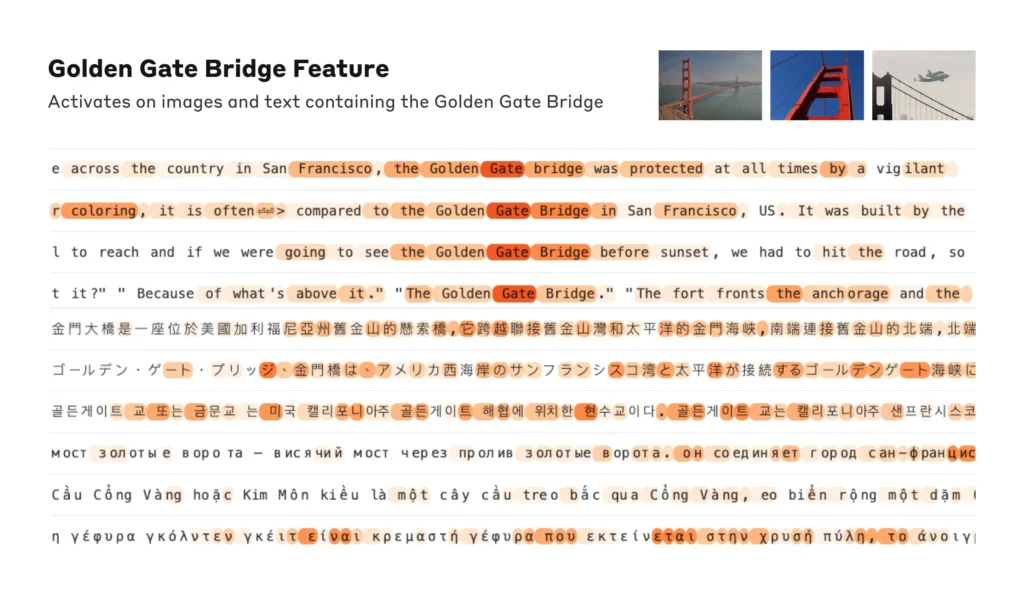

Intressant nog visade det sig att funktionerna var multimodala och svarade på både textuella och visuella intryck, vilket tyder på att modellen kan lära sig och representera begrepp i olika modaliteter.

Dessutom tyder de flerspråkiga funktionerna på att modellen kan förstå begrepp som uttrycks på olika språk.

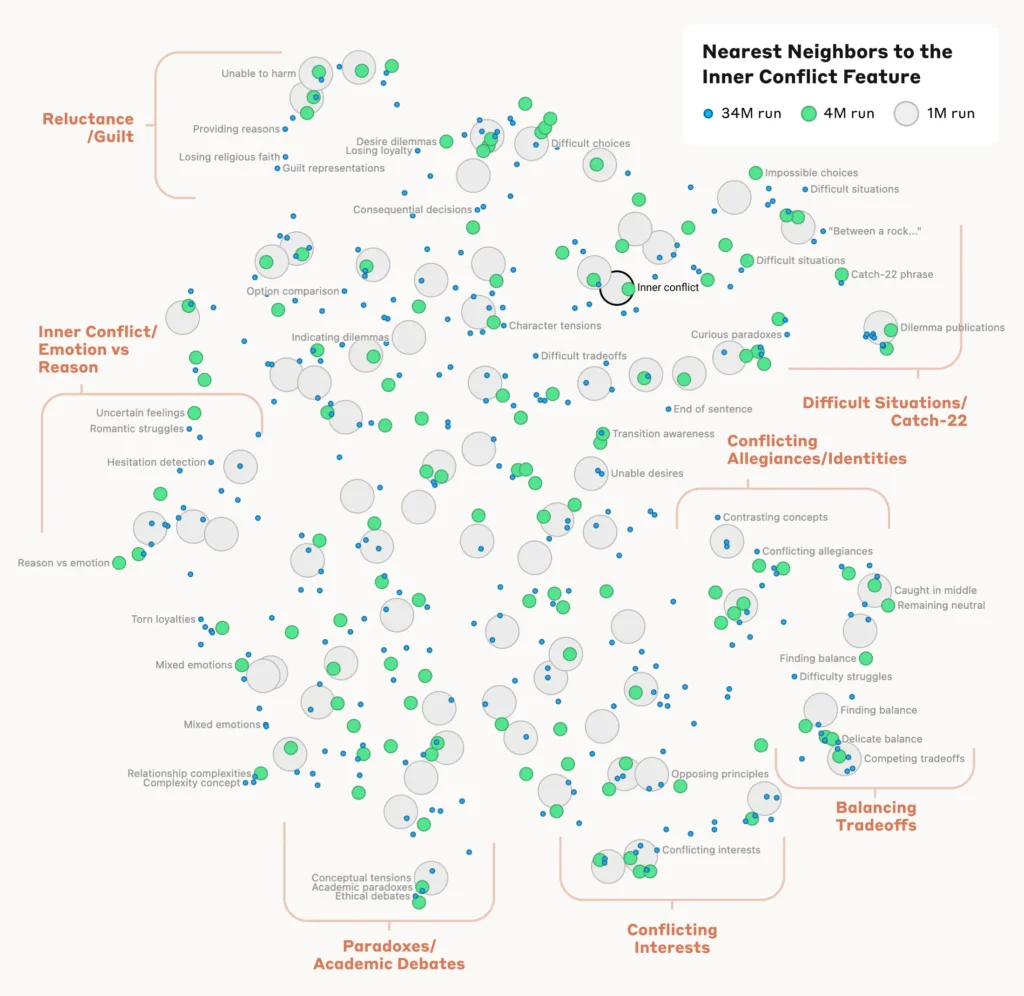

Analys av begreppens organisation

För att förstå hur modellen organiserar och relaterar olika begrepp analyserade forskarna likheten mellan funktioner baserat på deras aktiveringsmönster.

De upptäckte att funktioner som representerar relaterade begrepp tenderade att gruppera sig tillsammans. Till exempel uppvisade funktioner som associerades med städer eller vetenskapliga discipliner högre likhet med varandra än med funktioner som representerade orelaterade koncept.

Detta tyder på att modellens interna organisation av begrepp i viss mån överensstämmer med mänskliga intuitioner om begreppsmässiga relationer.

Verifiering av funktionerna

För att bekräfta att de identifierade funktionerna direkt påverkar modellens beteende och utdata genomförde forskarna experiment med "funktionsstyrning".

Detta innebar att man selektivt förstärkte eller undertryckte aktiveringen av specifika funktioner under modellens bearbetning och observerade hur detta påverkade dess svar.

Genom att manipulera enskilda funktioner kunde forskarna etablera en direkt koppling mellan enskilda funktioner och modellens beteende. Till exempel, genom att förstärka en funktion relaterad till en specifik stad fick modellen att generera stadsbaserade utgångar, även i irrelevanta sammanhang.

Läs hela studien här.

Varför tolkningsbarhet är avgörande för AI-säkerhet

Anthropic's forskning är i grunden relevant för AI-tolkningsbarhet och, i förlängningen, säkerhet.

Att förstå hur LLM:er bearbetar och representerar information hjälper forskare att förstå och minska riskerna. Det lägger grunden för att utveckla mer transparenta och förklarliga AI-system.

Som Anthropic förklarar: "Vi hoppas att vi och andra kan använda dessa upptäckter för att göra modeller säkrare. Det kan till exempel vara möjligt att använda de tekniker som beskrivs här för att övervaka AI-system för vissa farliga beteenden (som att lura användaren), för att styra dem mot önskvärda resultat (debiasing) eller för att helt ta bort vissa farliga ämnen."

Att få en större förståelse för AI:s beteende blir allt viktigare när de blir allestädes närvarande i kritiska beslutsprocesser inom områden som sjukvård, finans och straffrätt. Det hjälper också till att avslöja grundorsaken till förspänning, hallucinationer och andra oönskade eller oförutsägbara beteenden.

Till exempel kan en nyligen genomförd studie från University of Bonn avslöjade hur grafneurala nätverk (GNN) som används för läkemedelsupptäckt är starkt beroende av att återkalla likheter från träningsdata snarare än att verkligen lära sig komplexa nya kemiska interaktioner.

Detta gör det svårt att förstå exakt hur dessa modeller bestämmer nya intressanta föreningar.

Förra året var Den brittiska regeringen förhandlade med stora teknikjättar som OpenAI och DeepMindsom vill ha tillgång till sina AI-systems interna beslutsprocesser.

Reglering som den EU:s AI-lag kommer att pressa AI-företagen att bli mer transparenta, även om affärshemligheter verkar vara säkra på att förbli inlåsta.

Anthropic's forskning ger en glimt av vad som finns inuti lådan genom att "mappa" information över modellen.

Sanningen är dock att dessa modeller är så omfattande att de genom Anthropic"Vi tror att det är ganska troligt att vi är storleksordningar korta, och att om vi ville få alla funktioner - i alla lager! - skulle vi behöva använda mycket mer databehandling än den totala databehandling som behövs för att träna de underliggande modellerna."

Det är en intressant poäng - att omvänt konstruera en modell är mer beräkningsmässigt komplext än att konstruera modellen i första hand.

Det påminner om enormt dyra neurovetenskapliga projekt som Human Brain Project (HBP)som satsade miljarder på att kartlägga våra egna mänskliga hjärnor, men misslyckades i slutändan.

Underskatta aldrig hur mycket som finns i den svarta lådan.