Googles forskare utvecklade en teknik som kallas Infini-attention, som gör det möjligt för LLM:er att hantera oändligt långa texter utan att öka beräknings- och minneskraven.

Transformatorarkitekturen i en LLM är det som gör att den kan uppmärksamma alla tokens i en prompt. De komplexa punktprodukt- och matrismultiplikationerna som den utför är kvadratiska i komplexitet.

Det innebär att om du fördubblar antalet tokens i din prompt krävs det fyra gånger mer minne och processorkraft. Det är därför det är så utmanande att göra LLM:er med stora kontextfönster utan att minnes- och beräkningskraven skjuter i höjden.

I en "vanlig" LLM går informationen i början av promptens innehåll förlorad när prompten blir större än kontextfönstret. Googles forskningsrapport förklarar hur Infini-attention kan lagra data utanför kontextfönstret.

Google presenterar Leave No Context Behind: Effektiva oändliga kontexttransformatorer med infini-uppmärksamhet

1B-modell som finjusterades på upp till 5K sekvenslängdsinstanser löser problemet med 1M längdhttps://t.co/zyHMt3inhi pic.twitter.com/ySYEMET9Ef

- Aran Komatsuzaki (@arankomatsuzaki) 11 april 2024

Hur fungerar Infini-attention?

Infini-attention kombinerar komprimerande minnestekniker med modifierade uppmärksamhetsmekanismer så att relevant äldre information inte går förlorad.

När inmatningsuppmaningen blir större än modellens kontextlängd lagrar det komprimerande minnet informationen i ett komprimerat format i stället för att kassera den.

Detta gör att äldre, mindre omedelbart relevant information kan lagras utan att minnes- och beräkningskraven växer i oändlighet i takt med att inmatningen växer.

I stället för att försöka hålla kvar all äldre information väger Infini-attentions komprimerande minne samman och sammanfattar information som bedöms vara relevant och värd att hålla kvar.

Infini-attention utgår från en "vanilj"-uppmärksamhetsmekanism men återanvänder KV-tillstånden (key value) från varje efterföljande segment i modellen i stället för att förkasta dem.

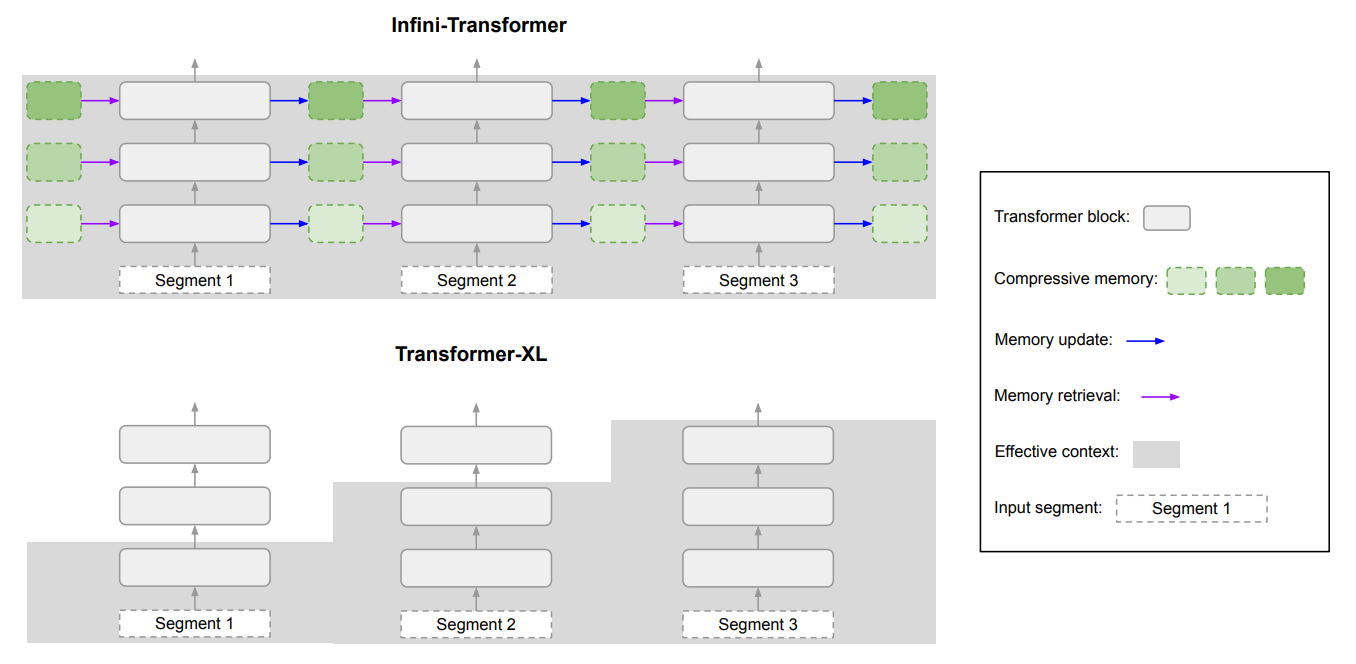

Här är ett diagram som visar skillnaden mellan Infini-attention och en annan modell med utökad kontext, Transformer XL.

Resultatet är en LLM som ger lokal uppmärksamhet åt nya indata, men som också har kontinuerligt destillerad komprimerad historisk data som den kan ge långsiktig uppmärksamhet.

I artikeln konstateras att "denna subtila men kritiska modifiering av uppmärksamhetsskiktet gör det möjligt för LLM att bearbeta oändligt långa sammanhang med begränsade minnes- och beräkningsresurser".

Hur bra är den?

Google genomförde benchmarkingtester med mindre Infini-attention-modeller med 1B- och 8B-parametrar. Dessa jämfördes med andra modeller med utökat sammanhang som Transformer-XL och Memorizing Transformers.

Infini-Transformer uppnådde betydligt lägre perplexitetspoäng än de andra modellerna vid bearbetning av innehåll med långa kontexter. En lägre perplexitetspoäng innebär att modellen är mer säker på sina förutsägelser av utdata.

I "passkey retrieval"-testerna hittade Infini-attention-modellerna konsekvent det slumpmässiga talet som var gömt i text med upp till 1 miljon symboler.

Andra modeller klarar ofta av att hämta nyckeln mot slutet av inmatningen men har svårt att hitta den i mitten eller början av ett långt innehåll. Infini-attention hade inga problem med detta test.

Benchmarktesterna är mycket tekniska, men den korta historien är att Infini-attention överträffade baslinjemodellerna när det gäller att sammanfatta och hantera långa sekvenser samtidigt som sammanhanget bevarades under längre perioder.

Betecknande nog behöll den denna överlägsna lagringsförmåga samtidigt som den krävde 114 gånger mindre minne.

Benchmarkresultaten övertygar forskarna om att Infini-attention kan skalas upp för att hantera extremt långa indatasekvenser med begränsade minnes- och beräkningsresurser.

Infini-attentions "plug-and-play"-karaktär innebär att den kan användas för kontinuerlig förträning och finjustering av befintliga Transformer-modeller. Detta skulle effektivt kunna utöka deras kontextfönster utan att kräva fullständig omskolning av modellen.

Kontextfönstren kommer att fortsätta växa, men den här metoden visar att ett effektivt minne kan vara en bättre lösning än ett stort bibliotek.