Den amerikanska armén försöker integrera AI-chattbottar i sin strategiska planering, om än inom ramen för en krigsspelssimulering baserad på det populära tv-spelet Starcraft II.

Detta studiesom leds av US Army Research Laboratory, analyserar OpenAI:s strategier för GPT-4 Turbo och GPT-4 Vision på slagfältet.

Detta är en del av OpenAI:s samarbete med försvarsdepartementet (DOD) efter dess upprättande av arbetsgrupp för generativ AI förra året.

AI:s användning på slagfältet är hett omdebatterad, med en nyligen genomförd liknande studie om AI-krigsspel och konstaterar att LLM som GPT-3.5 och GPT-4 tenderar att eskalera diplomatiska taktiker, vilket ibland leder till kärnvapenkrig.

I denna nya forskning från US Army användes Starcraft II för att simulera ett scenario på slagfältet med ett begränsat antal militära enheter.

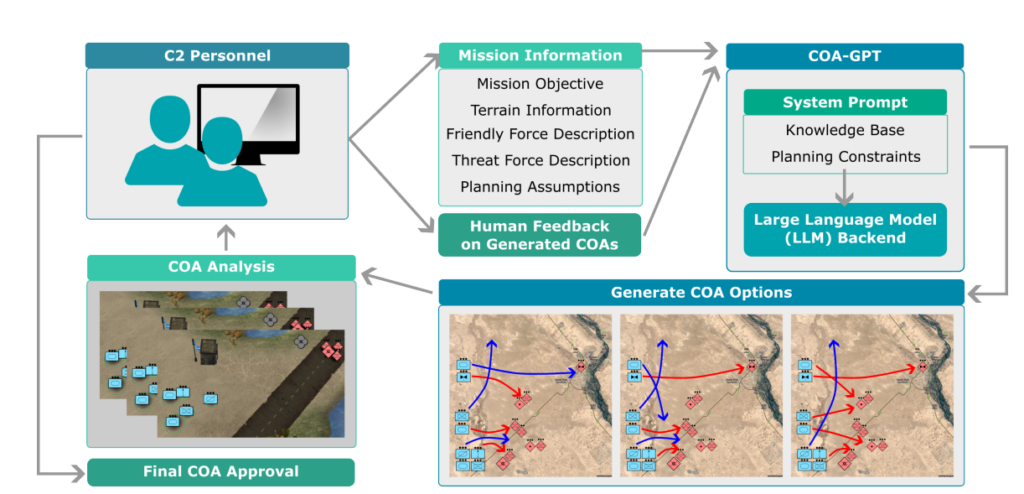

Forskarna döpte systemet till "COA-GPT" - där COA står för den militära termen "Courses of Action", som i huvudsak beskriver militär taktik.

COA-GPT antog rollen som en militär befälhavares assistent, med uppgift att utforma strategier för att utplåna fiendens styrkor och erövra strategiska punkter.

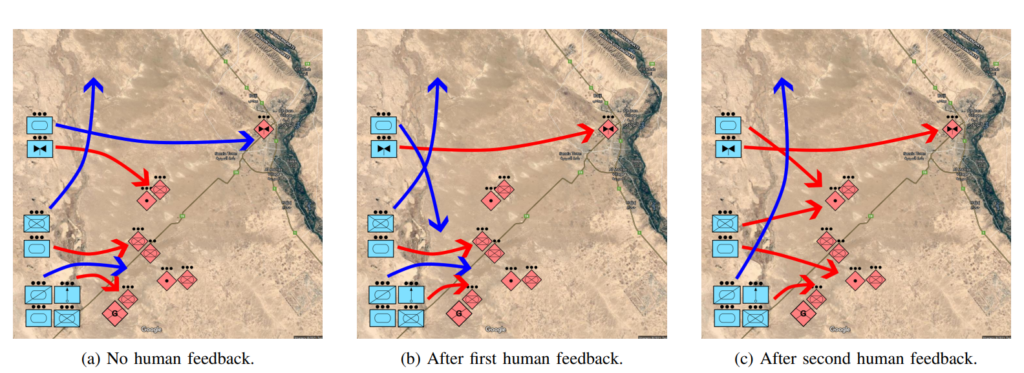

Forskarna konstaterar att traditionell COA är ökänt långsam och arbetsintensiv. COA-GPT fattar beslut på några sekunder samtidigt som mänsklig feedback integreras i AI:ns inlärningsprocess.

COA-GPT överträffar andra metoder, men det finns en kostnad

COA-GPT visade överlägsen prestanda jämfört med befintliga metoder och överträffade befintliga metoder när det gällde att generera strategiska COA:er, och kunde anpassa sig till feedback i realtid.

Det fanns dock brister. Framför allt drabbades COA-GPT av fler förluster när uppdragsmålen uppnåddes.

I studien konstateras: "Vi observerar att COA-GPT och COA-GPT-V, även när de förbättras med mänsklig feedback, uppvisar högre förluster för vänstyrkorna jämfört med andra baslinjer."

Avskräcker detta forskarna? Till synes inte.

I studien står det: "Sammanfattningsvis representerar COA-GPT en transformativ metod för militära C2-operationer, vilket underlättar snabbare och mer flexibelt beslutsfattande och upprätthåller en strategisk fördel i modern krigföring."

Det är oroväckande att ett AI-system som orsakade fler onödiga dödsfall än baslinjen definieras som en "transformativ metod".

Försvarsdepartementet har redan identifierat andra möjligheter att utforska AI:s militära användningsområden, men det finns fortfarande frågetecken kring teknikens beredskap och etiska konsekvenser.

Vem är till exempel ansvarig när militära AI-tillämpningar går fel? Utvecklarna? Den ansvariga personen? Eller någon längre ner i kedjan?

AI-krigföringssystem används redan i konflikterna i Ukraina och Palestina-Israel, men dessa frågor är fortfarande i stort sett oprövade.

Låt oss hoppas att det förblir så.