OpenAI meddelade att de kommer att använda C2PA-standarden för att lägga till metadata till bilder som genereras med DALL-E 3.

Tillkännagivandet kommer samtidigt som företag fortsätter att leta efter sätt att hindra att deras generativa AI-produkter används för att sprida desinformation.

C2PA är en öppen teknisk standard som lägger till metadata till en bild, inklusive dess ursprung, redigeringshistorik och annan information. OpenAI säger att bilder som genereras med DALL-E 3 direkt, eller via ChatGPT eller dess API, nu kommer att innehålla C2PA-data. Mobilanvändare kommer att se detta implementerat senast den 12 februari.

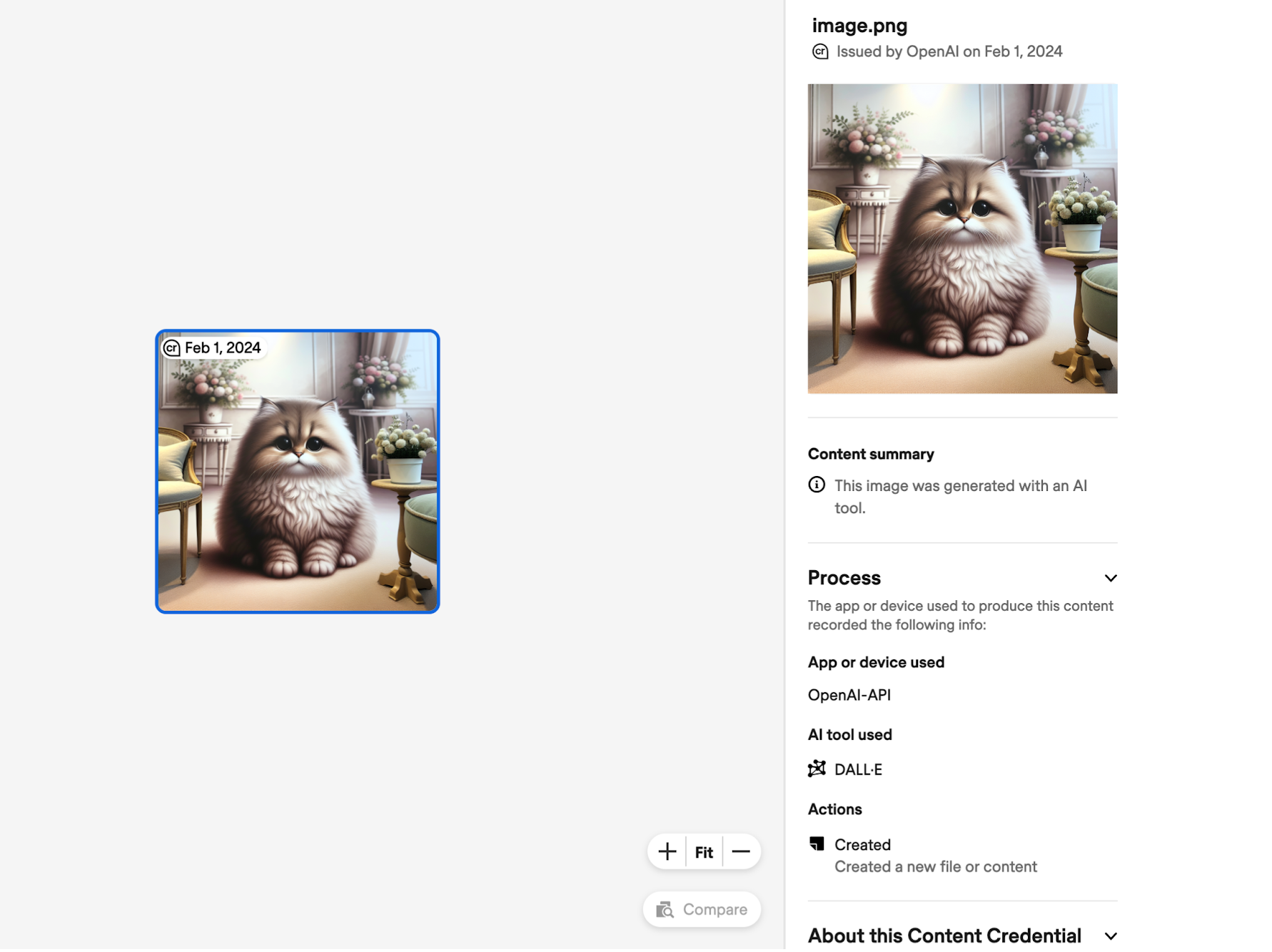

En bild som har C2PA-metadata tillagd kan laddas upp till webbplatser som Verifiering av innehållsreferenser för att kontrollera bildens ursprung. Här är ett exempel på informationen C2PA avslöjar om en bild som gjorts med DALL-E via API: et.

Sociala medieplattformar kan också använda dessa data för att flagga och märka bilder som AI-genererade. Meta tillkännagav nyligen att det skulle vara att göra en större insats för att göra det.

Tillägget av C2PA-data ökar filstorleken med exempel på uppskattningar från OpenAI som anges som:

- 3,1 MB → 3,2 MB för PNG via API (3% ökning)

- 287k → 302k för WebP via API (ökning med 5%)

- 287 000 → 381 000 för WebP genom ChatGPT (ökning med 32%)

OpenAI erkänner att "C2PA inte är en silverkula för att ta itu med frågor om proveniens." Metadata kan lätt tas bort, ofta oavsiktligt.

Om du tar en skärmdump av bilden behålls inte C2PA-data. Även konvertering av en bild från PNG till JPG kommer att förstöra de flesta metadata. De flesta sociala medieplattformar tar bort metadata från bilder när de laddas upp.

OpenAI säger att genom att lägga till C2PA i DALL-E-bilder hoppas man kunna uppmuntra "användare att inse att dessa signaler är viktiga för att öka tillförlitligheten i digital information".

Det kan göra det i begränsad utsträckning, men det faktum att C2PA är så lätt att ta bort hjälper inte mycket när en person avsiktligt vill använda en bild för att vara vilseledande. Om något kan det bara sakta ner deepfakers lite.

Googles digitala vattenstämpel SynthID verkar vara en mycket säkrare lösning, men OpenAI kommer troligen inte att använda ett verktyg som skapats av en konkurrent.