IBM Security publicerade forskning på sin Security Intelligence-blogg för att visa hur AI-röstkloner kan injiceras i en livekonversation utan att deltagarna inser det.

I takt med att tekniken för röstkloning förbättras har vi sett falska robotsamtal som utger sig för att vara Joe Biden och bluffsamtal som utger sig för att vara en nödställd familjemedlem som ber om pengar.

Ljudet i dessa samtal låter bra, men bluffsamtalet är ofta lätt att avstyra genom att ställa några personliga frågor för att identifiera den som ringer som en bedragare.

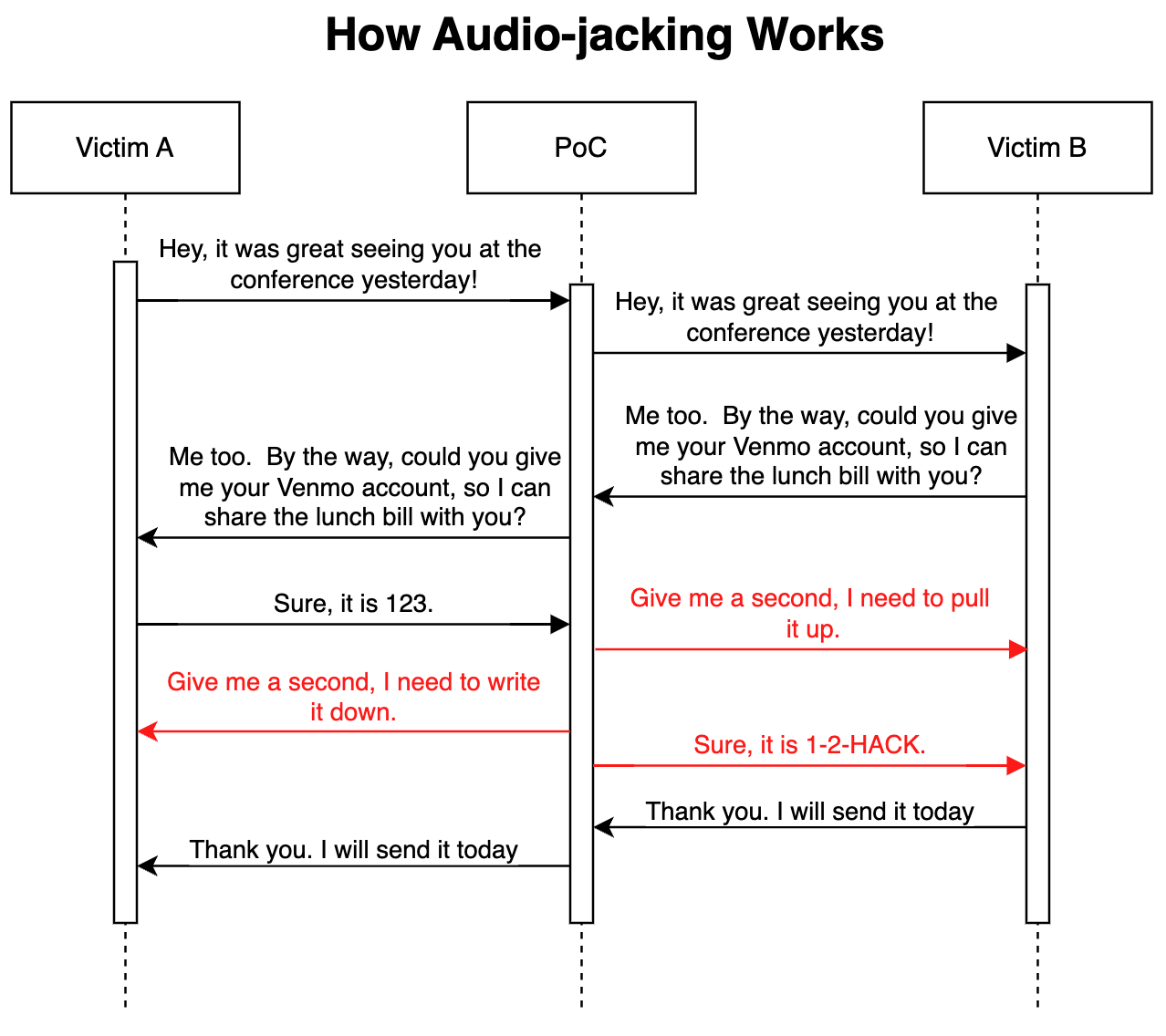

I sin avancerade "proof of concept"-attack har IBM:s säkerhetsforskare visade att en LLM i kombination med röstkloning kunde fungera som en man i mitten för att kapa endast en viktig del av ett samtal, snarare än hela samtalet.

Så här fungerar det

Attacken kan ske via skadlig kod som installeras på offrens telefoner eller via en skadlig VoIP-tjänst (Voice over IP). Väl på plats övervakar programmet konversationen och behöver bara 3 sekunders ljud för att kunna klona båda rösterna.

En tal-till-text-generator gör det möjligt för LLM att övervaka samtalet för att förstå sammanhanget i diskussionen. Programmet instruerades att vidarebefordra samtalsljudet som det är men att ändra samtalsljudet när en person begär bankkontouppgifter.

När personen svarar med att ange sina bankkontouppgifter ändrar röstklonen ljudet så att det i stället innehåller bedragarens bankuppgifter. Fördröjningen i ljudet under modifieringen täcks med lite fyllnadstal.

Här följer en illustration av hur PoC-attacken (Proof of Concept) fungerar.

Eftersom LLM vidarebefordrar oförändrat ljud under större delen av samtalet är det verkligen svårt att veta att hotet är i spel.

Forskarna sa att samma attack "också skulle kunna ändra medicinsk information, såsom blodgrupp och allergier i konversationer; den skulle kunna beordra en analytiker att sälja eller köpa en aktie; den skulle kunna instruera en pilot att omdirigera."

Forskarna sa att "att bygga denna PoC var förvånansvärt och skrämmande lätt." I takt med att intonationen och känslan hos röstkloner förbättras och bättre hårdvara minskar latensen, skulle den här typen av attack vara mycket svår att upptäcka eller förhindra.

Forskarna utvidgar konceptet till att omfatta mer än att kapa en ljudkonversation och säger att med "befintliga modeller som kan konvertera text till video är det teoretiskt möjligt att fånga upp en livestreamad video, t.ex. nyheter på TV, och ersätta originalinnehållet med ett manipulerat innehåll".

Det kan vara säkrare att bara tro på dina ögon och öron när du fysiskt befinner dig i närheten av den person du talar med.