Kan människor lära sig att på ett tillförlitligt sätt upptäcka AI-genererade förfalskningar? Hur påverkar de oss på en kognitiv nivå?

OpenAI:s Sora-system presenterade nyligen en ny våg av syntetiska AI-drivna medier. Det kommer förmodligen inte att dröja länge innan någon form av realistiska medier - ljud, video eller bild - kan genereras med hjälp av anvisningar på bara några sekunder.

I takt med att AI-systemen blir allt mer kapabla kommer vi att behöva utveckla nya färdigheter i kritiskt tänkande för att skilja sanning från fiktion.

Hittills har Big Techs ansträngningar för att bromsa eller stoppa deep fakes inte lett till mycket annat än känslor, inte på grund av bristande övertygelse utan för att AI-innehållet är så realistiskt.

Det gör det svårt att upptäcka på pixelnivåmedan andra signaler, som metadata och vattenstämplar, har sina brister.

Även om AI-genererat innehåll skulle kunna upptäckas i stor skala är det dessutom svårt att skilja autentiskt, ändamålsenligt innehåll från innehåll som är avsett att sprida felaktig information.

Att skicka innehåll till mänskliga granskare och använda "community notes" (information som bifogas innehåll, ofta sett på X) är en möjlig lösning. Detta innebär dock ibland en subjektiv tolkning och risk för felaktig märkning.

Till exempel, i Israel-Palestina-konfliktenVi har bevittnat störande bilder som betecknats som äkta när de varit falska och vice versa.

När en riktig bild stämplas som falsk kan detta skapa en 'lögnens utdelning,' där någon eller något kan avfärda sanningen som falsk.

Så i avsaknad av tekniska metoder för att stoppa djupa förfalskningar på tekniksidan, vad kan vi göra åt det?

Och i vilken utsträckning påverkar deep fakes vårt beslutsfattande och vår psykologi?

När människor till exempel exponeras för falska politiska bilder, har det då en påtaglig inverkan på deras röstbeteende?

Låt oss ta en titt på ett par studier som utvärderar just detta.

Påverkar djupa förfalskningar våra åsikter och psykologiska tillstånd?

En studie från 2020, "Deepfakes och desinformation: Exploring the Impact of Synthetic Political Video on Deception, Uncertainty, and Trust in News", undersöktes hur djupt falska videor påverkar allmänhetens uppfattning, särskilt när det gäller förtroendet för nyheter som delas på sociala medier.

Forskningen omfattade ett storskaligt experiment med 2.005 deltagare från Storbritannien, utformat för att mäta reaktionerna på olika typer av djupt falska videor av USA:s tidigare president Barack Obama.

Deltagarna tilldelades slumpmässigt att se en av tre videor:

- Ett 4-sekunders klipp som visar Obama göra ett överraskande uttalande utan sammanhang.

- Ett 26 sekunder långt klipp som innehöll vissa ledtrådar om videons artificiella natur men som främst var vilseledande.

- En fullständig video med en "pedagogisk avslöjande" där den djupa fejkens artificiella natur uttryckligen avslöjades, med Jordan Peele som förklarar tekniken bakom den djupa fejkningen.

Viktiga resultat

Studien undersökte tre nyckelområden:

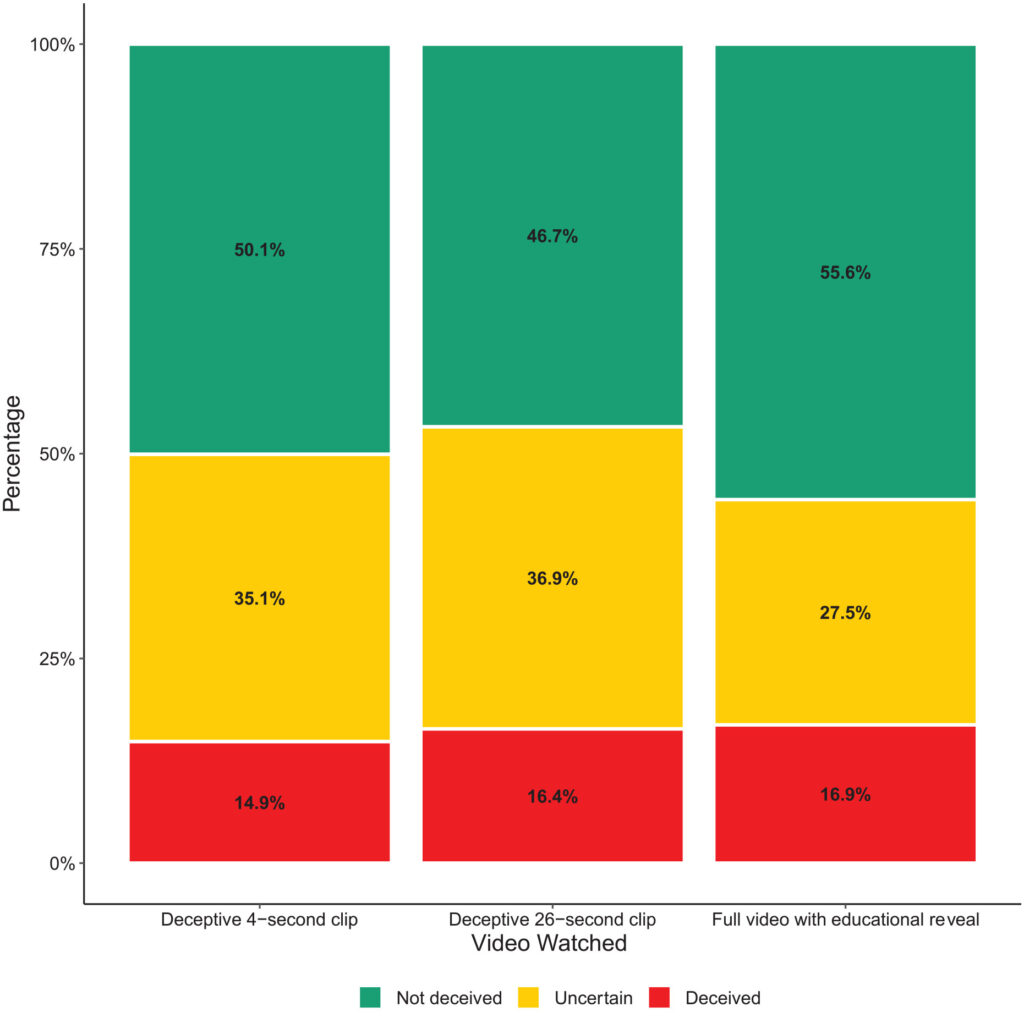

- Bedrägeri: Studien fann minimala bevis för att deltagarna trodde på de falska påståendena i de djupa förfalskningarna. Andelen deltagare som vilseleddes av de djupa förfalskningarna var relativt låg i alla behandlingsgrupper.

- Osäkerhet: Ett viktigt resultat var dock ökad osäkerhet bland tittarna, särskilt de som såg de kortare, bedrägliga klippen. Cirka 35,1% av deltagarna som såg 4-sekundersklippet och 36,9% som såg 26-sekundersklippet rapporterade att de kände sig osäkra på videons äkthet. Däremot var det bara 27,5% av dem som såg hela utbildningsvideon som kände på detta sätt.

- Förtroende för nyheter: Denna osäkerhet påverkade deltagarnas förtroende för nyheter på sociala medier negativt. De som exponerades för de vilseledande djupa förfalskningarna visade lägre förtroendenivåer än de som såg det pedagogiska avslöjandet.

Detta visar att exponering för djupa falska bilder orsakar osäkerhet på längre sikt.

Med tiden kan falska bilder försvaga tilltron till all information, inklusive sanningen.

Liknande resultat visades av en mer aktuell studie 2023"Face/Off: Changing the face of movies with deepfake", som också drog slutsatsen att falska bilder har långsiktiga effekter.

Människor "minns" falskt innehåll efter exponering

Face/Off-studien, som genomfördes med 436 deltagare, undersökte hur djupt förfalskningar kan påverka våra minnen av filmer.

Deltagarna deltog i en online-enkät som utformades för att undersöka deras uppfattningar och minnen av både verkliga och imaginära nyinspelningar av filmer.

Undersökningens kärna bestod i att deltagarna presenterades för sex filmtitlar, som innehöll en blandning av fyra verkliga nyinspelningar och två fiktiva.

Mfilmerna randomiserades och presenterades i två format: Hälften av filmerna introducerades genom korta textbeskrivningar, och den andra hälften parades ihop med korta videoklipp.

Fiktiva nyinspelningar av filmer bestod av versioner av "The Shining", "The Matrix", "Indiana Jones" och "Captain Marvel", kompletta med beskrivningar som falskeligen påstod att kända skådespelare medverkade i dessa obefintliga nyinspelningar.

Deltagarna fick till exempel höra talas om en falsk nyinspelning av "The Shining" med Brad Pitt och Angelina Jolie i huvudrollerna, som aldrig ägt rum.

De riktiga nyinspelningarna som presenterades i enkäten, som "Charlie & chokladfabriken" och "Total Recall", beskrevs däremot korrekt och åtföljdes av äkta filmklipp. Denna blandning av äkta och falska remakes var avsedd att undersöka hur deltagarna skiljer mellan faktamässigt och fabricerat innehåll.

Deltagarna tillfrågades om sin kännedom om varje film och om de hade sett originalfilmen eller nyinspelningen eller hade någon tidigare kunskap om dem.

Viktiga resultat

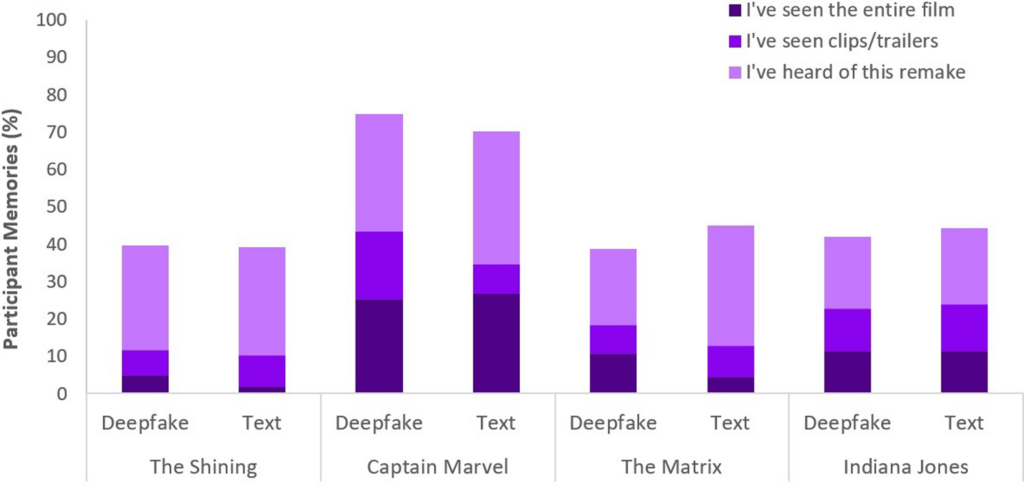

- Fenomenet med falska minnen: Ett viktigt resultat av studien är avslöjandet att nästan hälften av deltagarna (49%) utvecklade falska minnen av att titta på fiktiva remakes, till exempel att föreställa sig Will Smith som Neo i "The Matrix". Detta illustrerar den bestående effekt som suggestiva medier, oavsett om det är djupa falska videor eller textbeskrivningar, kan ha på vårt minne.

- Specifikt"Captain Marvel" toppade listan, med 73% av deltagarna som mindes AI-remaken, följt av "Indiana Jones" på 43%, "The Matrix" på 42% och "The Shining" på 40%. Bland dem som felaktigt trodde på dessa nyinspelningar trodde 41% att nyinspelningen av "Captain Marvel" var överlägsen originalet.

- Jämförande påverkan av djupa förfalskningar och text: En annan upptäckt är att deep fakes, trots sin visuella och auditiva realism, inte var mer effektiva när det gällde att förändra deltagarnas minnen än textuella beskrivningar av samma fiktiva innehåll. Detta tyder på att formatet på felinformationen - visuell eller textuell - inte nämnvärt förändrar dess inverkan på minnesförvrängning i samband med film.

Fenomenet med falska minnen som denna studie handlar om är väl utforskat. Det visar hur människor effektivt konstruerar eller rekonstruerar falska minnen som vi är säkra på är verkliga när de inte är det.

Alla är mottagliga för att konstruera falska minnen, och deep-förfalskningar verkar aktivera detta beteende, vilket innebär att visning av visst innehåll kan ändra vår uppfattning, även när vi medvetet förstår att det inte är äkta.

I båda studierna hade deep fakes påtagliga, potentiellt långsiktiga effekter. Effekten kan smyga sig på oss och ackumuleras över tid.

Vi måste också komma ihåg att falskt innehåll sprids till miljontals människor, så små förändringar i uppfattningen påverkar hela den globala befolkningen.

Vad gör vi åt djupa förfalskningar?

Att gå i krig mot djupa förfalskningar innebär att bekämpa den mänskliga hjärnan.

Medan ökningen av falska nyheter och felaktig information har tvingat människor att utveckla en ny mediekompetens under de senaste åren, kommer AI-genererade syntetiska medier att kräva en ny nivå av anpassning.

Vi har ställts inför sådana brytpunkter tidigare, från fotografering till CGI-specialeffekter, men AI kommer att kräva en utveckling av våra kritiska sinnen.

Idag måste vi gå längre än att bara tro våra ögon och förlita oss mer på att analysera källor och kontextuella ledtrådar.

Det är viktigt att ifrågasätta innehållets incitament eller partiskhet. Stämmer det överens med kända fakta eller motsäger det dem? Finns det bekräftande bevis från andra trovärdiga källor?

En annan viktig aspekt är att fastställa rättsliga standarder för att identifiera falska eller manipulerade medier och hålla upphovsmännen ansvariga.

Den US DEFIANCE-lagenStorbritannien, UK Online Safety Act, och motsvarande myndigheter över hela världen håller på att införa rättsliga förfaranden för att hantera djupa förfalskningar. Hur effektiva de kommer att vara återstår att se.

Strategier för att avslöja sanningen

Låt oss avsluta med fem strategier för att identifiera och förhöra potentiella djupa förfalskningar.

Även om ingen enskild strategi är felfri är det bästa vi kan göra kollektivt för att minimera effekterna av AI-felinformation att främja kritiska tankesätt.

- Verifiering av källa: Att undersöka informationens trovärdighet och ursprung är ett grundläggande steg. Autentiskt innehåll kommer ofta från välrenommerade källor som har visat sig vara tillförlitliga.

- Teknisk analys: Trots sin sofistikering kan djupa förfalskningar uppvisa subtila brister, till exempel oregelbundna ansiktsuttryck eller inkonsekvent belysning. Granska innehållet och överväg om det är digitalt ändrat.

- Korsreferenser: Att verifiera information mot flera betrodda källor kan ge ett bredare perspektiv och hjälpa till att bekräfta innehållets äkthet.

- Digital läskunnighet: Att förstå AI-teknikens möjligheter och begränsningar är avgörande för att kunna bedöma innehållet. Utbildning i digital kompetens i skolor och medier, inklusive hur AI fungerar och dess etiska konsekvenser, kommer att vara avgörande.

- Försiktigt samspel: Att interagera med AI-genererad felaktig information förstärker dess effekter. Var försiktig när du gillar, delar eller lägger upp innehåll som du är tveksam till.

I takt med att deep fakes utvecklas, utvecklas också de tekniker som krävs för att upptäcka och mildra skadan. År 2024 kommer att bli avslöjande, eftersom omkring hälften av världens befolkning kommer att rösta i viktiga val.

Det finns bevis för att djupa förfalskningar kan påverka vår uppfattning, så det är långt ifrån orimligt att tro att felaktig AI-information skulle kunna påverka utfallet i väsentlig grad.

När vi går vidare kommer etiska AI-metoder, digital kompetens, reglering och kritiskt engagemang att vara avgörande för att forma en framtid där tekniken förstärker, snarare än döljer, kärnan i sanningen.