En grupp Chicago-baserade utvecklare har utrustat konstnärer med Nightshade, en metod för att slå tillbaka mot oetiska datapraktiker.

Nightshade är ett sofistikerat verktyg som är utformat för att skydda digitala konstverk från obehörig användning i AI-träning genom att introducera "giftiga" prover.

Dessa förändringar är omärkliga för det mänskliga ögat men stör en AI:s inlärningsprocess och leder till felaktiga associationer och svar.

Den forskare skriver"Ett mänskligt öga kan se en skuggad bild av en ko på ett grönt fält i stort sett oförändrad, men en AI-modell kan se en stor läderväska som ligger i gräset."

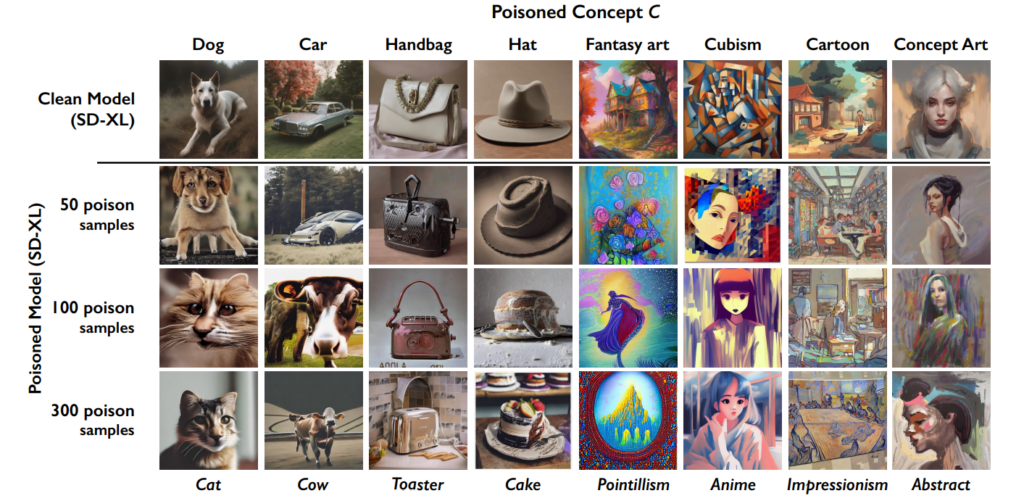

Effekten ackumuleras, så ju fler "förgiftade" bilder som hamnar i ett dataset, desto mer försämras modellens prestanda.

Detta verktyg kommer i tillägg till University of Chicagos tidigare skapelse, Glaze, som också hjälper konstnärer att bekämpa dataskrapning. "Glaze kan ändra saker som färger och penseldrag och presentera en annan konstnärlig stil än vad som faktiskt finns där", förklarar utvecklarna.

Nightshade avviker dock från Glaze i tillvägagångssätt. "Medan Glaze var ett defensivt verktyg är Nightshade utformat för att vara ett offensivt verktyg", säger teamet.

Jag är väldigt glad över att kunna berätta att "Artifact" har blivit Glazed och Nightshaded av @TheGlazeProject och vilket perfekt verk för det också. Det här är en målning om generativ AI som kannibaliserar den autentiska rösten hos mänskliga kreatörer. När den här bilden skrapas fram för träning, ja... pic.twitter.com/0VNFIyabc2

- Kelly McKernan (@Kelly_McKernan) 14 januari 2024

Hur Nightshade fungerar i fem steg

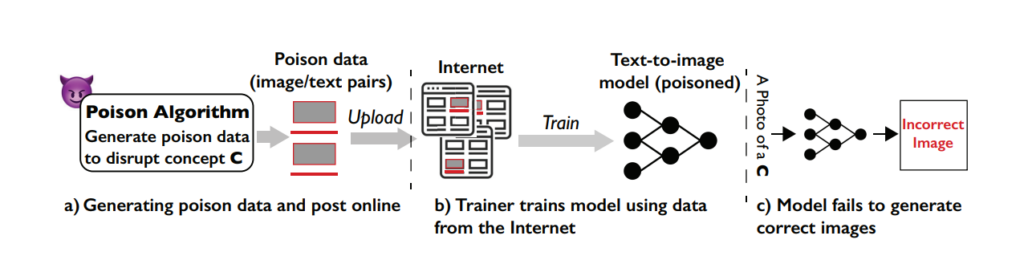

Nightshade är ett smart verktyg som använder de maskininlärningsfunktioner som ingår i modellutbildningen mot själva systemet, vilket förgiftar inlärningsprocessen och leder till sämre resultat för olika modeller.

Förståelse för sårbarheten

Nightshade-attacken utnyttjar en specifik svaghet i generativa modeller för text-till-bild. Dessa AI-modeller tränas på stora datamängder med bilder och motsvarande textbeskrivningar.

Teamet från University of Chicago upptäckte dock att mängden träningsdata är ganska begränsad för vissa specifika frågor eller ämnen. Denna begränsade datapool för specifika uppmaningar gör dessa modeller sårbara för riktade dataförgiftningsattacker.

Konceptet bakom Nightshade

Nightshade är en sofistikerad metod som är utformad för att utföra vad som kallas en prompt-specifik förgiftningsattack.

Enkelt uttryckt är det som att införa ett litet, noggrant utformat fel i AI:ns inlärningsprocess, vilket leder till betydande och riktade misstag när AI:n genererar bilder baserat på vissa uppmaningar.

Den viktigaste egenskapen hos Nightshade är dess förmåga att producera "förgiftade" prover som ser normala ut för mänskliga ögon men som är radikalt annorlunda i hur AI uppfattar och lär sig av dem.

Skapa giftprov

För att utföra en Nightshade-attack genererar forskarna först vad de kallar "ankarbilder". Dessa är bilder av ett koncept som inte är relaterat till det faktiska målet för attacken.

Om målbegreppet till exempel är "hund" kan ankarbilderna vara av "katter". Dessa ankarbilder genereras av en AI-modell som användarna kör på sin dator.

Därefter hittar forskarna verkliga bilder av målkonceptet (som hundar) och ändrar dem subtilt för att anpassa dem till funktionerna i ankarbilderna i AI:s uppfattning.

För en människa ser de här modifierade bilderna fortfarande ut som hundar, men för AI:n liknar de katter. Även om det kan vara svårt att förstå, är det viktigt att komma ihåg att de former som skapar bilder alltid är fundamentalt lika.

Förändringarna kallas adversarial perturbations. De är noggrant uträknade för att flytta bildens representation i AI:ns funktionsrymd från den region som förknippas med katter till den som förknippas med hundar.

Hur attacken påverkar AI-modeller

När en generativ AI-modell tränas på dessa förgiftade prover börjar den associera funktionerna i det orelaterade konceptet (katter) med målkonceptet (hundar).

När AI-modellen uppmanas att generera bilder av hundar kan den därför producera bilder av katter i stället. Detta beror på att modellens förståelse av vad som utgör en "hund" har förvrängts av de förgiftade uppgifterna.

Även om detta inte helt "förstör" en AI-modell, gör det den mindre effektiv och mer oförutsägbar, vilket verkligen kan försämra användbarheten.

AI-företag kommer sannolikt att slå tillbaka mot Nightshade och liknande tekniker, men det kommer att kräva tid och ansträngning.

Påverkan

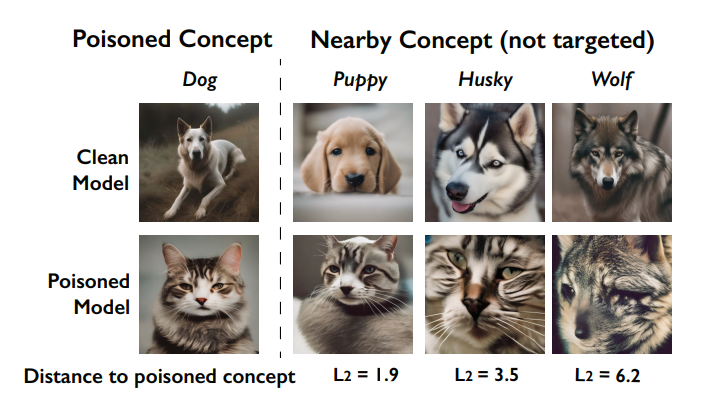

En viktig effekt av Nightshade-attacken är dess "genomblödningseffekt". Det innebär att förgiftningen av ett koncept kan påverka relaterade koncept.

Om man till exempel förgiftar begreppet "hundar" kan det också påverka hur modellen genererar bilder av relaterade djur som "vargar" eller "rävar".

skadas av förgiftningen (kallas genomblödningseffekten). Källan är: University of Chicago via ArXiv

När flera begrepp förgiftas i en modell kan det dessutom bryta modellens förmåga att generera sammanhängande bilder för ett brett spektrum av uppmaningar.

Hur artister kan använda Nightshade

Nightshade är ett verktyg som du laddar ner och använder själv, men det är ganska resurskrävande och kräver en kompatibel Nvidia GPU med minst 4G minne.

Den här processen kan förenklas i framtiden, eller så kan det finnas molntjänster där du helt enkelt kan ladda upp dina bilder så att de blir Nightshade'd åt dig.

Så här använder du Nightshade:

- Välj ditt konstverk: Du kan antingen dra en enskild bild till bildplatshållaren eller välja flera bilder med hjälp av knappen "Select..." (Välj...).

- Justera parametrarna: Intensity bestämmer styrkan på Nightshades effekt. En högre intensitet leder till en kraftigare störning men kan orsaka märkbara förändringar i ditt konstverk. Renderingskvalitet anger beräkningstiden för att hitta den optimala giftnivån. Högre kvalitet ger starkare gift men kräver mer tid. Om du har en GPU går den här processen snabbare.

- Välj utdatakatalog: Välj var du vill att Nightshaded-bilderna ska sparas.

- Välj gifttagg: Nightshade fungerar genom att vilseleda AI om vissa begrepp i din bild. Den kan t.ex. ändra bilder som taggats som "bil" så att de uppfattas som "ko" av AI-modeller. Nightshade kommer att föreslå en tagg baserad på sin innehållsanalys när du väljer din bild. Se till att taggen korrekt återspeglar nyckelbegreppet i din bild och justera vid behov. Effektiviteten hos Nightshade ökar när din bild associeras med den här taggen genom alt-text, bildtexter eller närliggande text.

- Kör Nightshade: När du har slutfört dina inställningar och bekräftat bildtaggen startar du processen genom att trycka på "Run"-knappen. De ändrade bilderna kommer att sparas i den valda utdatakatalogen.

- Detaljerade instruktioner finns i officiell användarhandbok här.

Gemenskapens mottagning till Nightshade-mottagningen

Det har funnits ett överväldigande stöd för konstnärer som försöker försvara sina verk från AI, men som alltid finns det flera fraktioner, och vissa liknar det vid en cyberattack mot AI-modeller.

Som svar på kritiken förtydligar teamet: "Nightshades mål är inte att bryta modeller, utan att öka kostnaden för utbildning på olicensierad data, så att licensiering av bilder från deras skapare blir ett lönsamt alternativ."

"Om Nightshade används på ett ansvarsfullt sätt kan det bidra till att avskräcka modellutbildare som struntar i upphovsrätt, opt-out-listor och do-not-scrape/robots.txt-direktiv", hävdar de.

Debatten kring dataskrapning och träning av AI-modeller har blivit extremt bitter efter kontroversen på Midjourney och en flodvåg av företag som använder AI-genererade konstverk och ersätter mänsklig arbetskraft i processen.

Nightshade är ute!

Nightshade förgiftar AI-modeller om din konst eller dina bilder tas utan tillstånd, Glaze skyddar dig från AI-efterlikning. Det rekommenderas att du Nightshade först, sedan Glaze. En version som gör båda kommer.

Läs den här tråden för mer information.

Gå och ta dem 🫡 https://t.co/bU8EDthUcS pic.twitter.com/YddNu8xmJm

- Reid Southen (@Rahll) 19 januari 2024

Plötsligt känns det som om det finns ett allt större tomrum mellan teknikföretag som marknadsför AI som en filantropisk kraft och allmänheten, som tycker att AI tränger sig in för långt i kulturen och samhället.

Nightshade är faktiskt inte bara användbart för konstnärer. Människor uppmuntrar så många som möjligt att använda dessa verktyg, vilket skapar en mindre pool av högkvalitativ data som AI-företag kan skrapa.

Men har företagen tillräckligt med data redan? Kanske för tillfället, men för att hålla modellerna moderna och uppdaterade kommer AI-utvecklarna att behöva föra in nya data i sina system någon gång.

#Nattskugga

Proffstips: använd Nightshade på allt du laddar upp online (inte bara din konst), bilder från sociala medier, dagliga bilder på din måltid, familj, valpar, kattungar, slumpmässiga selfies och gatubilder - och låt spelet börja.- redigera ballai 🌿 (@eballai) 19 januari 2024

I Glaze och Nightshade ser vi en framväxande teknisk och etisk kamp mellan kreatörer och AI-företag.

Det kommer att bli mer och mer intressant, och kan det finnas liknande sätt att lura och förgifta språkmodeller?

Detta, i kombination med rättsliga tvister, kan leda till att generativ AI går in i en volatil period. Det kommer att bli ett enormt år för tekniken.