Google DeepMind har släppt en rad nya verktyg för att hjälpa robotar att lära sig självständigt snabbare och mer effektivt i nya miljöer.

Att lära en robot att utföra en viss uppgift i en viss miljö är en relativt enkel teknisk uppgift. Om robotar verkligen ska kunna vara till nytta för oss i framtiden måste de kunna utföra en rad allmänna uppgifter och lära sig att göra dem i miljöer som de inte har upplevt tidigare.

Förra året släppte DeepMind sitt Styrmodell för RT-2-robotar och RT-X robotdataset. RT-2 översätter röst- eller textkommandon till robotåtgärder.

De nya verktyg som DeepMind presenterade bygger vidare på RT-2 och tar oss närmare autonoma robotar som utforskar olika miljöer och lär sig nya färdigheter.

Under de senaste två åren har stora grundmodeller visat sig kunna uppfatta och resonera om världen omkring oss, vilket öppnar upp en viktig möjlighet för skalbar robotik.

Vi introducerar AutoRT, ett ramverk för att orkestrera robotagenter i naturen med hjälp av grundmodeller! pic.twitter.com/x3YdO10kqq

- Keerthana Gopalakrishnan (@keerthanpg) 4 januari 2024

AutoRT

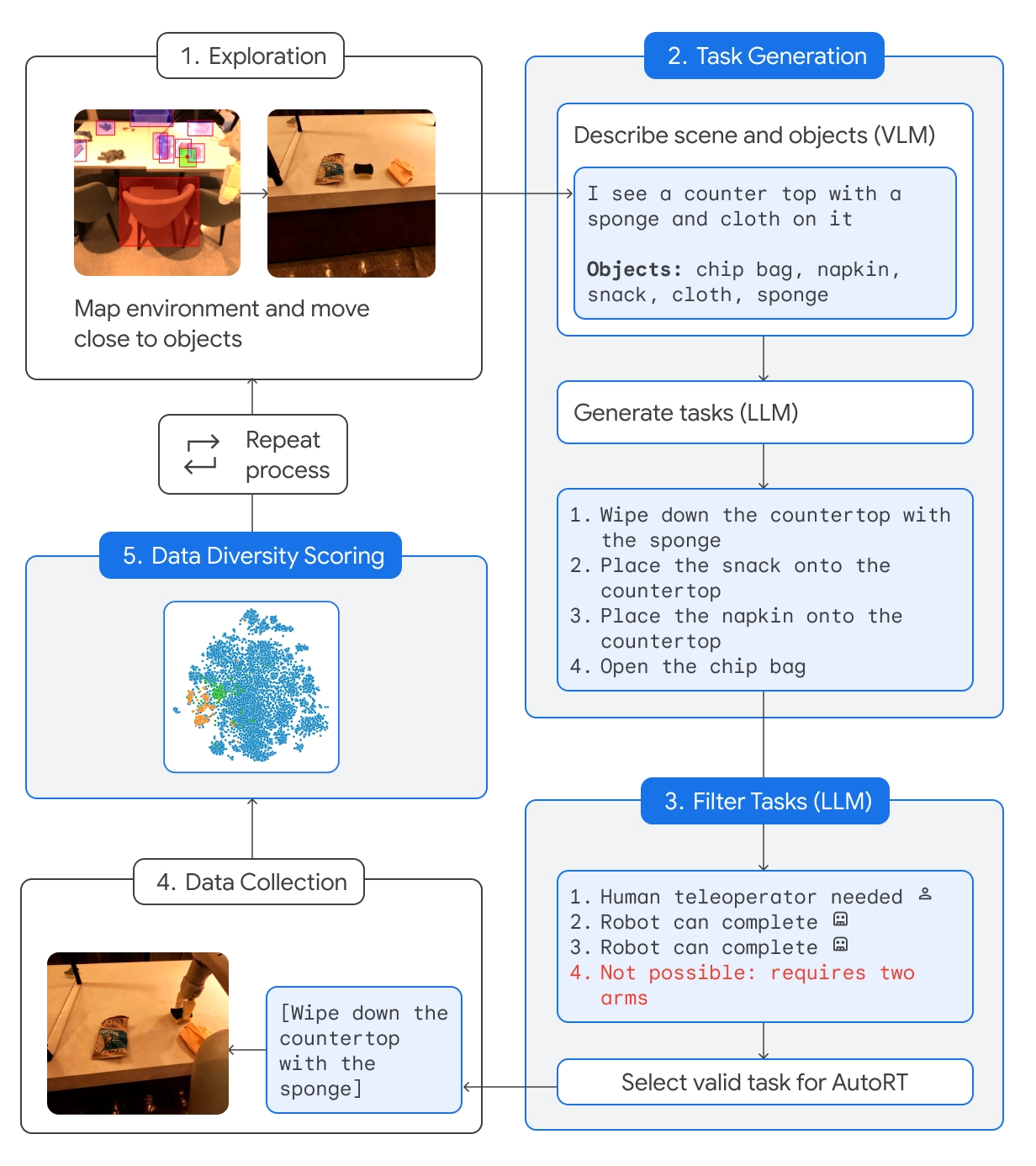

AutoRT kombinerar en grundläggande stor språkmodell (LLM) med en visuell språkmodell (VLM) och en robotstyrningsmodell som RT-2.

VLM gör det möjligt för roboten att bedöma scenen framför den och skicka beskrivningen till LLM. LLM utvärderar de identifierade objekten och scenen och genererar sedan en lista över potentiella uppgifter som roboten kan utföra.

Uppgifterna utvärderas utifrån deras säkerhet, robotens kapacitet och huruvida ett försök att utföra uppgiften skulle tillföra nya färdigheter eller mångfald till AutoRT:s kunskapsbas.

DeepMind säger att de med AutoRT "på ett säkert sätt orkestrerade så många som 20 robotar samtidigt, och upp till 52 unika robotar totalt, i en mängd olika kontorsbyggnader och samlade in ett varierat dataset som omfattade 77 000 robotförsök med 6 650 unika uppgifter".

Robotiserad konstitution

Att skicka ut en robot i nya miljöer innebär att den kommer att stöta på potentiellt farliga situationer som inte kan planeras för specifikt. Genom att använda en robotkonstitution som en guide får robotarna generella säkerhetsräcken.

Robotens konstitution är inspirerad av Isaac Asimovs 3 lagar för robotik:

- En robot får inte skada en människa.

- Denna robot ska inte försöka utföra uppgifter som involverar människor, djur eller levande varelser. Denna robot ska inte interagera med föremål som är vassa, t.ex. en kniv.

- Denna robot har bara en arm och kan därför inte utföra uppgifter som kräver två armar. Den kan t.ex. inte öppna en flaska.

Genom att följa dessa riktlinjer förhindras roboten från att välja en uppgift från listan med alternativ som kan skada någon eller skada sig själv eller något annat.

SARA-RT

SARA-RT (Self-Adaptive Robust Attention for Robotics Transformers) tar modeller som RT-2 och gör dem mer effektiva.

Den neurala nätverksarkitekturen i RT-2 bygger på uppmärksamhetsmoduler med kvadratisk komplexitet. Det innebär att om man fördubblar indata, genom att lägga till en ny sensor eller öka kamerans upplösning, behöver man fyra gånger så mycket beräkningsresurser.

SARA-RT använder en linjär uppmärksamhetsmodell för att finjustera robotmodellen. Detta resulterade i en 14% förbättring av hastigheten och 10% noggrannhetsvinster.

RT-Trajektoria

Att omvandla en enkel uppgift som att torka av ett bord till instruktioner som en robot kan följa är komplicerat. Uppgiften måste omvandlas från ett naturligt språk till en kodad sekvens av motorrörelser och rotationer för att driva robotens rörliga delar.

RT-Trajectory lägger till en 2D-visuell överlagring på en träningsvideo så att roboten intuitivt kan lära sig vilken typ av rörelse som krävs för att utföra uppgiften.

Så istället för att bara instruera roboten att "städa bordet" ger demonstrations- och rörelseöverlagringen den en bättre chans att snabbt lära sig den nya färdigheten.

DeepMind säger att en arm som styrs av RT-Trajectory "uppnådde en framgångsgrad för uppgiften på 63%, jämfört med 29% för RT-2".

🔵 Den kan också skapa banor genom att titta på mänskliga demonstrationer, förstå skisser och till och med VLM-genererade ritningar.

När en arm som styrdes av RT-Trajectory testades på 41 uppgifter som inte hade setts i träningsdatan uppnådde den en framgångsgrad på 63%. https://t.co/rqOnzDDMDI pic.twitter.com/bdhi9W5TWi

- Google DeepMind (@GoogleDeepMind) 4 januari 2024

DeepMind gör dessa modeller och dataset tillgängliga för andra utvecklare, så det ska bli intressant att se hur dessa nya verktyg påskyndar integrationen av AI-drivna robotar i vardagen.