När Google tillkännagav lanseringen av sina Gemini-modeller var det mycket spänning eftersom företaget sa att dessa var i nivå med erbjudanden från OpenAI. Det kanske inte är helt sant.

Google sa att dess Gemini Ultra modellen är bättre än GPT-4. Modellen har ännu inte släppts så vi får ta deras resultat från benchmarktesterna för vad de är. Gemini Pro har släppts och Google säger att den är i nivå med GPT-3.5.

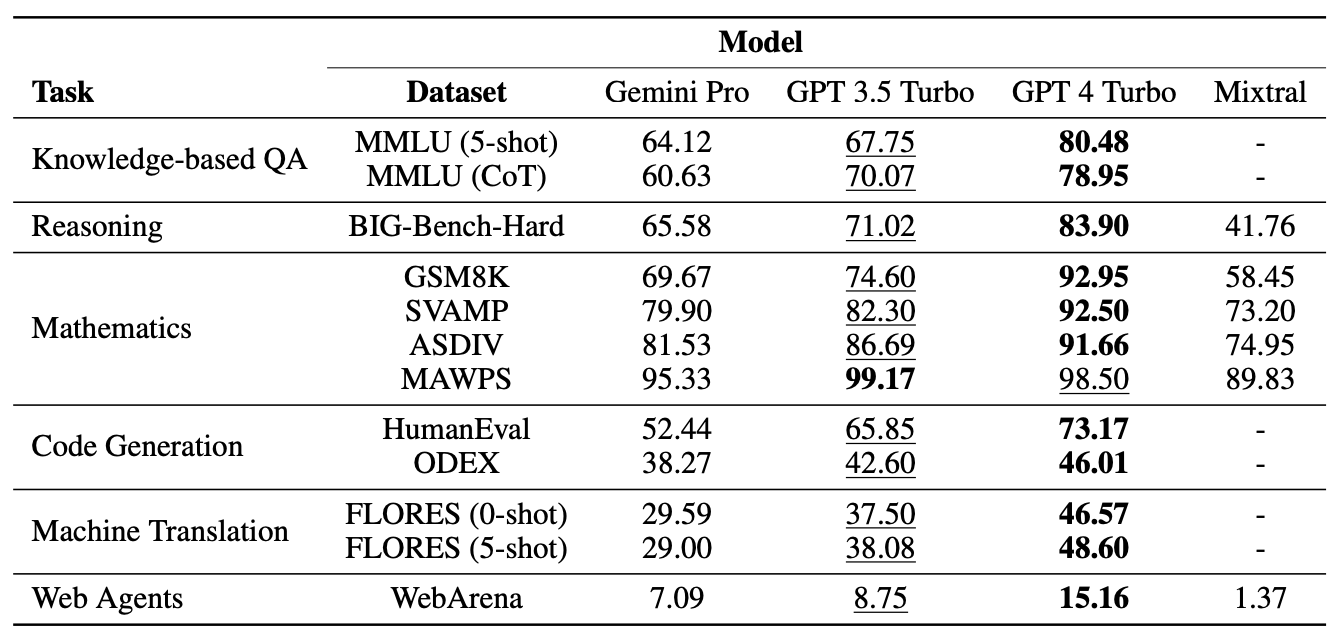

Forskare från Carnegie Mellon University och AI-mjukvaruplattformen BerriAI lät Gemini Pro genomgå en rad uppgifter för att testa dess språkförståelse och genereringsförmåga.

De körde samma tester med GPT-3.5 Turbo, GPT-4 Turbo och Mistral AI:s nya Mixtral 8x7B modell.

Googles Gemini blev nyligen känd som en stor konkurrent till OpenAI:s GPT. Spännande! Men vi undrade:

Hur bra är Gemini egentligen?

Vid CMU genomförde vi en opartisk, djupgående och reproducerbar studie som jämförde Gemini, GPT och Mixtral.

Papper: https://t.co/S3T7ediQLa

🧵 pic.twitter.com/NmEOeDd8pI- Graham Neubig (@gneubig) 19 december 2023

Resultat

Föga förvånande vann GPT-4 men Google kommer att vara mindre spända på att se hur Gemini Pro stod sig mot GPT 3.5 Turbo. I en sammanfattning av teamets resultat, tidningen "Geminis Pro-modell uppnådde jämförbar men något sämre noggrannhet jämfört med den nuvarande versionen av OpenAI:s GPT 3.5 Turbo."

Här följer en sammanfattning av resultaten.

Modellerna uppmanades att använda BerriAI:s LiteLLM-gränssnitt och varje modell fick exakt samma uppmaningar och utvärderingsprotokoll.

Modellerna testades på flervalsfrågor, allmänna resonemang, matematiska resonemang, kodgenerering, språköversättning och att fungera som en webbagent.

En av anledningarna till att Gemini Pro fick dåliga resultat i flervalsfrågorna är att den hade en stark positionsbias. Den valde ofta svaret i position D, oavsett om det var korrekt eller inte. Intressant nog är detta något som Microsofts Medprompt löses med shuffling.

Trots att Gemini Pro förlorade i några av testerna slog den GPT-3.5 Turbo på två områden, nämligen ordsortering och symbolmanipulation och översättning.

I alla de översättningsuppgifter som Gemini Pro slutförde överträffade den alla andra modeller, inklusive GPT-4. Gemini Pros slutpoäng på översättningstesterna blev dock lägre än GPT-3.5 eftersom den avböjde att slutföra vissa förfrågningar när dess övernitiska innehållsmodereringsskydd slog till.

Än sen?

Google bestrider de siffror som forskarna kom till och insisterar på att dess siffror visar att Gemini Pro är i nivå eller bättre än GPT-3.5. Om vi tillåter den myriad av variabler och skär Google lite slack, kan vi dela skillnaden och säga att Gemini Pro och GPT-3.5 är ganska mycket samma.

Det viktigaste här är att Gemini Pro, en helt ny modell som Google tillbringade månader på att utveckla, inte slår en modell som har funnits ute i mer än ett år och är gratis att använda via ChatGPT.

Gemini Ultra förväntas lanseras i början av 2024. Kommer den att leva upp till sitt påstående att vara bättre än GPT-4? Låt oss hoppas att professor Graham Neubig och hans team får köra liknande benchmarkingtester snart.