Dagens AI-modeller kan göra en hel del osäkra eller oönskade saker. Mänsklig övervakning och feedback håller dessa modeller i linje, men vad kommer att hända när dessa modeller blir smartare än oss?

OpenAI säger att det är möjligt att vi kan se skapandet av en AI som är smartare än människor inom de närmaste 10 åren. Med den ökade intelligensen kommer också risken att människor inte längre kan övervaka dessa modeller.

OpenAI:s forskargrupp Superalignment fokuserar på att förbereda sig för den eventualiteten. Teamet lanserades i juli i år och leds av Ilya Sutskever som har varit i skuggan sedan Sam Altman avskedande och efterföljande återanställning.

Bakgrunden till projektet sattes in i ett nyktert sammanhang av OpenAI som konstaterade att "för närvarande har vi ingen lösning för att styra eller kontrollera en potentiellt superintelligent AI och förhindra att den blir oseriös".

Men hur förbereder man sig för att kontrollera något som ännu inte finns? Forskargruppen har precis släppt sin första experimentella resultaten eftersom den försöker göra just det.

Svag-till-stark generalisering

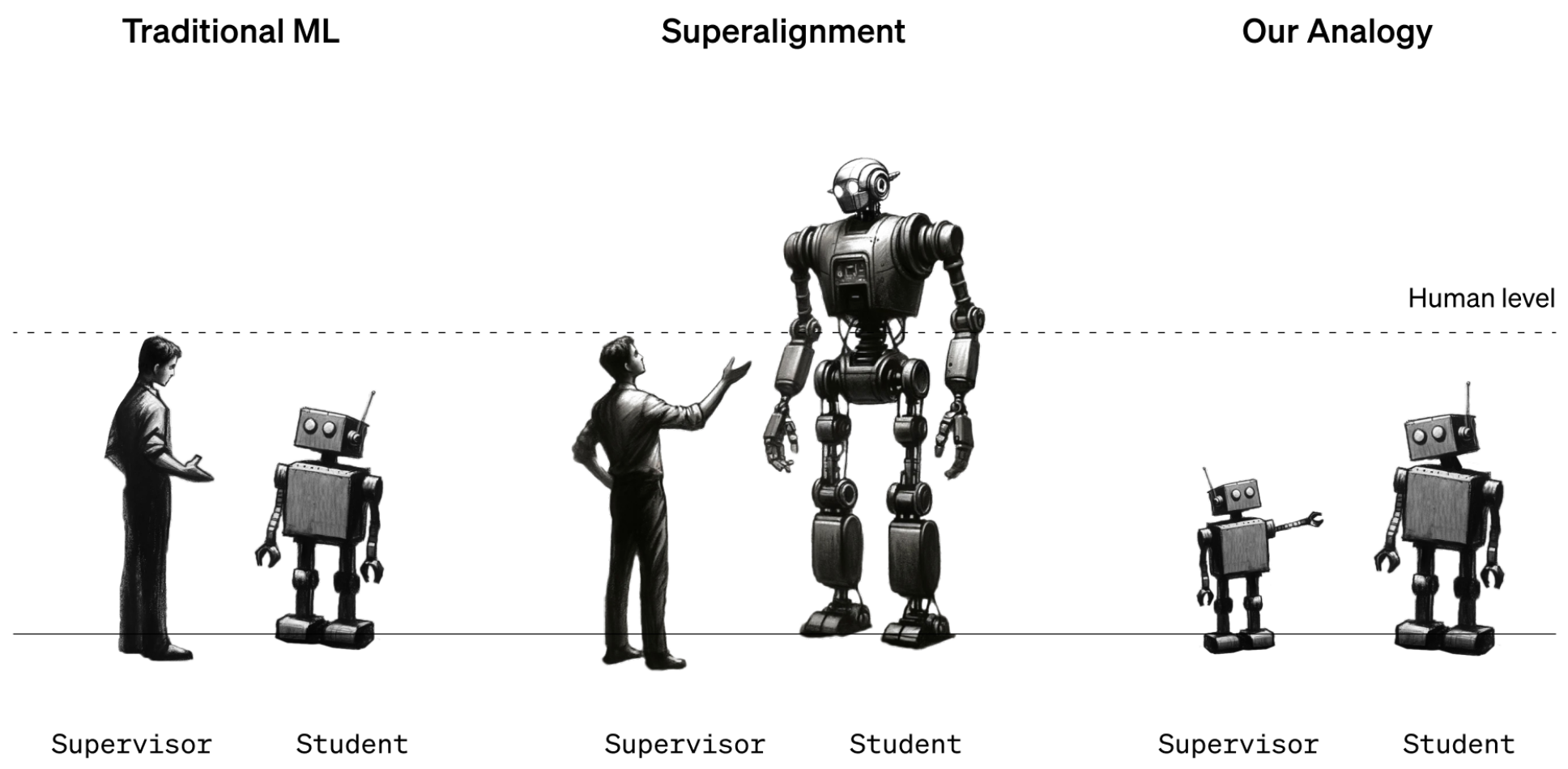

Än så länge har människan fortfarande en starkare intelligensposition än AI-modeller. Modeller som GPT-4 styrs eller justeras med hjälp av RLHF (Reinforcement Learning Human Feedback). När en modells resultat inte är önskvärt säger den mänskliga utbildaren till modellen "Gör inte så" och belönar modellen med en bekräftelse på önskad prestanda.

Det här fungerar för tillfället eftersom vi har en god förståelse för hur de nuvarande modellerna fungerar och vi är smartare än dem. När framtida mänskliga datavetare behöver utbilda en superintelligent AI kommer intelligensrollerna att vara omvända.

För att simulera den här situationen beslutade OpenAI att använda äldre GPT-modeller som GPT-2 för att träna mer kraftfulla modeller som GPT-4. GPT-2 skulle simulera den framtida mänskliga tränaren som försöker finjustera en mer intelligent modell.

I forskningsrapporten förklaras att "precis som problemet med människor som övervakar övermänskliga modeller är vår installation en instans av vad vi kallar problemet med svag-till-stark inlärning".

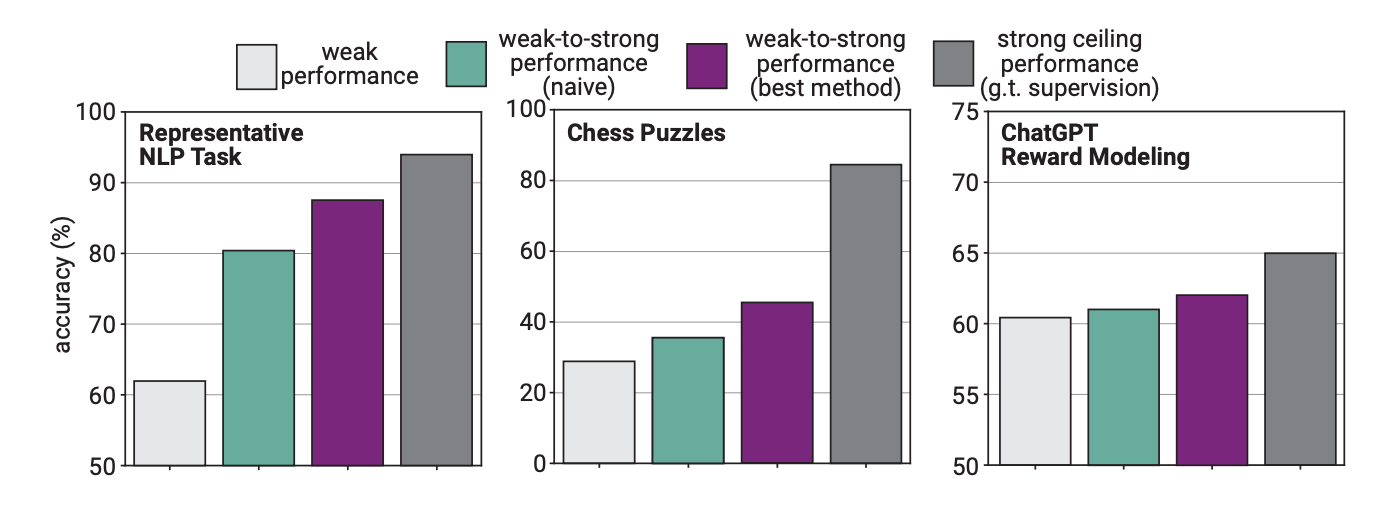

I experimentet använde OpenAI GPT-2 för att finjustera GPT-4 på NLP-uppgifter, schackpussel och belöningsmodellering. De testade sedan GPT-4:s prestanda vid utförandet av dessa uppgifter och jämförde den med en GPT-4-modell som hade tränats på "grundsanningen" eller korrekta svar på uppgifterna.

Resultaten var lovande i det att när GPT-4 tränades av den svagare modellen kunde den starkt generalisera och överträffa den svagare modellen. Detta visade att en svagare intelligens kunde ge vägledning till en starkare som sedan kunde bygga vidare på den träningen.

Tänk på det som om en elev i årskurs 3 skulle lära en riktigt smart elev lite matematik och sedan låta den smarta eleven fortsätta med matematik i årskurs 12 baserat på den inledande utbildningen.

Prestationsgap

Forskarna fann att eftersom GPT-4 tränades av en mindre intelligent modell, begränsade denna process dess prestanda till motsvarande en korrekt tränad GPT-3.5-modell.

Det beror på att den mer intelligenta modellen lär sig en del av de misstag eller dåliga tankeprocesser som den svagare handledaren gör. Detta tyder på att om man använder människor för att utbilda en superintelligent AI skulle det hindra AI:n från att prestera till sin fulla potential.

Forskarna föreslog att man skulle använda mellanliggande modeller i en bootstrapping-metod. I artikeln förklaras att "Istället för att direkt anpassa mycket övermänskliga modeller kan vi först anpassa en bara lite övermänsklig modell, använda den för att anpassa en ännu smartare modell och så vidare."

OpenAI åtar sig mycket resurser till detta projekt. Forskningsteamet säger att de har ägnat "20% av den beräkning som vi hittills har säkrat under de kommande fyra åren för att lösa problemet med superintelligensinriktning."

Man erbjuder också $10 miljoner i bidrag till individer eller organisationer som vill hjälpa till med forskningen.

Det är bäst att de löser det här snart. En superintelligent AI skulle potentiellt kunna skriva en miljon rader komplicerad kod som ingen mänsklig programmerare skulle kunna förstå. Hur skulle vi veta om den genererade koden var säker att köra eller inte? Låt oss hoppas att vi inte får reda på det den hårda vägen.