Träning av AI-modeller som GPT-4 har mestadels förlitat sig på dataset som består av text och bilder. Metas Ego-Exo4D multimodala perceptionsdataset presenterar datavetare med en rik ny uppsättning träningsdata.

Du kan lära dig en ny färdighet genom att läsa en bok, men det är så mycket lättare när någon visar dig hur du gör något medan du förklarar det för dig. Detta är målet Metas FAIR-team (Fundamental Artificial Intelligence Research) har för Ego-Exo4D.

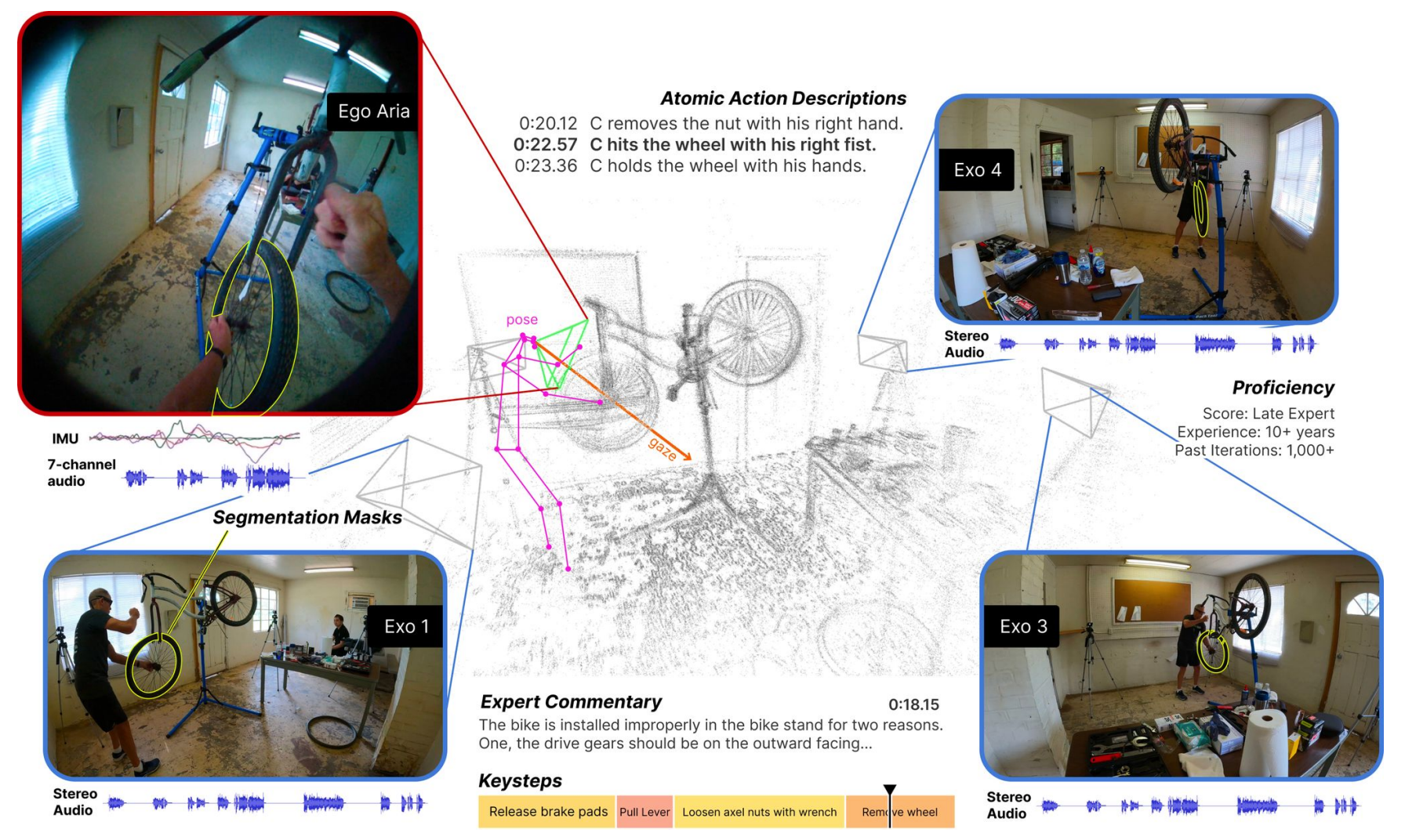

Datasetet består av videor i förstapersons- (Ego) och tredjepersons- (Exo) perspektiv av människor som utför olika kvalificerade mänskliga aktiviteter. Det kan vara allt från att laga mat, dansa, spela musik eller reparera en cykel. Uppgifterna samlades in i 13 städer över hela världen av 839 kamerabärare, som spelade in 1422 timmar video.

Videorna, som filmas samtidigt, kompletteras sedan med ytterligare datalägen med hjälp av Metas Project Aria-glasögon.

Project Aria-glasögonen är bärbara datorer i glasögonform. De fångar upp bärarens video- och ljudinspelningar samt information om ögonstyrning och plats. Glasögonen känner också av huvudpositioner och 3D-punktmoln av omgivningen.

Resultatet är ett dataset med samtidiga videor av en uppgift som utförs, med berättelser i första person av kamerabärarna som beskriver sina handlingar, och huvud- och ögonspårning av den person som utför uppgiften.

Vi presenterar Ego-Exo4D - ett grundläggande dataset och en benchmark-svit som fokuserar på skickliga mänskliga aktiviteter för att stödja forskning om videoinlärning och multimodal perception. Det är den största offentliga datauppsättningen i sitt slag någonsin.

Mer information ➡️ https://t.co/82OR4msehv pic.twitter.com/NTI1kdj1RN

- AI på Meta (@AIatMeta) 4 december 2023

Meta lade sedan till tredjepersons play-by-play-beskrivningar av varje kamerabärares handlingar. Meta anlitade också experter inom flera områden för att lägga till tredjepersons talade expertkommentarer som kritiserade hur personen i videon utförde uppgiften.

Genom att samla in både egocentriska och exocentriska vyer kan Ego-Exo4D-datasetet visa forskare hur aktiviteter ser ut från olika perspektiv. Detta kan hjälpa dem att så småningom utveckla datorseendealgoritmer som kan känna igen vad en person gör från vilket perspektiv som helst.

Ego-Exo4D öppnar nya möjligheter till lärande

Ett av de största hindren för att uppnå AGI eller träna robotar mer effektivt är den brist på sensorisk perception som datorer har. Som människor har vi så många sinnesintryck från vår omgivning som vi ofta tar för givet när vi lär oss nya färdigheter.

Ego-Exo4D kommer att vara en extremt användbar resurs för att överbrygga detta gap.

Dr Gedas Bertasius, biträdande professor vid institutionen för datavetenskap vid University of North Carolina, säger: "Ego-Exo4D handlar inte bara om att samla in data, utan om att förändra hur AI förstår, uppfattar och lär sig. Med människocentrerad inlärning och perspektiv kan AI bli mer användbart i våra dagliga liv och hjälpa oss på sätt som vi bara har kunnat föreställa oss."

Meta säger att de hoppas att Ego-Exo4D kommer att "möjliggöra framtidens robotar som får insikt om komplexa fingerfärdiga manipuleringar genom att titta på skickliga mänskliga experter i aktion."

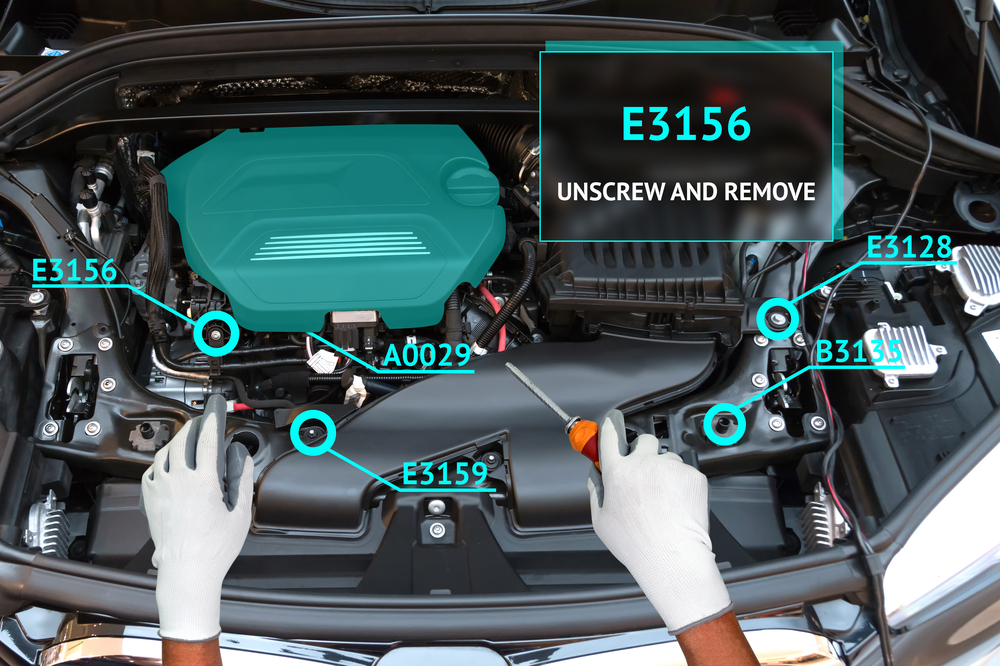

Detta dataset i kombination med Project Aria-glasögonen kommer snart också att möjliggöra en verkligt uppslukande inlärningsupplevelse för människor. Föreställ dig att du utför en uppgift medan dina glasögon använder förstärkt verklighet (AR) för att överlagra en instruktionsvideo eller prata med dig genom din uppgift.

Du kan lära dig att spela piano och få en visuell överlagring som visar hur händerna ska röra sig med ljud i realtid under tiden du spelar. Eller så kan du öppna motorhuven på din bil och få hjälp med att felsöka och åtgärda ett motorproblem.

Det ska bli intressant att se om Metas Ego How-To inlärningskoncept kommer att driva bättre antagande av Project Aria-glasögon än den misslyckade Google Glass-produkten upplevde. Det finns dock inget ord om när de kommer att finnas tillgängliga att köpa ännu.

Meta kommer att göra Ego-Exo4D-datasetet tillgänglig för nedladdning före slutet av december.