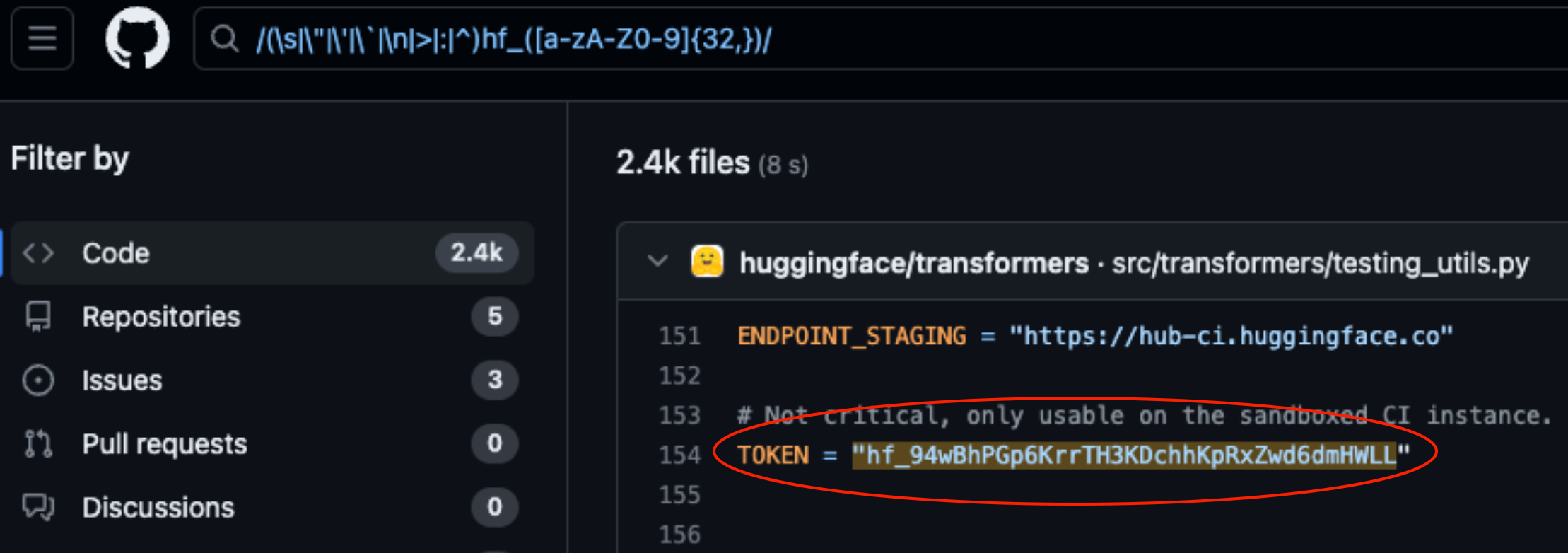

Lasso Security avslöjade säkerhetsproblem på HuggingFace och GitHub efter att ha hittat 1681 exponerade API-tokens hårdkodade i kod lagrad på plattformarna.

HuggingFace och GitHub är två av de mest populära repositorierna där utvecklare kan ge tillgång till sina AI-modeller och kod. Tänk på dessa som mappar i molnet som hanteras av de organisationer som äger dem.

HuggingFace och GitHub gör det enkelt för användare att interagera med hundratusentals AI-modeller och dataset via API:er. Det gör det också möjligt för organisationer som äger modellerna och dataseten att använda API-åtkomsten för att läsa, skapa, ändra och ta bort arkiv eller filer.

De behörigheter som är kopplade till din API-token avgör vilken åtkomstnivå du har. Lasso hittades att de med lite grävande kunde hitta många tokens i kod som lagrats i repositorier på plattformarna.

Av de 1681 giltiga tokens som de hittade hade 655 användares tokens skrivbehörighet, varav 77 hade full kontobehörighet.

Varför är det här en stor sak?

Tänk på en API-token som en nyckel till din ytterdörr. Det kan vara bekvämt att lämna nyckeln under dörrmattan, men om någon hittar den får de tillgång till ditt hus.

När utvecklare skriver en kod som behöver interagera med deras AI-modell eller dataset blir de ibland lite lata. De kan hårdkoda tokens i sin kod istället för att använda säkrare sätt att hantera dem.

Några av de tokens som Lasso hittade gav dem fullständiga läs- och skrivbehörigheter till Meta's Lama 2, BigScience Workshop och EleutherAI. Alla dessa organisationer har AI-modeller som har laddats ner miljontals gånger.

Om Lasso var skurkarna kunde de ha modifierat modellerna eller dataseten i de exponerade förvaret. Tänk dig om någon lade till lite lömsk kod i Metas förvar och sedan fick miljontals människor ladda ner den.

När Meta, Google, Microsoft och andra hörde om de exponerade API-tokens återkallade de dem snabbt.

Modellstöld, förgiftning av träningsdata och kombination av tredjepartsdatamängder och förtränade modeller är alla stora risker för AI-företag. Utvecklare som slentrianmässigt lämnar API-tokens exponerade i kod gör det bara lättare för dåliga aktörer att utnyttja dessa.

Man kan undra om Lassos ingenjörer var de första som upptäckte dessa sårbarheter.

Om cyberbrottslingar hittade dessa symboler skulle de säkert ha hållit det väldigt tyst medan de öppnade ytterdörren.