Nvidia skalade upp och optimerade sin Eos AI-superdator för att sätta nya rekord för MLPerf AI-utbildning.

När Nvidia slog på sin AI-superdator Eos i maj vaknade 10 752 NVIDIA H100 Tensor Core GPU:er till liv och de har just genomgått några testförsök i den verkliga världen.

Denna oöverträffade processorkraft tillsammans med nya programvaruoptimeringar har gjort det möjligt för Eos att driva MLPerf riktmärke in i rekordterritorium.

MLPerf-riktmärket med öppen källkod är en uppsättning tränings- och inferenstester som är utformade för att mäta prestanda för maskininlärningsarbetsbelastningar på verkliga dataset.

Ett av de mest anmärkningsvärda resultaten var att Eos kunde träna en GPT-3-modell med 175 miljarder parametrar på en miljard tokens på bara 3,9 minuter.

När Nvidia satte rekordet på denna benchmark för mindre än 6 månader sedan tog det nästan 3 gånger längre tid med en tid på 10,9 minuter.

Nvidia lyckades också uppnå en effektivitetsgrad på 93% under testerna, vilket innebär att nästan all den datorkraft som teoretiskt sett finns tillgänglig i Eos användes.

Microsoft Azure, som använder ungefär samma H100-installation som Eos i sin virtuella maskin ND H100 v5, kom inom 2% från Nvidias testresultat i sina MLPerf-tester.

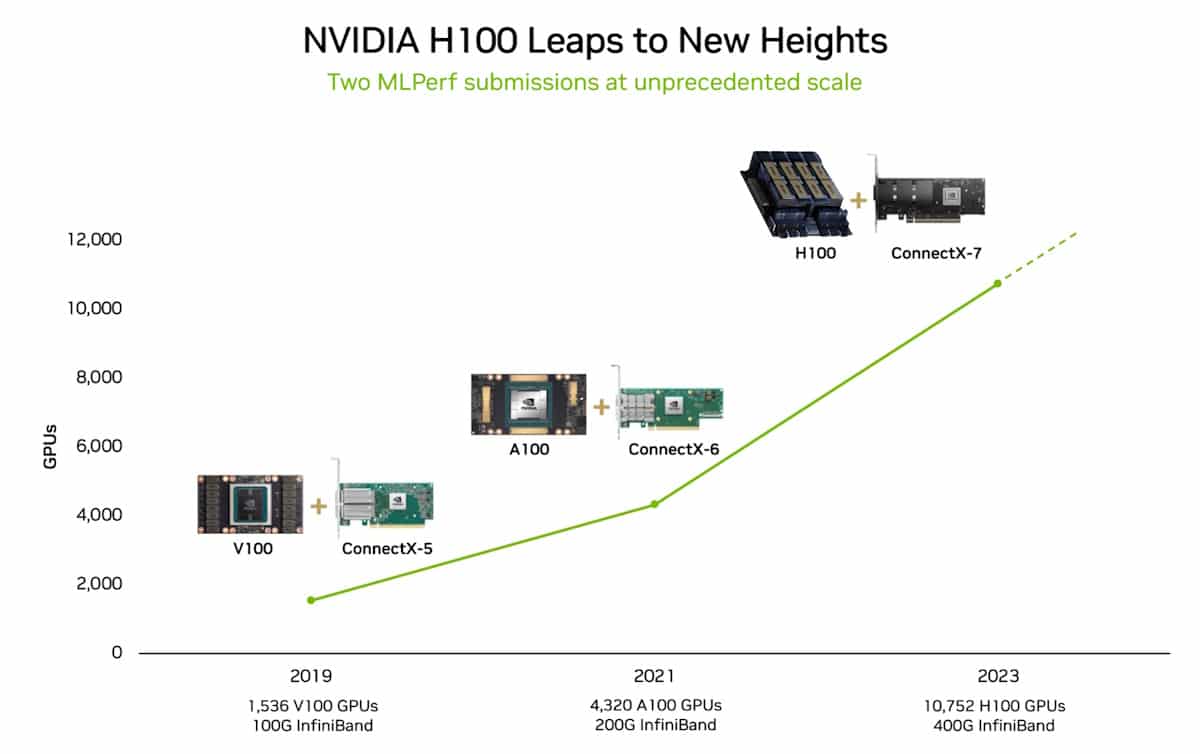

År 2018 sa Jensen Huang, VD för Nvidia, att prestandan hos GPU:er kommer att mer än fördubblas vartannat år. Detta påstående myntades Haung's Law och har visat sig vara sant eftersom det lämnar Moore's lag försvinner i datorns backspegel.

Än sen?

MLPerf benchmark-utbildningstestet som Nvidia aced använder bara en del av hela datasetet som GPT-3 utbildades på. Om du tar den tid Eos satte i MLPerf-testet och extrapolerar för hela GPT-3-datasetet så kan den träna hela modellen på bara 8 dagar.

Om du försökte göra det med det tidigare toppmoderna systemet som bestod av 512 A100 GPU:er skulle det ta cirka 170 dagar.

Om du skulle utbilda en ny AI-modell, kan du då föreställa dig skillnaden i tid till marknad och kostnad som 8 dagar jämfört med 170 dagar innebär?

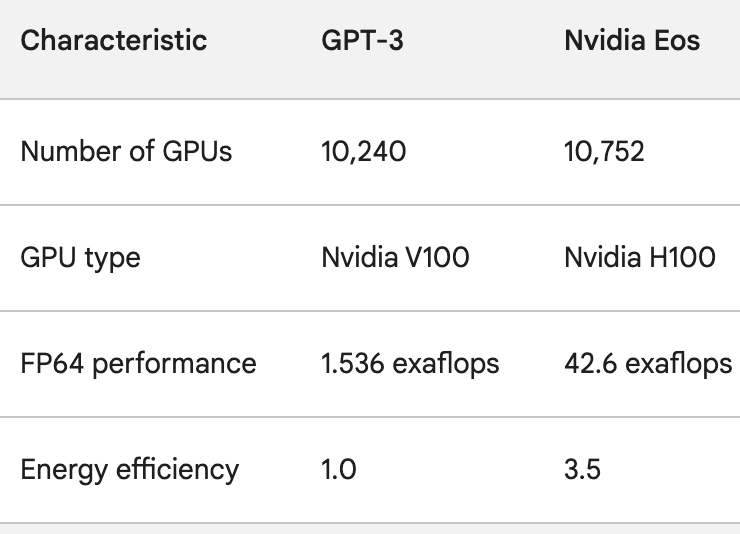

H100 GPU:erna är inte bara mycket mer kraftfulla än A100 GPU:erna, de är också upp till 3,5 gånger mer energieffektiva. Energianvändning och AI:s koldioxidavtryck är verkliga problem som måste lösas.

För att få en uppfattning om hur snabbt AI-bearbetningen förbättras, tänk på ChatGPT som gick live för knappt ett år sedan. Den underliggande modellen, GPT-3, tränades på 10 240 Nvidia V100 GPU:er.

Mindre än ett år senare har Eos 28 gånger så mycket processorkraft som den installationen med en 3,5-faldig förbättring av effektiviteten.

När OpenAI:s Sam Altman avslutade den senaste DevDay sa han att de projekt som OpenAI arbetade med skulle få de senaste versionerna att se gammaldags ut.

Med tanke på det språng i processorkraft som företag som Nvidia uppnår, sammanfattar Altmans påstående sannolikt framtiden för AI-industrin som helhet.