Under sitt besök i Storbritannien för AI Safety Summit meddelade USA:s vicepresident Kamala Harris att 30 länder har anslutit sig till USA:s förslag till riktlinjer för militär användning av AI.

Tillkännagivandet "Politisk deklaration om ansvarsfull militär användning av artificiell intelligens och autonomi" publicerades på det amerikanska utrikesdepartementets webbplats den 1 november och ytterligare detaljer om ramverket publicerades den 9 november.

I sitt uttalande om ramverket sa Harris: "För att skapa ordning och stabilitet mitt i den globala tekniska utvecklingen är jag övertygad om att vi måste vägledas av en gemensam uppsättning överenskommelser mellan nationer."

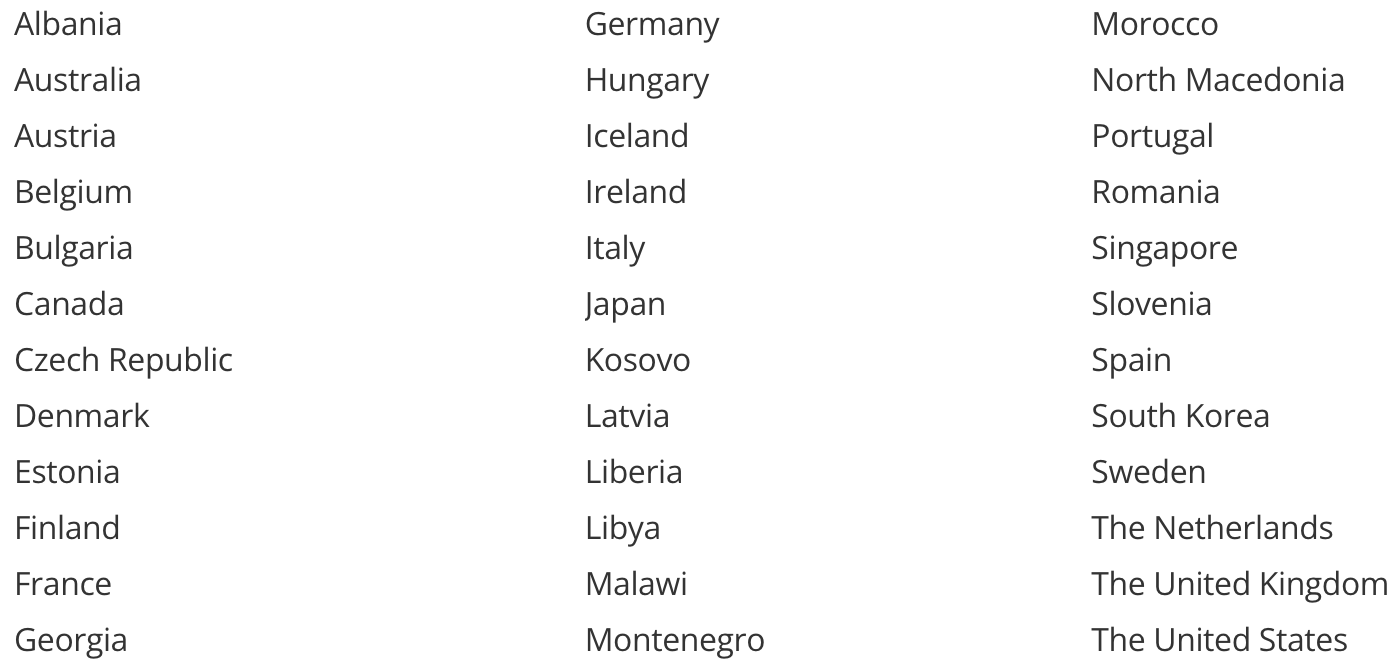

Dessa är de länder som utlovat sitt stöd för initiativet.

Kina och Ryssland är inte med på denna lista. Kina gav sitt stöd till Bletchley-deklarationenoch utlovade sitt principiella stöd för en säker utveckling av AI i allmänhet.

Rysslands och Kinas beslut att inte ställa sig bakom deklarationen om militär AI kan ha mer att göra med dokumentets författare än med deras syn på dess innehåll.

En annan lucka på listan lämnas av två länder som för närvarande får miljarder i militärt stöd från några av de stödjande staterna, Israel och Ukraina.

USA:s beslut att inte stödja utfästelsen beror sannolikt på att båda länderna för närvarande använder AI i de konflikter de är inblandade i.

Israel använder AI i olika militära tillämpningar, bland annat i sin Järnkupolen system. Ukraina har skapat kontroverser med sitt autonoma AI-drönare som riktar in sig på soldater och militär utrustning i sin konflikt med Ryssland.

Vad förbinder de sig till?

Om du vill läsa de fullständiga detaljerna om vad undertecknarna kommer överens om kan du göra det här.

Här är den korta versionen som kanske offrar lite substans för korthet:

- Se till att din militär antar och använder dessa AI-principer.

- Din militära AI-användning måste följa internationell lag och skydda civila.

- De högsta cheferna måste leda utvecklingen och användningen av militär AI.

- Proaktivt minimera oavsiktlig partiskhet i militära AI-kapaciteter.

- Var försiktig när du tillverkar eller använder AI-vapen.

- Se till att din AI-försvarsteknik är transparent och granskningsbar.

- Utbilda dem som använder eller godkänner användningen av militär AI-kapacitet så att de inte litar blint på AI när den gör fel.

- Definiera tydligt vad du planerar att göra med din militära AI-teknik och utforma den så att den bara gör det.

- Fortsätt att testa självlärande och kontinuerligt uppdaterande militära AI-funktioner för att se om de fortfarande är säkra.

- Ha en avstängningsknapp om ditt AI-vapen skulle missköta sig.

Detta är lovvärda ideal, men det är tveksamt om de är tekniskt eller ens logistiskt inom försvarsorganisationernas räckhåll.

Kommer de att vara verkställbara? Undertecknandet av utfästelsen är en bekräftelse på principiellt stöd men innebär inte någon juridisk skyldighet.

Att underteckna ett dokument som säger att "vi ska vara försiktiga när vi använder AI i vår militär" innebär också att landet har för avsikt att använda AI som ett vapen, om än på ett "ansvarsfullt och etiskt" sätt.

Åtminstone dessa länder erkänner AI:s potential att förstärka den skada som konventionella vapen redan orsakar. Har detta ramverk gjort världen lite säkrare, eller har det bara riktat strålkastarljuset mot vad som oundvikligen ligger framför oss?