Multimodala stora språkmodeller (MLLM) som GPT-4V är riktigt bra på att analysera och beskriva bilder, men ibland hallucinerar de och får saker om bakfoten. Ett nytt tillvägagångssätt som kallas Woodpecker kan åtgärda det.

Om du ber en MLLM att beskriva ett foto kan den normalt plocka ut föremålen och beskriva scenen på ett korrekt sätt. Men precis som med svar på textfrågor gör modellen ibland antaganden baserade på föremål eller begrepp som ofta förekommer tillsammans.

Det innebär att en MLLM kan beskriva ett foto av en butiksfasad och säga att det finns människor i bilden, trots att det inte finns några.

Att åtgärda hallucinationer i textbaserade LLM:er är ett ständigt pågående arbete, men det blir mycket enklare när modellen är ansluten till internet. LLM kan generera ett textsvar på en uppmaning, kontrollera att det är korrekt baserat på relevanta internetdata och självkorrigera vid behov.

Forskare från Tencents YouTu Lab och University of Science and Technology of China tog fasta på detta synsätt och översatte det till en visuell lösning som kallas Woodpecker.

Enkelt uttryckt bygger Woodpecker upp en kunskapsmassa från bilden och sedan kan en LLM använda den som referens för att korrigera den ursprungliga beskrivningen som genererats av MLLM.

Här följer en kort beskrivning av hur det fungerar:

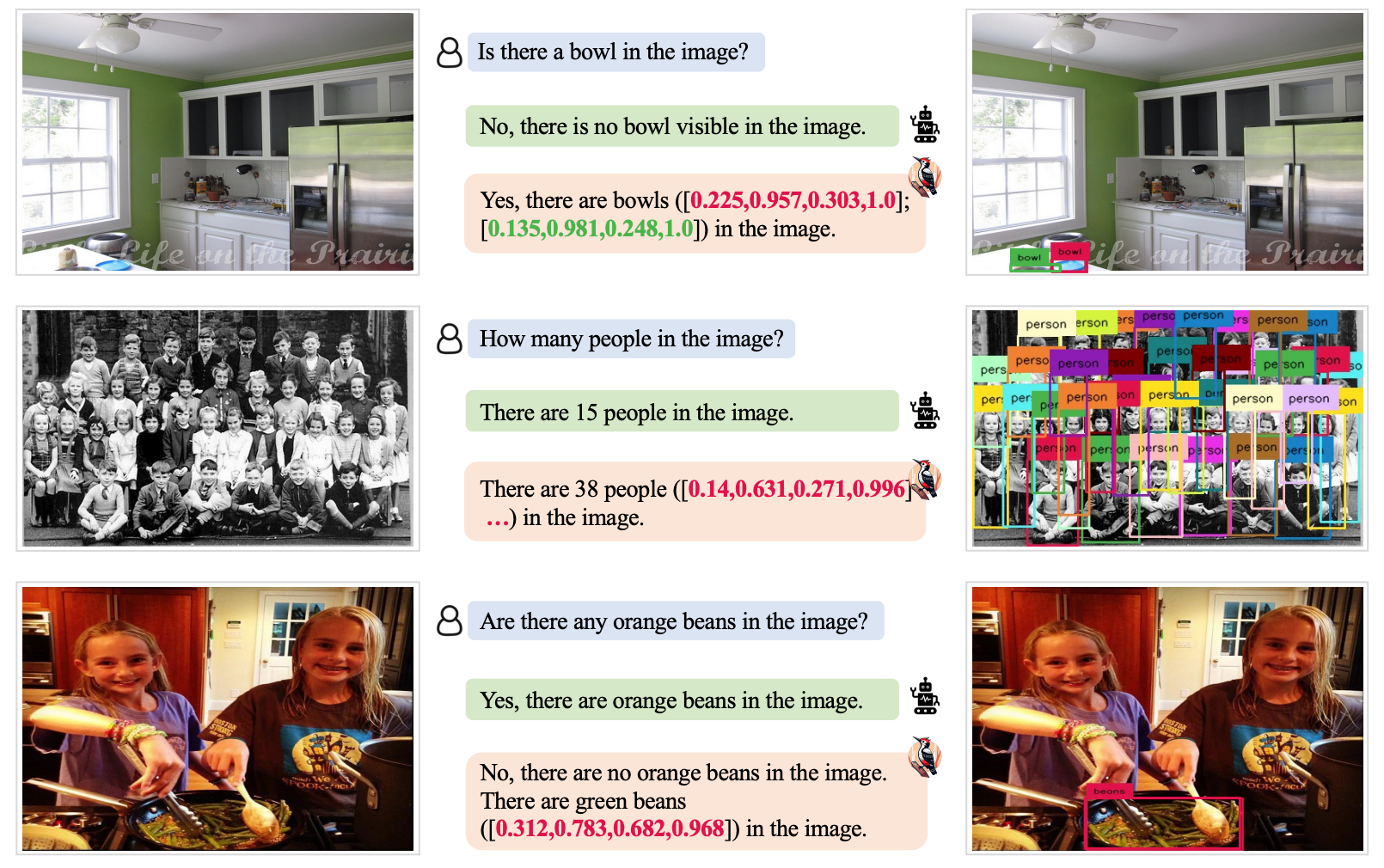

- En LLM som GPT-3.5 Turbo analyserar den beskrivning som genereras av MLLM och extraherar nyckelbegrepp som objekt, kvantiteter och attribut. I meningen "Mannen bär en svart hatt." extraheras till exempel objekten "man" och "hatt".

- En LLM uppmanas sedan att generera frågor relaterade till dessa begrepp, t.ex. "Finns det en man på bilden?" eller "Vad har mannen på sig?".

- Dessa frågor matas som uppmaningar till en VQA-modell (Visual Question Answering). Grounding DINO utför objektdetektering och räkning medan BLIP-2-FlanT5 VQA svarar på attributrelaterade frågor efter att ha analyserat bilden.

- En LLM kombinerar svaren på frågorna till en visuell kunskapsbas för bilden.

- En LLM använder denna referenskunskap för att korrigera eventuella hallucinationer i den ursprungliga MLLM:s beskrivning och lägger till detaljer som den missade.

Forskarna döpte sin metod till Woodpecker med hänvisning till hur fågeln plockar insekter ur träden.

Testresultaten visade att Woodpecker uppnådde en förbättring av noggrannheten med 30,66% för MiniGPT4 och 24,33% för mPLUG-Owl-modellerna.

Den generiska karaktären hos de modeller som krävs i denna metod innebär att Woodpecker-metoden enkelt kan integreras i olika MLLM.

Om OpenAI integrerar Woodpecker i ChatGPT kan vi få se en markant förbättring av den redan imponerande visuella prestandan. En minskning av MLLM-hallucinationer skulle också kunna förbättra automatiserat beslutsfattande i system som använder visuella beskrivningar som indata.