AI kretsar kring data, men var kommer den ifrån? Är datauppsättningar lagliga och etiska? Hur kan utvecklare avgöra det med säkerhet?

För att träna maskininlärningsmodeller, t.ex. stora språkmodeller (LLM), krävs stora volymer textdata.

Det finns mängder av dataset tillgängliga på plattformar som Kaggle, GitHub och Hugging Face, men de befinner sig i en juridisk och etisk gråzon, främst på grund av frågor om licenser och rättvis användning.

Den Initiativ för dataproveniens, ett samarbete mellan AI-forskare och jurister, har granskat tusentals dataset för att belysa deras verkliga ursprung.

Den fokuserade på över 1.800 dataset som finns tillgängliga på plattformar, inklusive Hugging Face, GitHub och Papers With Code. Dataseten är främst utformade för att finjustera modeller med öppen källkod, till exempel Llama-2.

Studien visade att cirka 70% av dessa dataset antingen saknade tydlig licensinformation eller var märkta med alltför tillåtande licenser.

Med en uppenbar brist på klarhet om begränsningar av upphovsrätt och kommersiell användning riskerar AI-utvecklare att av misstag bryta mot lagen eller bryta mot upphovsrätten.

Shayne Longpre, en doktorand vid MIT Media Lab som ledde granskningen, betonade att problemet inte är värdplattformarnas fel utan snarare ett systemiskt problem inom maskininlärningssamhället.

2023 har bevittnat en störtflod av stämningar riktar sig mot stora AI-utvecklare som Meta, Anthropic och OpenAI, som är under extremt tryck att anta mer transparenta datainsamlingsmetoder. Förordningar, som t.ex. EU:s AI-lagär inställda på att genomdriva just detta.

Data Provenance Initiative gör det möjligt för utvecklare av maskininlärning att utforska de granskade datauppsättningarna här. Initiativet analyserar också mönster i datamängder och belyser deras geografiska och institutionella ursprung.

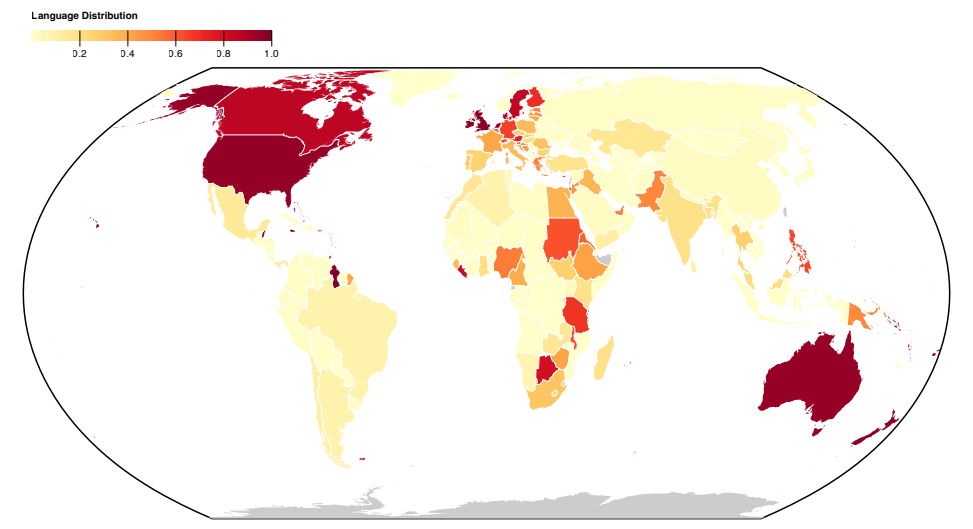

De flesta dataset är konstruerade i det engelsktalande globala nord, vilket belyser sociokulturella obalanser.

Mer om studien

Denna storskaliga analys av dataset avslöjade systematiska problem med hur data samlas in och distribueras. Initiativet har också resulterat i ett dokument som förklarar resultaten, publicerad här.

Här finns mer information om studiens metoder och resultat:

- Analys av dataset för ursprung och märkning: I den här studien granskades systematiskt över 1800 finjusterande dataset för att undersöka deras dataförsörjning, licensiering och dokumentation.

- Bevis på felaktig märkning: Resultaten belyste skillnaden i datatyper som är tillgängliga under olika licenser och konsekvenserna för juridiska tolkningar av upphovsrätt och rättvis användning. Det avslöjade en hög grad av felkategorisering av licenser, med över 72% av dataset som inte angav en licens och en felprocent på 50% i de som gjorde det.

- Otillförlitlig dataframställning: Forskningen uppmärksammar frågan om opålitlig datahärkomst och betonar behovet av standarder för att spåra datahärkomst, säkerställa korrekt tillskrivning och uppmuntra ansvarsfull dataanvändning.

- Geografisk utbredning: Studien belyser en allvarlig brist på representation och tillskrivning för dataset som härrör från det globala syd. De flesta dataset kretsar kring det engelska språket och är kulturellt bundna till Europa, Nordamerika och det engelsktalande Oceanien.

Den här studien belyser systemiska och strukturella problem i hur data skapas, distribueras och används. Data är en kritisk resurs för AI, och precis som naturresurser är den begränsad.

Det finns en oro för att AI-tekniken så småningom kommer att växa sig större än nuvarande dataset och kanske till och med börja konsumera sin egen produktion, vilket innebär att AI-modeller kommer att lära sig av AI-genererad text.

Detta kan försämra modellernas kvalitet, vilket innebär att högkvalitativa, etiska och lagliga data kan bli mycket värdefulla.