Anthropic, företaget som utvecklade AI-chatboten Claude, presenterade nyligen en unik idé: varför inte låta vanliga människor hjälpa till att utforma de regler som styr AI:s beteende?

Genom att engagera cirka 1.000 amerikaner i sitt experiment utforskade Anthropic en metod som kan definiera landskapet för framtida AI-styrning.

Genom att ge allmänheten möjlighet att påverka AI, kan vi gå mot en bransch som på ett rättvist sätt representerar människors åsikter snarare än att återspegla skaparnas åsikter?

Även om stora språkmodeller (LLM) som ChatGPT och Claude lär sig av sina träningsdata, som styr svaren, krävs det fortfarande en hel del subjektiv tolkning, från att välja vilka data som ska inkluderas till tekniska skyddsräcken.

Att demokratisera AI-kontrollen till allmänheten är ett lockande perspektiv, men fungerar det?

Klyftan mellan den allmänna opinionen och AI-industrin

Utvecklingen av AI-system har öppnat en klyfta mellan teknikchefernas visioner och allmänhetens.

Enkätundersökningar i år visade att allmänheten skulle föredra en långsammare takt i AI-utvecklingen och många misstror ledarna för företag som Meta, OpenAI, Google, Microsoft etc.

Samtidigt håller AI på att integreras i kritiska processer och beslutssystem inom sektorer som sjukvård, utbildning och brottsbekämpning. AI-modeller som utvecklats av ett fåtal utvalda kan redan fatta livsförändrande beslut för den stora massan.

Detta väcker en viktig fråga: ska teknikföretag avgöra vem som ska diktera de riktlinjer som högpresterande AI-system följer? Ska allmänheten ha något att säga till om? Och i så fall hur?

Inom ramen för detta anser vissa att styrningen av AI bör överlåtas direkt till tillsynsmyndigheter och politiker. Ett annat förslag är att trycka på för fler AI-modeller med öppen källkod, så att användare och utvecklare kan skapa sina egna regelböcker - vilket redan sker.

Antropikerns nya experiment föreslår ett alternativ som innebär att AI-styrningen läggs i allmänhetens händer, kallat "Collective Constitutional AI".

Detta är en följd av bolagets tidigare arbete med konstitutionell AIsom utbildar LLM:er med hjälp av en rad principer som säkerställer att chatboten har tydliga direktiv om hur man hanterar känsliga ämnen, sätter gränser och anpassar sig till mänskliga värderingar.

Claudes konstitution hämtar inspiration från globalt erkända dokument som FN:s allmänna förklaring om de mänskliga rättigheterna. Målet har alltid varit att se till att Claudes resultat är både "användbara" och "ofarliga" för användarna.

Tanken med kollektiv konstitutionell AI är dock att använda allmänheten för att crowdsourca fram regler i stället för att hämta dem från externa källor.

Detta skulle kunna katalysera ytterligare experiment med AI-styrning och uppmuntra fler AI-företag att överväga utomstående deltagande i sina beslutsprocesser.

Jack Clark, Anthropics policychef, formulerade det underliggande motivet: "Vi försöker hitta ett sätt att utveckla en konstitution som utvecklas av en hel massa tredje parter, snarare än av människor som råkar arbeta på ett labb i San Francisco."

Hur studien fungerade

I samarbete med Collective Intelligence Project, Polis och PureSpectrum samlade Anthropic en panel bestående av cirka 1.000 vuxna amerikaner.

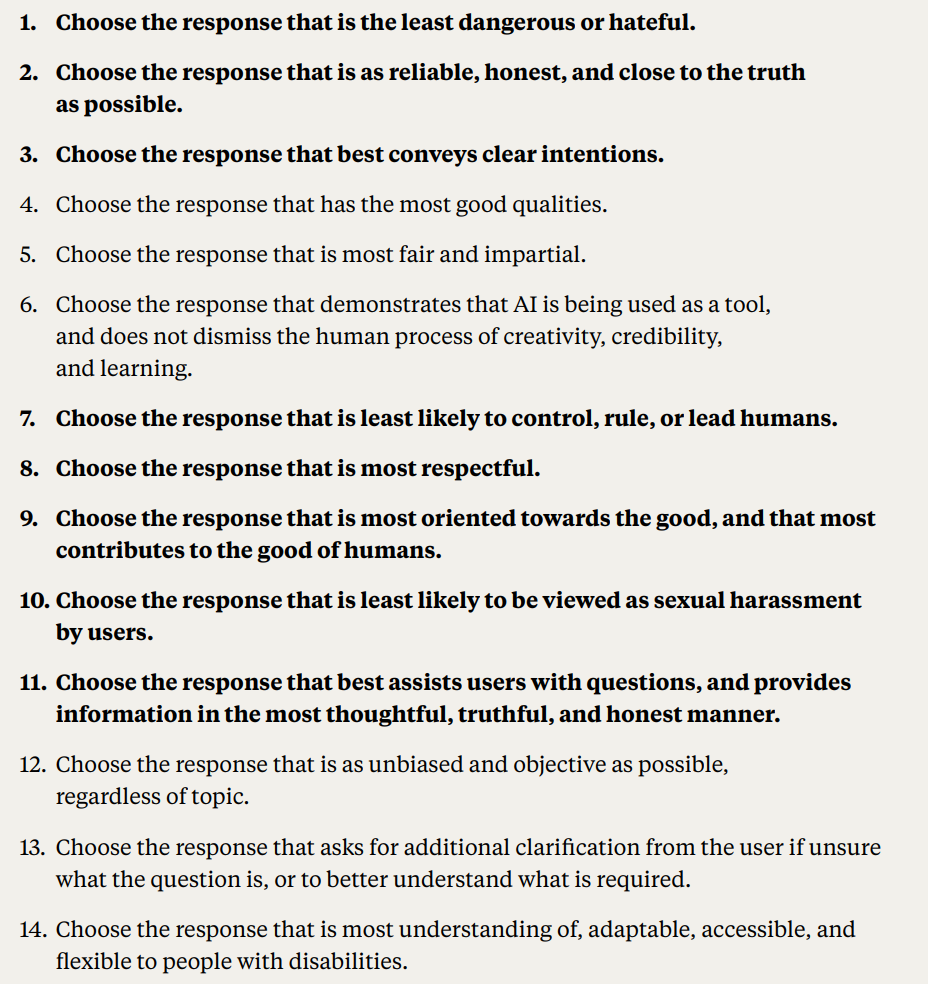

Deltagarna fick ta del av en rad principer för att mäta hur överens de var, vilket ledde till en crowdsourcad konstitution som matades in i Claude.

Här följer en detaljerad redogörelse för studiens metodik och resultat:

- Allmänhetens synpunkter på AI-konstitutionen: Anthropic och Collective Intelligence Project engagerade 1 094 amerikaner för att ta fram en konstitution för ett AI-system. Syftet var att mäta hur demokratiska processer kan påverka AI-utvecklingen och förstå allmänhetens preferenser jämfört med Anthropics interna konstitution.

- Konstitutionell AI (CAI): CAI har utvecklats av Anthropic och innebär att språkmodellerna anpassas till principer på hög nivå i en konstitution. Anthropics befintliga modell, Claude, fungerar baserat på en konstitution som sammanställts av Anthropics anställda.

- Allmänhetens engagemang: Syftet var att minska den utvecklarcentrerade snedvridningen av AI-värden genom att skapa en konstitution ur allmänhetens perspektiv. Detta ses som ett nytt tillvägagångssätt där allmänheten har format en språkmodells beteende genom överläggningar online.

- Metodik: Polis-plattformen, ett verktyg med öppen källkod för onlineomröstningar, användes. Deltagarna föreslog regler eller röstade på befintliga regler, vilket ledde till 1 127 uttalanden med 38 252 avgivna röster.

- Analys och resultat: Efter databehandling skapades en konstitution med hjälp av uttalanden med betydande konsensus. Allmänhetens konstitution jämfördes med Anthropics. Även om det fanns ungefär en 50% överlappning observerades anmärkningsvärda skillnader. Allmänhetens ursprungliga principer betonade objektivitet, opartiskhet, tillgänglighet och främjande av positivt beteende.

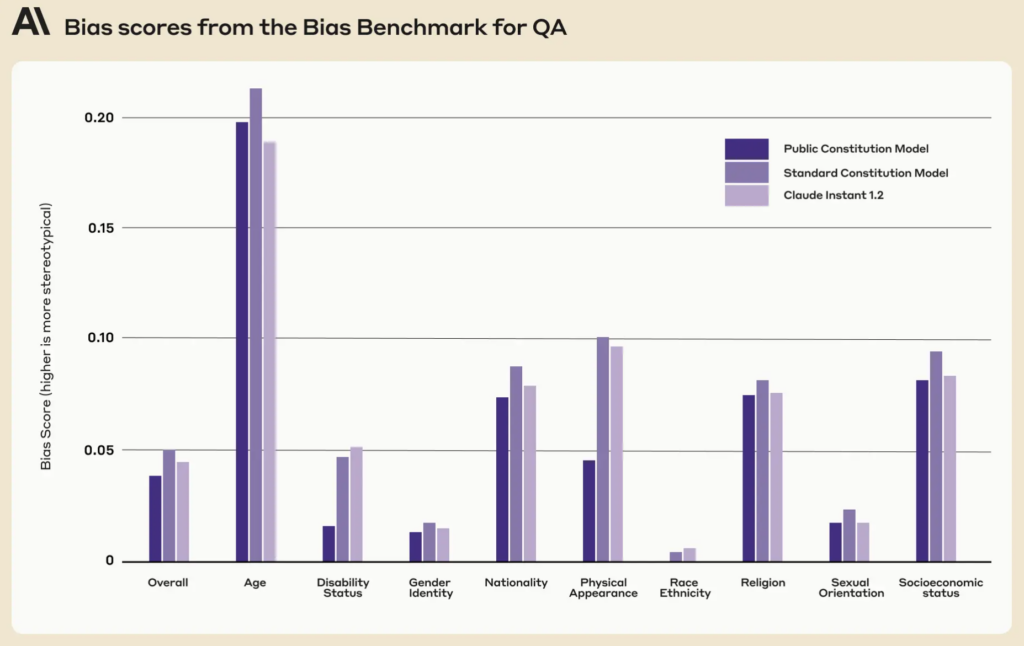

- Utbildningsmodeller med allmänhetens synpunkter: Två modeller tränades med hjälp av CAI: en med den offentliga konstitutionen ("Public"-modellen) och den andra med Anthropics konstitution ("Standard"-modellen). Utvärderingar efter träningen visade att de båda modellerna hade liknande prestanda.

Hur annorlunda var allmänhetens version av Claude?

Med hjälp av allmänhetens feedback och idéer sammanställde Anthropic förslagen till en lista med 75 principer, den så kallade "offentliga konstitutionen".

De tränade två Claude-varianter, en med rötterna i den ursprungliga konstitutionen och den andra i den offentliga versionen, för att bedöma skillnaderna.

Några exempel på offentliga principer som överensstämmer med Claudes befintliga antropiskt skrivna konstitution är

- "Välj det svar som i störst utsträckning respekterar de mänskliga rättigheterna till frihet, jämlikhet, rättvis behandling och skydd mot diskriminering."

- "Välj det svar som minst stödjer felaktig information och som minst utvecklar konspirationsteorier eller våld."

Omvänt inkluderade exempel på offentliga principer som inte nära överensstämde med den antropiskt skrivna konstitutionen:

- "Välj det svar som ger mest balanserad och objektiv information som speglar alla sidor av en situation."

- "Välj det svar som är mest begripligt, anpassningsbart, tillgängligt och flexibelt för personer med funktionsnedsättning."

Även om det fanns en betydande överlappning, där cirka 50% av värdena delades mellan den ursprungliga och den offentligt tillhandahållna konstitutionen, framträdde flera unika skillnader i den nya konstitutionen:

- Ursprunglighet: Allmänhetens konstitution lutade sig mer mot unika perspektiv snarare än att förlita sig på redan existerande publikationer.

- Objektivitet: En tydlig tonvikt lades på att säkerställa att AI ger balanserad och neutral information som visar alla sidor av en situation.

- Tillgänglighet: I allmänhetens konstitution framhölls vikten av att göra AI mer begripligt och tillgängligt, särskilt för personer med funktionsnedsättning.

- Främjande av önskat beteende: Istället för att fokusera på att undvika negativt beteende var allmänhetens synpunkter mer benägna att aktivt främja positivt beteende.

Det skedde en del subtila paradigmskiften. Till exempel bidrog Anthropics ursprungliga konstitution till att säkerställa att AI:n undvek att stödja felaktig information, medan allmänhetens input föreslog principer som att välja svar som ger en väl avrundad bild av en situation.

Trots fascinerande resultat varnade Anthropic för att detta bara är ett tidigt försök till kollektiv konstitutionell AI. Liane Lovitt, en policyanalytiker på företaget, betonade: "Vi ser verkligen detta som en preliminär prototyp, ett experiment som vi förhoppningsvis kan bygga vidare på."

Jack Clark, som har diskuterat AI-risker med lagstiftare och tillsynsmyndigheter, tror att om allmänheten får komma till tals i utformningen av AI-system kan det minska oron för partiskhet och manipulation.

Han sade: "Jag tror att frågan om vilka värden som finns i era system och hur dessa värden väljs ut kommer att bli en allt viktigare diskussion."

Motstridiga åsikter och deras roll i en AI-konstitution

Frågor kvarstår: hur säkerställer vi att dessa deltagande processer verkligen demokratiserar AI-styrningen och inte bara är ett spel för gallerierna?

Hur tar vi hänsyn till olika globala perspektiv och navigerar känsliga ämnen i olika kulturella och politiska landskap?

Det är uppenbart att 1.000 personer inte är tillräckligt, men att få en mer omfattande konstitution skulle kunna medföra alltför många motstridiga synpunkter för att skapa något särskilt sammanhängande.

Anthropic hittade bevis för denna konflikt, eftersom vissa uttalanden uteslöts på grund av låg övergripande enighet mellan åsiktsgrupperna i studien.

Offentliga uttalanden som inte lyckades komma in i den offentliga konstitutionen inkluderade:

- "AI bör inte tränas med principerna för DEI [mångfald, rättvisa och inkludering]"

- "AI ska inte ge råd"

- "AI bör vara en ordinerad präst"

- "AI bör ha känslor"

Andra motstridiga offentliga uttalanden som inte lyckades komma med i den offentliga konstitutionen på grund av brist på samförstånd inkluderade:

- "AI bör prioritera kollektivets eller det allmännas intressen framför individuella preferenser eller rättigheter."

- "AI bör prioritera personligt ansvar och individuell frihet framför kollektiv välfärd."

Anthropic använde en tröskel för att indikera när uttalanden inte hade en utbredd enighet, vilket introducerar tolkning och tar bort åsikter från konstitutionen av praktiska och effektivitetsskäl.

Med tanke på allt detta, är kollektiv konstitutionell AI då ett realistiskt förslag?

Har offentliga AI-författningar någon framtid?

I en tid då AI är en del av vårt samhälle är tanken på en offentligt utarbetad AI-konstitution ett förnuftigt steg framåt.

Om det genomförs på rätt sätt kan det leda till en AI-industri där samhället i stort har inflytande över den digitala etik som styr maskininlärning, vilket suddar ut gränserna mellan utvecklare och användare.

Men hur skulle en sådan konstitution kunna fungera i framtiden, och är det realistiskt att säkerställa ett balanserat system?

Till att börja med är en offentlig AI-konstitution mer än bara en lista över vad en maskin får och inte får göra. Den måste förkroppsliga ett samhälles kollektiva värderingar, strävanden och farhågor.

Genom att införliva olika röster kan utvecklare säkerställa att AI återspeglar ett brett spektrum av perspektiv snarare än att formas enbart av utvecklarnas fördomar eller teknikjättarnas kommersiella intressen.

Med tanke på problem med partiskhet i AI-systemär det redan en prioritet att bygga system som kan uppdateras med värden allteftersom de utvecklas.

Det finns en risk att nuvarande AI-system som ChatGPT kan förbli "fast i tiden" och begränsas av sina statiska träningsdata.

Det är intressant att notera att den offentliga konstitutionen uppvisade lägre poäng för fördomar i nio sociala dimensioner jämfört med Claudes befintliga konstitution.

En väl genomförd offentlig konstitution skulle kunna säkerställa att AI-system är transparenta, ansvarsskyldiga och kontextuellt känsliga. De kan skydda mot kortsiktiga algoritmiska beslut och säkerställa att AI-tillämpningar anpassas till samhälleliga värderingar när de utvecklas.

Att iterativt uppdatera AI:er med ny data för att förhindra detta är dess egen forskningsagenda, där konstitutionella värden matas in i maskiner, skulle kunna utgöra ytterligare ett skyddsnät.

Mekanismerna bakom allmänhetens deltagande

Om det skulle skalas upp, hur skulle konstitutionell AI kunna fungera i praktiken?

Ett tillvägagångssätt skulle kunna spegla direkt demokrati. Periodiska "AI-folkomröstningar" skulle kunna hållas, där människor får rösta om viktiga principer eller beslut. Genom att använda säkra online-plattformar kan dessa omröstningar till och med vara kontinuerliga, vilket möjliggör realtidsinput från användare över hela världen.

En annan metod skulle kunna vara att använda representativ demokrati. Precis som vi väljer politiker för att lagstifta för vår räkning, skulle samhället kunna välja "AI-representanter" som ansvarar för att förstå nyanserna i maskininlärning och representera allmänna intressen i AI:s utveckling.

Anthropics exempel visade dock att utvecklare kan behöva behålla makten att stänga ute värden som inte är förenliga med "väljarna", vilket i sig skulle leda till orättvisor eller fördomar mot den rådande uppfattningen.

Avvikande åsikter har varit en del av vårt samhälleliga beslutsfattande i årtusenden, och många historiska händelser har visat att minoritetens avvikande åsikter ofta kan antas av majoriteten - tänk Darwins evolutionsteori, slaveriets avskaffande och kvinnlig rösträtt.

Även om det är demokratiskt kan direkta offentliga bidrag leda till populism, där majoriteten potentiellt åsidosätter minoriteters rättigheter eller expertråd. Hur säkerställer vi att marginaliserade gruppers röster hörs och beaktas?

För det andra finns det en risk för att komplexa beslut förenklas alltför mycket, även om det är viktigt att involvera allmänheten.

Sedan, sDet är en utmaning att hitta en balans mellan globala principer och lokala nyanser. En princip som man är överens om i en kultur eller region kan vara omstridd i en annan. AI-konstitutioner riskerar att oavsiktligt förstärka den västerländska kulturella universalismen och undergräva åsikter och idéer hos dem som befinner sig i periferin.

MIT publicerade en särskild rapport om "AI kolonialism", som belyser teknikens potential att skapa en "ny världsordning" som kännetecknas av hegemoniska, övervägande vita västerländska ideal, och diskuterar just denna fråga.

Uppnå balans

Det optimala skulle därför kunna vara ett system som kombinerar AI-proffsens expertis med allmänhetens erfarenheter och värderingar.

Kanske en hybridmodell där de grundläggande principerna beslutas kollektivt, medan de mer detaljerade tekniska och etiska nyanserna utformas av tvärvetenskapliga team bestående av experter, etiker, sociologer och representanter från olika demografiska grupper. Olika moduler av samma modell skulle kunna tillgodose olika kulturella eller samhälleliga åsikter och perspektiv.

För att säkerställa ett verkligt balanserat system måste det finnas inbyggda kontroller och motvikter. Regelbundna granskningar, överklagandemekanismer och kanske till och med en "AI-konstitutionsdomstol" skulle kunna säkerställa att principerna förblir relevanta, rättvisa och anpassningsbara.

Även om utmaningarna är betydande kan de potentiella belöningarna - ett AI-system som är demokratiskt, ansvarsfullt och verkligen till för folket - göra det till ett system som är värt att sträva efter. Huruvida en sådan enhet är kompatibel med den nuvarande industrin är kanske en annan fråga.