Forskare från University of Chicago har utvecklat ett nytt verktyg för att "förgifta" AI-modeller när AI-företag inkluderar bilder i sina dataset utan samtycke.

Företag som OpenAI och Meta har mött kritik och stämningar på grund av deras omfattande skrapning av onlineinnehåll för att träna sina modeller. För att text-till-bild-generatorer som DALL-E eller Midjourney ska vara effektiva måste de tränas på stora mängder visuell data.

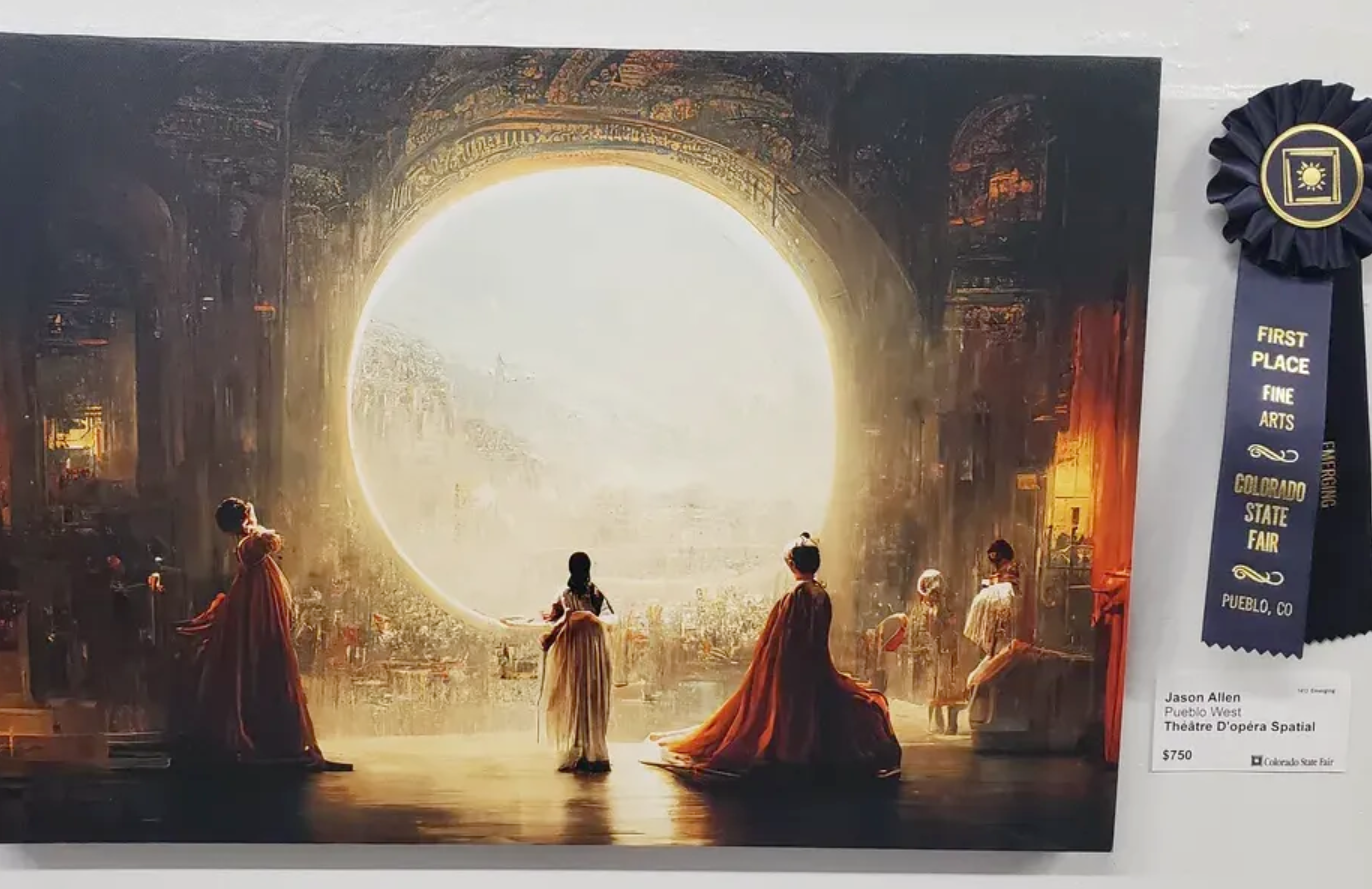

Ett antal artister har klagat på att dessa bildgeneratorer nu kan producera bilder i deras stil efter att ha skrapat deras konst utan samtycke.

Den forskare skapade Nightshade, ett verktyg som bäddar in osynliga pixlar i en bild som sedan gör bilden "giftig" för AI-modeller.

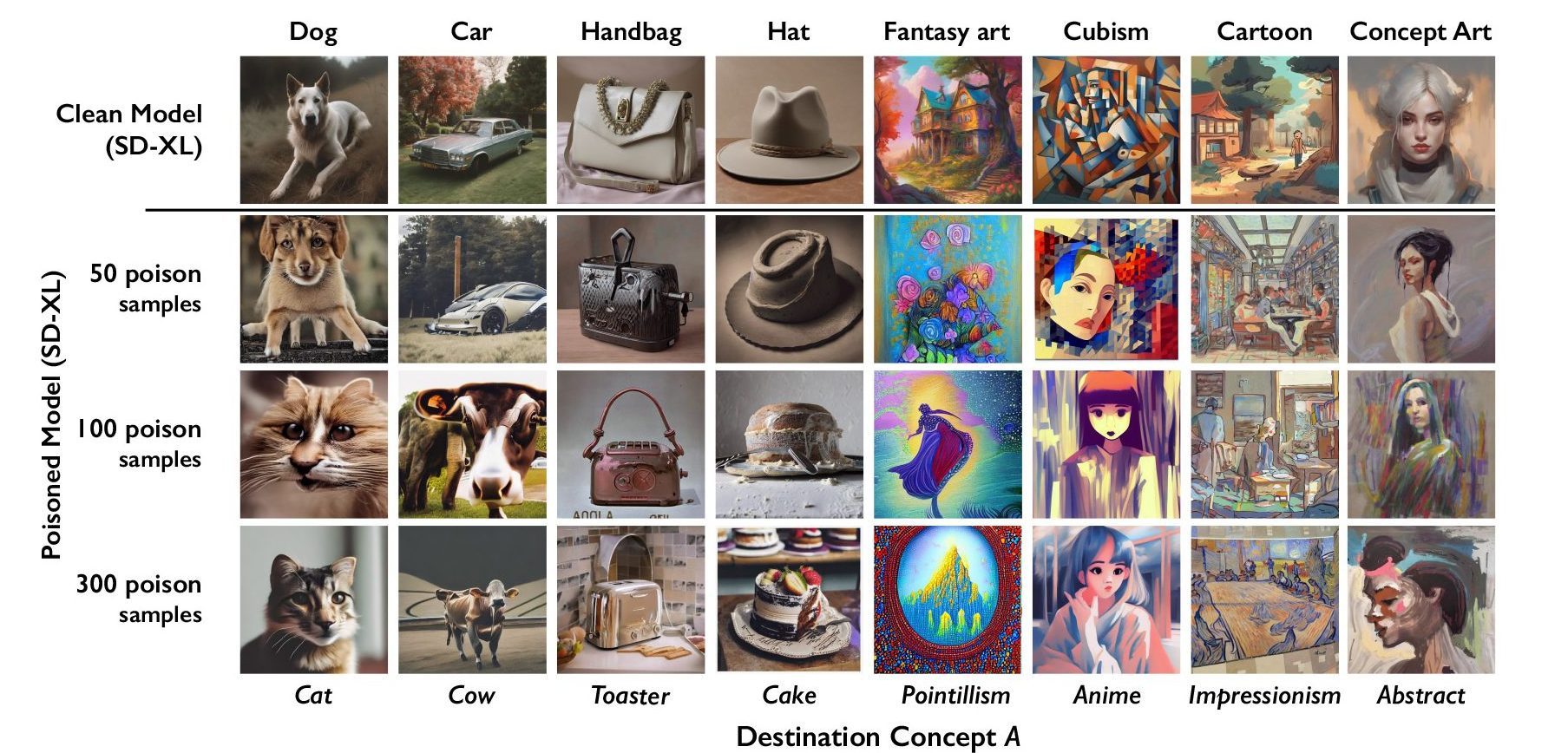

Generativ AI är beroende av korrekt märkta data. Om en AI-modell tränas på tusentals bilder av katter och alla bilder är märkta med "katt" vet den hur en katt ska se ut när du ber den att generera en bild av en katt.

Nightshade bäddar in data i bilden som förvanskar klassificeringen av bilden. Så en bild av ett slott som förgiftats av Nightshade skulle till exempel klassificeras som en gammal lastbil. Forskarna fann att det var effektivt att använda så få som 100 bilder som riktade sig mot en enda uppmaning för att korrumpera en modell.

Nightshade är dåliga nyheter för AI-bildgeneratorer

En modell som påverkas av förgiftade data kan få för sig att bilder på tårtor är hattar eller att brödrostar är handväskor. Förutom att korrumpera det specifika ord som Nightshade riktar in sig på, infekterar korruptionen också bredare begrepp. Så om man korrumperar etiketten "hund" skulle korruptionen utvidgas till att omfatta termer som "valp" också.

Om tillräckligt många konstnärer börjar använda Nightshade kan det leda till att företagen blir mycket mer försiktiga med att få samtycke innan de tar bilder.

Forskargruppen kommer att införliva Nightshade i verktyget Glaze som de också utvecklat. Glaze felmärker stilen på en bild. Till exempel kan en konstnär som vill skydda stilen på sitt verk använda Glaze för att märka det som "impressionistiskt" när det egentligen är "popkonst".

Det faktum att verktyg som Nightshade fungerar så effektivt belyser en Sårbarhet i text-till-bild-generatorer som kan utnyttjas av illvilliga aktörer.

Företag som OpenAI och Stability AI säger att de kommer att respektera Opt-outs för "skrapa inte som webbplatser kan lägga till i sina robots.txt-filer. Om de bilder som förgiftats av Nightshade inte skrapas förblir modellerna opåverkade.

Illvilliga aktörer kan dock förgifta en stor mängd bilder och göra dem tillgängliga för skrapning i syfte att skada AI-modeller. Det enda sättet att komma runt det är med bättre märkningsdetektorer eller mänsklig granskning.

Nightshade kommer att få artister att känna sig lite säkrare när de lägger ut sitt innehåll på nätet, men kan orsaka allvarliga problem för AI-bildgeneratorer.