Forskare har introducerat FANToM, ett nytt benchmark som är utformat för att rigoröst testa och utvärdera stora språkmodellers (LLM) förståelse och tillämpning av Theory of Mind (ToM).

Theory of Mind avser förmågan att tillskriva sig själv och andra föreställningar, önskningar och kunskaper samt förstå att andra har föreställningar och perspektiv som skiljer sig från ens egna.

ToM anses vara grunden till det medvetande som intelligenta djur besitter. Förutom människor anses även primater som orangutanger, gorillor och schimpanser ha ToM, liksom vissa icke-primater som papegojor och medlemmar av kråkfågelfamiljen.

I takt med att AI-modellerna blir allt mer komplexa söker AI-forskarna nya metoder för att utvärdera förmågor som ToM.

Ett nytt riktmärke kallat FANToMsom skapats av forskare från Allen Institute for AI, University of Washington, Carnegie Mellon University och Seoul National University, utsätter modeller för maskininlärning för dynamiska scenarier som återspeglar interaktioner i verkliga livet.

Med FANToM går karaktärer in i och ut ur konversationer, vilket utmanar AI-modellerna att upprätthålla en korrekt förståelse för vem som vet vad i varje givet ögonblick.

När stora språkmodeller (LLM) utsattes för FANToM visade det sig att även de mest avancerade modellerna har svårt att upprätthålla en konsekvent ToM.

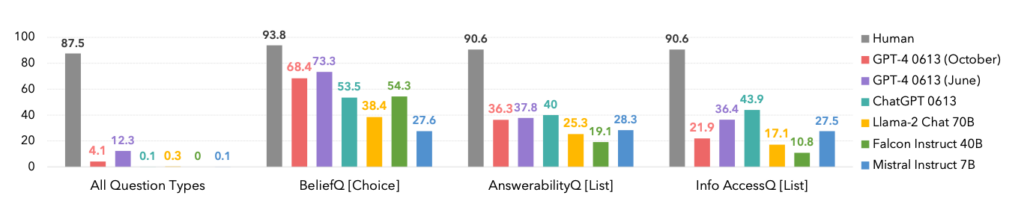

Modellernas prestanda var betydligt lägre än de mänskliga deltagarnas, vilket belyser AI:s begränsningar när det gäller att förstå och navigera i komplexa sociala interaktioner.

Faktum är att människan dominerade alla kategorier, se nedan.

En intressant sidopunkt är att oktoberversionen av GPT-4-modellens iteration överträffades av en tidigare juniversion, vilket kan stödja de senaste anekdoterna bland användarna om att ChatGPT blir allt värre.

FANToM avslöjade också tekniker för att förbättra LLM ToM, till exempel tankekedje-resonemang och andra finjusteringsmetoder.

Skillnaden mellan AI:s och människors ToM-kompetens är dock fortfarande stor.

AI tar steg mot människoliknande språkkunskaper

I ett något relaterat men separat studie publicerad i Naturehar forskare utvecklat ett neuralt nätverk som kan generalisera språk på ett sätt som liknar människans.

Det nya neurala nätverket uppvisade en imponerande förmåga att integrera nyinlärda ord i sitt befintliga ordförråd. Det kunde sedan använda dessa ord i olika sammanhang, en kognitiv färdighet som kallas systematisk generalisering.

Människan har en naturlig förmåga till systematisk generalisering och införlivar sömlöst ny vokabulär i sin repertoar.

När någon till exempel lär sig termen "fotobomb" kan de tillämpa den i olika situationer nästan omedelbart. Ny slang dyker upp hela tiden, och människor tar naturligt till sig den i sitt ordförråd.

Forskarna utsatte både sitt eget anpassade neurala nätverk och ChatGPT för en serie tester och fann att ChatGPT släpade efter den anpassade modellen i prestanda.

Medan LLM:er som ChatGPT utmärker sig i många konversationsscenarier uppvisar de märkbara inkonsekvenser och luckor i andra, ett problem som detta nya neurala nätverk tar itu med.

För att undersöka den här aspekten av språklig kommunikation genomförde forskare ett experiment med 25 mänskliga deltagare där de bedömde deras förmåga att använda nyinlärda ord i olika sammanhang. Försökspersonerna introducerades till ett pseudospråk bestående av nonsensord som representerade olika handlingar och regler.

Efter en träningsfas kunde deltagarna på ett utmärkt sätt tillämpa dessa abstrakta regler på nya situationer, vilket visade på en systematisk generalisering.

När det nyutvecklade neurala nätverket utsattes för denna uppgift speglade det den mänskliga prestationen. När ChatGPT utsattes för samma utmaning hade den dock stora problem och misslyckades mellan 42 och 86% av tiden, beroende på den specifika uppgiften.

Detta är viktigt av två skäl. För det första kan man hävda att detta nya neurala nätverk effektivt överträffade GPT-4 på denna specifika uppgift - vilket är tillräckligt imponerande. För det andra avslöjar denna studie nya metoder för att lära AI-modeller hur man generaliserar nytt språk som människor.

Elia Bruni, specialist på bearbetning av naturligt språk vid universitetet i Osnabrück i Tyskland, beskriver det som att "det är en stor sak att införa systematik i neurala nätverk".

Tillsammans erbjuder dessa två studier nya tillvägagångssätt för att träna mer intelligenta AI-modeller som kan konkurrera med människor inom kritiska områden som lingvistik och Theory of Mind.