Nvidia presenterade en uppdaterad version av sitt Grace Hopper Superchip (GH200) som de tillkännagav för 2 månader sedan. GH200 var utformad för att driva datacenter för storskalig AI-bearbetning.

GH200 har ännu inte börjat serieproduceras, men den har redan haft en större uppgradering i sitt minne. Den hemliga såsen i dessa nya chip är det uppgraderade minnet med hög bandbredd, kallat HBM3e, som kan komma åt data med 5 TB/s.

Detta innebär en förbättring med 50% jämfört med HBM3-minnet i det chip som presenterades i slutet av maj.

Nvidia anslöt detta höghastighetsminne till kraftfulla CPU:er och GPU:er på samma enhet. Den resulterande ökningen i bearbetningshastighet kommer att dramatiskt förbättra den AI-bearbetningsförmåga som nuvarande datacenter har.

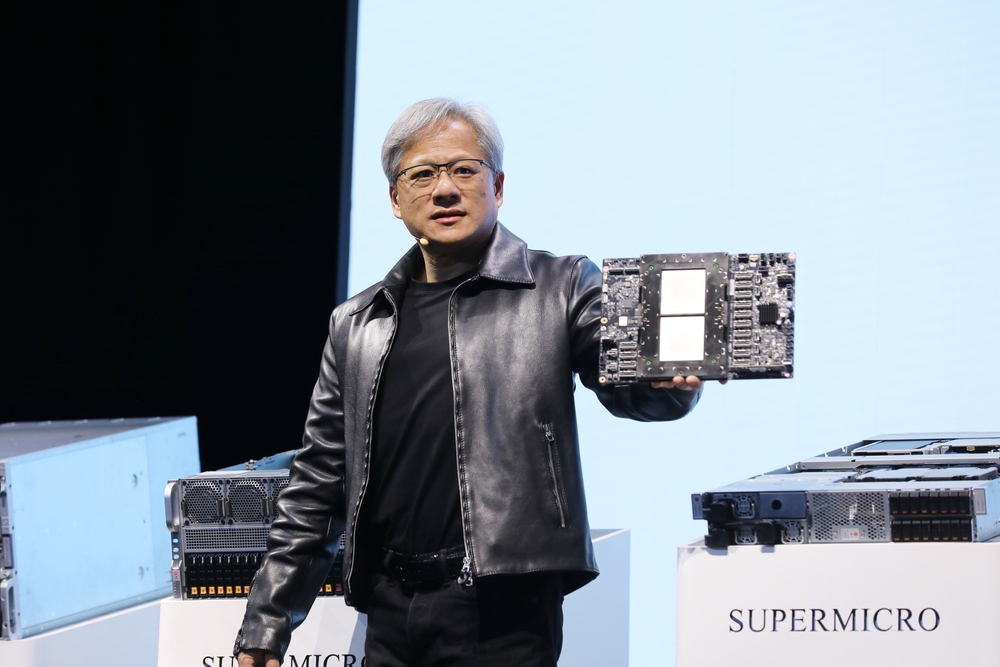

Förutom det uppdaterade chippet tillkännagav Nvidia också GH200 Grace Hopper-plattformen som gör det möjligt att ansluta två GH200-chipp på ett enda kort.

Plattformen levererar åtta petaflops AI-processering och 282 GB HBM3e-minne med en bandbredd på 10 TB/s.

Hur kommer Nvidias chip att förändra datacenters?

Siffrorna kan vara lite svåra att få grepp om. Så hur stor affär är detta nya chip och denna nya plattform?

I sin presentation använde Nvidias VD Jensen Huang exemplet med ett typiskt datacenter som kör 8800 x86-processorer som utför en mängd olika beräkningsfunktioner (ISO-budget).

Ett sådant datacenter som kör Llama 2 för inferens, med en vektordatabas som tillfrågas och SDXL som genererar utdata skulle kosta dig cirka $100 miljoner och använda 5 MW ström.

Ett datacenter på $100m med 2500 GH200-plattformar skulle kunna köra samma modeller 12 gånger snabbare och bara använda 3 MW ström.

Om ett datacenter var inriktat på en mycket specifik uppsättning uppgifter (ISO-arbetsbelastning) blir jämförelsen ännu mer häpnadsväckande.

Du skulle bara behöva spendera $8m för 210 GH200-enheter som bränner 20 gånger mindre energi för att matcha datacenterprestanda på $100m.

Det behöver inte sägas att alla datacenter för AI cloud computing som befann sig i planeringsfasen före den här utgåvan kommer att gå tillbaka till ritbordet.

GH200-chipen kommer att rullas ut under Q2 2024 och förväntas äta upp en hel del av x86-processorverksamheten. AMD:s nya MI300-chip är Nvidias närmaste rival, men dess fördel i form av större minne verkar eroderas av uppgraderingen i nya GH200.

Den utveckling av processortekniken som vi ser är överlägsen Moores lag och visar inga tecken på att sakta ner. Generativa AI-applikationer levererar redan imponerande prestanda, men det ser ut som om de kommer att bli mycket snabbare.