Meta tillkännagav lanseringen av Code Llama, dess nya AI-verktyg för kodning.

Code Llama är en finjusterad version av Meta's Llama 2 LLM, som har tränats för att skriva och dokumentera kod. Det nya verktyget tar beskrivningar på naturligt språk och förvandlar dem till kod. Det kan också felsöka, förklara och dokumentera kod som levereras som inmatning.

Det här är ett bra verktyg om du precis har lärt dig att koda, men det är programvaruingenjörer som kommer att ha störst nytta av Code Llama.

Verktyget stöder de flesta populära programmeringsspråk, inklusive Python, C ++, Java, PHP, Typescript (Javascript), C#, Bash och andra.

Med Code Llama kan du be den att "skriva en funktion i Python för att beräkna de 100 första primtalen", så genererar den koden åt dig.

Verktyg som ChatGPT kan redan skriva kod men Code Llama har ett antal funktioner som utan tvekan kan göra det till ett bättre kodningsverktyg.

ChatGPT har ett kontextfönster på mellan 4.000 och 8.000 tokens, medan Code Llama kan hantera upp till 100.000 tokens kontext. Den första uppenbara fördelen med att ha ett större kontextfönster är att det går att skriva betydligt längre kod.

Det som är mer spännande är att kunna mata in en stor bit kod och sedan låta Code Llama felsöka den åt dig. Om du vill använda ChatGPT för att göra det måste du felsöka små bitar åt gången.

Idag släpper vi Code Llama, en stor språkmodell som bygger på Llama 2, finjusterad för kodning och toppmodern för allmänt tillgängliga kodningsverktyg.

I enlighet med vår öppna strategi är Code Llama nu tillgänglig för allmänheten för både forskning och kommersiell användning.

Mer ⬇️

- Meta AI (@MetaAI) 24 augusti 2023

Meta har släppt 3 storlekar av Code Llama med 7B, 13B och 34B parametrar respektive. De mindre modellerna körs snabbare, med mindre processorkraft krävs, men är mindre kraftfulla än 34B-modellen.

De två mindre modellerna har också tränats med FIM-funktionen (fill-in-the-middle). Detta gör att en programmerare kan ange befintlig kod och låta Code Llama hantera kodkompletteringsuppgifter.

Förutom baslinjemodellerna som stöder flera språk, släppte Meta två versioner som specifikt utbildats på Python och Instruct.

Är Code Llama något bra?

Meta utförde sina egna benchmarkingtester och fann att Code Llama "presterade bättre än öppen källkod, kodspecifika LLM: er och överträffade Llama 2."

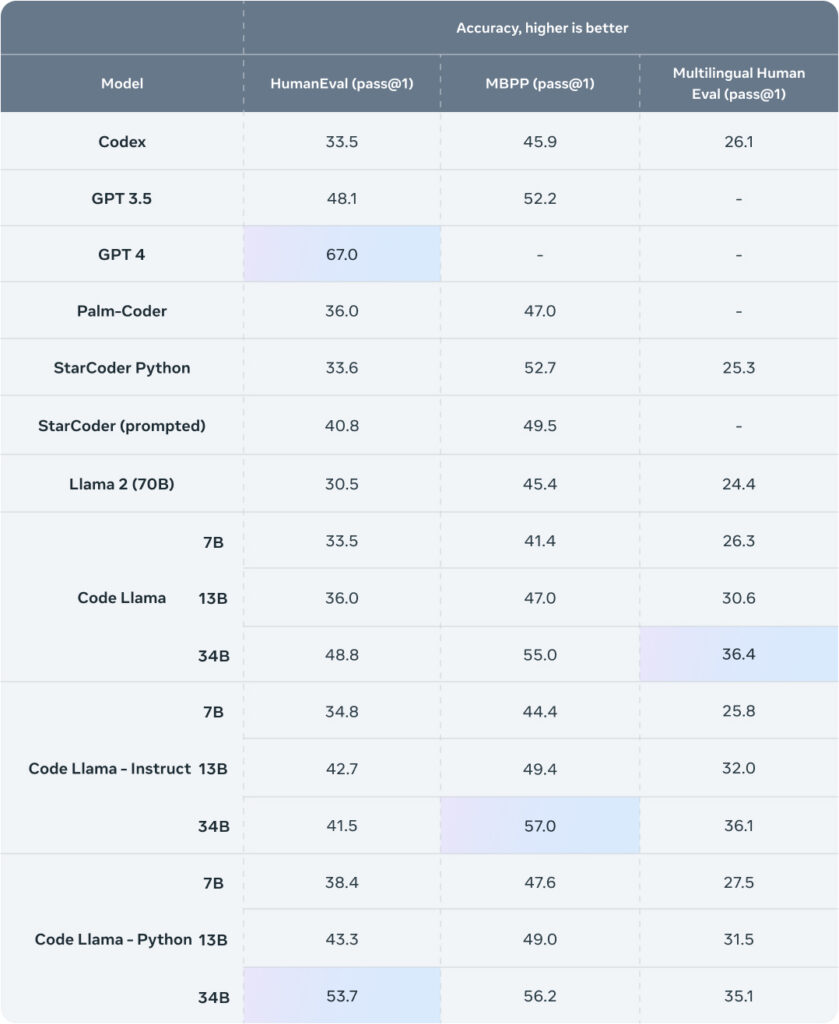

Här är jämförelsetabellen som visar hur Code Llama står sig i jämförelse med andra modeller.

Källa: Meta

GPT-4 är fortfarande i front med ett visst avstånd men det är en enorm modell, och det är inte gratis. Code Llama är gratis och 7B-versionen kan köras på din lokala maskin.

För att använda GPT-4 krävs att din kod skickas via OpenAI:s servrar, och för många företag innebär det en stor risk för deras immateriella rättigheter.

Eftersom Code Llama körs på lokala servrar finns det ingen risk för att privata företagsuppgifter läcker ut eller används för att träna andra modeller.

Utöver de lanserade modellerna är Kod Llama forskningsrapport refererade till en modell som heter "Unnatural Code Llama". Den fick 62,2% på HumanEval-riktmärket, vilket är väldigt nära GPT-4:s 67%.

Det finns inga uppgifter om när den modellen kommer att släppas, men den typen av prestanda slår Googles PaLM Coder med hästlängder och kommer till och med att göra GPT-4 svårsåld.