När AI fortsätter att integreras i rekryteringsprocesser är det tydligt att teknikens löfte om effektivitet kommer med sina egna risker.

Enligt uppgift från 2022 dataanvänder cirka 55% av företagen redan AI-verktyg för rekrytering.

AI har påskyndat traditionella anställningsförfaranden och eliminerat högar av CV:n och meritförteckningar i processen, men det har också väckt kritiska frågor om rättvisa, partiskhet och det mänskliga beslutsfattandets natur.

AI är ju trots allt utbildade på mänsklig data, så de kommer sannolikt att ärva alla de fördomar och förutfattade meningar som de lovar att utrota.

Är det här något vi kan ändra på? Vad har vi lärt oss av AI-rekrytering hittills?

Meta anklagas för diskriminerande annonsrutiner av människorättsgrupper

Uppgifter visar att vissa 79% av arbetssökande använder sociala medier för att söka jobb, och det finns bevis för att det är här diskrimineringen börjar.

Meta är för närvarande står inför flera anklagelser från europeiska människorättsorganisationer som hävdar att Facebooks algoritm för att rikta in jobbannonser är partisk.

I juni meddelade den icke-statliga organisationen Global Witness undersökte flera automatiskt riktade Facebook-jobbannonser och fann att många vidmakthöll könsfördomar.

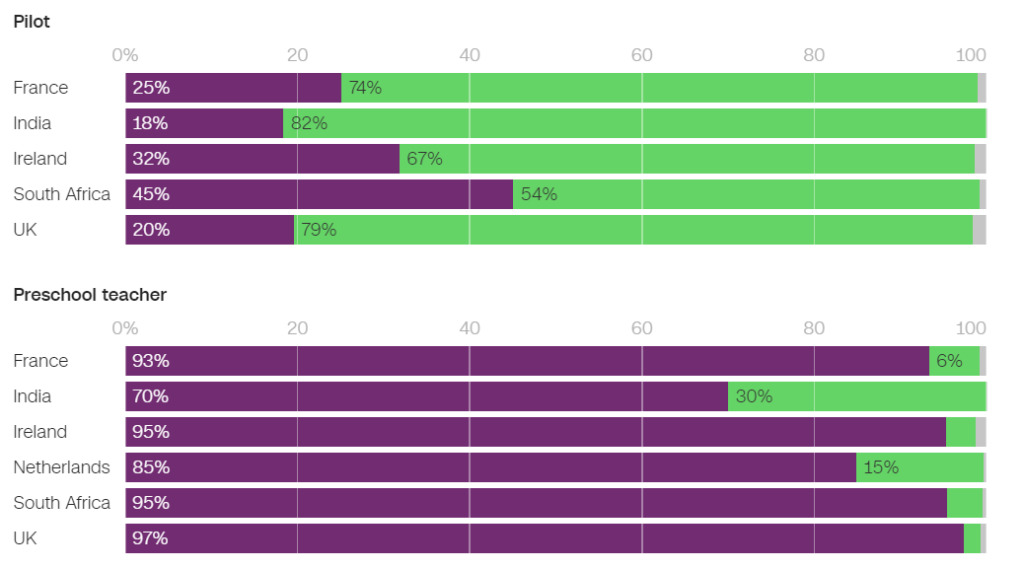

Till exempel var det betydligt mer sannolikt att män fick se annonser som handlade om ingenjörsyrken, medan det var betydligt mer sannolikt att kvinnor fick se annonser som handlade om undervisning.

Av de annonser som visades i Frankrike var 93% av de användare som såg en jobbannons för förskollärare och 86% av de som såg en jobbannons för psykologer kvinnor. Omvänt var det endast 25% av kvinnorna som fick se en jobbannons för en pilot och endast 6% som fick se en jobbannons för en mekaniker.

I Nederländerna var 85% av de användare som fick se en platsannons för lärare och 96% av de som fick se en platsannons för receptionister kvinnor. Liknande resultat observerades i många andra länder, bland annat Storbritannien, Indien och Sydafrika.

I en intervju med CNNNaomi Hirst från Global Witness sa: "Vår oro är att Facebook förvärrar de fördomar som vi lever med i samhället och faktiskt förstör möjligheterna till framsteg och rättvisa på arbetsplatsen."

Tillsammans med Bureau Clara Wichmann och Fondation des Femmes har Global Witness lämnat in klagomål mot Meta till människorätts- och dataskyddsmyndigheter i Frankrike och Nederländerna.

Grupperna uppmanar till en undersökning av om Metas praxis bryter mot mänskliga rättigheter eller dataskyddslagar. Om anklagelserna håller, kan Meta möta böter och sanktioner.

Som svar uppgav en Meta-talesman: "Systemet tar hänsyn till olika typer av information för att försöka visa människor annonser som de kommer att vara mest intresserade av."

Det här är inte första gången Meta har slagit bort sådan kritik - företaget mötte flera stämningar under 2019 och åtagit sig att ändra sitt annonssystem för att undvika fördomar baserade på skyddade egenskaper som kön och ras.

Pat de Brún, från Amnesty International, var kritisk till Global Witness resultat. "Forskning visar konsekvent hur Facebooks algoritmer ger djupt ojämlika resultat och ofta förstärker marginalisering och diskriminering", sa hon till CNN.

Amazon skrotar hemligt AI-rekryteringsverktyg som visade fördomar mot kvinnor

Amazon utvecklade ett AI-rekryteringsverktyg mellan 2014 och 2017 innan man insåg att verktyget var partiskt vid urvalet av mjukvaruutvecklare och andra tekniska tjänster. År 2018 hade Amazon tagit bort verktyget helt.

AI-systemet straffade CV:n som innehöll orden "kvinnor" och "kvinnors" och nedgraderade kompetensen hos kvinnliga akademiker.

Systemet misslyckades även efter att Amazon försökt redigera algoritmerna för att göra dem könsneutrala.

Det visade sig senare att Amazon tränat verktyget på CV:n som skickats in till företaget under en 10-årsperiod, varav de flesta kom från män.

Som många AI-system påverkades Amazons verktyg av de data som det tränades på, vilket ledde till oavsiktlig partiskhet. Denna bias gynnade manliga kandidater och föredrog CV:n som använde språk som var vanligare i manliga ingenjörers CV:n.

På grund av problem med den underliggande datan rekommenderade systemet dessutom ofta okvalificerade kandidater för olika jobb.

Den Världsekonomiskt forum säger om Amazons rekryteringssystem: "Till exempel - som i Amazons fall - kan starka könsobalanser korrelera med den typ av studie som genomförts. Dessa snedvridningar i utbildningsdata kan också uppstå på grund av dålig datakvalitet eller mycket små, icke diversifierade datamängder, vilket kan vara fallet för företag som inte verkar globalt och söker efter nischade kandidater."

Amazon lyckades återanvända en "urvattnad version" av rekryteringsmotorn för rudimentära uppgifter, som att eliminera dubbla kandidatprofiler från databaser.

De inrättade ett nytt team för att göra ett nytt försök med automatiserad anställningskontroll, den här gången med fokus på att främja mångfald.

Google kämpar mot sina egna problem med diskriminering och fördomar

I december 2020 meddelade Dr. Timnit Gebru, en ledande AI-etiker på Google, att den företaget hade avskedat henne.

Uppsägningen kom efter att Dr. Gebru uttryckt oro över Googles inställning till rekrytering av minoriteter och inbyggda fördomar i AI-system.

Innan Gebru lämnade företaget skulle han publicera en artikel som belyste partiskhet i Googles AI-modeller.

Efter att ha skickat in artikeln till en akademisk konferens avslöjade Gebru att en chef på Google hade bett henne att dra tillbaka artikeln eller ta bort sitt eget och de andra Googleforskarnas namn. När Gebru vägrade att följa uppmaningen accepterade Google en villkorligt föreslagen uppsägning, vilket i praktiken innebar att Gebru omedelbart sades upp från sin tjänst.

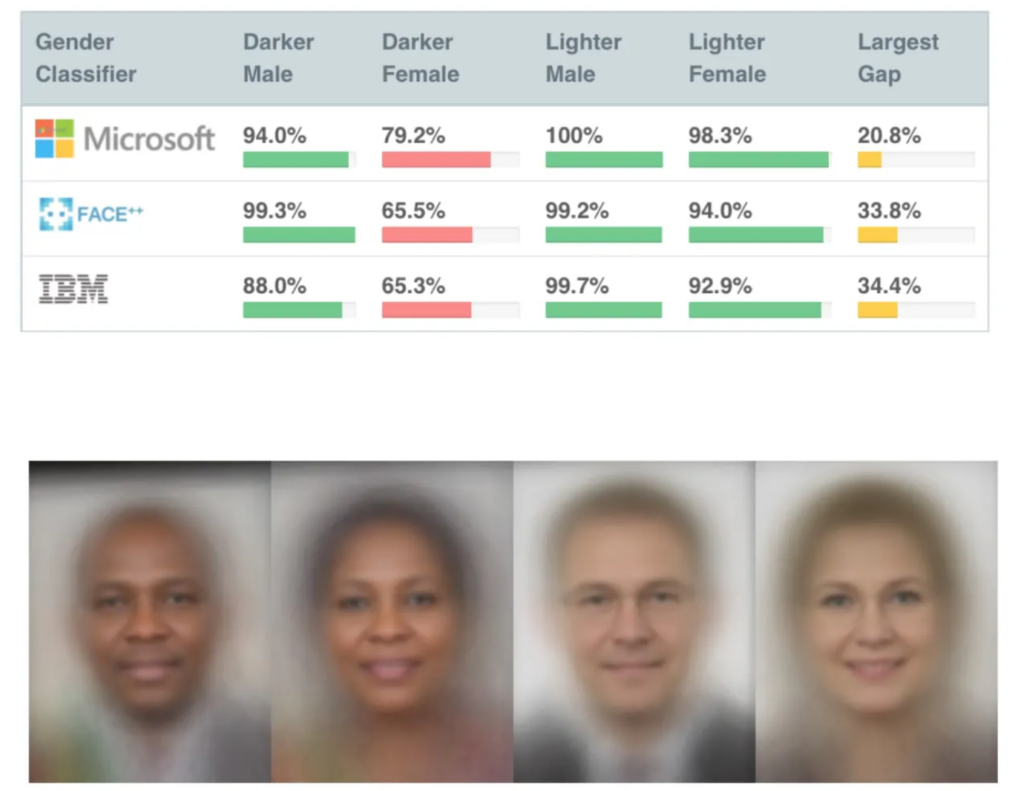

Detta skedde inte långt efter att flera mycket inflytelserika studier om AI-bias publicerats, bland annat MIT:s studie om genusnyansersom har blivit en av de mest citerade AI-uppsatserna genom tiderna.

Gender Shades-studien avslöjade partiskhet i AI för ansiktsigenkänning, som felidentifierade svarta ansikten ungefär 30% till 35% av tiden jämfört med cirka 5% för vita ansikten.

Felaktiga ansiktsigenkänningsmatcher ledde till att en person felaktigt greps och fängslades flera män i USA.

Gebru fick sparken, vilket ledde till en mediestorm kring diskriminerande metoder i Silicon Valley.

Mutale Nkonde från Stanford Digital Civil Society Lab sa: "Hennes avskedande visar bara att forskare, aktivister och akademiker som vill arbeta inom detta område - och som är svarta kvinnor - inte är välkomna i Silicon Valley."

Dr Gebru's avskedande inspirerade till ytterligare en studie, Avslöjande av kodade fördomarsom visade att svarta personer var betydligt mer benägna att bli underskattade av rekryterings-AI än någon annan.

"Denna rapport har funnit gott om bevis som tyder på att svarta studenter och yrkesverksamma är oroliga för att möta fördomar mot svarta under anställningsprocessen. Drygt hälften av alla respondenter uppger att de har observerat fördomar i anställnings- eller rekryteringsprocessen på webbplatser för anställning eller rekrytering. Svarta yrkesverksamma är något mer benägna att ha observerat sådana fördomar med femtiofem procent av de svarande som anger att de har observerat fördomar i anställningsprocessen," - Avslöjande av kodade fördomar, Penn Law Policy Lab.

I rapporten står det: "Den offentliga konversationen som Dr. Gebru och hennes kollegor om algoritmisk partiskhet gav upphov till gjorde det möjligt för vårt laboratorium att delta i denna nationella dialog och utöka en mer nyanserad förståelse av algoritmisk partiskhet i anställningsplattformar."

Att problemet har uppmärksammats har varit en katalysator för förändring, men AI har en lång väg att gå för att förena sin roll i känsligt mänskligt beslutsfattande.

AI:s roll i rekryteringen: några positiva saker att ta fasta på

Trots många kontroverser har det varit svårt för företag att motstå AI:s enorma potential att påskynda rekryteringen.

AI:s roll i rekryteringen är logisk - det kan vara lättare att rensa bort fördomar hos AI än hos människor. När allt kommer omkring är AI *bara* matematik och kod - säkert mer formbart än djupt förankrade omedvetna fördomar?

Och även om utbildningsdata var kraftigt partisk i början och mitten av 2010-talet, främst på grund av bristen på olika dataset, har detta förbättrats sedan dess.

Ett framstående AI-rekryteringsverktyg är Sapiasom kallas för en "smart intervjuare". Enligt Sapias grundare, Barb Hyman, möjliggör AI en "blind" intervjuprocess som inte förlitar sig på CV, sociala medier eller demografiska data utan enbart på den sökandes svar, vilket eliminerar fördomar som är vanliga vid mänskligt ledda anställningar.

Dessa system kan ge alla en rättvis chans genom att intervjua alla sökande. Hyman föreslår"Det är dubbelt så troligt att du får kvinnor och behåller kvinnor i anställningsprocessen när du använder AI."

Men även själva processen att intervjua någon med AI väcker frågor.

Modeller för bearbetning av naturligt språk (NLP) tränas i allmänhet främst på engelska texter, vilket innebär att de är dålig på att hantera personer som inte har engelska som modersmål.

Dessa system kan oavsiktligt missgynna personer som inte har engelska som modersmål eller personer med andra kulturella särdrag. Dessutom hävdar kritiker att funktionshinder kanske inte beaktas på ett adekvat sätt i en AI-chatt eller videointervju, vilket leder till ytterligare potentiell diskriminering.

Detta förvärras av det faktum att de sökande ofta inte vet om en AI bedömer dem, vilket gör det omöjligt att begära nödvändiga justeringar av intervjuprocessen.

Dataset är grundläggande

Dataset är grundläggande här. Träna en AI på data som är tio år gamla, och den lär sig tio år gamla värden.

Arbetsmarknaden har blivit betydligt mer mångfacetterad sedan millennieskiftet.

I vissa länder är till exempel antalet kvinnor större än antalet män inom flera viktiga medicinska discipliner, som psykologi, genetik, pediatrik och immunologi.

I Storbritannien, en rapport för 2023 fann att 27% av de sysselsatta kvinnorna arbetade inom "professionella yrken" (som läkare, ingenjörer, sjuksköterskor, revisorer, lärare och advokater) jämfört med 26% av männen, en trend som stadigt har ökat under 5-10 år.

Sådana övergångar har accelererat under de senaste 2 till 5 åren - många dataset är äldre och återspeglar helt enkelt inte de senaste uppgifterna. Liknande frågor gäller för ras och funktionsnedsättning som för kön.

Dataset måste spegla våra alltmer diversifierade arbetsplatser för att ge alla en rättvis service.

Även om det fortfarande finns mycket att göra för att säkerställa mångfald på arbetsplatsen, måste AI ärva värden från nuet och inte från det förflutna. Det borde vara ett absolut minimum för att skapa rättvisa och transparenta AI-system för rekrytering.

Utvecklarna av AI för rekrytering kommer sannolikt att utsättas för sträng reglering, med USA, Storbritannien, Kina, EU:s medlemsstater och många andra länder som kommer att skärpa AI-kontrollerna under de kommande åren.

Forskning pågår, men det är fortfarande osannolikt att de flesta AI:er som rekryterar tillämpar de rättvisa och opartiska principer som vi förväntar oss av varandra.